Автор: Вентцель Е.С. Овчаров Л.А.

Теги: теория вероятностей и математическая статистика теория вероятностей математическая статистика комбинаторный анализ теория графов математика

ISBN: 5-06-003830-0

Год: 2000

Текст

Е.С.Вентцель ЛАОвчаров

Теория

вероятностей

и ее инженерные

приложения

ИЗДАНИЕ ВТОРОЕ, СТЕРЕОТИПНОЕ

Рекомендовано

Министерством образования Российской Федерации

в качестве учебного пособия

для студентов высших технических

учебных заведений

Москва

«Высшая школа» 2000

УДК 519.21

ББК 22.171

В 29

Рецензент, директор Института проблем передачи информации РАН

академик НА. Кузнецов

Вентцель Е.С., Овчаров Л.А.

В 29 Теория вероятностей и ее инженерные приложения.

Учеб. пособие для втузов.— 2-е изд., стер.— М.: Высш.

шк., 2000.—480 с: ил.

ISBN 5-06-003830-0

В книге дано систематическое изложение основ теории

вероятностей под углом зрения их практических приложений по

специальностям: кибернетика, прикладная математика, ЭВМ,

автоматизированные системы управления, теория механизмов, радиотехника,

теория надежности, транспорт, связь и т. д. Несмотря на

разнообразие областей, к которым относятся приложения, все они

пронизаны единой методической основой.

Первое издание вышло в 1988 г.

Для студентое высших технических учебных заведений. Может

быть полезна преподавателям, инженерам и научным работникам

разных профилей, которые в своей практической деятельности

сталкиваются с необходимостью ставить и решать задачи, связанные

с анализом случайных процессов.

УДК 519.21

ББК 22.171

Учебное издание

Вентцель Елена Сергеевна

Овчаров Лев Александрович

ТЕОРИЯ ВЕРОЯТНОСТЕЙ И ЕЕ ИНЖЕНЕРНЫЕ ПРИЛОЖЕНИЯ

Редактор ТА. Рыкова

Художественный редактор Ю.Э. Иванова

ЛР № 010146 от 25.12.96. Изд. № ФМ-204. Подп. в печать 27 01.2000

Формат 60x88 1/16 Бум. газеты Гарнитура «Обыкновенная» Печать офсетная

Объем 29,40 усл.-печ. л , 29,40 усл. кр.-oiT., 25,21 уч -изд. л

Тираж 10000 экз. Заказ № 461

ГУП издательство «Высшая школа», 101430, Москва, Неглинная ул , д 29/14

Отпечатано в ГУП ИПК «Ульяновский Дом печати»,

432601, г Ульяновск, ул. Гончарова, д 14

ISBN 5-06-003830-0 © ГУП издательство «Высшая школа», 2000

Оригинал-макет данного издания является собственностью издательства

«Высшая школа» и его репродуцирование (воспроизведение) любым

способом без согласия издательства запрещено

ПРЕДИСЛОВИЕ

Книга представляет собой систематическое изложение

основ теории вероятностей под углом зрения их

практических инженерных приложений. Интересы этих

приложений определяют и отбор материала, и стиль

изложения, и его методическую основу. Книга изобилует

примерами решения практических задач, требующих

применения вероятностных методов и относящихся к

самым различным специальностям: кибернетика,

прикладная математика, ЭВМ, автоматизированные системы

управления, теория механизмов, радиотехника, теория

надежности, транспорт, связь и т. п. Несмотря на

разнообразие областей, к которым относятся приложения, все

они пронизаны единой методической основой, единой

системой подходов.

Эта книга относительно небольшого объема написана

на базе лекций по теории вероятностей, читанных

авторами в различных втузах на протяжении последних

десятилетий. Она предназначена для инженеров и научных

работников разных профилей, которые в своей

практической деятельности сталкиваются с необходимостью

ставить и решать задачи, связанные со случайными

явлениями и требующие вероятностного подхода. Книга

адресована широкому кругу читателей, она может быть

использована и в учебном процессе студентами и

преподавателями втузов, и как пособие для самообразования.

Изложение ведется на уровне, доступном читателю,

знакомому с математикой в объеме обычного втузовского

курса. Там, где по ходу дела приходится пользоваться

более сложными понятиями, они поясняются. Главный

упор делается не на тонкости математического аппарата,

а на методическую сторону вопроса и на

непосредственные практические приложения. Многолетний опыт

авторов в преподавании теории вероятностей п смежных с

нею дисциплин во втузах, а также обширный опыт приме-

4 ПРЕДИСЛОВИЕ

нения вероятностных методов в самых различных

областях инженерной практики показывает, что именно такой,

а не формальный подход к изложению теории

вероятностей больше всего пригоден тем, для кого изучение

теории вероятностей не самоцель, а средство решения

конкретных инженерных задач и примеров. Окончание

решепия примера или задачи отмечается знаком >•

Вместе с тем, авторы стремились нигде не

поступаться точностью формулировок и должной математической

строгостью и изложить материал в соответствии с

современным уровнем развития науки о случайных явлениях.

В книгу не вошли теория случайных процессов,

теория массового обслуживания, специальные главы

математической статистики и их инженерные приложения.

Ограниченный отбор материала в данную книгу

определялся тем, что авторы предполагают по каждому из

указанных выше разделов написать отдельное руководство,

где, так же как и здесь, основное внимание будет уделено

инженерным приложениям.

Авторы приносят глубокую благодарность академику

АН СССР В. С. Пугачеву и профессору В. Н, Тутубалину

за ценные советы и поддержку, которую они оказали при

составлении проекта книги; члену-корреспонденту АН

СССР Н. А. Кузнецову, любезно согласившемуся

отрецензировать рукопись и сделавшему ряд полезных

замечаний; доценту Г. В. Данилову, оказавшему авторам

большую помощь при подготовке кнпги и изданию, а

также доктору физико-математических, наук А. Д. Вентцелю

за ряд ценных предложений.

Е.С. Вентцель,

ЛА. Овчаров

— Вы можете,—

продолжал Гермаин,— составить

счастие моей жизни, и оно ничего

не будет вам стоить: я знаю,

что вы можете угадать три

карты сряду...

А. С. Пушкин «Пиковая дама»

ВВЕДЕНИЕ

Теорией вероятностей называется математическая

наука, изучающая закономерности в случайных явлениях'.

Условимся, что мы будем понимать под «случайным

явлением».

При научном изучении и описании окружающего

мира часто приходится встречайся с особого типа

явлениями, которые принято называть случайными.

Характерна для них большая, по сравнению с другими, степень

неопределенности, непредсказуемости. Случайное

явление — это такое явление, которое при неоднократном

воспроизведении одного и того же опыта (испытания,

эксперимента) протекает каждый раз несколько по-

иному.

Приведем несколько примеров случайных явлений.

1. Одно и то же тело несколько раз взвешивается на

точных (аналитических) весах; результаты повторных

взвешивании несколько отличаются друг от друга. За счет

чего это происходит? За счет влияния многих мелких,

второстепенных факторов, сопровождающих взвешивание,

таких, например, как положение тела и разновесок на

чашках весов; вибрации аппаратуры; смещение головы

и глаза наблюдателя п т. п.

2. Производится ряд испытаний заводских изделии

определенного типа, например реле, на длительность

безотказной работы. Результат испытания от раза к разу

не остается постоянным, меняется. Эти изменения

обусловлены влиянием ряда малозначительных,

трудноуловимых факторов, таких, например, как микродефекты в

металле; разные температурные условия; разные условия

хранения и транспортировки изделии; отклонения

напряжения от номинала и т. д.

3. Производится ряд выстрелов из одного и того же

орудия по одной и той же цели. Условия стрельбы (вид

снаряда, угол установки орудия) одни и те же. Тем не

б ВВЕДЕНИЙ

менее точки попадания снарядов обнаруживают разброс

(так пазываемое «рассеивание»). Теоретически

траектории снарядов совпадают; практически они разнятся за

счет таких малозначительных, трудноуловимых факторов,

как-то: ошибки изготовления снарядов; отклонения веса

заряда от номинала; неоднородность его структуры, уже

не говоря о метеоусловиях, которые от выстрела к

выстрелу могут меняться.

4. Самолет определенного типа совершает полет на

заданной высоте; теоретически он должен летать

горизонтально, равномерно и прямолинейно. Фактически

полет сопровождается отклонениями центра массы самолета

от горизонтальной прямой и колебаниями самолета около

центра массы. Эти отклонения и колебания являются

случайными и связаны с турбулентностью атмосферы и

ошибками пилотирования.

5. Круглая, правильной формы монета щелчком

подбрасывается, вращается в воздухе и падает па стол,

открывая одиу из сторон: «герб» или «решку». Опыт

повторяется несколько раз. Как бы ни стараться соблюдать

одинаковыми его условия (высоту подбрасывания,

начальную скорость и момент вращения), результат

варьируется от раза к разу: иногда выпадает «герб», иногда —

«решка». Исход опыта — «герб» или «решка» —

обусловлен множеством мелких, трудноуловимых причин, в

числе которых, например, неровности поверхности стола.

6. Рассматривается непрерывная работа ЭВМ между

двумя очередными сбоями в решении задачи. Все

контролируемые условия работы ЭВМ: температура,

влажность, напряжение, характер решаемой задачи остаются

неизменными. Повторяя такой опыт несколько раз, мы

убеждаемся, что время работы ЭВМ между двумя

очередными сбоями будет разным (случайным). Это

объясняется тем, что различные элементы ЭВМ подвергаются

незначительным, неконтролируемым изменениям.

Все приведенные примеры рассмотрены здесь под

одним и тем же углом зрения: подчеркнуты случайные

вариации, неодинаковые результаты ряда опытов,

основные условия которых остаются неизменными. Эти

вариации всегда связаны с наличием каких-то второстепенных

факторов, влияющих на исход опыта, но не заданпых

в числе его основных условий. Основные условия опыта,

определяющие в общих и грубых чертах его

протекание, сохраняются неизменными; второстепенные — меня-»

ВВЕДЕНИЕ 7

ются от опыта к опыту и вносят случайные различия

в их результаты.

Совершенно очевидно, что в природе,нет ни одного

явления, в котором не присутствовали бы в той или

иной мере элементы случайности. Как бы точно ц

подробно ни были фиксированы условия опыта,

невозможно достигнуть того, чтобы при его повторении

результаты полностью и в точности совпадали. Случайные

отклонения неизбежно сопутствуют каждому

закономерному явлению. Тем не менее в ряде практических задач

этими случайными элементами можно пренебречь,

рассматривая вместо реального явления его упрощенную

схему, «модель», и предполагая, что в данных условиях

опыта явление протекат вполне определенным образом.

При этом из бесчисленного множества фактов,

влияющих на явление, выделяются самые главные, основные,

решающие; влиянием остальных, второстепенных,

факторов просто пренебрегают. Такая схема изучения

явлений (которую будем называть «детерминистской»)

постоянно применяется в физике, механике, технике.

Согласно этой схеме при решении любой задачи прежде

всего выделяется основной круг учитываемых условий и

выясняется, на какие параметры задачи он влияет; затем

применяется тот или иной Математический аппарат

(например, составляются и решаются дифференциальные

уравнения, описывающие явление); таким образом

выявляется основная закономерность, свойственная данному

явлению и дающая возможность предсказать результат

опыта по его заданным условиям. По мере развития

науки число учитываемых факторов становится все

больше, научный прогноз — все точнее. Это — классическая

схема так называемых «точных наук» — от условий опыта

к его однозначному результату.

Однако для решения ряда задач такая схема

оказывается плохо приспособленной. Это — те задачи, где

интересующий нас результат опыта существенно зависит

от стоЛь большого числа факторов, что практически

невозможно зарегистрировать и учесть их все. В этих

задачах многочисленные тесно переплетающиеся

второстепенные факторы так тесно связаны с результатом опыта,

что ничтожное, на первый взгляд, их изменение может

сыграть решающую роль, обусловить «успех» или

«неуспех» опыта. В таких случаях классическая схема точных

наук — детерминистская — оказывается непригодной,

8 ВВЕДЕНИЕ

Вернемся к вышеприведенным примерам случайных

явлений, в частности, к примеру 3 (стрельба из орудия).

Если мы конструируем прицельное приспособление, то

классическая, «детерминистская», схема вполне

достаточна. Проинтегрировав уравнения движения снаряда, мы

можем определить его траекторию, точку попадания.

Но предположим, что стрельба ведется по цели, размеры

которой меньше зоны рассеивания снарядов, и нас

интересуют вопросы: какой процент выпущенных снарядов

в среднем попадет в цель? Сколько нужно потратить

снарядов для того, чтобы с достаточной надежностью

поразить цель? Какие следует принять меры для

уменьшения расхода снарядов? И т. д.

Чтобы ответить на такие (и подобные им) вопросы,

обычная схема точных наук оказывается недостаточной.

Эти вопросы органически связаны со случайной природой

явления; для того чтобы на них ответить, очевидно,

нельзя просто пренебречь случайностью, надо изучить

явление рассеивания снарядов со стороны

закономерностей, присущих ему именно как случайному явлению.

Надо исследовать закон, по которому распределяются

точки попадания снарядов; выявить случайные причины,

вызывающие рассеивание, сравнить их между собой по

степени важности и т. д.

Рассмотрим другой пример. Некоторое техническое

устройство (скажем, система автоматического

управления) решает определенную задачу в условиях, когда на

нее непрерывно воздействуют случайные помехи. В

результате система решает задачу с некоторой ошибкой,

иногда выходящей за пределы допустимой. Возникают

вопросы: как часто будут появляться такие ошибки?

Какие меры надо принять для того, чтобы практически

исключить их возможность? И т. д.

Чтобы ответить на такие вопросы, необходимо

исследовать природу и структуру случайных возмущений,

воздействующих на систему, изучить реакцию системы на

эти возмущения, выяснить влияние конструктивных

параметров системы на вид реакции.

Подобные задачи, число которых в физике, технике

и инженерном деле чрезвычайно велико, требуют

изучения не только основных, главных закономерностей,

определяющих явление в общих чертах, но и

анализа случайных возмущений и искажений, связанных

с наличием второстепенных факторов и придающих

ВВЕДЕНИЕ 9

исходу опыта при заданных условиях элемент

неопределенности.

Какие же существуют пути и методы для

исследования случайных явлений?

С чисто теоретичесгсоп точки аренпя те факторы,

которые мы условно назвали «случайными», в принципе

ничем не отличаются от тех, которые мы выделили в

качестве «основных». Теоретически можно неограниченно

повышать точность решения задачи, учитывая все новые

и новые факторы. Однако на практике попытка

одинаково подробно и тщательно проанализировать влияние

всех факторов, от которых зависит явление, привела бы

только к тому, что решение, в силу непомерной

громоздкости и сложности, оказалось бы практически

неосуществимым и к тому же не имело бы никакой

познавательной ценности, относясь только к узкому кругу плохо

контролируемых условий.

Должна существовать принципиальная разница в

методах учета основных факторов, определяющих в

главных чертах ход и исход явления, и вторичных,

второстепенных факторов, влияющих на него в качестве

«погрешностей» или «возмущений». Племент

неопределенности, сложности и многопричинности, присущий

случайным явлениям, требует специальны? методов для

их изучения. Такие методы и разрабатываются в

теории вероятностей. Ее предметом являются специфические

закономерности, наблюдаемые в случайных явлениях.

Практика показывает, что, наблюдая в совокупности

массы однородных случайных явлений, мы часто

обнаруживаем в них своего рода устойчивости. Напри1

мер, если много раз подряд бросать монету, частота

появления герба (отношение числа выпавших гербов

к общему числу бросаний) постепенно выравнивается,

стабилизируется, приближаясь ко вполне определенному

числу, а именно к 1/2. Такое же свойство устойчивости

частот наблюдается и при многократном повторении

ряда других опытов с заранее неизвестным,

неопределенным исходом. Так, например, в хорошо налаженном

производстве устойчивым оказывается процент

доброкачественных изделий. Многолетние наблюдения показывают,

что частота рождения мальчиков для самых разных

географических и климатических условий весьма

устойчива (приблизительно равна 0,51). Устойчивость частот

наблюдается даже в таких сугубо непредсказуемых яв-

40 ВВЕДЕНИЕ

лениях, как уличный травматизм (именно эта

устойчивость позволяет планировать работу лечебных

учреждений и службы скорой помощи).

Устойчивость частот наблюдается в тех случаях,

когда мы имеем дело с массой однородных опытов, для

которых механизм воздействия случайных факторов

сходен. Не обладают свойством устойчивости частот те

явления с неопределенным исходом, где условия явно

неоднородны и даже несопоставимы. Например,

бессмысленно говорить об устойчивой «частоте возникновения

войн» (историческому процессу свойственны черты

неповторимости, направленности развития). Также

бессмысленно говорить об устойчивой частоте, скажем,

правильно решенных научных проблем или появления

гениальных произведений искусства.

Теория вероятностей занимается только темп

явлениями с неопределенным исходом, для которых

предполагается наличие устойчивости частот. Для таких

явлений она устанавливает определенные закономерности,

характерные для массы случайных явлений. Одно,

отдельное случайное явление остается в своем результате

неопределенным, непредсказуемым; только в массе

случайных явлений проявляются специфические

закономерности, которые выполняются тем точнее и строже, чем

обширнее массив изучаемых явлений. При очень

большом числе таких явлений случайность, непредсказуемость

практически исчезает.

Поясним это примером. В сосуде заключен некпй

объем газа, состоящий па большого числа молекул.

Каждая из них за секунду испытывает множество

столкновений с другими молекулами, многократно меняет скорость

и направление движения; траектория каждой отдельной

молекулы случайна. Известно, что давленР1е газа на

стенку сосуда обусловлено совокупностью ударов

молекул об эту стенку. Казалось бы, если траектория

каждой отдельной молекулы случайна, если неизвестно,

в какой точке и с какой скоростью она ударится о

стенку, то и давление на стенку должно было бы изменяться

случайным и непредсказуемым образом. Однако это не

так. Если число молекул достаточно велико, то давление

газа практически не зависит от траекторий отдельных

молекул и подчиняется вполне определенно]! и очень

простой физической закономерности. Случайные

особенности, свойственные движению каждой отдельной моле-

ВВЕДЕНИЕ 11

кулы, в массе взаимно погашаются, компенсируются.

В результате, несмотря на сложность и запутанность

отдельного случайного явления, возникает простая

закономерность, справедливая для массы случайных

явлений. Отметим, что именно массовость случайных

явлений обеспечивает выполнение этой закономерности

(при ограниченном числе молекул в объеме начинают

сказываться случайные отклонения от закономерности,

так называемые флуктуации).

Рассмотрим другой пример: производится ряд

взвешиваний одного и того же тела на аналитических весах;

каждый раз результат взвешивания записывается.

Вначале, пока число взвешиваний невелико, набор

результатов представляется хаотичным, беспорядочным. Однако

по мере увеличения числа взвешиваний в совокупности

результатов начинает обнаруживаться вполне

определенная закономерность; она проявляется тем отчетливее,

чем большее число взвешиваний произведено. Становится

ясно, что результаты группируются практически

симметрично около некоторого среднего значения; в

центральной области они расположены гуще, чем по краям,

причем густота их с удалением от центра убывает по вполне

определенному закону (так называемому «нормальному»,

которому большое внимание будет уделено в

дальнейшем).

Подобного рода закономерности (их называют

«статистическими») возникают, когда мы наблюдаем в

совокупности массивы однородных случайных явлений. Они

оказываются практически независимыми от

индивидуальных особенностей отдельных случайных явлении,

входящих в массив; эти особенности как бы взаимно

погашаются, нивелируются; выражаясь образно, «из

множества беспорядков возникает порядок». Средний, массовый

результат множества случайных явлений оказывается

практически уже не случайным, предсказуемым. Это н

является базой для практического применения

вероятностных (статистических) методов исследования.

Методы теории вероятностей не отменяют и не

упраздняют случайности, непредсказуемости исхода

отдельного опыта, но дают возможность предсказать, с каким-

то приближением, средний суммарный результат массы

однородных случайных явлений. Чем большее количество

однородных случайных явлений фигурирует в задаче,

тем отчетливее выявляются присущие им специфические

12 ВВЕДЕНИЕ

законы, тем с большей уверенностью и точное!ью

можно осуществлять научный прогноз.

Цель вероятностных (статистических) методов —

в том, чтобы, минуя слишком сложное (и зачастую

практически невозможное) исследование отдельного

случайного явления, обратиться непосредственно к законам,

управляющим массами таких явлений. Изучение этих

законов позволяет не только осуществлять прогноз в

области случайных явлений, но и целенаправленно влиять

на ход этих явлений, контролировать их, ограничивать

сФеРУ действия случайности, сужать ее влияние на

практику.

Приступая к изучению теории вероятностей с ее

специфическим объектом исследования (случайные, т. е.

непредсказуемые явления), надо отдавать себе отчет

в том, что прогнозы, даваемые методами этой науки,

несколько отличаются по своему характеру от привычных

нам прогнозов «точных наук». Не давая точного

указания, что именно произойдет при таких-то условиях,

вероятностный прогноз является приближенным; он

указывает только границ ы, в которых, с достаточно

высокой степенью достоверности, будут заключены

интересующие нас параметры. Чем обширнее изучаемый массив

случайных явлений, тем уже эти границы, тем точнее

и определеннее становится вероятностный прогноз.

Характерным для сегодняшнего этапа развития

науки является все более широкое применение

вероятностных методов во всех ее областях. Это связано с двумя

причинами. Во-первых, изучение явлений окружающего

мира, становясь более глубоким, требует выявления не

только основных закономерностей, но и возможных

случайных отклонений от них. Во-вторых, наука все больше

внедряется в такие области практики, где наличие и

большое влияние именно случайности не подлежит

сомнению, а иногда даже является определяющим.

В настоящее время нет практически ни одной

области науки, в которой в той или иной степени не

применялись бы вероятностные методы. В одних науках, в

силу специфики предмета и исторических условий, эти

методы находят применение раньше, в других — позднее.

Исторически первые пачаткп вероятностных методов

с соответствующим, еще довольно примитивным

математическим аппаратом возникли в XVIT веке, при

разработке теории азартных игр с целью дать рекомендации

ВВЕДЕНИЕ 13

игрокам. Затем эти методы стали применяться в

практике страховых компаний для установления разумных

размеров страховых премий. Постепенно область

применения вероятностных методов расширялась. Сегодня эти

методы распространяются все шире и шире. Целые

разделы современной физики (в частности, ядерная физика)

базируются на математическом аппарате теории

вероятностей. Широко применяются вероятностные методы

в современных электротехнике, радиотехнике, теории

связи, теории автоматического регулирования,

кибернетике, вычислительной технике, теории АСУ

(автоматизированных систем управления). Это и естественно, так как

работа современных автоматизированных систем

протекает в условиях случайных воздействий, без учета

которых невозможно разумное проектирование подобных

систем, выбор их конструктивных параметров.

Любая процедура управления чем бы то ни было

(техническим устройством, группой устройств, человеко-

машинным комплексом) протекает в заранее

неизвестных, случайных условиях, неизбежно сопровождается

случайными ошибками измерения тех или других

параметров, ошибками выполнения команд и т. д.; анализ

работы такой системы практически невозможен без

учета случайных факторов. Столь важные в народном

хозяйстве метеорологические прогнозы не могут строиться

без учета случайности процессов, протекающих в

атмосфере.

Знакомство с методами теории вероятностей

необходимо сегодня каждому грамотному инженеру. И не

только инженеру. Биология, физиология, медицина,

социология все шире применяют вероятностные методы. Не

чуждаются их и такие «исконно гуманитарные» науки,

как психология, лингвистика, литературоведение, даже

эстетика.

Как бы ни был обширен перечень научных

дисциплин, где сегодня применяются вероятностные методы, он

все же неизбежно страдает неполнотой. Короче будет

сказать, что нет области знаний, где не могли бы сказать

свое слово эти методы исследования.

Считать ли теорию вероятностей специальным

разделом математики или одной из естественных наук? И то

и другое. Математические законы теории вероятностей —

это отражение реальных статистических законов,

объективно существующих закономерностей в массовых слу-

14 ВВЕДЕНИЕ

чайных явлениях природы. К изучению этих явлений

теория вероятностей применяет математический метод и

по своему методу является одним из разделов

математики, столь же точным и строгим, как другие

математические науки.

Для инженера, применяющего теорию вероятностей

в своей практической деятельности, всего важнее не

математические тонкости этой теории, а умение распознать

в реальной задаче ее вероятностные черты, поставить,

если нужно, эксперимент, разумно обработать его

результаты и выработать рекомендации, как поступать, чтобы

добиться желаемого результата с минимальной затратой

сил и средств. Лучше всего такое умение приобретается

при рассмотрении конкретных примеров из области

инженерной практики. Таких примеров в нашей книге

будет много.

ГЛАВА 1

ОСНОВНЫЕ ПОНЯТИЯ ТЕОРИИ ВЕРОЯТНОСТЕЙ

1,1. Случайное событие. Его вероятность

Любая наука, развивающая общую теорию какого-

либо круга явлений, содержит ряд основных понятии, на

которых она базируется. Таковы, например, в геометрии

понятия точки, прямой, линии; в механике — понятия

силы, массы, скорости, ускорения. Естественно, что не

все основные понятия могут быть строго определены,

ибо «определить» понятие — это значит свести его к

другим, более известным. Очевидно, процесс определения

одних понятий через другие должен где-то кончаться,

дойдя до самых первичных понятий, к которым сводятся

все остальные и которые сами не определяются, а только

поясняются. Такие понятия существуют и в теории

вероятностей. Здесь мы рассмотрим некоторые из них.

Под опытом (экспериментом, испытанием) мы будем

понимать некоторую воспроизводимую совокупность

условий, в которых наблюдается то или другое явление,

фиксируется тот или другой результат. Заметим, что

«опыт» не обязательно должен быть поставлен

человеком; он может протекать независимо от него; при этом

человек выступает в роли наблюдателя или фиксатора

происходящего. От него зависит только решение: что

именно наблюдать и какие параметры фиксировать.

Если результат опыта варьируется при его

повторении, говорят об опыте со случайным исходом. Именно

такие опыты мы будем здесь рассматривать и добавление

«со случайным исходом» для краткости опускать. Тот

факт, что при повторении опыта его основные условия

сохраняются, и, значит, мы вправе ожидать устойчивости

частот, тоже не будем каждый раз оговаривать.

Случайным событием (или, короче, просто событием)

называется всякий факт, который в опыте со случайным

исходом может произойти или не произойти. События мы

будем обозначать большими буквами латинского

алфавита.

16 ГЛ. 1, ОСНОВНЫЕ ПОНЯТИЯ ТЕОРИИ ВЕРОЯТНОСТЕЙ

Рассмотрим несколько примеров событий.

1. Опыт — бросание монеты; событие А — появление

герба.

2. Опыт — бросание трех монет; событие В —

появление трех гербов.

3. Опыт — передача группы из п сигналов по каналу

связи; событие С—искажение хотя бы одного из них.

4. Опыт —выстрел по мишени; событие Z)

—попадание.

5. Опыт — вынимание наугад одной карты из колоды;

событие Е — появление туза.

6. Тот же опыт, что в примере 5; событие F —

появление карты червонной масти.

7. Опыт (наблюдение)—измерение количества

осадков, выпадающих в данном географическом пункте за

определенный месяц; событие G — выпадение более

N миллиметров осадков.

8. Опыт — лечение группы больных определенным

препаратом; событие Я — существенное улучшение более

чем у половины из них.

Все приведенные примеры начинались с описания

опыта, в котором появляется или не появляется событие.

В общем случае это необязательно; опыт может

упоминаться после формулировки события; например:

А — появление герба при бросании монеты;

В — появление трех гербов при бросании трех

монет и т. д.

Рассматривая перечисленные в наших примерах

события А, В, ..., Я, мы видим, что каждое из них обладает

какой-то степенью возможности — одни большей,

а другие меньшей, причем для некоторых из них мы

сразу можем решить, какое из них более, а какое менее

возможно. Например, сразу видно, что событие А более

возможно (вероятно), чем В1 а событие F более

возможно, чем Е. Относительно других событий нашего списка

таких выводов сразу сделать нельзя; для этого условия

опыта описаны недостаточно подробно. Так пли иначе,

любое случайное событие обладает какой-то степенью

возможности, которую в принципе можно измерить

численно. Чтобы сравнивать между собой события по

степени их возможности, нужно связать с каждым из

них какое-то число, которое тем больше, чем более

возможно событие. Это число мы и назовем

вероятностью события.

1.1. СЛУЧАЙНОЕ СОБЫТИЕ. ЕГО ВЕРОЯТНОСТЬ 17

Отметим, что сравнивая между собой по степени

возможности различные события, мы склонны считать более

вероятными те события, которые происходят чаще, менее

вероятными — те, которые происходят реже;

маловероятными—те, которые почти никогда не происходят.

Например, событие «выпадение дождя в Москве 1-го июня

предстоящего года» более вероятно, чем «выпадение

снега в Москве в тот же день», а событие «землетрясение

в Москве, превышающее по интенсивности 3 балла, в

течение предстоящего года» крайне маловероятно (хотя

такое землетрясение и наблюдалось в 1977 г., и

статистика говорит, что подобные события происходят примерно

раз в 100 лет). Таким образом, понятие вероятности

события с самого начала тесно увязывается с понятием его

частоты (подробнее это основное понятие будет

освещено ниже, см. п. 1.3).

Характеризуя вероятности событий числами, нужно

установить какую-то единицу измерения. В

качестве такой единицы естественно взять вероятность

достоверного события, т. е. такого, которое в результате

опыта неизбежно должно произойти. Пример

достоверного события — выпадение не более шести очков при

бросании игральной кости*). Другой пример

достоверного события: «камень, брошенный вверх рукой, вернется

на Землю, а не станет ее искусственным спутником».

Противоположностью достоверного события является

невозможное событие — то, которое в данном опыте

вообще не может произойти. Пример: «выпадение 12 очков

при бросании одной игральной кости». Невозможному

событию естественно приписать вероятность, равную

нулю.

Если приписать достоверному событию вероятность,

равную единице, а невозможному — равную нулю, то все

другие события — возможные, но не достоверные, будут

характеризоваться вероятностями, лежащими между

нулем и единицей, составляющими какую-то долю

единицы.

Таким образом, установлены единица измерения

вероятности — вероятность достоверного события и диапазон

изменения вероятностей — числа от нуля до единицы.

Какое бы событие А мы ни взяли, его вероятность Р(А)

*) «Игральной костью» называется кубпк, на шести гранях

которого нанесены 1, 2, 3, 4, 5, 6 точек (очков),

18 гл i. оснопные понятия теории перогттноглтп

удовлетворяет условию:

0<Р(Л)<1. A.1.1)

Очень большую роль в применении вероятностных

методов играют практически достоверные и

практически невозможные события.

Событие А называется практически невозможным,

если его вероятность не в точности равна нулю, но очень

близка к нулю:

Р {А)« 0.

Пример. Опыт: 32 буквы разрезной азбуки

смешаны между собой; наугад вынимается одна карточка,

стоящая на ней буква записывается, карточка возвращается

обратно и смешивается с другими. Такой опыт

производится 25 раз. Событие А состоит в том, что после 25

выниманий мы запишем первую строчку «Евгения Онегина»:

«Мой дядя самых честных правил».

Событие А не является физически невозможным;

в дальнейшем (см. п. 2.3) мы даже подсчитаем его

вероятность, которая равна (&) ". Она настолько мала,

что событие с такой вероятностью смело можно считать

практически невозможным. >

Аналогично, практически достоверным называется

событие, вероятность которого не в точности равна

единице, но очень близка к единице:

Введем новое важное понятие: противоположное

событие. Противоположным событию А называемся событие

JJ, состоящее в непоявлении события А.

Пример. Опыт: один выстрел по мишени.

Событие А — попадание в десятку. Противоположное событие

А — непопадание в десятку. >

Вернемся к практически невозможным и практически

достоверным событиям. Если какое-то событие А

практически невозможно, то противоположное ему А

практически достоверно, и наоборот.

Практически невозможные (п сопутствующие им

практически достоверные) события играют большую роль

в теории вероятностей: на них основана вся ее

познавательная ценность. Ни один прогноз в области случайных

явлений не является и не может являться полностью

1.1. СЛУЧАЙНОЕ СОБЫТИЕ ЕГО ВЕРОЯТНОСТЬ 19

достоверным; он может быть только практпческ и

достоверным, т. е. осуществляться с очень большой

вероятностью.

В основе применения всех выводов и рекомендаций,

добываемых с помощью теории вероятностей, лежит

принцип практической уверенности, который может быть

сформулирован следующим образом:

Если вероятность события А в данном опыте весьма

мала, то (при однократном выполнении опыта) можно

вести себя так, как будто событие А вообще невозможно,

г. е. не рассчитывать на его появление.

В повседневной жизни мы постоянно (хотя и

бессознательно) пользуемся этим принципом. Например,

выезжая куда-то на такси, мы не рассчитываем на

возможность погибнуть в дорожной катастрофе, хотя некоторая

(весьма малая) вероятность такого события все же

имеется. Отправляясь летом на Кавказ или в Крым, мы но

захватываем с собой зимней верхней одежды, хотя

какая-то (очень малая) вероятность того, что нас

настигнет мороз, все-таки не равна нулю.

Обратим внимание на слова «при однократном

выполнении опыта» в формулировке принципа практической

уверенности. Дело в том, что производя много опытов,

в каждом из которых вероятность события А ничтожно

мала, мы повышаем вероятность того, что событие А

произойдет хотя бы один раз в массе опытов.

В самом деле, представьте себе лотерею, в которой на

миллион билетов всего один выигрыш. Некто покупает

одип билет. Вероятность выигрыша для него 0,000001,

т. е. ничтожно мала, и можно считать выигрыш

практически невозможным. А теперь представьте себе, что

распроданы все 1000000 билетов. Кто-то из купивших

получит выигрыш, т. е. для него произойдет

практически невозможное событие. За счет чего? За счет того,

что опыт (покупка билета) произведен очень много раз.

Аналогично обстоит дело с надежностью сложных

агрегатов. Пусть агрегат состоит из большого числа N

элементов. Каждый из них отказывает (выходит из строя)

с ничтожно малой вероятностью. Но за счет того, что

элементов очень много, вероятность того, что откажет

хотя бы один из них, перестает быть близкой к нулю

(см. пример 16 п. 2.4).

Переходим к самому тонкому и трудному вопросу:

насколько мала должна быть вероятность

20 гл. i. основные понятия теории вероятностей

события, чтобы его можно было считать

практически невозможным?

Ответ на этот вопрос выходит за рамки

математической теории и в каждом отдельном случае решается из

практических соображений, в соответствии с той

важностью, которую имеет для нас желаемый результат

опыта. Чем опаснее возможная ошибка

предсказания, тем ближе к нулю должна быть

вероятность события, чтобы его считать

практически невозможным.

Например, когда мы, на основе вероятностных

расчетов, предсказываем, что средний результат N

взвешиваний не отклонится от истинного веса тела больше, чем па

заданную величину е, а вероятность того, что

отклонение будет больше е, равна 0,01, мы еще можем

примириться с этим и считать событие А — «ошибка

больше е» — практически невозможным. Чем мы в данном

случае рискуем? Легкой неправильностью предсказания.

Совершенно другое дело — если вероятность взрыва

космической ракеты при ее запуске равна тем же 0,01.

Риск велик, велика ответственность; в таких условиях

во что бы то ни стало надо добиваться «вероятности

неудачи», на несколько порядков меньшей.

Размер допустимой «вероятности риска» всегда

назначается исследователем, исходя из степени опасности

риска. Выбирается он более или менее произвольно.

Поэтому на всех прогнозах, осуществляемых методами

теории вероятностей, всегда лежит отпечаток «начального

произвола», связанного с выбором достаточно малой

«вероятности риска»,— вероятности того, что прогноз не

оправдается. Это обстоятельство отнюдь не снижает

ценности вероятностных методов исследования.

«Ориентировочный прогноз» все же лучше, чем «никакой прогноз»,

который вытекал бы из требования, чтобы «вероятность

риска» была в точности равна нулю.

Чтобы убедиться в полезности вероятностных методов

предсказания, предлагаем читателю (если он не ленив

и любопытен) проделать элементарный опыт: бросить

монету любого достоинства N = 1000 раз (для простоты

можно бросать сразу по 10 штук, тщательно

перетряхнув их в коробке) и подсчитать число появившихся

гербов. На основе вероятностных методов можно утверждать

с практической достоверностью (в данном случае с

вероятностью приблизительно 0,997), что число выпавших

1.2. НЕПОСРЕДСТВЕННЫЙ ПОДСЧЕТ ВЕРОЯТНОСТЕЙ 21

гербов не выйдет за пределы D53-5-547)*). Не слишком

точное предсказание, не правда ли? Но ведь не

пользуясь вероятностными методами, мы могли бы дать

только одно, строго достоверное, но зато тривиальное

предсказание: число выпавших гербов будет заключено в

пределах @-М000).

1.2. Непосредственный подсчет

вероятностей

Существует класс опытов, для которых вероятности

их возможных исходов можно вычислить, исходя

непосредственно из самих условий опыта. Для этого нужно,

чтобы различные исходы опыта обладали симметрией и

в силу этого были объективно одинаково возможными.

Рассмотрим, например, опыт, состоящий в бросании

игральной кости. Если кубик выполнен симметрично,

«правильно» (центр тяжести не смещен ни к одной из

граней), естественно предположить, что любая из шести

граней будет выпадать так же часто, как каждая из

остальных. Так как достоверное событие «выпадет какая-

то из граней» имеет вероятность, равную единице, и

распадается на шесть одинаково возможных вариантов A,

2, 3, 4, 5 или 6 очков), то естественно приписать

каждому из них вероятность, равную 1/6.

Для всякого опыта, обладающего симметрией

возможных исходов, можно применить аналогичный прием,

который называется непосредственным подсчетом

вероятностей.

Симметрия возможных исходов чаще всего

наблюдается в искусственно организованных опытах, где

приняты специальные меры для ее обеспечения (например,

тасовка карт или костей домино, которая для того и

производится, чтобы каждая из них могла быть выбрана с

одинаковой вероятностью; или же приемы случайного

выбора группы изделий для контроля качества в

заводской практике). В таких опытах подсчет вероятностей

событий выполняется всего проще. Не случайно

первоначальное свое развитие (еще в XVII веке) теория

вероятностей получила на материале азартных игр,

которые поколениями вырабатывались именно так, чтобы

*) О том, как делаются такие предсказания, можно узнать в

гл. 10, п. 10.2, пример 12.

22 ГЛ. 1. ОСНОВНЫЕ ПОНЯТИЯ ТЕОРИИ ВЕРОЯТНОСТЕЙ

результат опыта не зависел от поддающихся контролю

его условий (рулетка, кости, карточные игры). Прием

непосредственного подсчета вероятностей, исторически

возникший вместе с математической теорией случайных

явлений, был положен в основу так называемой

«классической» теории вероятностей и долгое время считался

универсальным. Опыты, не обладающие симметрией

возможных исходов, искусственно сводились к

«классической» схеме.

Несмотря на ограниченную сферу практического

применения этой схемы, она все же представляет известный

интерес, так как именно на ней легче всего

познакомиться со свойствами вероятностей.

Перед тем как дать способы непосредственного

подсчета вероятностей, введем некоторые вспомогательные

понятия.

1. Полная группа событий. Говорят, что

несколько событий в данном опыте образуют полную

группу, если в результате опыта неизбежно должно

появиться хотя бы одно из них.

Примеры событий, образующих полную группу:

1) «выпадение герба» и «выпадение решки» при

бросании монеты*);

2) появление «1», «2», «3», «4», «5», «6» очков при

бросании игральной кости;

3) «два попадания», «два промаха» и «одпо

попадание, один промах» при двух выстрелах по

мишени;

4) «появление белого шара» и «появление черного

шара» при вынимании одного шара пз урны, в которой

2 белых и 3 черных шара **);

5) «появление хотя бы одного белого» и «появление

хотя бы одного черного шара» при вынимании двух

шаров из той же урны.

Специально обратим внимание на последний пример.

В нем даны два события, которые не исключают друг

друга: в самом деле, если вынуть 1 белый и 1 черный

шар, появляется и то и другое. Но не зря же при

определении полной группы событий мы сказали «неизбеж-

¦) Исход «монета встанет на ребро» мы отбрасываем, как

ничтожно маловероятный (практически невозможный).

•*) Во всех задачах «па урпы» здесь и в дальнейшем мы

будем предполагать, что шары тщательно перемешаны.

1.2. НЕПОСРЕДСТВЕННЫЙ ПОДСЧЕТ ВЕРОЯТНОСТЕЙ 23

но должно появиться хотя бы одно из них»

(«хотя бы одно» значит «одно или больше»). Если события

образуют полную группу, то опыт не может

кончиться помимо ни х. К полной группе событий

можно прибавлять еще какие угодно события, любые

исходы опыта; от этого полнота группы событий не

утрачивается.

2. Несовместные события. Несколько

событии в данном опыте называются несовместными, если

никакие два из них не могут появиться вместе.

Примеры несовместных событии:

1) «выпадение герба» и «выпадение решки» при

бросании монеты;

2) «два попадания» и «два промаха» при двух

выстрелах;

3) «выпаденпе двух», «выпадепие трех» п

«выпадение пяти» очков при однократном бросашш игральной

кости;

4) «появление туза», «появление десятки» и

«появление карты с картинкой» (короля, дамы или валета)

при вынимании одной карты из колоды;

5) «появление трех» и «появление более трех»

очков при бросанпп игральной кости;

6) искажение «ровно пяти», «ровно двух» п «не

менее шести» символов при передаче сообщения,

состоящего пз 10 символов.

Вспомним, что к полной группе событии можно

было добавлять любые другие события, не нарушая

полноты. Что касается несовместных событий, то из них

можно выбрасывать любые (пока остаются хотя бы два),

не нарушая свойства несовместности.

3. Равновозможные события. Несколько

событий в данном опыте называются равновозможными,

если по условиям симметрии есть основание считать, что

ни одно пз них не является объективно более

возможным, чем другое.

Заметим, что равновозможные события не могут

появляться иначе, чем в опытах, обладающих симметрией

воЗхМожных исходов; наше незнание о том, какое пз

них вероятнее, не есть основание для того, чтобы

считать события равновозможнымп.

Примеры равновозможных событий:

1) «выпадение герба» и «выпадение решки» прп

бросании симметричной, «правильной» монеты;

24 гл. i. основные понятия теории вероятностей

2) выпадение «трех», «четырех», «пяти» и «шести»

очков при бросании симметричной, «правильной»

игральной кости;

3) появление шара с номером «1», «2», «4» и «5»

при вынимании наугад шара из урны, в которой 10

перенумерованных шаров;

4) появление шаров с номерами «2 и 3», «3 и 4»,

«5 и 8» при вынимании двух шаров из той же урны;

5) появление карточки «с буквой а», «с буквой ф»

и «с буквой щ» при вынимании одной из тщательно

перемешанных карточек детской азбуки;

6) появление карты «червонной», «бубновой»,

«трефовой» или «пиковой» масти при вынимании карты из

колоды.

Заметим, что равновозможность событий в каждом из

этих опытов обеспечивается специальными мерами

(симметричное изготовление костп; тасовка карт;

тщательное перемешивание шаров в урие и т. п.).

Из группы, содержащей более двух равновозможных

событий можно исключать любые (кроме последних

двух), не нарушая их равновозможности.

С опытами, обладающими симметрией возможных

исходов, связываются особые группы событий, обладающие

всеми тремя свойствами: они образуют полную группу,

несовместны и равновозможны.

События, образующие такую группу, называются

случаями (иначе «шансами»).

Примеры случаев:

1) появление «герба» и «решки» при бросанип

монеты;

2) появление «1», «2», «3», «4», «5» и «6» очков

при бросании игральной костп;

3) появление шара с номером «1», «2», ... при

вынимании одного шара из урны, в которой п

перенумерованных шаров;

4) появление карты «червонной», «бубновой»,

«трефовой» и «пиковой» масти при вынимании одной карты

из колоды в 36 листов.

Если опыт обладает симметрией возможных исходов,

то случаи представляют собой исчерпывающий набор

его равновозможных и исключающих друг друга исходов.

Про такой опыт говорят, что он сводится к схеме

случаев (иначе —к «схеме урн», ибо любую

вероятностную задачу для такого опыта можно заменить экви-

1.2. НЕПОСРЕДСТВЕННЫЙ ПОДСЧЕТ ВЕРОЯТНОСТЕЙ 25

валентной ей задачей, где фигурируют урны, содержащие

шары тех или других цветов). Для таких опытов

возможен непосредственный подсчет вероятностей, основанный

на подсчете доли так называемых благоприятных

случаев в общем их числе.

Случай называется благоприятным (или

«благоприятствующим») событию Л, если появление этого случая

влечет за собой появление данного события.

Например, при бросании игральной кости из шести

случаев («1», «2», «3», «4», «5», «6» очков) событию А —

«появление четного числа очков» благоприятны три

случая: «2», «4», «6» и не благоприятны остальные три.

Событию В — «появление не менее 5 очков»

благоприятны случаи «5», «6», и не благоприятны остальные

четыре.

Если опыт сводится к схеме случаев, то вероятность

события А в данном опыте можно вычислить как долю

благоприятных случаев в общем их числе:

m А

РD)--^, A.2.1)

где wA —число случаев, благоприятных событию А; п —

общее число случаев.

Формула A.2.1), так называемая «классическая

формула» для вычисления вероятностей, предложенная еще

в XVII веке, когда главным полем приложения теории

вероятностей были азартные игры (в которых симметрия

возможных исходов обеспечивается специальными

мерами), долгое время (вплоть до XIX века) фигурировала в

литературе как «определение вероятности»; те задачи,

в которых схема случаев отсутствует, искусственными

приемами сводились к ней. В настоящее время

формального определения вероятности не дается (это понятие

считается «первичным» и не определяется), а при его

пояснении исходят из других принципов, непосредственно

связывая его с понятием частоты события (см. п. 1.3).

Применяется также аксиоматическое,

теоретико-множественное построение теории вероятностей на основе

общих положений теории множеств и небольшого числа

аксиом (см. пп. 1.4, 1.5).

Что касается формулы A.2.1), то она сохраняется

ныне лишь для подсчета вероятностей событий в опытах,

обладающих симметрией возможных исходов. Приведем

несколько примеров ее применения.

26 ГЛ. 1. ОСНОВНЫЕ ПОНЯТИЯ ТЕОРИИ ВЕРОЯТНОСТЕЙ

Пример 1. В урне находится 5 шаров, из которых

2 белых и 3 черных. Из урны наугад вынимается один

шар. Найти вероятность того, что этот шар будет белым.

Решение. Обозначим А интересующее нас событие:

А = (появление белого шара) *).

Общее число случаев п = 5; из них два благоприятны

событию А: тА = 2. По формуле A.2.1) Р(^) = 2/5. >

Пример 2. В урне 7 шаров: 4 белых и 3 черных.

Из нее вынимаются (одновременно или последовательно)

два шара. Найти вероятность того, что оба они будут

белыми:

В = {оба шара белые).

При решении этой задачи и других ей подобных мы

будем пользоваться элементарными формулами

комбинаторики, в частности, формулой для числа с о ч е т а н и it.

Число сочетаний из к элементов по / — это число

способов, какими можно выбрать / различных элементов из

к\ обозначается оно Ck и вычисляется по формуле:

ri *(*-1) ¦•.(/;- /-!- 1)

Или, пользуясь знаком факториала (!)

, Л: (Л- — 1) ...(*— /+ 1) *I

Число сочетаний обладает следующими свойствами:

Пользуясь формулой A.2.2), решим пример 2.

Решение. Общее число случаев в примере 2 равно

числу способов, какими можно выбрать 2 шара из 7:

а число случаев, благоприятных событию 5,— это число

способов, какими можно выбрать 2 белых шара из 4:

*) Здесь и в дальпейшем мы будем пользоваться подобпым

обозначением событий, ставя о фигурные скобки их словесное

описание.

1.2. НЕПОСРЕДСТВЕННЫЙ ПОДСЧЕТ ВЕРОЯТНОСТЕЙ 27

Отсюда

Р(В)-±- 2 ь

Пример 3. В партии из К изделий М дефектных.

Пз партии выбирается для контроля к изделий (к<К).

Найти вероятность того, что среди них будет ровно т

дефектных (т ^ к).

Решение. Общее число случаев п = Ск* Найдем

mD — число случаев, благоприятных событию

D = {ровно т дефектных изделий в контрольной партии).

Найдем сперва число способов, какими из М

дефектных изделий можно выбрать т для контрольной партии;

оно равно C™i- Но ото еще не все: к каждой комбинации

дефектных изделий пужно присоединить комбинацию из

fe — m доброкачественных; это можно сделать CjfJlj

способами. Каждая комбинация из т дефектных изделий

может сочетаться с каждой комбинацией пз k — m

доброкачественных; число тех и других комбинаций надо

перемножить. Поэтому число благоприятных событию D

случаев равно nip = C^'CkIIm и

Р(В)-СТгСкК--УСкК. > A,2.3)

Пример 4. Некто выбирает наугад 6 клеток

«Спортлото» F пз 49). Найти вероятность того, что он

правильно угадает пз числа выигравших 6 номеров:

А = {ровно три},

В =» {ровно четыре},

С== {ровно пять},

D = {все шесть}.

Решение. Нетрудно убедиться, что задача по

структуре полностью совпадает с предыдущей, если считать

«дефектными» выигравшие номера, а

«доброкачественными»—не выигравшие. Применяя формулу A.2.3),

полагая в ней ЛГ = 49, М = 6, а т — последовательно

равным 3, 4, 5, 6, получим:

с. С ^

р (А) - -±^ » 1,765.1(Гг, Р (Я) - -5-12 « 9,686- Ю~\

С С4»

~8' >

28 ГЛ. 1. ОСНОВНЫЕ ПОНЯТИЯ ТЕОРИИ ВЕРОЯТНОСТЕЙ

Пример 5. Опыт состоит в одновременном (или

последовательном) бросании двух монет. Найти вероятность

события

А = {хотя бы на одной монете выпадет герб}.

Решение. С первого взгляда легкомысленному и

торопливому читателю может показаться, что в данной

задаче три случая:

Л! = {два герба); Лг^дпе решки};

Аг = {герб и регака}.

Однако это неверно: эти события неравновозможны;

последнее вдвое вероятнее каждого из остальных.

Составим схему случаев; для этого назовем монеты: первая

и вторая (если они бросаются последовательно, первой

будет первая по времени; если одновременно, то,

например, та, центр которой ляжет севернее). Случаями будут

следующие события:

2?i = {на первой монете герб, на второй герб},

В2 =» {на первой монете решка, на второй решка),

Bz * {на первой монете герб, на второй решка),

^ — {на первой монете решка, на второй герб).

Найдем Р(А). Из четырех случаев событию А

благоприятны все, кроме В2; значит, тА = 3 и РD) = 3/4.

Событию As = {герб и решка) благоприятны два

последних случая В3 и /?4, откуда Р (^3) = 2/4 «* 1/2, т. е.

событие А3 вдвое вероятнее каждого из событий Av и А2. >

1.3. Частота пли статистическая

вероятность события

Как уже знаем, формула A.2.1) для

непосредственного подсчета вероятностей применима только тогда,

когда опыт, в результате которого может появиться

интересующее нас событие, обладает симметрией возможных

исходов. Очевидно, это далеко не всегда так, и

существует огромный класс событий, вероятности которых нельзя

вычислять по «классической» формуле.

Возьмем, к примеру, неправильно сделанпую

игральную кость (со смещенным центром тяжести). Событие

А «{выпадение 5 очков) уже не будет обладать

вероятностью 1/6. Но какой же? И как ее найти? Ответ

интуитивно ясен: надо «попробовать» побросать кость доста-

i.3. частота или статистическая вероятность 29

точно много раз и посмотреть, насколько часто будет

появляться событие А,

Очевидно, что вероятности таких событий, как

В = (попадание в цель при выстреле},

С = {выход из строя интегральной схемы в течение

одного часа работы),

D = {при контроле изделий будет выявлено за день

ровно т дефектных),

также не могут быть пайдены по формуле

A.2.1)—соответствующие опыты к схеме случаев не сводятся. Тем не

менее, естественно предположить, что каждое из них

обладает какой-то степенью объективной возможности,

которая при многократном повторении соответствующих

опытов будет отражаться в относительной частоте

событий.

Мы будем исходить из предположения, что каждое из

случайных событии (сводится опыт к схеме случаев или

нет, лишь бы он был неограниченно воспроизводим)

обладает какой-то вероятностью,

заключенной между нулем и единицей. Для

опытов, сводящихся к схеме случаев, подсчет вероятностей

производится (прямо или косвенно) по формуле A.2.1).

С теми же опытами, которые к схеме случаев не

сводятся, дело обстоит сложнее: прямое или косвенное

нахождение вероятностей событий корнями своими уходит

в сбор данных, статистику, массовый эксперимент.

Введем одно из важнейших понятий теории

вероятностей — понятие частоты случайного события.

Если производится серия из п опытов, в каждом из

которых может появиться или не появиться событие А,

то частотой события А в данной серии опытов

называется отношение числа опытов, в которых появилось

событие Л, к общему числу п произведенных опытов.

Частоту события часто называют его

статистической вероятностью (в отличие от ранее введенной

«математической» вероятности).

ч Подчеркнем, что для вычисления частоты события

недостаточно знать условия опыта, нужно еще располагать

каким-то массивом статистических данных. Частота —

характеристика опытная, экспериментальная.

Условимся обозначать частоту (статистическую

вероятность) события А знаком Р*(-4) (здесь и в дальней-

30 ГЛ. 1. ОСНОВНЫЕ ПОНЯТИЯ ТЕОРИИ ВЕРОЯТНОСТЕЙ

шем звездочка у буквы будет указывать на

статистический характер соответствующего параметра). Согласно

определению, частота события А вычисляется по

формуле:

м

р*(Л) = -^г A.3.1)

где п — число произведенных опытов (не путать с

числом случаев в «классической схеме»!), МА — число

опытов, в которых событие А появилось.

При небольшом п частота события носит в

значительной мере случайный характер. Пусть, например,

опыт — бросание монеты, событие А = (появление герба}.

Вероятность этого события, по формуле A.2.1), Р(Л) =

— 1/2. Что касается частоты Р* {А), то она вовсе не

обязана равняться 1/2 и даже быть близкой к ней.

Например, при пяти бросаниях (п = 5) вполне возможно,

что герб появится только один раз: Р* (А) =* 1/5; менее

вероятно, но тоже возможно, что он не появится вообще

ни разу: Р* (А) = 0, или все пять раз: Р*(А) = 1.

Одним словом, при малом числе опытов частота события

непредсказуема, случайна. Однако при большом числе

опытов п частота все больше теряет свой случайный

характер: она проявляет тенденцию

стабилизироваться, приближаясь, с незначительными колебаниями,

к некоторой средней постоянной величине*). Например,

при многократном бросании монеты частота появления

герба будет лишь незначительно уклоняться от 1/2 — 0,5.

Для иллюстрации в табл. 1.3.1 приведены результаты

серии из п = G00 бросаний монеты (для простоты опыт

подразделен на 60 «подсерпй», в каждой из которых

бросались одновременно 10 тщательно встряхнутых монет

и подсчитывалось число выпавших гербов).

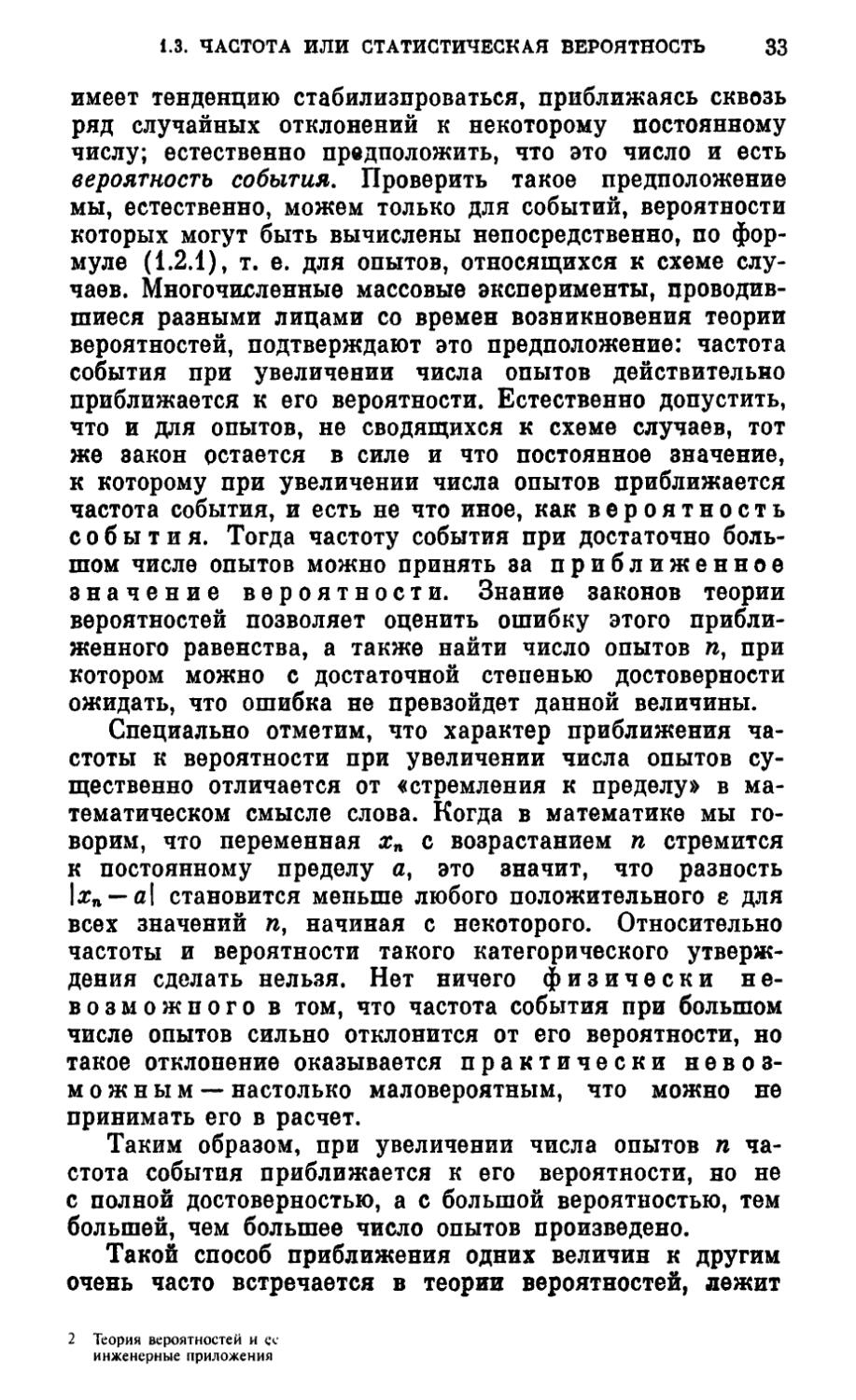

Для иллюстрации на рис. 1.3.1 изображена

зависимость частоты Р*(Л) появления герба от числа

опытов л.

Из этого графика видно, что по мере увеличения п

частота проявляет тенденцию стабилизироваться,

приближаясь сквозь ряд случайных отклонений к постоян-

*) Естественно, это справедливо только для тех случайных

явлений, которые обладают свойством устойчивости частот (см.

введение), но только такими явлениями и занимается теория ьэ-

роятяостей.

1.3. ЧАСТОТА ИЛИ СТАТИСТИЧЕСКАЯ ВЕРОЯТНОСТЬ

31

ной величине, которую мы положим равной 0,5 (это —

как раз вероятность Р (А) появления герба в одном

опыте).

Из рассмотрения табл. 1.3.1 и графика рис. 1.3.1 мы

можем сделать ряд поучительных выводов.

1. По мере увеличения числа опытов п частота

события имеет тенденцию приближаться к его вероятности.

Т а б л и ц а 1.3.1

Число

ОПЫТОВ ?1

10

20

30

40

50

60

70

80

90 -

100

110

120

130

140

150

100

170

180

190

200

Р* (А)

0,600

0,650

0,600

0,575

0,540

0,550

0,528

0,512

0,588

0,490

0,550

0,492

0,523

0,500

0,493

0,475

0,471

0,472

0,463

0,465

п

210

220

230

240

250

260

270

280

290

300

310

320

330

340

350

360

370

380

390

400

Р* U)

0,462

0,472

0,470

0,479

0,484

0,477

0,489

0,482

0,493

0,497

0,500

0,503

0,497

0,506

0,497

0,497

0,495

0,492

0,500

0,498

п

410

420

430

440

450

460

470

480

490

500

510

520

530

540

550

560

570

580

590

600

Р* U)

0,502

0,512

0,512

0,514

0,519

0,515

0.515

0,510

0,508

0,510

0,506

0,516

0,513

0,515

0,513

0,511

0,512

0,509

0,507

0,505

2. Это приближение идет довольпо медленно (гораздо

медленнее, чем хотелось бы!), но явно прослеживается

на экспериментальном материале.

3. Колебания частоты около вероятности носят

случайный, незакономерный характер. Если бы мы повторили

тот же массовый опыт (произвели бы другие 600

бросаний монеты), то кривая зависимости частоты Р* (А) от

числа опытов п имела бы другой конкретный вид, но,

по-видимому, общая тенденция приближаться к 0,5

сохранилась бы.

Теперь спросим себя: можно ли сказать, что при

увеличении п частота Р* (^4) стремится к вероятности

Р (А) в обычном математическом смысле слова? Нет,

этого сказать нельзя, именно в связи со случаи-

32

ГЛ 1. ОСНОВНЫЕ ПОНЯТИЯ ТЕОРИИ ВЕРОЯТНОСТЕЙ

н о с т ь ю процесса приближения. В самом деле,

теоретически, например, могло ли бы случиться, что все

600 раз выпал герб и Р* (А) оказалось равным единице?

Теоретически могло бы, а на практике — нет. Вероятность

того, что все 600 раз выпадет герб, настолько мала

(в дальнейшем (см. гл. 2, п. 2.4) мы вычислим ее и

убедимся, что она равна A/2N00), что можно пренебречь

возможностью такого совпадения. Подсчеты показывают,

0,650

0,500

0,550-

100

200 300

Рис. 1.3.1

Ц-00

500

600 л

что даже значительно меньшие отклонения частоты от

вероятности при п = 600 практически не встречаются.

Забегая вперед (см. гл. И), сообщим читателю, что при

шестистах бросаниях монеты частота появления герба

почти наверное не отклонится от 0,5 больше, чем 0,06

(в дальнейшем вы научитесь самостоятельно находить

такие границы, за которые практически наверняка не

выйдут отклонения численного результата опыта от

заранее предсказанного или искомого значения (см.

гл. 11)).

Подмеченная нами на конкретном примере

закономерность имеет более общий смысл. А именно, если

воспроизводить достаточное число раз один и тот же опыт

со случайным исходом, в котором может появиться или

не появиться событие Л, частота Р*(Л) этого события

1.3. ЧАСТОТА ИЛИ СТАТИСТИЧЕСКАЯ ВЕРОЯТНОСТЬ 33

имеет тенденцию стабилизироваться, приближаясь сквозь

ряд случайных отклонений к некоторому постоянному

числу; естественно предположить, что это число и есть

вероятность события. Проверить такое предположение

мы, естественно, можем только для событий, вероятности

которых могут быть вычислены непосредственно, по

формуле A.2.1), т. е. для опытов, относящихся к схеме

случаев. Многочисленные массовые эксперименты,

проводившиеся разными лицами со времен возникновения теории

вероятностей, подтверждают это предположение: частота

события при увеличении числа опытов действительно

приближается к его вероятности. Естественно допустить,

что и для опытов, не сводящихся к схеме случаев, тот

же закон остается в силе и что постоянное значение,

к которому при увеличении числа опытов приближается

частота события, и есть не что иное, как вероятность

события. Тогда частоту события при достаточно

большом числе опытов можно принять за приближенное

значение вероятности. Знание законов теории

вероятностей позволяет оценить ошибку этого

приближенного равенства, а также найти число опытов /г, при

котором можно с достаточной степенью достоверности

ожидать, что ошибка не превзойдет данной величины.

Специально отметим, что характер приближения

частоты к вероятности при увеличении числа опытов

существенно отличается от «стремления к пределу» в

математическом смысле слова. Когда в математике мы

говорим, что переменная хп с возрастанием п стремится

к постоянному пределу а, это значит, что разность

\хп — а\ становится меньше любого положительного е для

всех значений п, начиная с некоторого. Относительно

частоты и вероятности такого категорического

утверждения сделать нельзя. Нет ничего физически

невозможного в том, что частота события при большом

числе опытов сильно отклонится от его вероятности, но

такое отклонение оказывается практически

невозможным—настолько маловероятным, что можно не

принимать его в расчет.

Таким образом, при увеличении числа опытов п

частота события приближается к его вероятности, но не

с полной достоверностью, а с большой вероятностью, тем

большей, чем большее число опытов произведено.

Такой способ приближения одних величин к другим

очень часто встречается в теории вероятностей, лежит

2 Теория вероятностей и ее

инженерные приложения

34 гл. i. основные понятия теории вероятностей

в основе большинства ее выводов и рекомендации и

носит специальное название: «сходимость по вероятности».

Говорят, что величина А'п сходится по вероятности

к величипе а, если при сколь угодио малом е

вероятность неравенства \Хп — а\ < г с увеличением п

неограниченно приближается к единице.

Применяя этот термин, можно сказать, что при

увеличении числа опытов п частота события не «стремится»

к его вероятности, а «сходится к ней по вероятности».

Таким образом, вводя поиятие частоты события и

пользуясь связью между нею и вероятностью, мы

получаем возможность приписать определенные вероятности,

заключенные между нулем и единицей, не только

событиям, для которых применима схема случаев, но и тем

событиям, которые к этой схеме не сводятся; достаточно,

чтобы опыт обладал свойством устойчивости частот,

иными словами, мог быть неограниченно воспроизводим в

практически одинаковых условиях. Тогда можпо,

производя достаточно большое число опытов, приближенно

положить искомую вероятность события равной его

частоте.

В дальнейшем мы увидим, что для определения

вероятности события в опыте, не сводящемся к схеме

случаев, сравнительно редко надо непосредственно

находить из серии опытов его частоту. Теория вероятностей

располагает способами, позволяющими находить

вероятности событий не прямо, а косвенно, через

вероятности других событий, с ними связанных. В сущности,

такие косвенпые способы и составляют главное содержание

теории вероятностей. Но и при пользовании косвенными

способами (если опыт не сводится к схеме случаев)

в копечном итоге все же приходится обращаться к

экспериментальным данным.

Выведем некоторые свойства частот, справедливые не

только при большом, по и при любом число опытов гс.

1. Правило сложения часют. Если два

события А и Б несовместны, то частота события С,

состоящего в том, что появится А или В (безразлично, какое

имепно), равна сумме частот этих событий:

Р* (С) - Р* {А или В} - Р* (А) + Р* (В). A.3.2)

Действительно, если число опытов, в которых

появилось событие А, равно МА, а число опытов, в которых

1.3. ЧАСТОТА ИЛИ СТАТИСТИЧЕСКАЯ ВЕРОЯТНОСТЬ 35

появилось событие В, равно Мв и события А и В

несовместны, то

Р* (С) = Л^4^ = ^ + ^ = Р* (Л) + Р*(Я).

2. Правило умножения частот. Для любых

двух событий А и В частота события Д состоящего в том,

что появятся оба события:

D = U и В)

равна частоте одного из них, умноженной на «условную

частоту» другого, вычисленную в предположении, что

первое имело место:

Р*(?>) = Р*{Л и В)-Р*(А)-Р*(В\А)% A.3.3)

где Р* (В | А) — частота события #, вычисленная

только для тех опытов, в которых

произошло событие А (предполагается, что МАФЪ).

Действительно, пусть в МА опытах произошло

событие А; в MD опытах оно сопровождалось появлением

события В, т. е. происходило событие D = {А и В). Тогда

частота события D

Но второй сомножитель в формуле A.3.4) есть не что

иное, как частота события В, вычисленная только

для тех опытов, в которых произошло

событие А (назовем «условной частотой события В при

наличии А» и обозначим Р*(В\А)).

Заметим, что условную частоту события В при

наличии А можно вычислить и исходя из P*(D) по

формуле:

P*{B\A)-P*(D)/P*(A), A.3.5)

т. е. условная частота события В при наличии А может

быть получена делением частоты события D = {А и В] на

частоту события А.

В дальнейшем мы увидим, что аналогичные правила

сложения и умножения справедливы и для вероятностей

событий.

Понятие частоты события является кардинально

важным в теории вероятностей. Можно построить все ее

здание, исходя из основного понятия частоты и постуди-

36 ГЛ. 1. ОСНОВНЫЕ ПОНЯТИЯ ТЕОРИИ ВЕРОЯТНОСТЕЙ

руя свойства не вероятностей, а частот (такое

построение теории вероятностей было еще в начале XX века

предложено Р. Мизесом; да и в настоящее время

некоторые авторы предпочитают излагать теорию вероятпо-

стей на частотной основе). С нашей точки зрения

наиболее современным (и, что немаловажно, соответствующим

традициям изложения теории вероятностей в

университетах) является аксиоматический теоретико-

множественный подход, связанный с идеями

А. Н. Колмогорова; этого подхода мы и будем

придерживаться в дальнейшем.

ГЛАВА 2

АКСИОМАТИКА ТЕОРИИ ВЕРОЯТНОСТЕЙ.

ПРАВИЛА СЛОЖЕНИЯ И УМНОЖЕНИЯ

ВЕРОЯТНОСТЕЙ И ИХ СЛЕДСТВИЯ

2.1. Элементарные сведения

из теории множеств

Напомним тому, кто их знает, и сообщим тому, кто

впервые с ними встречается, основные понятия этой

математической науки.

Множеством называется любая совокупность

объектов произвольной природы, каждый из которых

называется элементом множества.

Примеры множеств: 1) множество студентов,

обучающихся в данном вузе; 2) множество натуральных чисел,

не превосходящих 100; 3) множество точек на плоскости,

лежащих внутри или на границе круга радиуса г с

центром в начале координат; 4) множество точек на

числовой оси, расстояние от которых до точки с абсциссой а

не превышает d.

Множества мы будем обозначать по-разному: или

одной большой буквой, или перечислением его элементов,

данным в фигурных скобках; или указанием (в тех же

фигурных скобках) правила, по которому элемент

относится к множеству. Например, множество М

натуральных чисел от 1 до 100 может быть записано в виде:

М = И, 2, ..., 100) - U- целое; 1<К 100} -

-{f-1, ..., 100}.

Множество точек на числовой оси, расстояние от

которых до точки с абсциссой а не превосходит d, может

быть записано в виде

S = {\z-a\^d) или S = {x: |*.-a| <d),

где х — абсцисса точки.

Множество С точек на плоскости, лежащих внутри

или на границе круга радиуса г с центром в начале

координат, может быть записано в виде

С = {хг + уг<г*) или ? = {(*, у): х2 + у2^г*},

38 ГЛ. 2. АКСИОМАТИКА ТЕОРИИ ВЕРОЯТНОСТЕЙ

где х, у — декартовы координаты точки, или же

С = {р < г},

где р — одна из полярных координат точки.

По числу элементов множества делятся на конечные

и бесконечные. Множество М = {1, 2, ..., 100} конечно

и состоит из 100 элементов. В частности, конечное

множество может состоять из одного элемента.

Множество всех натуральных чисел Nt = {1, 2, ...

..., /г, ...} бесконечно; так же бесконечно и множество

четных чисел: /V2 = {2, 4, ..., 2и, ...}. Бесконечное

множество называется счетным, если все его члены можно

расположить в какой-то последовательности,

перенумеровать (оба множества Л^ и N2 являются счетными).

Вышеупомянутые множества S и С оба бесконечны и

несчетны (их элементы нельзя перенумеровать).

Два множества А и В совпадают (или равны), если

они состоят из одних и тех же элементов. Например,

множество корней уравнения х2 — Ъх + 4 = 0 совпадает с

множеством И, 4), а также с множеством {4, 1).

Совпадение множеств обозначается знаком равенства: А=В.

Запись а^А означает: объект а является элементом

множества А; другими словами, а принадлежит А. Запись

а&А означает: а не принадлежит А.

Пустым множеством называется множество, не

содержащее ни одного элемента; оно обозначается символом 0.

Пример: множество точек плоскости, координаты

которых ху у удовлетворяют неравенству х2 + у2^— 1:

Все пустые множества равны между собой.

Множество В называется подмножеством (частью)

множества Л, если все элементы В содержатся также и

в А; обозначение В^А или А эВ.

Примеры: {1, 2, 3}е{1, 2, 3, ..., 100); {г + 2

1)У + Ч2)

Подмножество может быть равно самому множеству:

{1, 2, 3, 4} = {1, 2, 3, 4}. >

Отношения подмножества и множества можно на*

глядно изображать с помощью геометрической

интерпретации (рис. 2.1.1), где элементами множеств являются

точки на плоскости; каждая точка фигуры В принадле-

2.1. СВЕДЕНИЯ ИЗ ТЕОРИИ МНОЖЕСТВ 39

жит также и фигуре А;

Объединением (суммой) множеств А и В называется

множество С = А + В, состоящее из всех элементов А и

всех элементов В (в том числе и тех, которые

принадлежат и А и В). Короче: объединение двух множеств —это

Рис. 2.1.1

совокупность элементов, принадлежащих хотя бы

одному из них.

Объединение множеств А и В часто обозначают A U Вх.

Так как мы будем обычно называть объединение

событий их суммой, нам удобнее обозначать эту

операцию знаком «+». Очевидно, что если В^4, то А +

А.

Примеры: 1) {1, 2, ..., 100} + {50, 51, ..., 200)

-{1, 2, ..., 200); 2) A, 2, ..., 100) + {1, 2 1000}

~<1, 2, ..., 1000}; 3) {х2 + у2<2) + {х2 + у2<4}{2

+ У2<4).

Геометрическая интерпретация объединения двух

множеств А и В дана на рис. 2.1.2, где А и В —

множества точек, входящих соответственно в фигуры А и 5.

Аналогично объединению двух множеств

определяется объединение (сумма) нескольких мпожеств, а именно

п

Ах + А2+ ... + Лп - 2 Аг

есть множество всех элементов, входящих хотя бы в

одно из множеств Аи А2, ..., Ап- Рассматриваются

также объединения бесконечного (счетного) числа

множеств, например:

A, 2} + {2, 3} + C, 4) + ... + {п - 1, и) + ... -

«{1,2,3,...,/г, ...}.

40 ГЛ 2. АКСИОМАТИКА ТЕОРИИ ВЕРОЯТНОСТЕЙ