Автор: Комарцова Л.Г. Максимов А.В.

Теги: общее машиностроение технология машиностроения кибернетика информатика нейронные сети машинное обучение

ISBN: 5-7038-2554-7

Год: 2004

Текст

Информатика в техническом университете

... Л.Г. Комащова, А.В. Максимов

JJ

* Ф

II I

I

I 'I

I

та) S3 6» С5Э

|ммм| ими! «мяк йммк

'1 I

13.

-■■ЦЦи

ft

Til

«У

if'}

Издательство

МГТУ имени

Н.Э. Баумана

s s s s

15Э 69 6^1 i55

Информатика в техническом университете

Информатика в техническом университете

Серия основана в 2000 году

РЕДАКЦИОННАЯ КОЛЛЕГИЯ:

чл.-кор. РАН КБ. Федоров — главный редактор

д-р техн. наук 77.77. Норенков — зам. главного редактора

д-р техн. наук Ю.М. Смирнов — зам. главного редактора

д-р техн. наук В. В. Девятков

д-р техн. наук В. В. Емельянов

канд. техн. наук 77.77. Иванов

д-р техн. наук В.А. Матвеев

канд. техн. наук Н.В. Медведев

д-р техн. наук В. В. Сюзев

д-р техн. наук Б.Г. Трусов

д-р техн. наук В.М. Черненький

д-р техн. наук В.А. Шахнов

Л.Г. Комарцова, А.В. Максимов

Нейрокомпьютеры

Издание второе, переработанное и дополненное

Допущено Министерством образования

Российской Федерации

в качестве учебного пособия

для студентов высших учебных заведений,

обучающихся по специальности

«Вычислительные машины, комплексы, системы и сети»

направления подготовки дипломированных специалистов

«Информатика и вычислительная техника»

Москва

Издательство МГТУ имени Н.Э. Баумана

2004

УДК 621(075.8)

ББК 32.818

К 63

Рецензенты:

кафедра «Нейрокомпьютеры»

Московского физико-технического института

(зав. кафедрой докт. техн. наук А.И. Галушкин);

профессор Г.А. Полтавец

(Московский авиационный институт)

Комарцова Л.Г., Максимов А.В.

К 63 Нейрокомпьютеры: Учеб. пособие для вузов. - 2-е изд., перераб. и

доп. - М.: Изд-во МГТУ им. Н.Э. Баумана, 2004. - 400 с: ил. -

(Информатика в техническом университете.)

ISBN 5-7038-2554-7

Изложены вопросы современной теории нейрокомпьютеров. Приведен анализ

различных архитектур вычислительных устройств с параллельной организацией работы.

Рассмотрен биологический аналог параллельной организации обработки информации.

Большое внимание уделено разновидностям построения формальных нейронов,

технологии сетей и классическим методам их обучения, методам подготовки задач для решения на

нейрокомпьютерах. Приведены оригинальные результаты применения нейронных сетей

для решения систем дифференциальных уравнений и степенных рядов в

конструировании нейросетевых алгоритмов; обучения нейронных сетей на базе генетического

алгоритма и теории адаптивного резонанса. Представлены программные системы эмуляции

нейронных сетей, разработанных в Калужском филиале МГТУ им. Н.Э. Баумана. Уделено

внимание аппаратной реализации нейрокомпьютеров, в том числе и на отечественной

элементной базе.

Второе издание (1 -е - 2002 г.) переработано и дополнено исследованием новых типов

нейронных сетей, в том числе гибридных, построенных на основе интеграции с нечеткими

системами и генетическими алгоритмами. Добавлен материал, иллюстрирующий

использование нейрокомпьютеров при решении прикладных задач.

Содержание учебного пособия соответствует курсу лекций, которые авторы читают

в Калужском филиале МГТУ им. Н.Э. Баумана.

Для студентов, инженеров, аспирантов и научных сотрудников кибернетических

специальностей.

УДК 621(075.8)

ББК 32.818

© Л.Г. Комарцова, А.В. Максимов, 2002; 2004 с изменениями

ISBN 5-7038-2554-7 О МГТУ им. Н.Э. Баумана, 2002; 2004 с изменениями

ОГЛАВЛЕНИЕ

Предисловие 8

1. Введение в системы с параллельной организацией

вычислительного процесса 10

1.1. Работа вычислительной системы в реальном масштабе времени 10

1.2. Предпосылки создания параллельных ЭВМ 16

1.3. Анализ эффективности параллельных архитектур

вычислительных систем 19

1.4. Биологический аналог параллельной организации обработки

информации 27

1.5. Нейрокомпьютеры и их место среди высокопроизводительных

ЭВМ 30

2. Модели операционного блока нейрокомпьютеров 36

2.1. Обобщенная структурная схема нейрокомпьютера 36

2.2. Модели формальных нейронов 39

2.3. Классификация нейронных сетей 47

2.4. Методика решения задач в нейросетевом базисе 55

3. Конструирование формируемых нейронных сетей 58

3.1. Общие сведения 58

3.2. Синтез нейронной сети для решения нормальной системы

дифференциальных уравнений 59

3.3. Применение степенных рядов при синтезе формируемых

нейронных сетей 73

4. Настройка нейронной сети на решение прикладных задач 83

4.1. Компоненты нейрокомпьютера 83

4.2. Предварительная обработка информации 87

4.3. Интерпретатор ответов сети 91

4.4. Оценка качества работы нейронной сети 93

4.5. Конструирование нейронных сетей 95

4.6. Отбор информативных данных 102

4.7. Обучение нейронной сети 104

4.8. Пример решения задачи классификации на основе нейронной

сети 108

5

Оглавление

5. Обучение нейронных сетей без обратных связей 112

5.1 Эволюция развития персептронных алгоритмов обучения 112

5.2. Обучение многослойной нейронной сети без обратных связей 122

5.3. Анализ стандартных методов оптимизации в процедуре обучения

многослойного персептрона 130

5.4. Пример использования многослойной нейронной сети для решения

задачи выбора архитектуры сервера 136

5.5. Решение задачи прогнозирования временного ряда с помощью

многослойного персептрона 139

6. Обучение нейронных сетей на основе генетического алгоритма... 143

6.1. Суть генетического алгоритма 143

6.2. Формирование популяции 148

6.3. Классификация генетических операторов 149

6.4. Селекция решений 151

6.5. Способы отбора решений в популяцию 152

6.6. Кодирование потенциальных решений 154

6.7. Теорема схем в генетическом алгоритме 158

6.8. Многопопуляционный генетический алгоритм 160

6.9. Исследование ГА для решения задачи обучения НС 162

б.Ю.Управляемый алгоритм обучения нейронной сети на основе

генетического поиска и имитации отжига 168

7. Рекуррентные и ассоциативные нейронные сети 175

7.1. Характеристики ассоциативной памяти 175

7.2. Рекуррентные нейронные сети 177

7.3. СетьХопфилда 178

7.4. Машина Больцмана (вероятностная сеть) 181

7.5. Сеть Хемминга 183

7.6. Ассоциативно-проективные нейронные сети 187

7.7. Нейронная сеть СМАС 195

7.8. Двунаправленная ассоциативная память 199

8. Самоорганизующиеся нейронные сети 203

8.1. СетьКохонена 203

8.2. Сети на основе теории адаптивного резонанса 215

8.3. Сети встречного распространения 224

9. Радиально-базисные и другие модели нейронных сетей 227

9.1. Радиально-базисные нейронные сети 227

9.2. Другие типы нейронных сетей без обратных связей 234

9.3. Перспективы использования НС для создания интеллектуальных

систем 237

6

Оглавление

10. Математические основы построения нечетких систем 239

10.1. Основные положения нечеткой математики 239

10.2. Структура и принципы работы нечеткой системы 251

10.3. Пример использования СНЛ 264

11. Гибридные нейронные сети 267

11.1. Интеграция нейросетевых и нечетких систем 267

11.2. Нейросетевые элементы нечетких систем 268

11.3. Нейросетевая модель нечеткого композиционного вывода 271

11.4. Нечеткие элементы нейросетевых систем 274

11.5. Алгоритм обучения нечеткого персептрона 276

11.6. Нечеткая нейронная сеть Кохонена 279

11.7. Нечеткое управление параметрами обучения нейронных сетей 282

12. Программная эмуляция нейрокомпьютеров 289

12.1.Классификация нейроимитаторов 289

12.2. Программный комплекс Neurolterator 292

12.3. Нейросетевой пакет ЛОКНЭС 311

12.4. Работа двухмерной нейронной сети 324

12.5. Нейропакет Neural Networks IDE 327

12.6. Пакет STATISTICA Neural Networks 343

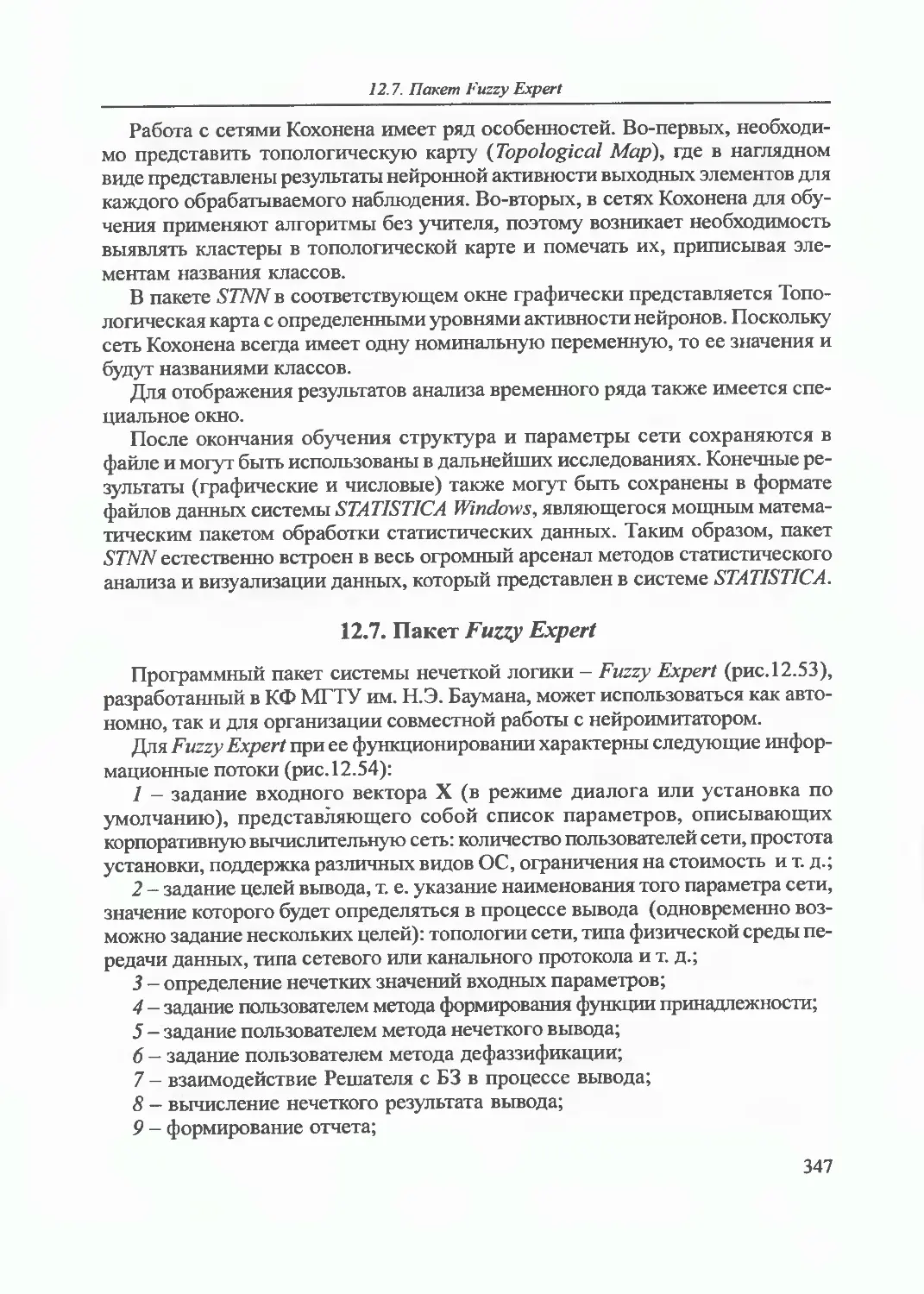

12.7. Пакет Fuzzy Expert 347

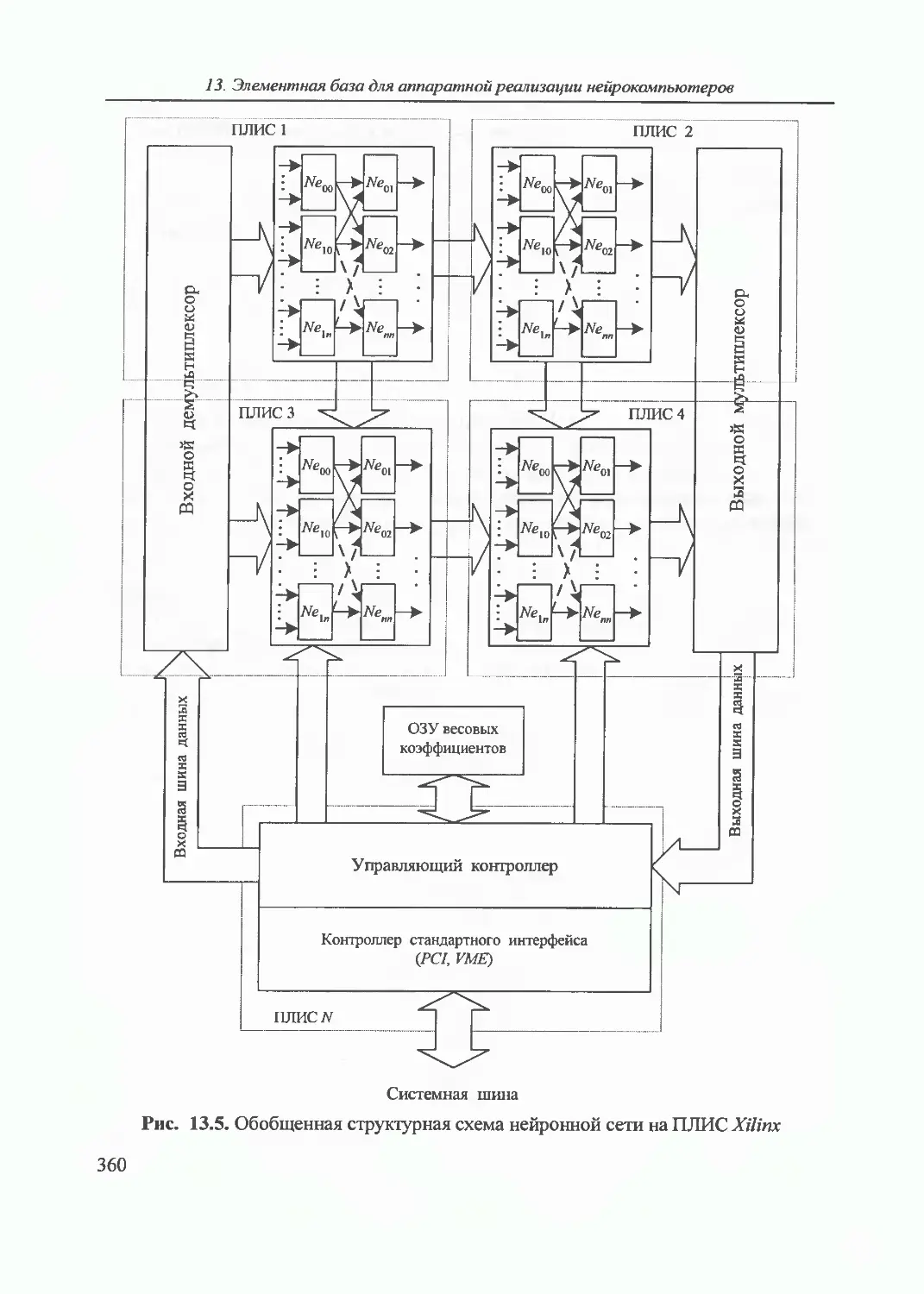

13. Элементная база для аппаратной реализации нейрокомпьютеров... 353

13.1. Общие сведения 353

13.2. Особенности ПЛИС как элементной базы нейрокомпьютеров 354

13.3. Особенности ЦСП как элементной базы нейрокомпьютеров 363

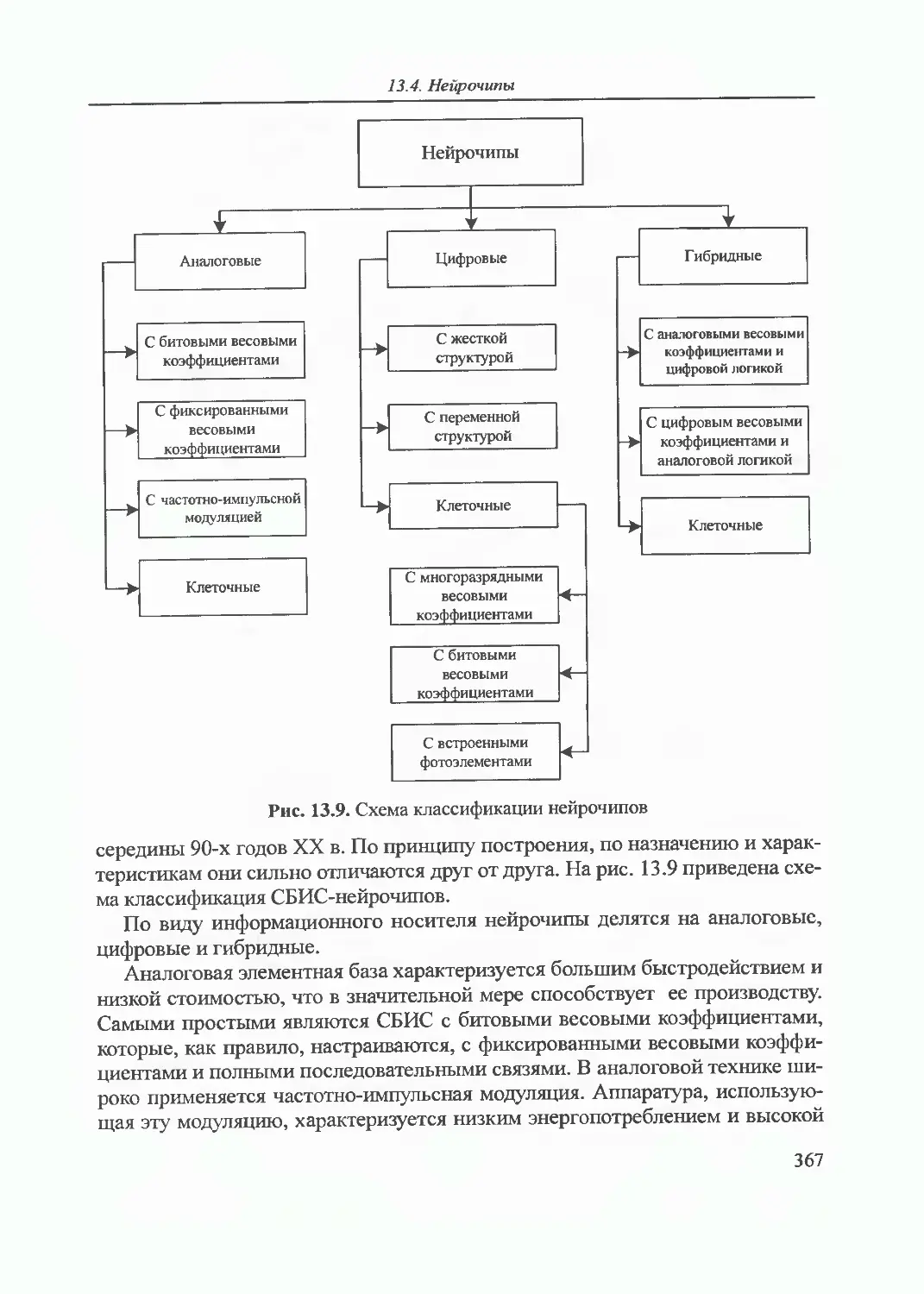

13.4. Нейрочипы 366

Заключение 394

Список литературы 397

Предметный указатель 398

К 175-летию МГТУ имени Н.Э. Баумана

ПРЕДИСЛОВИЕ

В последние годы наблюдается активизация теоретических и практических

разработок в области нейрокомпьютеров. Все больше и больше

разработчиков различных областей обращаются к ним. Это объясняется многими

причинами, которые действуют, как правило, в совокупности.

Во-первых, теория нейровычислителей - ровесница теории машин фон

Неймана. Поэтому для этого научного направления давно определен свой предмет

исследования. За более чем 50-летнюю историю сформировались и

развиваются свои методы исследования.

Во-вторых, теория и практика классических машин фон Неймана начинает

качественное перерождение. Наступает эра параллельных, многопроцессорных

вычислительных устройств.

В-третьих, достижения микроэлектроники стимулируют практическую

реализацию быстродействующих и недорогих вычислительных систем, с успехом

используемых во многих областях деятельности человека.

Поскольку нейрокомпьютеры занимают самостоятельное и весомое место

среди высокопроизводительных вычислительных машин с параллельной

организацией работы, то было бы непростительным не включать нейротематику в

учебные планы подготовки инженеров по кибернетическим направлениям и

специальностям.

Предлагаемое учебное пособие ориентировано на базовую подготовку

студентов по направлению «Информатика и вычислительная техника», а также

других родственных направлений.

Книга состоит из тринадцати глав. В главе 1 рассмотрены особенности

работы ЭВМ как элемента системы управления, приведены предпосылки

создания параллельных ЭВМ, проведен анализ эффективности различных структур

параллельной организации вычислительного процесса, показано место

нейрокомпьютеров среди высокопроизводительных ЭВМ. В главе 2 приведены

обобщенная структурная схема нейрокомпьютера и сравнение ее со схемой

машины фон Неймана. Большое внимание уделено различным топологиям

нейронных сетей. В заключении приводится методика решения задач в нейросете-

вом базисе, предложенная А. И. Галушкиным.

В главе 3 приведены теория и практические результаты проектирования

формируемых нейронных сетей для решения линейных систем

дифференциальных уравнений. Рассмотрен практический пример применения степенных

рядов для конструирования нейронной сети, воспроизводящей полиномы. Глава

4 посвящена решению проблем настройки нейронной сети (НС) на конкретную

решаемую задачу.

8

Предисловие

В главах 5,6,8,9 представлена эволюция развития алгоритмов обучения на

основе многослойного персептрона, рассмотрены проблемы построения,

обучения и использования рекуррентных и ассоциативных НС на примерах сетей

Хопфилда, Хемминга, машины Больцмана, двунаправленной ассоциативной

памяти. Исследуются основные особенности алгоритмов обучения без учителя

для сети Кохонена и сетей адаптивного резонанса, обсуждаются вопросы

построения и использования радиально-базисных, функциональных и других

типов сетей. Показана целесообразность построения комбинированных НС для

повышения качества решения прикладных задач. Для каждой из

рассмотренных видов сетей определены классы задач, которые наиболее эффективно ими

решаются, приведены примеры решения таких задач.

Глава 7 посвящена изложению перспективного эвристического метода

оптимизации в процедуре обучения многослойной НС, основанного на

генетическом алгоритме (ГА). Приведен анализ различных генетических операторов

и схем построения ГА, обеспечивающих минимизацию ошибки обучения НС.

В главах 10 и 11 представлены основные положения теории нечеткой логики

Л. Заде применительно к НС, определены задачи, которые необходимо решать

при построении нечетких систем, и способы их реализации. Исследованы

возможности построения некоторых гибридных нейросетевых нечетких и

нечетких нейросетевых систем, позволяющих повысить эффективность их

использования при решении прикладных задач классификации и распознавания.

В главе 12 рассмотрены программные пакеты нейроимитаторов и нечетких

систем, разработанные на кафедре «Компьютерные системы и сети»

Калужского филиала МГТУ им. Н. Э. Баумана, а в главе 13 - элементная база

аппаратной реализации нейрокомпьютеров. Особое внимание уделено

программируемым логическим схемам фирмы XILINX и сигнальным процессорам, как

наиболее перспективным элементам для построения нейрокомпьютеров.

Авторы стремились изложить материал в доступной для студентов форме и

восполнить пробелы в учебной литературе по данной тематике. Именно

поэтому в книге подробно рассматриваются типы НС, получившие наибольшее

распространение на практике.

Во втором издании книги существенно переработаны главы 9,10, добавлен

новый материал в главы 7,10,11 по проблемам построения на принципах

синергизма гибридных нейро-генетических и нейро-нечетких систем, а также в

главу 13, в которой приведены характеристики элементной базы нейрокомпьютеров.

Главы 4-11 написаны Л.Г. Комарцовой; главы 2,3,13 - А.В. Максимовым;

главы 1 и 12 написаны авторами совместно.

Авторы глубоко признательны рецензентам: кафедре «Нейрокомпьютеры»

Московского физико-технического института (зав. кафедрой докт. техн. наук

А.И. Галушкин) и профессору Г.А. Полтавец (Московский авиационный

институт) за ценные замечания и рекомендации, которые были учтены авторами

при работе. Хочется выразить также благодарность студентам и аспирантам,

пр i i : i участие в написании отдельных па» • и «в:И.В. Винокурову (§12.2),

А.В. Бобкову (§ 12.3 ), В.А. Алексееву (§§ 2.3, 12.4), А.К. Злобину (12.5), а

также А.Ю. Солодовникову (12.7).

Авторы

9

1. ВВЕДЕНИЕ В СИСТЕМЫ

С ПАРАЛЛЕЛЬНОЙ ОРГАНИЗАЦИЕЙ

ВЫЧИСЛИТЕЛЬНОГО ПРОЦЕССА

Обоснована необходимость создания параллельных ЭВМ, приведен анализ

эффективности существующих архитектур вычислительных систем с параллельной

организацией обработки информации. Кратко рассмотрен биологический аналог

параллельных вычислителей, дано определение нейрокомпьютерам, рассмотрена их роль и

место среди высокопроизводительных ЭВМ.

1.1. Работа вычислительной системы в реальном

масштабе времени

Первые ЭВМ появились еще в прошлом веке. За это время сменилось уже

несколько поколений вычислительных машин. Менялись элементная база,

конструктивные решения, языки программирования, программное обеспечение, но

основы архитектуры, заложенные при создании машин первого поколения,

практически без изменения перешли на машины последующих и успешно

работают до настоящего времени. Нет сомнений, что идеи машин первого поколения

еще послужат человеку. Однако все настоятельнее требуются системы,

наделенные элементами интеллекта при обработке колоссального объема

информации и в то же время работающие в темпе управляемых процессов.

Наиболее ярким примером таких систем являются системы автоматического (и/или

автоматизированного) управления техническими объектами с ЦВМ в контуре.

Рассмотрим работу такой системы.

В классической теории управления техническими объектами

рассматривают различные варианты схем систем управления с ЦВМ в контуре. Для

лучшего понимания принципа построения нейрокомпьютеров рассмотрим

несколько отличную от привычных схему, представленную на рис. 1.1.

10

F(0

Задатчик

программного

движения

Y„P(0

<т(0

*..,«

ЦАП

Исполнительные

механизмы

УЦВМ

U(0

*»««)

Объект

управления

АЦП

Датчики

Х(0

}

Рис. 1.1. Система управления с ЦВМ в контуре:

Х(/)-вектор состояния объекта; Х^С*)- вектор измеряемых параметров состояния объекта;

Yiiri(/) - вектор вычисленных параметров; Y (/) - вектор программного входного воздействия;

<У(/)- сигнал ошибки; U(/)-управляющее воздействие; F(/)-возмущение

1. Введение в системы с параллельной организацией вычислительного процесса

Система, приведенная на рис. 1.1, работает следующим образом. Под

действием управления U(t) объект движется по программной траектории. Однако

случайные, неуправляемые возмущения ¥(t) отклоняют его движение от

заданного. Отдельные компоненты вектора состояния объекта Хюм(?)

измеряются датчиками, затем квантуются по амплитуде и по времени

аналого-цифровыми преобразователями (АЦП) и передаются в управляющую ЦВМ

(УЦВМ). Последняя, преобразовав измеренную входную информацию по

заданному алгоритму, подает на узел сравнения вектор вычисленного

воздействия Y ыч(0> соответствующий состоянию объекта на момент измерения. Узел

сравнения вырабатывает сигнал ошибки a(t) и передает его исполнительным

механизмам. Сформированное исполнительными механизмами управление U(t),

воздействуя на объект, возвращает его на программную траекторию.

Очевидно, что ЦВМ, включенная в контур рассмотренной системы

управления, должна удовлетворять следующим требованиям:

• осуществлять возложенные на нее вычисления с точностью,

позволяющей системе нормально выполнять свои функции;

• проводить обработку входной информации в темпе работы системы.

Иначе говоря, управляющая ЦВМ должна вьщавать результаты с требуемой

точностью и работать в реальном масштабе времени.

Современный уровень развития элементной базы вычислительной техники

позволяет выполнять задатчик программного движения и узел сравнения в виде

программных модулей, размещаемых в памяти той же УЦВМ, что и основной

алгоритм обработки входной информации. В этом случае УЦВМ будет

вырабатывать непосредственно сигнал ошибки и, очевидно, будет иметь большую

вычислительную нагрузку. На рис. 1.2 представлена система управления с

расширенными функциями УЦВМ.

Практическим примером систем, представленных на рис. 1.1 и 1.2,

является бесплатформенная инерциалъная система ориентации, структурная

схема которой показана на рис. 1.3. Работа системы заключается в

следующем. Под действием маршевых двигателей подвижный объект движется в

пространстве в общем случае по произвольной пространственной траектории.

Изменение направления движения объекта в пространстве определяется

положением его рулей, которые приводятся в действие рулевым приводом. Рулевой

привод на схеме 1.3 является исполнительным механизмом на рис. 1.1, 1.2.

Изменение положения рулей изменяет ориентацию объекта, что в свою

очередь приводит к изменению его пространственной траектории движения. В

качестве датчиков текущего состояния объекта в рассматриваемой системе

используют лазерные датчики угловых скоростей (ЛДУС). Это объясняется

тем, что в настоящее время нет простых и сравнительно недорогих датчиков

углового положения подвижных объектов, которые измеряли бы углы в диапа-

12

Модуль программного

движения

Модуль вычисления

рассогласования

(ошибки)

УЦВМ

Модуль реализации

основного алгоритма

-К

ЦАП

а(0

-►^Исполнительные

механизмы

и(0

F(0

хюм(0

АЦП

■<.>•

Объект

управления

х(0

3

Датчики {

Рис. 1.2. Система управления с расширенными функциями УЦВМ

Программные

значения

угловых скоростей

w

Блок

интегрирования

кинематических

уравнений

i

УЦВМ

к

Рулевой

привод

Объект

управления

Лазерный датчик

угловых скоростей

(ЛДУС)

Параметры

ориентации

Рис. 1.3. Структурная схема бесплатформенной инерциальной системы ориентации

1. Введение в системы с параллельной организацией вычислительного процесса

зоне ±360°в трех плоскостях. Поэтому для подвижных объектов, имеющих

произвольную пространственную эволюцию, применяют датчики угловых

скоростей с последующим интегрированием кинематических уравнений.

Естественно, что это интегрирование ложится на УЦВМ. Наименьших затрат при

интегрировании кинематических уравнений можно достичь, если в качестве

параметров ориентации применять так называемые параметры Родрига-

Гамильтона, называемые еще кватернионами. Матричное

кинематическое уравнение в кватернионах имеет вид

А= 0,5(0-0^,

где Л = (Я,0, A,j, Х2, Я,3)т - вектор параметров ориентации (составляющие

кватерниона); Q, Q - матрицы, составленные из текущих и программных

значений проекций вектора угловой скорости объекта на связанную с ним систему

прямоугольных координат со,, со , со_. Обе матрицы имеют одинаковый вид

О -со, -со, -сог

Q= со, 0 со, -со,

СО, -СО, О СО,

сог со, -со, О

Значительное повышение качества работы системы дает ее

интеллектуализация. Систему управления можно назвать интеллектуальной, если она

способна на основе заложенных в ней знаний и полученных извне сведений

сформулировать программу движения объекта и найти способ оптимальной

реализации этой программы. На рис. 1.4 приведена схема системы

управления, обладающая элементами интеллекта.

Вычислительная часть этой системы имеет три пополняемых в ходе

эксплуатации базы данных: состояния среды (БД ССр); алгоритмов управления (БД

АУ); состояния объекта (БД СОб). Анализируя ситуацию, в которой находится

объект управления, при этом учитывая динамику изменения состояния

окружающей среды, формирователь управляющих воздействий (ФУВ)

корректирует программу движения объекта (МКПД) и вырабатывает команды на

изменение структуры исполнительных механизмов (МКСИМ) с тем расчетом, чтобы

объект достиг цели оптимальным способом. Критерии оптимальности зависят

от конкретного исполнения и назначения системы.

Очевидно, что выполнить такой огромный объем вычислительных работ

машина с последовательной архитектурой не в состоянии. Выход можно найти

лишь в применении параллельных принципов организации обработки

информации.

14

Q,

пр

-СО

хпр

СО

хпр

-СО

СО

.упр

■со

znp

хпр

-СО

.упр

СО

.упр

СО

хпр

СО

znp

СО

.упр

О

■со

со

хпр

хпр

г

БД ССр

БД АУ

ЬД

ч

w

МОССр

V

ФУВ

J

к

МКСИМ

МКПД

АЦП

ЦАП

ЦАП

АЦП

ДССр

1

г

ИМ

11

F(f)

г

Объект

управления

^

ДСОб

X®

W

пр ■■■ • | • щая вычислительная система

Рис. 1.4. Система управления с элементами интеллекта:

БД ССр - база данных состояния среды; МОССр - модуль оценки состояния среды; ДССр - датчики состояния среды;

БД АУ - база данных алгоритмов управления; ФУВ - формирователь управляющих воздействий;

ЦАП - цифроаналоговые преобразователи; МКСИМ - модуль коррекции структуры исполнительных механизмов;

МКПД - модуль коррекции программного движения; БД СОб - база данных состояния объекта; МОСОб - модуль оценки

состояния объекта; ДСОб - датчики состояния объекта; АЦП - аналого-цифровые преобразователи;

ИМ - исполнительные механизмы

1. Введение в системы с параллельной организацией вычислительного процесса

1.2. Предпосылки создания параллельных ЭВМ

В таких прикладных областях деятельности человека, как космология,

молекулярная биология, гидрология, охрана окружающей среды, медицина,

экономика и многих других, сформулированы проблемы, решение которых

потребует вычислительных машин, обладающих колоссальными ресурсами. Например:

быстродействие, TFLOPS 0,2... 200

оперативная память, Гбайт 100... 200

дисковая память, Тбайт 1 ...2

пропускная способность

устройств ввода-вывода, Гбайт/с 0,2... 0,5

На сегодняшний день нижняя граница указанных технических

характеристик реализуется только с помощью дорогостоящих уникальных архитектур от

CRAY, SGI, Fujitsu, Hitachi с несколькими тысячами процессоров. Чтобы

достичь верхней границы этих характеристик, необходимы интенсивные

исследования в области разработки новой элементной базы и новых архитектур

вычислительных систем (ВС).

В настоящее время концептуально разработаны методы достижения

высокого быстродействия, которые охватывают все уровни проектирования ВС. На

самом нижнем уровне - это передовая технология конструирования и

изготовления быстродействующей элементной базы и плат с высокой плотностью

монтажа. Это наиболее простой и прямой путь к увеличению

производительности ЭВМ. Так, например, если бы удалось все задержки при распространении

сигналов в ЭВМ сократить в к раз, то это привело бы к увеличению

быстродействия в такое же число раз. В последние годы достигнуты огромные

успехи в создании быстродействующей микропроцессорной элементной базы и

адекватных методов монтажа. В соответствии с законом Гордона Мура количество

транзисторов на кристалле удваивается каж-

N дые 18 месяцев (рис. 1.5), производительность

микропроцессора также увеличивается вдвое.

К 2006 г. на одной плате предполагается раз-

106 ^^г мещать 350 млн транзисторов (для сравнения

кристалл микропроцессора Pentium Pro

содержит 5,5 млн транзисторов).

Дальнейшая эволюция микропроцессоров,

по всей видимости, будет проходить по следу-

ю'

ю4

ю2

-I 1-

1970 1980 1990 2000 Гпп1Л

i оды ющим направлениям:

Рис. 1.5. Иллюстрация закона • уменьшение ширинь! проводника с 0,3 5 мкм

Мура- до 0,18 мкм (1/500 человеческого волоса);

N -число транзисторов на кристалле • уменьшение потребляемого напряжения;

16

1.2. Предпосылки создания параллельных ЭВМ

• увеличение металлических слоев (Pentium Pro содержит 5 слоев,

предполагается 8 слоев);

• усложнение архитектуры микропроцессора.

' К 2011 г. предполагается выпустить микропроцессор под условным

названием «Micro-2011» со следующими характеристиками: 1 млрд транзисторов на

кристалле; тактовая частота 10 Ггц; производительность 2,5 тыс. MFLOPS

(1MFLOPS = 106 операций с плавающей точкой в 1 с). Таким образом, основ-

i ная тенденция в развитии современной элементной базы направлена на

повышение степени интеграции так, чтобы на одной плате можно было реализовать

суперЭВМ. Это требует развития новых прогрессивных технологий (оптоэлект-

ронной технологии, нанотехнологии) и материалов (например, арсенид гал-

, лия - GaAs).

Теоретически совершенствование элементной базы — самый простой

метод повышения производительности вычислительных систем. Однако на

практике он приводит к существенному удорожанию новых разработок. Поэтому

наиболее приемлемым путем к созданию высокопроизводительных ЭВМ,

оцениваемых по критерию «производительность/стоимость», может быть путь

исследования и разработки новых методов логической организации систем, а

также новых принципов организации вычислений. Основной способ повышения

производительности с этой точки зрения - использование параллелизма.

' Параллельной называется такая обработка на ЭВМ, которая

предусматривает одновременное выполнение программ или их отдельных частей на

независимых устройствах.

Известны следующие базовые способы введения параллелизма в архитек-

\ туру ЭВМ:

• конвейерная обработка - применение методов конвейерной сборки для

повышения производительности арифметико-логического и управляющего

устройства;

' • функциональная обработка - предоставление нескольким независимым

устройствам возможности параллельного выполнения различных функций,

таких, как операции логики, сложения, умножения, приращения и т. д., и

обеспечение взаимодействия с различными данными;

i • матричная обработка - производится большим числом идентичных

процессорных элементов (ПЭ) с общей системой управления и организованных в

! виде матриц, при этом все ПЭ выполняют одну и ту же операцию, но с

различными данными, хранящимися в локальной памяти каждого процессора, т. е.

I жестко связанные пошаговые операции;

• мультипроцессорная обработка - осуществляется несколькими

процессорами, каждый из которых имеет свои команды; взаимодействие процессоров

осуществляется через общее поле памяти.

г

17

1. Введение в системы с параллельной организацией вычислительного процесса

Естественно, что в отдельных проектах могут объединяться некоторые или

все эти способы параллельной обработки. Например, процессорная матрица в

качестве ПЭ может иметь конвейерные арифметические усгройства или одно

функциональное устройство в компьютере, содержащем множество таких

устройств.

На основе сопоставления структуры ЭВМ фон Неймана и

многопроцессорной системы были сформулированы критерии оценки производительности:

закон Гроша и гипотеза Минского.

Закон Гроша гласит, что производительность одного процессора

увеличивается пропорционально квадрату его стоимости (см. рис. 1.6, а). Следуя

этому закону, многопроцессорные системы строить нецелесообразно. Так, для

двукратного увеличения производительности в двухпроцессорной системе

требуется четырехкратное увеличение стоимости. По этой причине применение

многопроцессорных систем долгое время ограничивалось сферой военных

приложений, где необходима очень высокая надежность. В пределе закон Гроша

не может быть справедлив, поскольку конечность скорости распространения

электронов в проводнике ограничивает возможность увеличения

производительности. Поэтому на практике в верхней области графика зависимость имеет

совершенно иной вид (рис. 1.6, б ). В соответствии с практикой можно

расходовать все больше средств, не получая при этом скорости вычислений,

предсказываемой законом Гроша.

Гипотеза Минского утверждает, что в параллельной системе с и

процессорами производительность каждого из которых равна единице, общая

производительность растет лишь как log2 n (рис. 1.7) из-за необходимости обмена

данными. Вычислительные системы 60 - 70-х годов прошлого века, которые

имели по два, три, четыре процессора, как бы подтверждали эту гипотезу.

Однако загруженность п процессоров может быть гораздо выше logj и.

Производительность

Стоимость одного процессора

Производительность

▲

Область

ВЫПОЛН1

закона

Грош;

Стоимость одного процессора

Рис. 1.6. Графики закона Гроша:

а - теоретический; б- практический

18

1.3. Анализ эффективности параллельных архитектур вычислительных систем

В более совершенных

многопроцессорных системах за счет введения

соответствующих механизмов управления, например

мультипрограммирования, можно

значительно повысить коэффициент использования

процессоров, что и было реализовано в

вычислительных системах 80 и 90-х годов.

Гипотеза Минского является чересчур

пессимистичной. Линейного роста

производительности, т. е. при увеличении числа

процессоров в Р раз производительность также

увеличивается в Р раз, можно достичь

только в истинной параллельной системе при

полной загрузке процессоров.

max

6 Число

процессоров

Рис. 1.7. График, иллюстрирующий

гипотезу Минского:

Р— производительность

1.3. Анализ эффективности параллельных архитектур

вычислительных систем

Эффективность использования различных способов организации ВС

напрямую зависит от структур реализуемых алгоритмов. Алгоритмические

структуры отличаются друг от друга содержанием вычислительных процедур и

отношением их следования при выполнении программ. Вычислительная процедура,

в свою очередь, может состоять из других вычислительных процедур. В

контексте организации параллелизма это приводит к понятию детализации

параллелизма. Детализацию называют мелкой {мелкозернистой), если

вычислительные процедуры являются примитивными (т. е. реализуются одной

командой), и крупной {крупнозернистой), если эти процедуры являются

сложными (т. е. состоят из других процедур). Спектр значений уровня детализации

простирается от очень мелкого (на уровне совмещения отдельных фаз

выполнения команд) до очень крупного (на уровне выполнения независимых программ).

В современных ВС может также использоваться и комбинированная

детализация.

Сравним возможности различных видов алгоритмических структур для

организации высокоскоростных вычислений (рис. 1.8).

Важное преимущество последовательного подхода, реализующего

архитектуру ОКОД - одиночный поток команд и одиночный поток данных по

классификации Флинна, состоит в том, что для машин такого вида разработано

большое число алгоритмов и пакетов прикладных программ, созданы обширные

базы данных, накоплен богатый опыт программирования, разработаны

фундаментальные языки и технологии программирования. Поэтому дальнейшее

совершенствование организации ЭВМ (мэйнфреймов и микропроцессоров) шло

19

1. Введение в системы с параллельной организацией вычислительного процесса

Рис. 1.8. Виды алгоритмических структур:

а — последовательная; б- последовательно-групповая;

в — слабо связанные потоки; г - параллельная структура общего вида

таким образом, что последовательная структура сохранялась, а к ней

добавлялись механизмы, позволяющие выполнять несколько команд одновременно.

До последнего времени параллельная обработка на уровне команд

(instruction -level-parallelism - ILP) утвердилась как единственный подход,

позволяющий добиваться высокой производительности без изменения программного

обеспечения.

В последовательно-групповой алгоритмической структуре вычислительные

процедуры объединены в группы, а отношение следования состоит в том, что

процедуры внутри группы могут выполняться одновременно, а сами группы -

последовательно. Вычислительные процедуры внутри одной группы могут быть

одинаковыми или разными. Наиболее типичным является случай, когда

одинаковые вычислительные процедуры образуют одиночный поток команд и

множественный поток данных (ОКМД). Примерами групп, составленных из

идентичных операций, могут служить векторные команды.

Для выполнения программ, алгоритмическая структура которых относится

к классу ОКМД, применяют два типа вычислительных систем: векторные

(Parallel Vector Processor — PVP) и матричные (Massively Parallel Processor -

MPP). В системах PVP вычислительные процедуры внутри групп исполняют-

20

1.3. Анализ эффективности параллельных архитектур вычислительных систем

ся конвейерным процессором, в то время как в МРР используются несколько

одновременно работающих процессоров (процессорные матрицы).

К типу МРР относятся следующие практически реализованные суперЭВМ:

ILLIAC-TV (Иллинойский университет, США), DAP (ICL), BSP {Burroughs),

STARAN {Goodyear Aerospace), СУММА, МИНИМАКС, ПС-3000 (СССР).

Основные проблемы реализации матричных систем - программирование

параллельной работы нескольких сотен процессоров и при этом обеспечение

минимума затрат счетного времени на обмен данными между ними. Развитие

суперЭВМ с матричной архитектурой дало следующие положительные результаты:

• удалось доказать возможность практической реализации параллельной

сверхскоростной обработки (производительность ILLIAC-TV в 1972 г.

составляла 20 MFLOPS, а даже самая скоростная ЭВМ для научных исследований

того времени последовательная CDC-7600 могла обеспечить не более

5 MFLOPS);

• на волне интереса к матричным структурам была разработана

теоретическая база для построения коммутационных сетей, объединяющих

множество процессов;

• в прикладной математике сформировалось самостоятельное научное

направление, связанное с параллельными вычислениями.

Более простая и «прозрачная» архитектура векторной обработки PVP с

возможностью использования стандартных языков высокого уровня типа FORTRAN

была реализована в первой векторно-конвейерной суперЭВМ STAR-100 (конец

60-х годов, производительность 50 MFLOPS), созданной под руководством С.

Крея. Существенной особенностью векторно-конвейерной архитектуры

является то, что данные всех параллельно исполняемых операций выбираются

и записываются в единую память, в связи с этим отпадает необходимость в

коммутаторе процессорных элементов, ставших камнем преткновения при

проектировании матричных суперЭВМ.

Итоги развития суперЭВМ на основе PVP первого поколения

американских - CYBER-205 {CDC), CRAY-l, CRAYX-MP{Cray Research) и японских -

£-810 {Hitachi), FACOM VP-200 {Fujitsu), SX{Nippon Electric - NEC) со

средней производительностью 1-2 GFLOPS и следующих поколений: CRAY-2, CRAY

Y-MP, SR-2201, VPP-500, SX-4 (свыше 400 MFLOPS) показали перспективность

их использования для соответствующего класса задач. Однако эти модели

являются дорогостоящими {CRAYX-MP - 20 млн долл.).

Следующий путь ускорения вычислений за счет параллельного выполнения

операций - это использование алгоритмов, структура которых представляет

совокупность слабо связанных потоков команд (последовательных процессов).

В этом случае программа может быть представлена как совокупность

процессов, каждый из которых может выполняться на отдельном последовательном

процессоре и при необходимости осуществлять взаимодействие с другими

процессорами. Вычислительные системы, отвечающие особенностям данной ал-

21

1. Введение в системы с параллельной организацией вычислительного процесса

горитмической структуры, - это многопроцессорные системы архитектуры

МКМД (множественный поток команд и множественный поток данных),

особенностью которых является необходимость синхронизации и взаимосвязи

между процессами. По этому принципу все архитектуры МКМД делятся на

два класса: взаимодействующие через общую память (класс а) и путем

обмена сообщениями (класс б). На рис. 1.9 показаны оба класса архитектур.

В архитектуре класса а память является общей для всех процессоров. Это

означает, что здесь существуют задержки в коммутационном устройстве, а

также доступе в память. Таким образом, в подобных системах требуется, чтобы

коммутационное устройство имело высокое быстродействие, а при доступе в

память количество конфликтов было минимальным. Примеры практической

реализации такой архитектуры: ЕТА-10 (CDC), Эльбрус-1, Эльбрус-2 (ИТМ и ВТ).

Класс архитектуры б предназначен для систем с большим числом

процессоров. Именно поэтому матричный коммутатор так же, как и коммутационная

сеть, оказываются малопригодными из-за высокой стоимости и

недостаточного числа входов. Наиболее перспективным классом коммутационных

устройств являются многоступенчатые сети (рис. 1.10) и гиперкубы. К классу б

относятся экспериментальные системы Cosmic Cube (Калифорнийский

технологический институт), Cm*, Ultracomputer (Нью-Йоркский университет).

В последнее время все более широкое распространение получают

транспьютеры, из которых строят системы класса б. Транспьютер является одно-

кристалльной системой, содержащей процессор и оперативную память.

Для объединения транспьютеров в систему используют механизмы связи (лин-

Коммутационная сеть

j

у

ПЭ

i

у

к

лп

i

у

к

ПЭ

J

У

к

ЛП

1

у

к

>

ПЭ

J

У

к

лп

Коммутационная

сеть

t

У

к

ПЭ

у

к

ПЭ

а б

Рис. 1.9. Архитектура МКМД:

а - с общей памятью; б - с обменом сообщениями;

ПЭ - процессорный элемент; ЛП-локальная память

22

1.3. Анализ эффективности параллельных архитектур вычислительных систем

Глобальная коммутационная сеть

>к

Локальная коммутационная

сеть

j

ПЭ

...

К]

1

к

ПЭ

настер ]

...

1'

ПЭ

...

ik

Локальная коммутационная

сеть

"" >к

ПЭ

...

ik

ПЭ

Кластер j

...

N

>к

ПЭ

Рис. 1.10. Архитектура ВС с двухуровневой коммутационной сетью:

ПЭ - процессорный элемент

ки) - встроенные специальные средства обмена сообщениями. Поскольку лин-

ки различных транспьютеров совместимы, то через коммутационную матрицу

можно конфигурировать системы различной мощности.

Максимальный коэффициент ускорения вычислений, который можно

получить в МКМД, состоящей из Р процессоров, равен Р (линейный рост

производительности). Однако действие отрицательных факторов снижает реальный

коэффициент ускорения. К этим факторам относятся:

• недостаточный параллелизм алгоритма, приводящий к неполной загрузке

процессоров (известно не так много алгоритмов, в которых при их вьшолнении

число параллельных ветвей сохранялось бы достаточно большим; поэтому для

эффективного использования ресурсов в таких системах целесообразно

одновременно выполнять несколько разных программ);

• конфликты и задержки при обращениях к памяти (в случае общей памяти).

Этот отрицательный фактор можно устранить путем назначения каждому

процессору локальной памяти. Однако при этом коэффициент использования

памяти и гибкость ВС снижаются;

• большие накладные расходы, связанные с механизмом синхронизации

между взаимодействующими потоками команд.

В последние 10-15 лет высокопроизводительные ВС (суперкомпьютеры),

являясь уникальными установками, строятся путем объединения

крупносерийных микропроцессоров широкого применения. Намечено создание

многопроцессорных СБИС и выход на уровень производительности квадриллион оп/с

(PFLOPS) - проект суперкомпьютера Blue Gene фирмы ЮМ (срок окончания

работ 2005-2013 гг.).

23

1. Введение в системы с параллельной организацией вычислительного процесса

По современным представлениям объединяющей основой

функционирования и поэтапного развития суперкомпьютерных систем являются концепции и

стандарты открытых систем, в которых реализуются свойства

масштабируемости, портабельности и т. д. Использование с этих позиций компьютерных

функциональных модулей массового промышленного применения открывает

возможности системной интеграции с высокими технико-экономическими

показателями в сжатые сроки. Такой подход в мировой практике за последние

2-3 года (данные на конец 2003 г.) выражен в развитии кластерных

вычислительных систем (рис. 1.10), которые занимают в настоящее время

доминирующее положение на рынке суперкомпьютеров и составляют четверть списка

ТОР500 - наиболее высокопроизводительных систем в мире.

На основе кластерных принципов построения высокопроизводительных

систем с учетом опыта создания транспьютерных систем в России в 2001 г.

введена в действие отечественная 768-процессорная система МВС-1000 М

производительностью 1 TFLOPS. Освоен выпуск установок типа МВС на базе

быстродействующих микропроцессоров Pentium-IV, Xeon, Itanium (фирмы Intel),

Power (фирмы ЮМ), Opteron (фирмы AMD). Межпроцессорный обмен в

системах МВС-1000 М осуществляется с применением мощных коммутаторов

высокоскоростных сетей Myrinet и Gigabit Ethernet.

Дальнейшее развитие архитектур МКМД связывается с комбинированием

различных принципов вычислений. Наиболее эффективным является

объединение архитектур МКМД и PVP. К таким системам относится, например,

вычислительный комплекс IBM-ICAP/3090. Этот комплекс объединяет в

различных сочетаниях мультипроцессорные комплексы, например, IBM-3090, с

векторными процессорами в единую систему. Другим примером является

архитектура НЕР-\ (Heterogenerous Element Processor) фирмы Denelcor.

Особенностью HEP-1 является организация мультипроцессора как нелинейной

системы, состоящей из группы процессоров команд, каждый из которых генерирует

«свой» процесс (поток команд). Обработка множества формируемых таким

образом процессов осуществляется на одном и том же арифметическом

устройстве конвейерного типа в режиме разделения времени (МКМД-конвейери-

зация) без использования коммутационной сети, что значительно снижает

стоимость системы, поскольку на реализацию АЛУ обычно приходится до 60 %

аппаратных ресурсов центрального процессора.

Основным недостатком МКМД-архитектур является отсутствие

возможности составления программ на стандартных языках последовательного типа,

в отличие от векторных суперЭВМ. Для эффективного программирования

таких систем потребовалось введение совершенно новых языков параллельного

24

1.3. Анализ эффективности параллельных архитектур вычислительных систем

программирования, таких, как Parallel Pascal, Modula-2, Occam, Ада, Val, Sisal

и создание новых прикладных пакетов программ.

В России одной из первых вычислительных систем с элементами

неоднородной архитектуры была система обработки данных АС-6. В ее состав

входила ЭВМ БЭСМ-6, ЦП АС-6 и периферийная машина ПМ-6, на которой был

решен ряд важных научных задач фундаментального плана.

Реализация алгоритмической структуры сильно связанных потоков (см.

рис.1. 8, г) требует организации такой архитектуры ЭВМ, которая

обеспечивала бы наибольшие возможности для параллельных вычислений. Принцип

вычислений, использующийся в такого рода системах, отличается от фон

Неймановского (управление потоком команд) и определяется как управление

потоком данных (Data Flow). Этот принцип формулируется следующим

образом: все команды выполняются только при наличии всех операндов

(данных), необходимых для их выполнения. Поэтому в программах, используемых

для потоковой обработки, описывается не поток команд, а поток данных.

Отметим следующие особенности управления потоком данных, характерные для

Data Flow:

• команду со всеми операндами (с доставленными операндами) можно

выполнять независимо от состояния других команд, т. е. появляется возможность

одновременного выполнения множества команд (первый уровень

параллелизма);

• отсутствует понятие адреса памяти, так как обмен данными происходит

непосредственно между командами;

• обмен данными между командами четко определен, поэтому отношение

зависимости между ними обнаруживается легко (функциональная обработка);

• поскольку управление командами осуществляется посредством передачи

данных между ними, то нет необходимости в управлении

последовательностью выполнения программы, т. е. имеет место не централизованная, а

распределенная обработка.

Таким образом, параллелизм в таких системах может быть реализован на

двух уровнях:

• на уровне команд, одновременно готовых к выполнению и доступных для

параллельной обработки многими процессорами (при наличии

соответствующих операндов);

• на уровне транспортировки команд и результатов их выполнения через

тракты передачи информации (реализуемые в виде сетей).

Достоинством машин потоков данных является высокая степень

однородности логической структуры и трактов передачи информации, что

позволяет легко наращивать вычислительную мощность.

25

1. Введение в системы с параллельной организацией вычислительного процесса

Примерами реализации архитектур такого типа являются системы Thinking

Machines (Connection Machine), Cedar (Cedar). Для архитектуры Data Flow

существует ряд факторов, снижающих максимальную производительность:

• в случае, когда число команд, готовых к выполнению, меньше числа

процессоров, имеет место недогрузка обрабатывающих элементов;

• перегрузка в сетях передачи информации; из соображений стоимости

максимальная пропускная способность сетей достигается только для

ограниченного числа вариантов взаимодействия между командами, что приводит к

временным задержкам.

Существенный недостаток Data Flow-машая заключается в том, что

достижение сверхвысокой производительности целиком возлагается на

компилятор, осуществляющий распараллеливание вычислительного процесса, и

операционную систему, координирующую функционирование процессоров и трактов

передачи информации. В связи с этим, как и в случае с МКМД, необходима

разработка соответствующих языков программирования высокого уровня и

подготовка пакетов приложений для решения реальных задач.

Несмотря на некоторые отрицательные черты архитектуры Data Flow, она

является очень перспективной в смысле достижения высокой

производительности, поскольку в ней устраняются основные недостатки, свойственные

архитектуре фон Неймана. В последнее время, благодаря успехам

микроэлектроники, в частности - создание однокристальной ассоциативной памяти для

хранения готовых к выполнению команд, стало возможным построение на

одном чипе сверхвысокопроизводительного процессора, работающего по

принципу управления потоком данных типа Data Flow (подобные разработки ведутся

в институте проблем информатики РАН).

Таким образом, ни один из рассмотренных принципов организации

вычислительных систем не является абсолютно адекватным для всех прикладных

областей. Более того, существуют задачи, которые являются неформализуемы-

ми и которые нельзя представить в виде рассмотренных классических

алгоритмических структур. К ним относятся: различные аспекты синтеза и

распознавания речи; распознавание символов; задачи классификации

объектов; субъективные процессы принятия решений (техническая и медицинская

диагностика, прогнозирование на финансовом рынке); проектирование

сложных объектов; сложные проблемы управления, требующие идентификации и

выработки решения для систем в реальном времени; создание адекватных

систем биологического зрения; моделирование функций понимания,

восприятия и др. Следовательно, требуется разработка новых принципов вычислений,

позволяющих ставить и решать задачи подобного типа, а также способных

значительно повысить скорость обработки традиционных вычислительных

алгоритмов.

26

1.4. Биологический аналог параллельной организации обработки информации

1.4. Биологический аналог параллельной

организации обработки информации

Основатель кибернетики Норберт Винер назвал свой главный труд

«Кибернетика или управление и связь в животном и машине». Этим названием он

подчеркнул, что законы управления являются общими для живой и неживой

природы, тем самым предопределил фундаментальность кибернетики.

Рассмотрим в общем виде функции сенсорных систем человека с точки зрения

кибернетики.

Информацию об окружающем мире и о внутренней среде организма

человек получает с помощью сенсорных систем, названных Павловым

анализаторами. С точки зрения современной нейрофизиологии под сенсорными

системами понимаются специализированные части нервной системы, состоящей из

периферических рецепторов (органов чувств), отходящих от них нервных

волокон (проводящие пути) и клеток центральной нервной системы,

сгруппированных вместе в так называемые сенсорные центры.

В сенсорных органах происходит преобразование энергии стимула в нервный

сигнал (рецепторный потенциал), который трансформируется в импульсную

активность нервных клеток (потенциалы действия). По проводящим путям эти

потенциалы достигают сенсорных центров, на клетках которых происходит

переключение нервных волокон и преобразование нервного сигнала

(перекодировка). На всех уровнях сенсорной системы одновременно с кодированием и

анализом стимулов осуществляется декодирование сигналов (считывание

сенсорного кода). Декодирование осуществляется на основе связей сенсорных

центров с двигательными и ассоциативными отделами мозга. Нервные

импульсы клеток двигательных систем вызывают возбуждение или торможение.

Результатом этих процессов является движение или остановка (действие и

бездействие). Следует подчеркнуть, что природа носителя информации в

сенсорных системах является электрической. Таким образом, основными

функциями сенсорных систем являются: рецепция сигнала; преобразование рецептор-

ного потенциала в импульсную активность проводящих путей; передача

первичной активности в сенсорные центры; преобразование первичной

активности в сенсорных центрах; анализ свойств сигналов; идентификация свойств

сигналов; принятие решения [8].

Нетрудно заметить, что приведенное описание восприятия человеком

влияния внешней среды есть описание работы системы управления с ЦВМ в

контуре по рис. 1.1 в терминах физиологии. Роль датчиков системы управления

играют рецепторы, роль управляющей ЦВМ - головной мозг человека, роль

исполнительных механизмов — двигательная система человека (его мышцы),

роль задатчика программного движения - головной мозг.

Очевидно, центральным звеном в биологических системах управления

является мозг, состоящий из более 100 млрд нервных клеток - нейронов, каждая

из которых имеет в среднем 10000 связей.

27

1. Введение в системы с параллельной организацией вычислительного процесса

Дендриты Нейрон имеет тело (сому), дерево

входов - дендритов, и выход - аксон

(рис. 1.11). Длина дендритов может

достигать 1 мм, длина аксона - сотен

миллиметров. На соме и дендритах

располагаются окончания других

нервных клеток. Каждое такое

окончание называется синапсом. Проходя

через синапс, электрический сигнал

меняет свою амплитуду: увеличивает

или уменьшает. Это можно

интерпретировать как умножение амплитуды

сигнала на весовой (синаптический)

коэффициент. Взвешенные в дендритном

дереве входные сигналы суммируют-

Рис. 1.11. Биологический нейрон ся в соме> и затем на аксонном

выходе генерируется выходной импульс

(спайк) или пачка импульсов. Выходной сигнал проходит по ветви аксона и

достигает синапсов, которые соединяют аксон с дендритными деревьями других

нейронов. Через синапсы сигнал трансформируется в новый входной сигнал

для смежных нейронов. Этот сигнал может быть положительным или

отрицательным (возбуждающим или тормозящим) в зависимости от вида синапса.

Величина сигнала, генерируемого на выходе синапса, определяется синапти-

ческим коэффициентом (весом синапса), который может меняться в процессе

функционирования синапса.

В настоящее время нейроны разделяют на три большие группы:

рецепторные, промежуточные и эффекторные. Рецепторные нейроны предназначены для

ввода сенсорной информации в мозг. Они преобразуют воздействие

окружающей среды на органы чувств (свет на сетчатку глаза, звук на ушную улитку) в

электрические импульсы на выходе своих аксонов. Эффекторные нейроны

передают приходящие на них электрические сигналы исполнительным органам,

например мышцам, также через специальные синапсы своих аксонов.

Промежуточные нейроны образуют центральную нервную систему и предназначены

для обработки информации, полученной от рецепторов и передачи

управляющих воздействий на эффекторы.

Головной мозг человека и высших животных состоит из серого и белого

вещества. Серое вещество есть скопление дендритов, аксонов и нейронов.

Белое вещество образовано волокнами, соединяющими различные области

мозга друг с другом, с органами чувств, мускулами. Волокна покрыты спецальной

миэлинированной оболочкой, играющей роль электрического изолятора. В

мозге существуют структурно обособленные отделы, такие, как кора, гиппокамп,

таламус, мозжечок, миндалина и т. п. (рис. 1.12). Каждый из отделов имеет

Шх

28

1.4. Биологический аналог параллельной организации обработки информации

Молекулярный слой

Наружный зернистый слой

Слой пирамидных клеток

Внутренний зернистый слой

Ганглионарный слой

Слой полиморфных клеток

Белое вещество

Рис. 1.12. Схема слоев коры больших полушарий

сложное модульное строение. Особое место в мозге занимает церебральная

кора, которая является его новейшей частью. В настоящее время принято

считать, что именно в коре происходят важнейшие процессы ассоциативной

переработки информации.

Связи между сенсорными областями и корой, между различными

участками коры физически параллельны. Один слой клеток проецируется на другой,

причем проекции состоят из множества разветвляющихся и сливающихся

волокон (проекции дивергируют и конвергируют). В настоящее время наиболее

изучен ввод в мозг зрительной информации. Возбуждение от сетчатки

достигает коры топографически упорядочным образом, т. е. ближайшие точки

сетчатки активируют ближайшие точки коры. По реакции на зрительные стимулы

различной сложности различают простые, сложные и гиперсложные нейроны.

Имеется тенденция к усложнению рецепторных свойств нейронов по мере

удаления от входных областей коры. Можно предположить, что

функциональная роль нейронных структур, примыкающих к органам чувств, включая

сенсорные области коры, заключается в преобразовании сенсорной информации

путем выделения все более сложных и информативных признаков входных

сигналов. Ассоциативная обработка получающихся при этом совокупностей

сенсорных признаков осуществляется в ассоциативных зонах коры, куда

поступают и другие сенсорные образы.

Приведенное весьма поверхностное описание принципа обработки

информации в живой природе позволяет сделать вывод, что техническая

кибернетика вплотную подошла к решению задачи управления в реальном времени

методами, отшлифованными за миллионы лет Создателем. Поэтому будет вполне

резонным появление в настоящее время термина «нейроуправление», под

которым понимается «область теории управления, занимающаяся вопросами

применения нейронных сетей для решения задач управления динамическими

объектами...»[1].

29

1. Введение в системы с параллельной организацией вычислительного процесса

Нейрокомпьютером называют ЭВМ (аналоговую или цифровую), основной

операционный блок (центральный процессор) которой построен на основе

нейронной сети и реализует нейросетевые алгоритмы.

1.5. Нейрокомпьютеры и их место среди

высокопроизводительных ЭВМ

Нейрокомпьютеры - это ЭВМ нового поколения, качественно

отличающиеся от рассмотренных классов реально действующих классических

вычислительных систем параллельного типа тем, что для решения задач они

используют не заранее разработанные алгоритмы, а специальным образом подобранные

примеры, на которых учатся. Их появление обусловлено объективными

причинами: отмеченное выше развитие элементной базы, позволяющее на одной плате

реализовать персональный компьютер (PC) - полнофункциональный

компьютер (модель нейрона), и необходимость решения важных практических задач,

поставленных действительностью. Попытки создания ЭВМ, моделирующих

работу мозга, предпринимались еще в 40-х годах специалистами по нейронной

кибернетике. Они стремились разработать самоорганизующиеся системы,

способные обучаться интеллектуальному поведению в процессе взаимодействия

с окружающим миром, причем, компонентами их систем обычно являлись

модели нервных клеток. Однако зарождавшаяся в это же время вычислительная

техника и связанные с нею науки, особенно математическая логика и теория

автоматов, оказали сильное влияние на области исследования, связанные с

мозгом.

К концу 50-х годов сформировался логико-символьный подход к

моделированию интеллекта. Его развитие создало такие направления, как

эвристическое программирование и машинный интеллект, и способствовало угасанию

интереса к нейронным сетям. Неблагоприятным моментом, затормозившим

развитие нейросетевой тематики на два с лишним десятилетия, явилось

опубликование тезиса, выдвинутого авторитетнейшими учеными 60-х годов М.

Минским и С. Пейпертом, о невозможности воспроизведения произвольной

функции нейронной сетью и, следовательно, о невозможности создания

универсального вычислительного устройства на ее основе. Таким образом, в

течение длительного времени основным направлением в развитии

искусственного интеллекта являлся логико-символьный подход, который может быть

реализован на традиционных вычислительных системах. Было получено решение

многих «интеллектуальных» задач из определенных предметных областей. К

началу 80-х годов были созданы условия для возрождения интереса к нейро-

сетевым моделям. Это было связано с накоплением новых данных при

экспериментальных исследованиях мозга. Кроме того, были получены важные

теоретические результаты, позволившие разработать алгоритмы обучения для

различных искусственных нейронных сетей (НС).

30

1.5. Нейрокомпьютеры и их место среди высокопроизводительных ЭВМ

К настоящему времени сформировался обширный рынок нейросетевых

продуктов. Подавляющее большинство продуктов представлено в виде

моделирующего программного обеспечения. Ведущие фирмы разрабатывают также

и специализированные нейрочипы или нейроплаты в виде приставок к

персональным ЭВМ. При этом программное обеспечение может работать как без

нейроприставок, так и с ними. В последнем случае быстродействие гибридной

ЭВМ возрастает в сотни и тысячи раз. Однако при ближайшем рассмотрении

оказывается, что эти приставки представляют собой классические

процессоры (универсальные или специализированные, например сигнальные), в

некоторых случаях учитывающие специфику НС (например, за счет аппаратной

реализации операции адаптивного суммирования). При использовании такого

подхода представляется проблематичным реализация суперЭВМ с «истинным

параллелизмом», когда каждый нейрон работает в соответствии с логикой

работы НС.

Основываясь на достижениях микроэлектроники, можно реализовать ЭВМ

с большим числом элементов - нейронов (порядка тысяч и десятков тысяч).

При этом возникает проблема организации связей между элементами,

отвечающих архитектуре НС, которая на сегодняшний момент для произвольных НС

пока не решена. Поэтому, как указано в [1], современные

супернейрокомпьютеры строятся по традиционной архитектуре МКМД (либо комбинированной

МКМД+PVP, либо МКМД + конвейеризация), но не из стандартных процессо-

эов (i860, Альфа, Мерсед и др.), а из элементов в виде СБИС нейрочипов, аппа-

ратно реализующих фрагмент НС. Наиболее ярким прототипом

супернейрокомпьютера является система обработки аэрокосмических изображений,

разработанная в США по программе «Силиконовый мозг». Объявленная

производительность супернейрокомпьютера составляет 80 PFLOPS (80 -1015

операций с плавающей точкой в 1 с) при физическом объеме, равном объему

человеческого мозга, и потребляемой мощности 20 Вт. Естественно, что такая

производительность не может быть обеспечена с помощью рассмотренных

традиционных архитектур суперЭВМ.

Основные проблемы создания нейрокомпьютеров - разработка

сверхпараллельных нейросетевых алгоритмов формализумых задач и их

распараллеливание в соответствии с архитектурой коммутационной системы, а также

разработка новых методик решения неформализуемых задач. При этом

рассматриваются три вида моделей нейронных сетей: физические,

математические, технологические. Львиную долю публикаций по вопросам создания

нейросетевых моделей составляют работы по реализации различных видов нейро-

процессоров на основе СБИС, оптической, ПЛИС и т. п. технологий

(технологические модели НС). Работы по исследованию физических моделей

НС, в которых отображаются физические принципы функционирования головного

мозга, привели к созданию проекта Кремниевой Мозговой Коры {Silicon Cortex -

SCX), возглавляемого немецким биологом М. Маховальдом. Тем не менее,

несмотря на значительные достижения в разработке физических моделей моз-

31

1. Введение в системы с параллельной организацией вычислительного процесса

га, пока не создано такой модели, которая адекватно отображала бы работу

мозга и позволяла генерировать новое знание. Более того, главная проблема -

моделирование зрения, внимания, координированного управления поведением

не имеет удовлетворительного решения в рамках нейросетевой технологии.

С этих позиций наиболее важными представляются работы по созданию

математических моделей нейросетевых вычислений, которые позволяют

отрабатывать и создавать новые принципы организации параллельной работы

многих вычислительных элементов - формальных нейронов.

Идея коннекционизма

Большое влияние на разработку теории искусственных нейронных сетей

оказал коннекционизм - раздел искусственного интеллекта, связанный с

созданием, исследованием и развитием моделей мозга (мышления) человека. С

точки зрения коннекционизма {connection - связь) в основу концепции НС

положена идея о том, что нейроны можно моделировать довольно простыми

автоматами, а вся сложность мозга, гибкость его функционирования и другие

важнейшие качества определяются связями между нейронами. Каждая связь

представляется как простой элемент, служащий для передачи сигнала. При

таком подходе для нейросетевой модели характерно следующее:

• однородность системы (элементы нейронной сети одинаковы и просты,

все определяется структурой связи);

• надежность системы, построенной из ненадежных элементов, за счет

избыточного числа связей;

• «голографичность», предопределяющая, что при разрушении части

система сохраняет свои свойства.

Предполагается, что широкие возможности систем связи -

демаскирование старых связей и добавление новых - компенсирует бедность набора

элементов, из которых строится модель, их ненадежность, а также возможные

разрушения части связей. На первых этапах развития нейросетевых моделей

коннекционизм сыграл исключительную роль, поскольку были поняты

основные механизмы индуктивного вывода, осуществляемого НС, позволившие

решить множество прикладных задач. Однако для создания математических

нейросетевых моделей, адекватных реальным задачам, требуются более

глубокие исследования биологических принципов функционирования головного мозга.

Направления развития и использования нейрокомпьютеров

Выделим четыре направления, которые представляются наиболее важными

и интересными.

1. Решение задач, традиционных для искусственного интеллекта:

распознавание образов (зрительных, слуховых, обоняния и т. д.), классификация,

извлечение знаний из данных, заполнение пропусков в таблицах данных, построение

32

1.5. Нейрокомпьютеры и их место среди высокопроизводительных ЭВМ

отношений на множестве объектов и т. д. Успешное решение этих задач дает

возможность создавать искусственные органы, например, искусственный глаз,

ухо, нос, предсказывать явления, действия, ситуации, разрабатывать

специальные устройства - миниатюрные, дешевые, быстродействующие (в виде

приставок к персональным компьютерам), обеспечивать потребности

диалогового общения человека с ЭВМ и т. д.

2. Значительного повышения производительности суперкомпьютера можно

ожидать при использовании идеологии НС для решения сложных задач теории

вычислений, так как при этом можно получить естественные параллельные

алгоритмы, позволяющие значительно ускорить вычисления. Нейросетевая

реализация классических задач и алгоритмов вычислительной математики

(решение систем линейных уравнений, решение задач математической физики

сеточными методами, оптимизированных задач, гидро- и аэродинамических

расчетов, молекулярного конструирования лекарств, структурного исследования

человеческих генов и т. д.) может позволить получить значительный прогресс

в области вычислительной и прикладной математики.

3. Использование нейрокомпьютера как инструмента для моделирования

работы структур человеческого мозга, чтобы понять принципы его работы. В

настоящее время успехи нейрофизиологии в области исследования процессов,

происходящих в мозге, позволили создать искусственные НС, решающие

сложные задачи распознавания, восприятия, прогнозирования и т. д. Однако

все еще недостаточно знаний о работе отдельных нейронов, взаимодействия

групп нейронов при обработке разнородной информации, формирования

логического мышления и т. д. Поэтому особенно важным представляется

исследование различных моделей НС и возможности их гибридизации с другими

информационными технологиями для создания теоретической базы построения

интеллектуальных систем, имитирующих функции человеческого мозга. Это

даст возможность строить различные схемы и проверять гипотезы об

устройстве и функционировании структур мозга.

4. Создание на основе концепции НС пр 11 i .но новых систем обработки

информации. Эти системы должны объединять в себе основные достоинства

традиционных ЭВМ, такие, как высокое быстродействие отдельного элемента,

высокую скорость передачи сигналов, большой объем памяти, и основные

достоинства нейрокомпьютеров, связанных с высокой скоростью обработки

как дискретной, так и аналоговой информации, возможностью управления

сложными системами и процессами, возможностью решения в реальном

времени различных типов оптимизационных задач, а также обеспечения

высокой степени надежности и способности адаптации к быстро меняющейся

обстановке.

33

1. Введение в системы с параллельной организацией вычислительного процесса

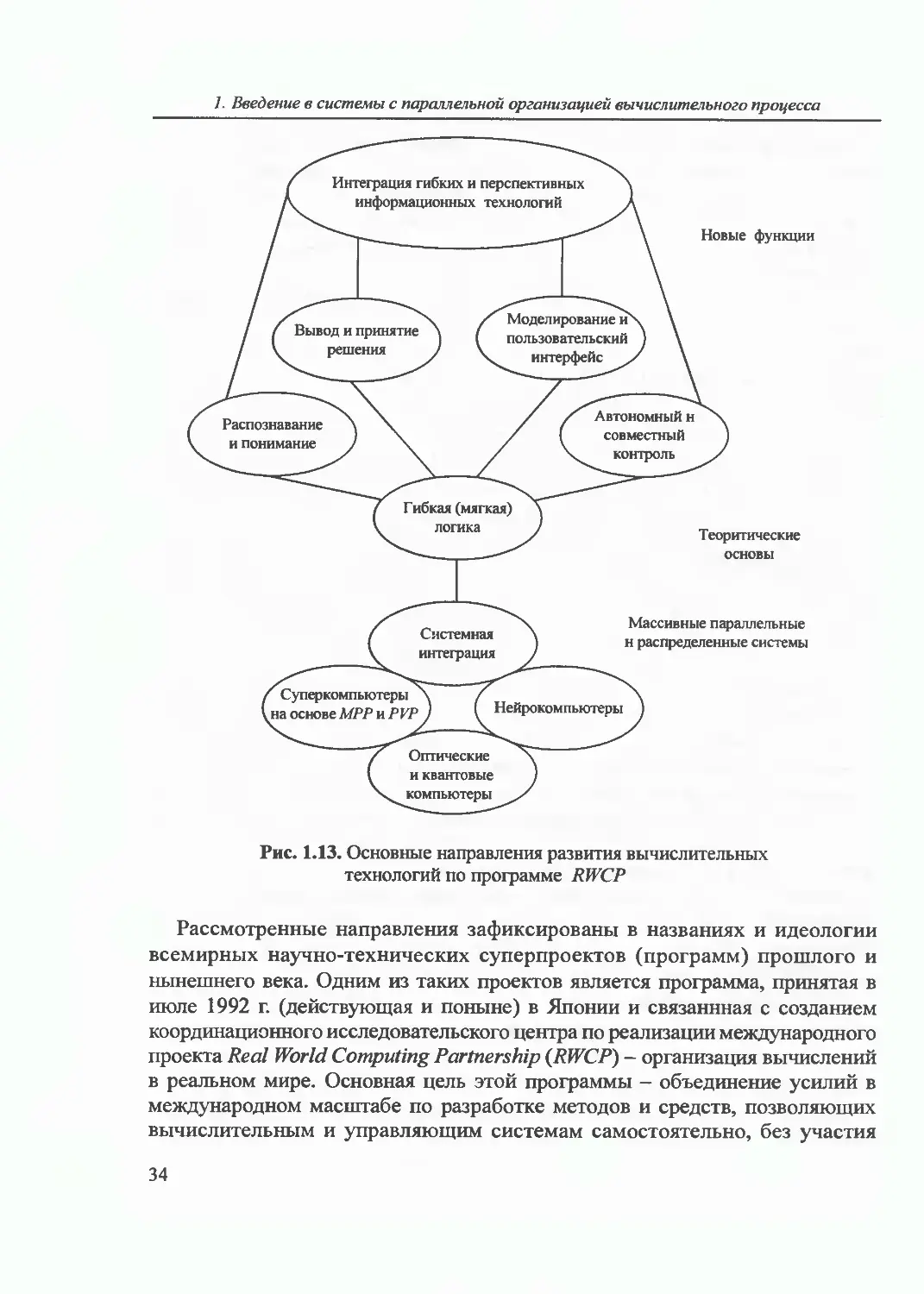

Новые функции

Теоритические

основы

Массивные параллельные

н распределенные системы

Рис. 1.13. Основные направления развития вычислительных

технологий по программе RWCP

Рассмотренные направления зафиксированы в названиях и идеологии

всемирных научно-технических суперпроектов (программ) прошлого и

нынешнего века. Одним из таких проектов является программа, принятая в

июле 1992 г. (действующая и поныне) в Японии и связаннная с созданием

координационного исследовательского центра по реализации международного

проекта Real World Computing Partnership (RWCP) - организация вычислений

в реальном мире. Основная цель этой программы — объединение усилий в

международном масштабе по разработке методов и средств, позволяющих

вычислительным и управляющим системам самостоятельно, без участия

34

1.5. Нейрокомпьютеры и их место среди высокопроизводительных ЭВМ

человека, воспринимать воздействия внешнего мира и действовать в нем: иными

словами, обучаться и адаптироваться в заданной проблемной среде.

Главными являются следующие направления развития этой программы

(рис. 1.13):

• фундаментальные исследования;

• создание новых методов и алгоритмов для решения практических задач,

включая нейросетевые методы и гибридные методы и технологии;

• развитие технологии организации вычислительных процессов в

массивных параллельных вычислительных системах и НС;

• проработка вопросов создания и использования оптических и квантовых

компьютерных систем.

Авторы программы огромную роль (до 30 - 40% ее содержания) отводят

исследованию естественных и созданию искусственных НС. Уже сейчас

искусственные НС применяются для решения очень многих задач обработки

изображений, управления роботами и непрерывными производствами, для

понимания и синтеза речи, для диагностики заболеваний людей и технологических

неполадок в машинах и приборах, для предсказания курсов валют и

результатов спортивных соревнований и т. д. Таким образом, искусственные НС

являются одним из «слонов», на которых сейчас стоит платформа

научно-технического прогресса, и одним из важнейших его направлений является разработка

методов и средств для решения задач реального мира.

Вопросы для самоконтроля

1. Воспроизведите схему системы управления с ЦВМ в контуре и опишите ее работу.

2. В чем особенность интеллектуальных систем?

3. Сформулируйте закон Мура.

4. Дайте определение параллельной ЭВМ.

5. В чем отличие теоретического и практического представления закона Гроша?

6. В чем суть гипотезы Минского?

7. Назовите и дайте характеристику базовых способов введения параллелизма в

архитектуру ЭВМ.

8. Назовите особенности векторных и матричных ЭВМ.

9. Дайте определение нейрокомпьютера.

10. В чем суть идеи коннекционизма?

35

2. МОДЕЛИ ОПЕРАЦИОННОГО БЛОКА

НЕЙРОКОМПЬЮТЕРОВ

Сформулированы задачи, реишемые на нейрокомпьютерах, приведено описание

работы абстрактного нейрокомпьютера (аналог машины фон Неймана). Подробно

рассмотрены модели формальных нейронов, их функции активации, классификация

нейронных сетей. Приведены математические модели многослойных нейронных сетей.

Завершается глава методикой решения задач в нейросетевом базисе (методика A.M.

Галушкина).

2.1. Обобщенная структурная схема нейрокомпьютера

Задачи, решаемые на нейрокомпьютерах

Все задачи, которые решают с помощью средств вычислительной техники,

с точки зрения формализма разработки алгоритма решения удобно разделить

на три класса: формализуемые; трудноформализуемые; неформализуемые [1].

Формализуемая задача имеет четко сформулированный алгоритм

решения. Ярким примером таких задач являются вычислительные задачи: решение

алгебраических, дифференциальных, интегральных и других уравнений,

сортировка данных и т. п. Для решения этого класса задач вычислительной

математикой разработано много эффективных методов, ориентированных именно на

применение в ЭВМ.

Трудноформализуемая задача имеет алгоритм решения, качество

которого трудно оценить или трудно оценить достижимость решения. Этот класс

включает задачи моделирования систем большой размерности (известное

выражение «проклятия размерности»). К ним можно отнести моделирование сложных

электронных устройств в системах автоматизированного проектирования,

задачи интегрированной подготовки производства и т. п.

Неформализуемая задача имеет в своей постановке неявно заданные

функции и параметры. К этому классу относят задачи распознавания образов, кла-

36

2.1. Обобщенная структурная схема нейрокомпьютера

стеризации данных, предсказания, аппроксимации функций и т. п. Для

понимания сути задач этого класса дадим их краткую характеристику.

Задача распознавания образов состоит в отнесении входного набора

данных, представляющего распознаваемый объект, к одному из заранее

известных классов. Это может быть задача распознавания рукописных и печатных

символов при оптическом вводе в ЭВМ, распознавание типов клеток крови,

распознавание речи и пр.

Задача кластеризации данных состоит в группировке входных данных по

присущей им «близости». Алгоритм определения близости данных

(определение расстояния между векторами, вычисление коэффициента корреляции и другие

способы) закладываются в НК при построении. Нейронные компьютеры

кластеризуют данные на заранее неизвестное число кластеров. Кластеризация

применяется при сжатии данных, анализе данных и поиске в них закономерностей.

Задача предсказания заключается в определении значения какого-то

параметра системы (или нескольких параметров) на будущий, еще не наступивший

момент времени по известным значениям этого параметра (или параметров) в

предыдущие моменты времени. Такие задачи актуальны для банков при

принятии решения об объеме страхового запаса финансов, при управлении

складскими запасами.

Задача аппроксимации функции заключается в определении по

экспериментальным данным функции, наилучшим образом приближающейся к

неизвестной и удовлетворяющей определенным критериям. Эта задача актуальна

при моделировании сложных динамических систем.

До недавнего времени НК использовались в основном для решения нефор-

мализуемых задач. Именно необходимость решения таких задач породило

появление реальных нейронных ЭВМ в бывшем СССР еще 30 лет назад [1].

Однако развитие теории и элементной базы последних лет позволило

разработать методы проектирования НК для решения и формализуемых, и труднофор-

мализуемых задач. Таким образом, сегодня НК приобретает черты

универсальной вычислительной машины.

Схема абстрактного нейрокомпьютера

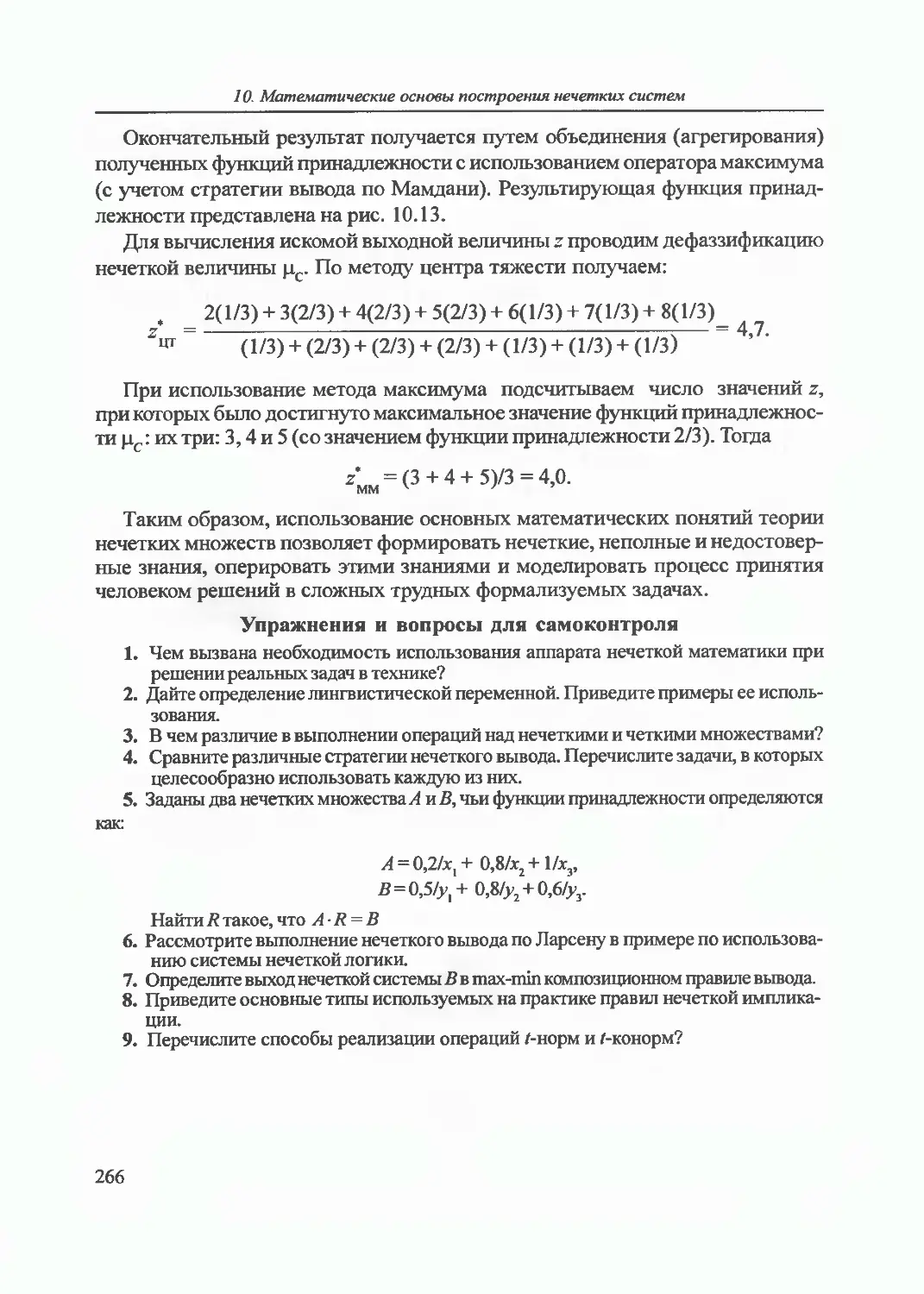

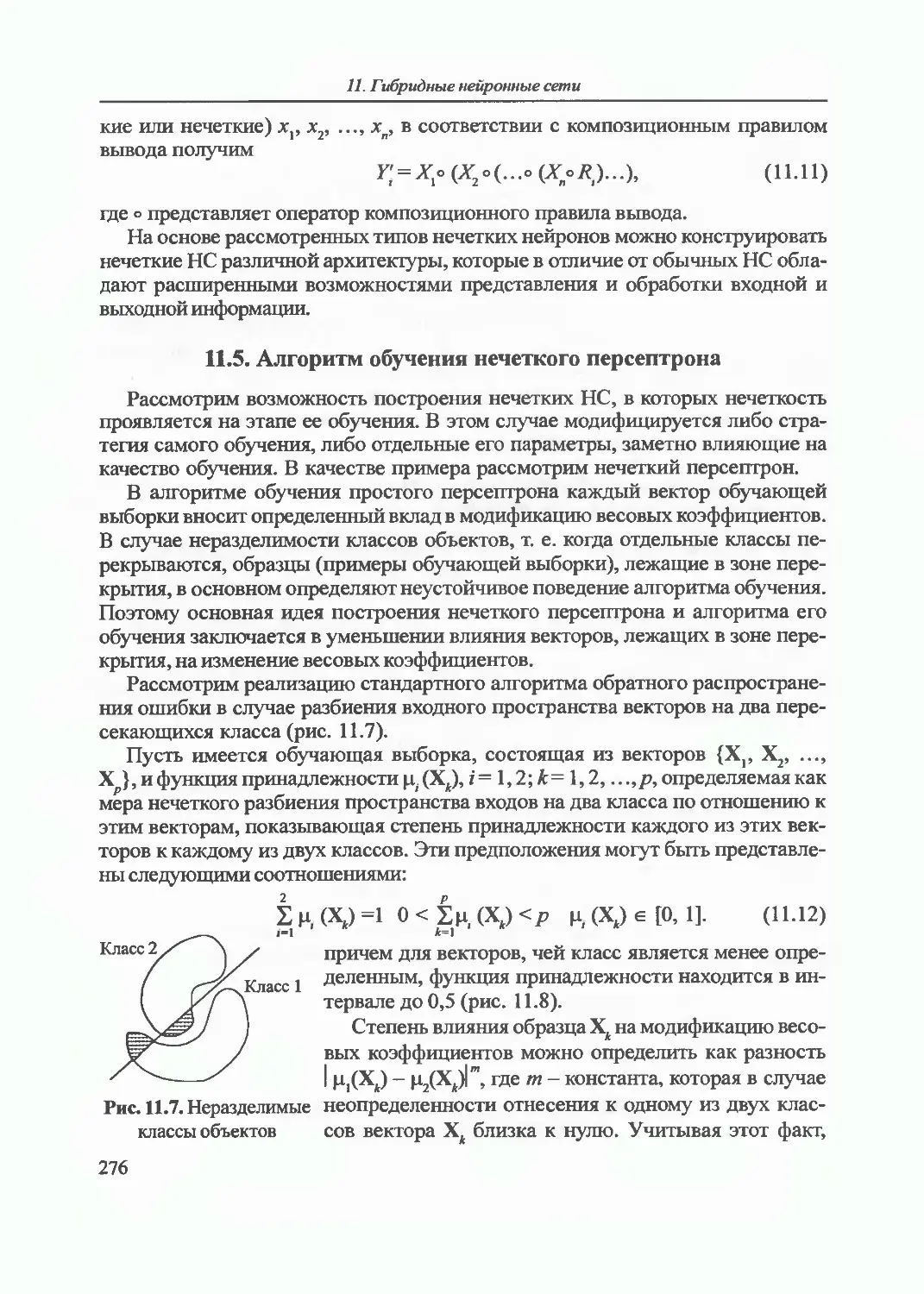

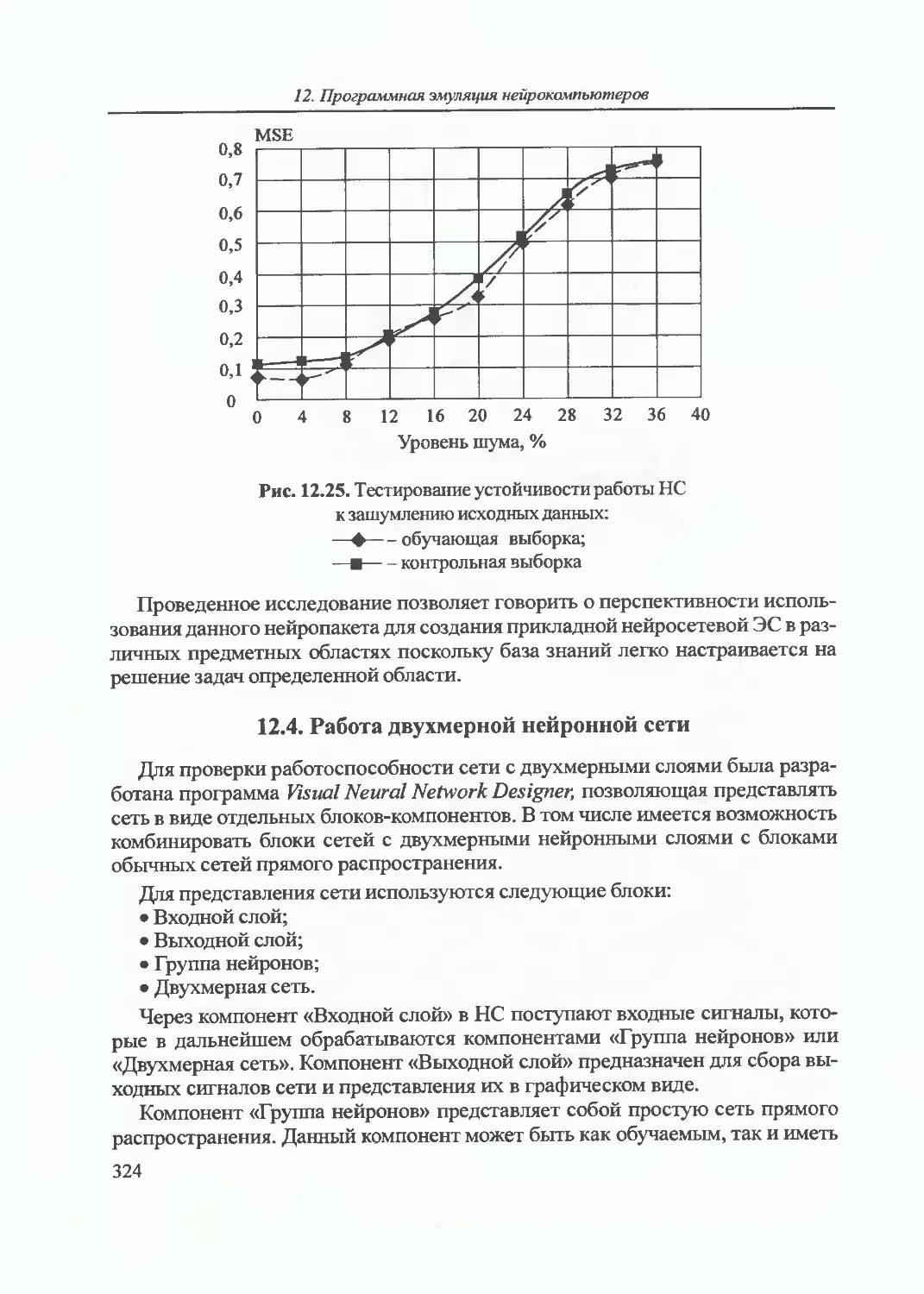

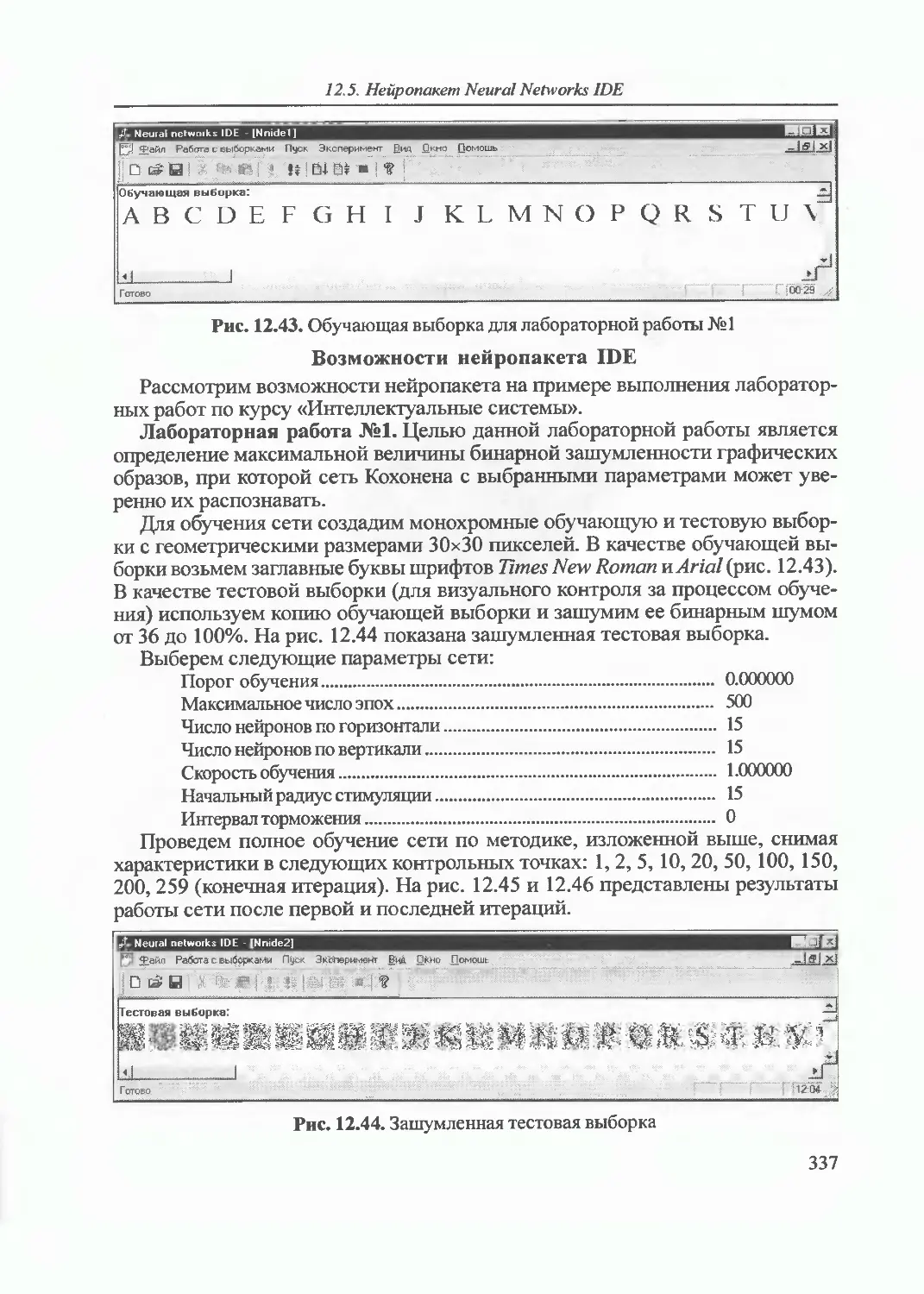

На рис. 2.1 представлена структурная схема абстрактного НК. Такую