Автор: Мэйндоналд Дж.

Теги: теория вероятностей математическая статистика комбинаторный анализ теория графов математика статистика вычислительная математика

ISBN: 0-471-86452-8

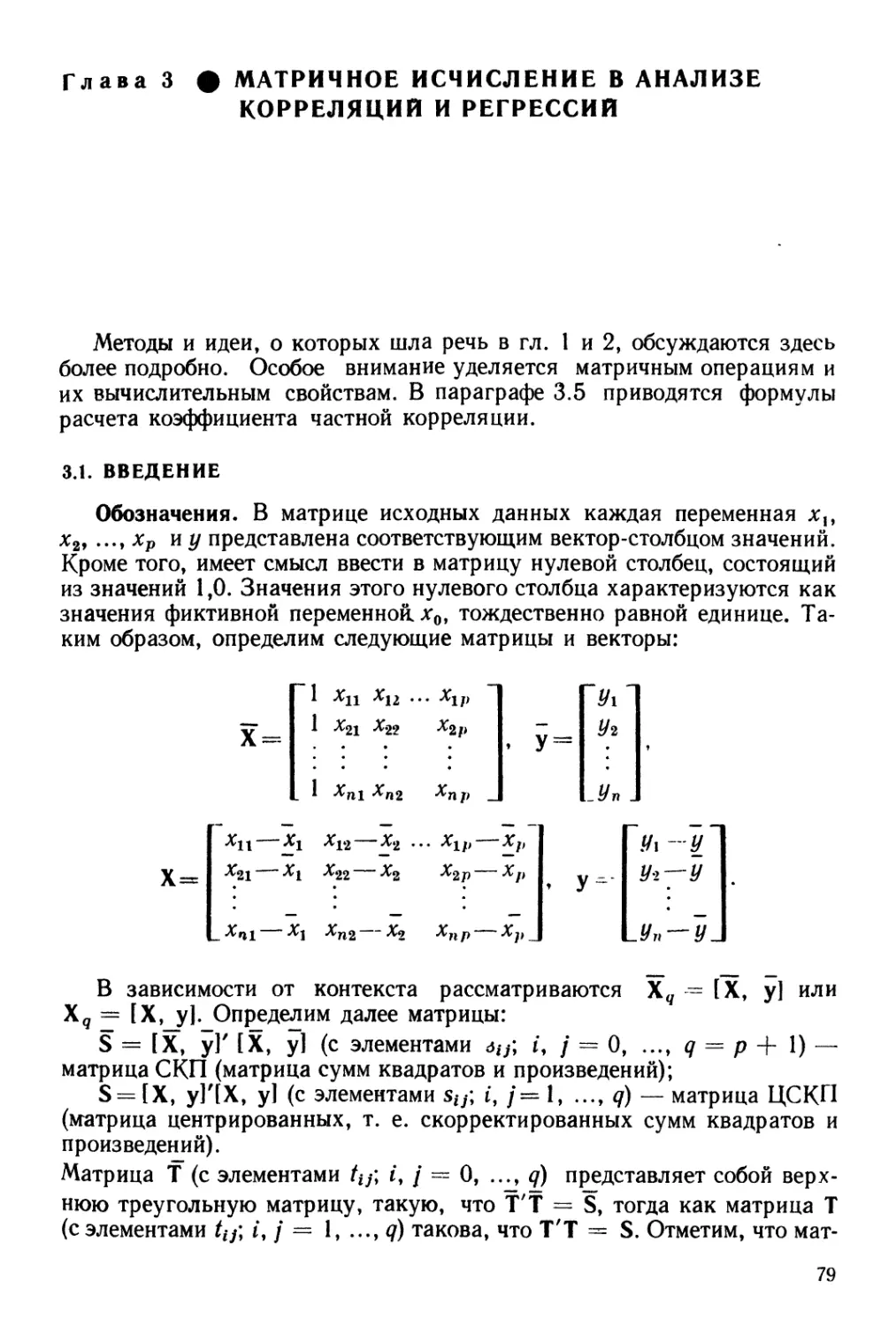

Год: 1988

Текст

МАТЕМАТИ КО-СТАТИ СТИ Ч ЕСКИ Е

МЕТОДЫ ЗА РУБЕЖОМ

STATISTICAL

COMPUTATION

J.H.MAINDONALD

Applied Mathematics Division

Department of Scientific

and Industrial Research.

Auckland, New Zealand

JOHN WILEY & SONS

New York • Chichester • Brisbane • Toronto • Singapore

Дж. Мэй ндоналд

ВЫЧИСЛИТЕЛЬНЫЕ

АЛГОРИТМЫ

В ПРИКЛАДНОЙ

СТАТИСТИКЕ

Перевод с английского Б.И. КЛИМЕНКО, А.В. ГМЫРИ

Под редакцией Е.З. ДЕМИДЕНКО

Москва "Финансы и статистка" 1988

ББК 22.172

М97

МАТЕМАТИКО-СТАТИСТИЧЕСКИЕ

МЕТОДЫ ЗА РУБЕЖОМ

Серия основана в 1977 году

ВЫШЛИ ИЗ ПЕЧАТИ

1. Ли Ц., Джадж Д., Зельнер А.

Оценивание параметров марковских

моделей по агрегированным временным

рядам.

2. Райфа Г., Шлейфер Р.

Прикладная теория статистических

решений.

3. Клейнен Дж. Статистические

методы в имитационном моделировании.

Вып. 1 и 2.

4. Бард Й. Нелинейное оценивание

параметров.

5. Б о л ч Б. У., X у а н ь К. Д.

Многомерные статистические методы для

экономики.

6. И б е р л а К. Факторный анализ.

7. Зельнер А. Байесовские методы

в эконометрии.

8. X е й с Д. Причинный анализ в

статистических исследованиях.

9. П у а р ь е Д. Эконометрия

структурных изменений.

10. Драймз Ф. Распределенные

лаги.

И. Мостеллер Ф., Тьюки Дж.

Анализ данных и регрессия. Вып. 1 и 2.

12. Бикел П., Доксам К.

Математическая статистика. Вып. 1 и 2.

13. Л им ер Э. Статистический анализ

неэкспериментальных данных.

14. Песаран М., Слейтер Л.

Динамическая регрессия: теория и

алгоритмы.

15. Дидэ Э. и др. Методы анализа

данных.

16. Бартоломью Д.

Стохастические модели социальных процессов.

17. Дрейпер Н., Смит Г.

Прикладной регрессионный анализ. Кн. 1

и 2.

18. Хеттманспергер Т.

Статистические выводы, основанные на

рангах.

19. Д эй в и сон М. Многомерное

шкалирование. Методы наглядного

представления данных.

20. Жамбю М. Иерархический

кластер-анализ и соответствия.

21. Кокс Д. Р., О у кс Д. Анализ

данных типа времени жизни.

ГОТОВИТСЯ К ПЕЧАТИ

Л и ттл Р. Дж. А., Рубин Д. Б.

Статистический анализ данных с

пропусками.

Редколлегия: А. Г. Аганбегян,.

Ю. П. Адлер, С. А. Айвазян, Ю. Н.

Благовещенский, Б. В. Гнеденко,

Э. Б. Ершов, Е. М. Четыркин

М

0702000000—110

010@1)—88

109—88

ISBN 0—471—86452—8 (США)

ISBN 5—279—00057—4 (-СССР)

© 1984 by John Wiley & Sons, Inc.

© Перевод на русский язык,

предисловие «Финансы

и статистика», 1988

ПРЕДИСЛОВИЕ К РУССКОМУ ИЗДАНИЮ

Трудно переоценить роль вычислений в современной статистике.

Собственно вычисление здесь и представляет собой единственно

возможный эксперимент, который всегда служил «окончательным судьей»

теоретических споров и научных изысканий. Математическая и

прикладная статистика, хотя это до сих пор многими не осознано, всегда была

и остается кладезем разного рода вычислительных задач. Великий

немецкий математик К. Ф. Гаусс A777—1855), по-видимому, был первым,

кто свел статистическую задачу оценивания параметров линейной

зависимости к решению системы линейных уравнений на основе

предложенного им метода наименьших квадратов. В 1944 г. К. Левенберг

предложил итеративный метод минимизации суммы квадратов отклонений в

нелинейной регрессии, который со времени И. Ньютона и К. Гаусса,

по признанию специалистов в области оптимизации, был одним из

первых практических итеративных методов минимизации неквадратиче-

ской функции многих переменных.

Термин «вычислительная статистика» (computational statistics)

прочно вошел в лексикон статистиков. Соответствующий раздел прикладной

статистики стал развиваться особенно бурно в последнее время в связи

с вторжением компьютерной техники во все сферы человеческой

деятельности.

Методам и алгоритмам вычислений в современной статистике и

посвящена книга Дж. Мэйндоналда «Вычислительные алгоритмы в

прикладной статистике».

Регрессионный анализ — наиболее популярный раздел прикладной

статистики. При этом особое значение приобретает проблема выбора

устойчивого, экономного алгоритма расчета регрессий, или, более

конкретно, оценок наименьших квадратов. Почти половина книги

посвящена этой важной теме. Вычислению оценки наименьших квадратов и

более общей проблеме решения системы линейных уравнений с

неотрицательно определенной симметричной матрицей уделяется достаточно

внимания специалистами по вычислительной математике как у нас в

стране, так и за рубежом. Недавно на русский язык была переведена

книга Ч. Лоусена, Р. Хенсона «Численное решение задач метода

наименьших квадратов» (М.: Наука, 1986), посвященная

непосредственно этой теме. Число алгоритмов для решения задачи нахождения

оценки наименьших квадратов на сегодняшний день достаточно велико,

большинство из них обсуждаются в книге Дж. Мэйндоналда. Эти

алгоритмы, естественно, обладают неодинаковой степенью устойчивости к

ошибкам округления, требуют разного объема памяти ЭВМ и времени

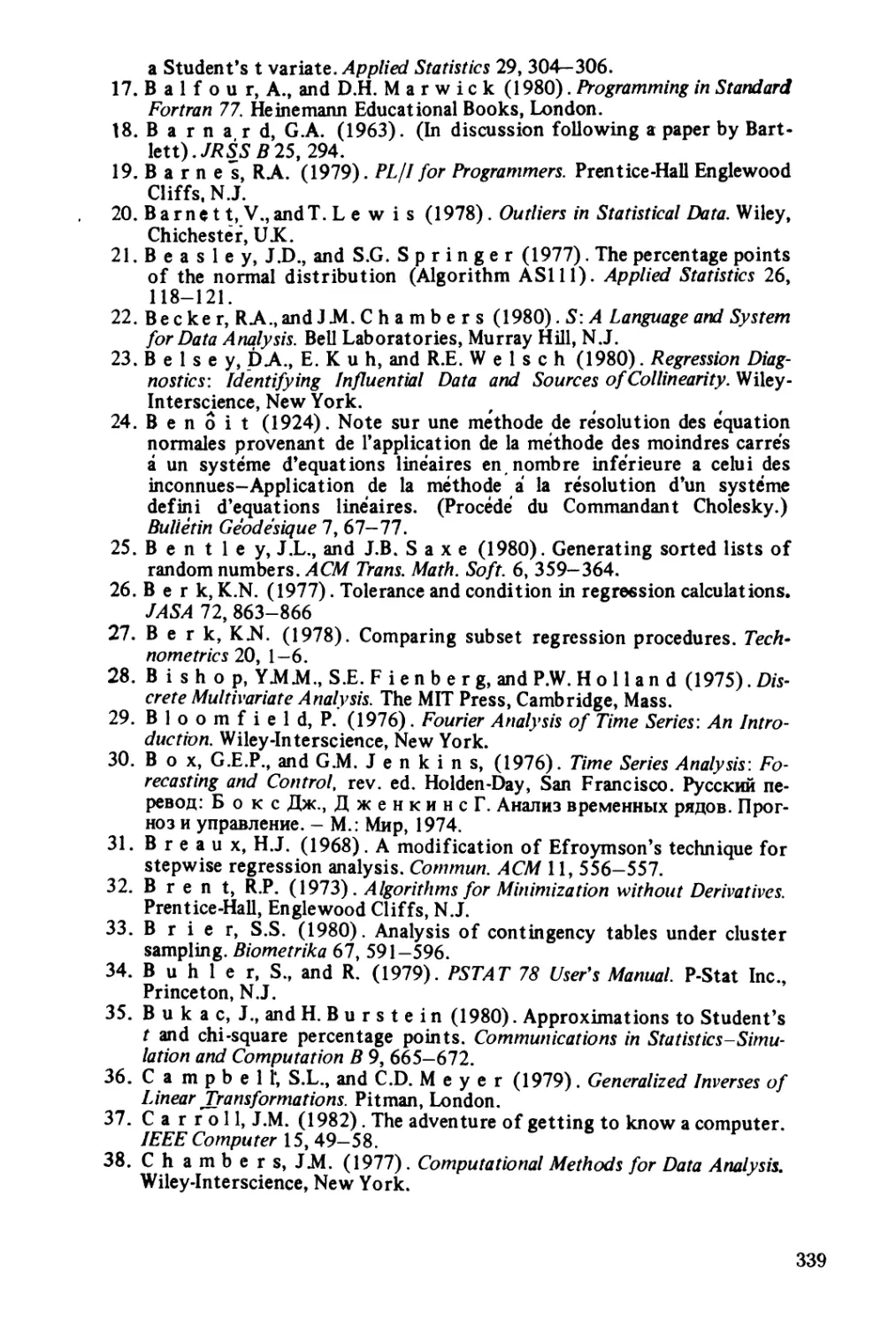

счета. В приведенной ниже таблице (основанной на табл. 19.1 из книги

Ч. Лоусена и Р. Хенсона) представлены методы решения задачи

наименьших квадратов с оценкой соответствующего числа операций.

Число операций для численных методов решения задачи наименьших квадратов

Мртод

1. Приведение к треугольному виду

методом Хаусхолдера

2. Сингулярное, разложение:

2.1. прямое применение

2.2. приведение к треугольной

матрице методом Хаусхолдера

3. Метод Грама — Шмидта

(классический или модифицированный)

4. Решение нормальных уравнений

методом Холецкого

5. Решение нормальных уравнений

методом Гаусса—Жордана (для

пошаговой регрессии)

6. Спектральный анализ нормальных

уравнений

Приблизительное число операций

/Ш1*—./Я»/3

2лт2 + 4т3

пт2 + т3

«3

пт2

т3/6+пт2/2

т»/3+лт2/2

16

т3 + я/п2/2

3

Замечание. Добавочный член пт2/2 в последних трех методах связан с

формированием матрицы нормальных уравнений (точнее, он равен пт(т-\-\)/2.

Здесь п — объем выборки, т — число коэффициентов регрессии.

Задача решения системы линейных уравнений возникает в связи с

численным нахождением оценки параметров регрессии, и это

накладывает свой, «статистический» отпечаток на всю вычислительную работу.

Статистика (в отличие от вычислителя) интересуют не только значения

оценок наименьших квадратов, но и их дисперсии, которые

пропорциональны диагональйым элементам матрицы, обратной к матрице системы

нормальных уравнений. Таким образом, необходимость вычисления

диагональных элементов обратной матрицы заставляет либо вообще

отказаться от некоторых методов, перечисленных в таблице, либо

требует их модификации, в результате которой были бы найдены не только

решения системы нормальных уравнений, но и диагональные элементы

обратной матрицы. Последнее требование заставляет вообще

отказаться от некоторых методов вычисления оценок наименьших квадратов и

обратиться к новым алгоритмам, ранее не принимавшихся во внимание.

Более того, поскольку статистика часто интересуют не только

дисперсии оценок, но и их ковариации (необходимые, например, при расчете

дисперсии прогноза), лучший метод решения задачи вычисления

оценки наименьших квадратов следует искать среди методов обращения сим-

метричных, положительно (или неотрицательно) определенных матриц

(похоже, что одним из наиболее экономных методов обращения

симметричных, положительно определенных матриц служит метод выметания

(sweeping), при этом приблизительное число операций равно 2т3 +

+ пт2/2).

Статистический подход к проблеме вычисления оценки метода

наименьших квадратов привносит еще один методологический нюанс в

поиск наиболее эффективного алгоритма. Есть основания считать, что

особо эффективный алгоритм и не нужен. Вспомним поучительную

дискуссию, развернувшуюся вокруг исследования, проведенного

в 1967 г. Дж. Лонгли с целью анализа качества программ для решения

задачи наименьших квадратов. Лишь благодаря настольному

калькулятору, работавшему с 40 значащими цифрами, Дж. Лонгли удалось

найти удовлетворительное (можно считать, абсолютно точное) решение

одной регрессионной задачи. Таким образом, программы в большинстве

своем были признаны им неудовлетворительными. Спустя 9 лет, его

соотечественники А. Битон, Д. Рубин и Дж. Бароне вернулись к ставшей

знаменитой «регрессии Лонгли». Они заметили, что отвергнутые ранее

программы давали очень высокое значение дисперсии оценок даже в

том случае, когда соответствующие оценки не совпадали не только по

первым значащим цифрам с «точным» решением Лонгли, но и по знакам.

«Зачем нужны нам точные решения, если заведомо они неустойчивы к

даже ничтожным изменениям зависимой переменной?»—задавали

естественный вопрос авторы более позднего исследования (более

подробное обсуждение «регрессии Лонгли» читатель найдет в книге [236]).

Само собой разумеется, что пределы поиска эффективного и наиболее

точного алгоритма должны быть разумными. Алгоритм решения задачи

наименьших квадратов должен быть, помимо всего прочего, экономным

и по возможности адаптивным. Последнее означает, что при расчете

новой регрессии с добавочными или исключенными факторами

результаты предыдущих вычислений должны быть максимально

использованными. Подобное свойство алгоритма позволяет достаточно быстро

организовать выбор наилучшей регрессии, который в свою очередь можно

осуществить либо полным перебором, либо методом включения всех

возможных (потенциальных) факторов регрессии, либо методом их

исключения.

В одной работе трудно подробно описать все вычислительные схемы

и алгоритмы, применяемые сегодня в прикладной статистике. Автор

ограничивается иногда лишь кратким упоминанием, схематичным

описанием того или иного метода. Для более подробного ознакомления

читатель может обратиться к литературе, приведенной в конце книги.

В заключение отметим, что книга Дж, Мэйндоналда окажет

существенную пользу специалистам по прикладной статистике и

вычислительной математике, а также программистам. Она будет полезна всем, кого

заинтересует использование вычислительных схем и алгоритмов в

современных статистических исследованиях.

Е. 3. Демиденко

ПРЕДИСЛОВИЕ

Эта книга адресована профессиональным статистикам, а также

студентам, желающим более глубоко ознакомиться с техникой

статистических расчетов. Она может оказаться полезной и для тех, кого

интересуют проблемы чисто вычислительного характера. Статистический

анализ для них — лишь область приложения аппарата линейной

алгебры, вычислительной математики и матричного исчисления.

Практически в любом пакете компьютерных программ по

статистике имеется программа оценки параметров множественной регрессии.

Однако возможности проведения статистического анализа с помощью

такого пакета существенно расширяются, если в нем также

представлены программы по дисперсионному и ковариационному анализу,

логлинейному анализу многофакторных таблиц. Указанные темы

рассматриваются в первых семи главах книги. В гл. 8 и 9 излагаются, хотя

и менее подробно, вопросы построения сплайн-функций, робастного

оценивания параметров регрессии, особенности исследования

временных рядов, способы получения псевдослучайных чисел, а также

некоторые другие, менее важные темы, представляющие биределенный

интерес для статистиков-прикладников. В последней главе показана та

роль, какую играют компьютеры в Современном статистическом

анализе. Методы проведения расчетов я старался рассматривать в контексте

исследования реальных статистических проблем.

Гл. 1—3 посвящены в основном применению методов наименьших

квадратов для решения системы нормальных уравнений и вычислению

сопутствующих им статистических характеристик. Тем самым создается

база для обсуждения в гл. 4 численно более тонких методов,

основанных на использовании алгоритмов ортогонального приведения матрицы

к верхней треугольной форме. Такой подход, когда вначале

рассматриваются методы, основанные на решении системы нормальных

уравнений, обусловлен тем, что большинство статистиков хорошо знакомы

именно с этими алгоритмами. Кроме того, с помощью указанных

методов удается продемонстрировать порядок проведения расчетов на

примерах, в которых данные подобраны таким образом, чтобы

максимально упростить арифметические выкладки. Матричные операции,

вводящиеся в первых четырех главах, служат основой для большинства

вычислений, представленных в гл. 5—7. Здесь приведены простые

способы выявления линейных зависимостей и показана работа с ними.

При этом обобщенная обратная матрица как таковая практически не

применяется.

Изложение гл.6 базируется на использовании алгоритма

вычисления собственных значений и собственных векторов. Обсуждение

достоинств и недостатков альтернативных алгоритмов выходит за рамки

настоящей книги. Поэтому читателю, желающему в деталях

познакомиться с подобными алгоритмами, мы советуем обратиться прежде всего к

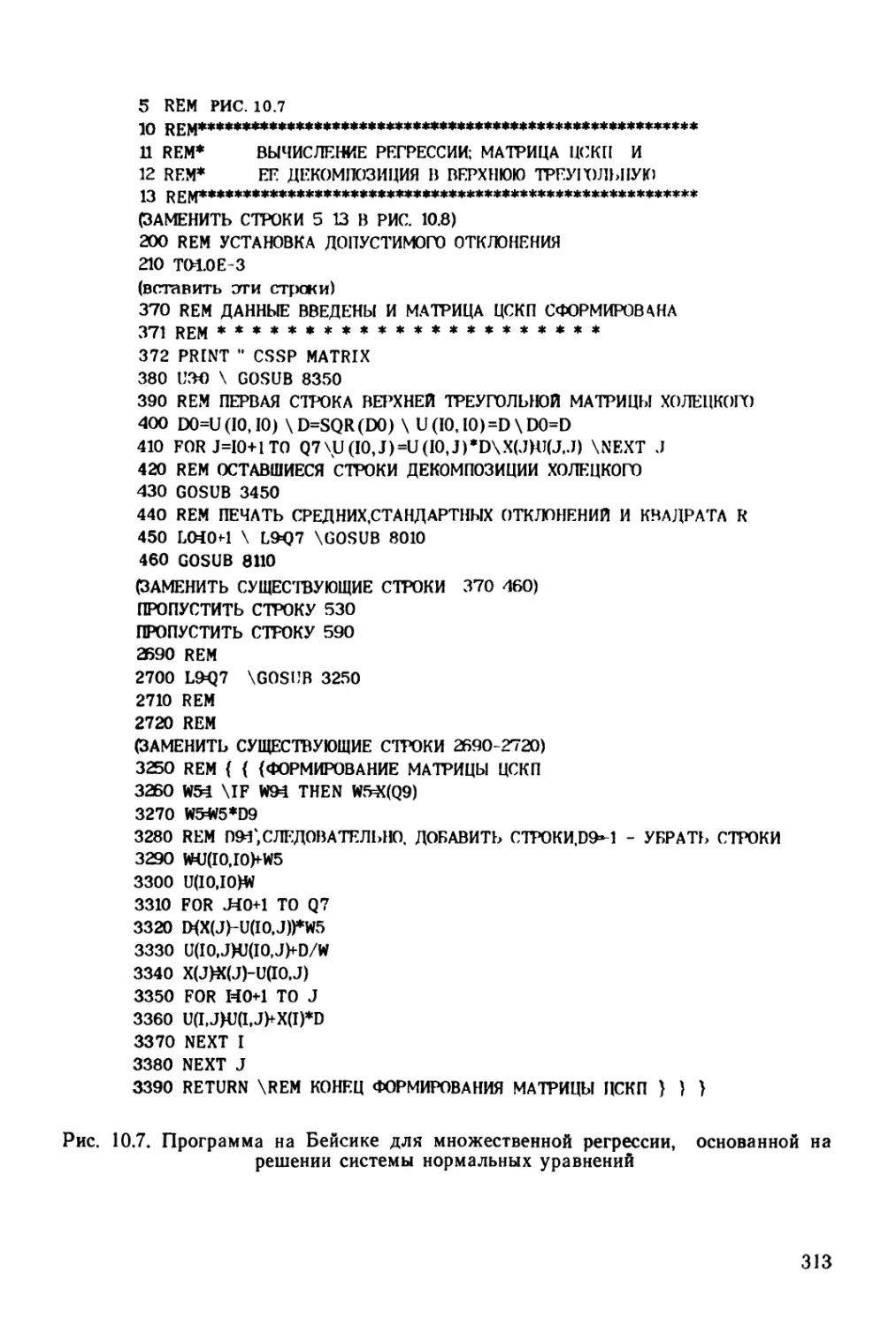

работе Дж. Наша [164]. В гл. 10 приводится написанная на Бейсике

программа для работы с матрицами небольшой размерности.

Мы не ожидаем, что после прочтения настоящей книги большинство

читателей сразу же приступит к составлению своих компьютерных

программ. Этим стоит заняться разве что в учебных целях, в порядке

упражнений. Наша задача — побудить читателя к осмысленной работе

с уже имеющимися статистическими программами.

Написанные на Бейсике программы, приведенные в гл. 9 и 10,

представляют интерес для тех, кто захотел бы поэкспериментировать,

используя небольшие компьютеры (включая некоторые из имеющихся

в настоящее время переносных компьютеров) при проведении

статистических вычислений.

Если не считать работ по вычислительным методам, я не могу

назвать каких-либо других книг, посвященных выбранной мной теме.

Хотя существует обширная литература, знакомящая со

статистическими методами расчетов, работы, доступные читателю со скромным

уровнем математической подготовки, практически отсутствуют. Еще одна

примечательная черта настоящей книги состоит в том, что в ней я

уделяю внимание как самим вычислениям, так и статистическим аспектам

рассматриваемых методов анализа.

Включение той или иной темы было продиктовано необходимостью

осветить лишь наиболее известные и популярные методы вычислений в

статистических исследованиях. Таким образом, в книге прежде всего

уделяется внимание вопросам практического использования

статистических методов, особенно в тех случаях, когда соответствующие модели

только недавно получили достаточно широкое распространение.

Описание методов, рассмотренных в гл. 1—3, и приведенные в них

примеры доступны для читателя, знакомого лишь с основами

матричного исчисления. При чтении параграфов, помеченных звездочкой в

этих глайах, а также при чтении последующих глав требуется знание

элементарной линейной алгебры. Гл. 7 предполагает некоторое

знакомство с методом максимального правдоподобия. Более сложные

упражнения и упражнения, требующие громоздких вычислений, также

помечены звездочкой.

Окленд, Новая Зеландия,

январь 1984 г. Дж. Мэйндоналд

ОБОЗНАЧЕНИЯ

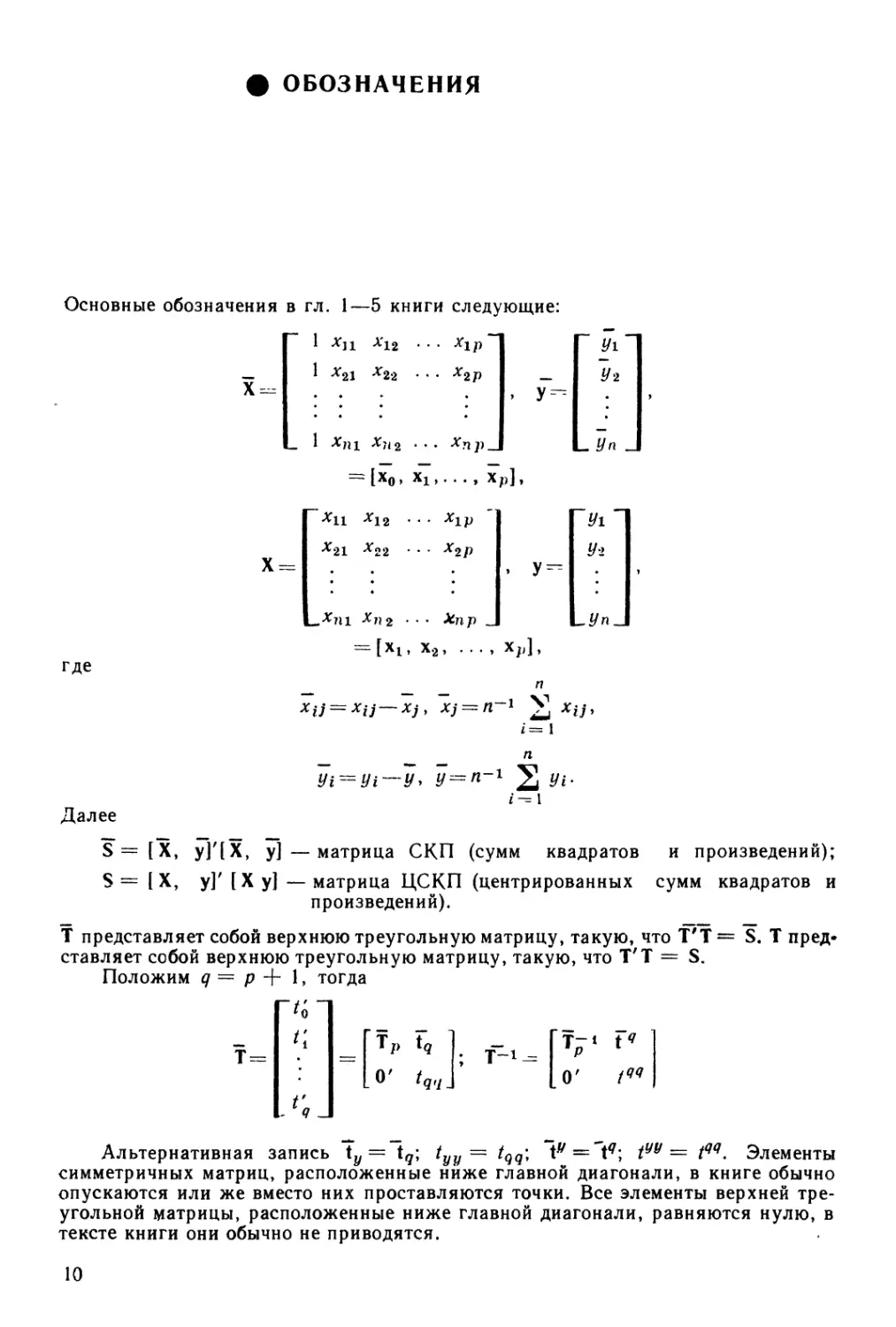

Основные обозначения в гл. 1—5 книги следующие:

1 Л*]! Х12 . . . Х1}

х22

Хщ

У^

У\

~У2

Х =

Хц

где

Уг

У-1

х22 • •, х2р

l ХП2 • • • Х-пр _

п

¦¦хи-х,,Ъ = п-* V *w,

Далее

S=[X, yJ'[X, у]—матрица СКП (сумм квадратов

S= [X, у]' [Ху] —матрица ЦСКП (центрированных

произведений).

Т представляет собой верхнюю треугольную матрицу, такую, что Т'Т

ставляет собой верхнюю треугольную матрицу, такую, что Т'Т = S.

Положим д = р + 1, тогда

и произведений);

сумм квадратов и

S. Т

пред</ J

Ч

о' /,,,

с

Альтернативная запись ty = tq; tyy — tqq\ tv=1<7; tyy = tqq. Элементы

симметричных матриц, расположенные ниже главной диагонали, в книге обычно

опускаются или же вместо них проставляются точки. Все элементы верхней

треугольной матрицы, расположенные ниже главной диагонали, равняются нулю, в

тексте книги они обычно не приводятся.

10

Глава 1 # РАСЧЕТ РЕГРЕССИИ. Часть I

В этой главе будут рассмотрены некоторые методы решения системы

нормальных уравнений, возникающей при применении метода

наименьших квадратов в регрессии. Изложение иллюстрируется простыми

числовыми примерами, которые подобраны таким образом, чтобы не

вызывать затруднений вычислительного характера. Методы решения

таких^ систем базируются на алгоритмах приведения матрицы Х'Хк виду

ТТ, где Т — верхняя треугольная матрица, т. е. такая матрица, в

которой все элементы, расположенные ниже главной диагонали, равны

нулю.

1.1. ЛИНЕЙНАЯ ПАРНАЯ РЕГРЕССИЯ

Рассмотрим задачу: требуется «провести» прямую через следующие

точки на плоскости:

1 = 1

i = 2

t=3

i-4

— 2

J

2

7

0

2

5

3

Число точек здесь равно п = 4. Нетрудно вычислить:

Z*i = 6, 2*/* = 10, 2x2i = 58, 2*101=29, 2#=

На рис. 1.1 показана прямая, произвольным образом «проведенная»

через эти четыре точки. Уравнение такой прямой может быть записано

в виде у = а + Ьх. Чтобы понять смысл использования «крышки» над

г/, предположим, что х = xt представляет собой значение х одной из че-

тырех числовых точек. «Крышка» позволяет отличить точку (хь yt)

на прямой линии от числовой точки с координатами (xiy yt).

Предположим, что у — зависимая переменная, ах — предиктор,

т. е. объясняющая (независимая) переменная. Тогда метод наименьших

квадратов позволяет подобрать аи b таким образом, чтобы сумма

квадратов отклонений по у от построенной прямой линии была минималь-

11

ной. Для того чтобы получить формальное математическое описание

этого метода, рассмотрим уравнение

*=1, 2, 3, 4.

Величины et (положительные для точек, расположенных выше прямой,

и отрицательные для точек, лежащих ниже прямой) показаны на рис. 1.1

жирными вертикальными линиями. Оценки параметров а и Ь должны

быть такими, чтобы величина 2е? была минимальной. В курсе элемен-

5

4

3

! 2

1 1

-2 -1

г

-

-

I

1 2

I

3

I I I

4 5 6 7

Рис. 1.1. Прямолинейная регрессия

тарной статистики показывается, что оценки параметров а и Ь могут

быть получены в результате решения следующей системы уравнений:

A.1)

A.2)

где для простоты индекс i опущен. В нашем случае эта система примет

вид

Dа+66=10, A.3)

Fа+ 586 =29. A.4)

Решим эту систему. Параметр а может быть исключен умножением A.3)

на 3/2 и вычитанием полученного результата из A.4). Тогда получаем

Dа + 66=10, A.3')

| 496 = 14. A.4')

Метод решения полученной системы состоит в обратной подстановке,

а именно: вначале мы найдем 6 = 2/7 из A.4'), а затем подставим

найденное значение 6 в A.3'), что дает 4а = 10 — 6 х B/7), а = 29/14.

12

1.2. МОДИФИЦИРОВАННАЯ СХЕМА РЕШЕНИЯ СИСТЕМЫ

НОРМАЛЬНЫХ УРАВНЕНИЙ

Схема, к описанию которой мы приступаем, будет в центре нашего

внимания на протяжении почти всей книги. Она называется схемой

Холецкого, или схемой квадратного корня. Итак, начнем с

рассмотрения системы

4а+ 66 =10, B.1)

6а+586 = 29. B.2)

Однако теперь вместо уравнений A.3') и A.4'), следуя схеме

Холецкого, приходим к системе

Bа+ 36 =5, B.3)

I 7fe=2. B.4)

Уравнение B.3) получено в результате деления коэффициентов

уравнения A.3') на квадратный корень из коэффициента при а, т.е. на|/г4.

Уравнение B.4) может быть получено из уравнения A.4') делением его

коэффициентов на "^49, что является квадратным корнем из

коэффициента b этого уравнения.

Описанная процедура имеет следующие два отличительных свойства:

1) коэффициент при Ъ в B.3) показывает, на какую величину

следует умножить B.3), чтобы вычесть полученный результат из уравнения

B.2);

2) выражения в правой части уравнений B.3) и B.4), помимо всего

прочего, дают информацию, необходимую для составления следующей

таблицы дисперсионного анализа:

Сумма квадратов

обусловленная свободным членом (определяется разностью

между 2у2 и 2 (у —уJ) 5*

обусловленная х при данном свободном члене

(определяется разностью между 2(# —уJ и 2 (# — а — ЬхJ) 22

Эта таблица может быть использована также для расчета остаточной

суммы квадратов (СК): 2*/2 — 52 — 22 = 9.

Последовательность вычислений может быть представлена

следующим схематическим образом (номер уравнения во всей цепочке

преобразований остается неизменным):

B.1) 4a + 6fc = 10, Разделим члены 2а+3& = 5, B.Г)

B.2) 6а+58&=29. B.1) на УТ. 6а+ 586= 29. B.2)

13

Умножим B. Г) на 3 (коэффициент при 6 в этом уравнении) и

вычтем его из B.2).

B. Г) 2а + 36 =5, Разделим члены 2а + 36 = 5, B. Г)

B.2') 496=14. B.2') на/49. 76 = 2. B.2")

Поскольку известно, что значение коэффициента при а в B.2') равно

нулю, рассчитывать его не нужно.

В общем случае линейной парной регрессии, начав с системы

B.5)

B.6)

по схеме Холецкого приходим к системе

Ь = п-1'22у, B.5')

2[Z(x-x)(y--y)]. B.6')

Все члены уравнения B.5') перед тем, как его вычли из уравнения B.6),

были умножены на д-1/2 2х, т. е. на значение коэффициента при 6.

При получении B.6) необходимо воспользоваться следующими

соотношениями:

n-1(ExJ = 2(x—x)\ B.7)

Zxy-п-1 (Ех) Bу) = 2 (х-х) (у-у). B.8)

Можно легко проверить, что элементы описанной выше таблицы

дисперсионного анализа были рассчитаны правильно. Возведение в квадрат

члена, расположенного в правой части B.5'), дает

что можно трактовать как уменьшение суммы квадратов,

обусловленное присутствием свободного члена. Возведение в квадрат члена,

стоящего в правой части уравнения B.6'), приводит к

[S (х—7) (у—у)]а = 2 (f/_ -J_2 {у_а_ЬхJу

2 (х-хJ

где а и 6 определяются на основе B.5) и B.6). Подробности

соответствующих алгебраических преобразований можно уточнить в любом курсе

элементарной статистики.

При описании схемы вычислений запись коэффициентов а и 6, а

также знаки равенства для простоты изложения можно опустить. В

дополнение к этому, как будет показано в следующем параграфе,

полезно включить в рассмотрение дополнительную строку, в которой

приводилась бы информация, необходимая для расчета остаточной суммы

квадратов.

14

1.3. СХЕМАТИЧЕСКОЕ ПРЕДСТАВЛЕНИЕ РЕШЕНИЯ СИСТЕМЫ

Информация, содержащаяся в уравнениях B.3) и B.4), т. е.

Bа+ 36 = 5,

1

адекватным образом может быть представлена в виде следующей

формальной схемы:

а Ь

2 3 | 5

7 I 2

Подобные схематические представления будут использоваться нами во

всем последующем изложении.

Таким образом, у нас имеется верхняя треугольная матрица (см.

параграф 1.4), в которой опущен элемент, расположенный в нижнем

левом углу. На это место удобно будет поставить значение квадратного

корня из остаточной суммы квадратов. Так, для нашего примера

получим:

2 3

5-4- Возвести в квадрат для получения суммы квадратов,

«обусловленной свободным членом»

2ч- Возвести в квадрат для получения суммы квадратов, «обус-

ловленной х при данном свободном члене».

| 3 [ч- Возвести в квадрат для получения остаточной суммы

квадратов.

Данный набор чисел получен в результате применения описанной

схемы к матрице

а Ь

т. е.

п

B*)

B*/)

а

4

F)

2*

2ху

Bху) |2?|

Ь

6

58

10

29

A0) B9) 1 C8) I

(Расположенные ниже главной диагонали элементы заключены в

скобки, поскольку в их записи нет необходимости. Они попросту дублируют

значения, находящиеся на соответствующих им позициях выше

главной диагонали.)

J5

Пересчет верхних двух строк, как и раньше, приводит к

2 з

@) 7

A0) B9) |38|ч-В дальнейшем будет заменено

на C8-52-22)^.

Продолжим расчеты и вычтем значение

B,31 5) X 5+ @,7| 2) х 2

из последней строки. Для нас представляет интерес только последний

ее элемент; первые же два элемента равны нулю. В результате 38 будет

заменено на 38 — 52 — 22 -— 9. Вместо 9 запишем теперь квадратный

корень из этого числа, что в итоге даст нам

2 з

@) 7

@) @) |3|

Упорядоченный таким образом массив чисел, в котором все элементы

ниже главной диагонали равны нулю, называется верхней треугольной

матрицей. Как уже отмечалось, в этом случае нет необходимости

записывать элементы, лежащие ниже главной диагонали, или хранить

их в памяти компьютера.

1.4. ХРАНЕНИЕ СИММЕТРИЧНЫХ ИЛИ ВЕРХНИХ ТРЕУГОЛЬНЫХ

МАТРИЦ

В настоящей книге предполагается, что в памяти компьютера

должен храниться в виде упорядоченного массива чисел верхний

треугольник любой симметричной или верхней треугольной матрицы. В случае

когда, как в параграфе 1.3, эта матрица соответствует регрессионному

уравнению со свободным членом, ее строки и столбцы будут

нумероваться 0,1» •••* <7* где </ = р + 1. Предположим, что переменные 1, 2, ...,/?

являются фактическими или потенциальными объясняющими

переменными. Последняя переменная (переменная q) обычно принимается как

зависимая переменная. Элементы матрицы, которые хранятся в

памяти ЭВМ, расположены следующим образом:

@,0) @,1) ... @,9)

A,1) ... A,<7)

(Я, Я)

В параграфе 1.3 q = 2.

16

Потребности в машинной памяти будут минимальными, если эти

элементы хранятся в виде одномерного массива. В этом случае порядок

их расположения определяется так:

1

2

3

q(q+\)/2+2

Таким образом, элемент (/, /) имеет адрес / (/ + 1)/2 + i + 1.

1.5. АЛГОРИТМЫ РАЗЛОЖЕНИЯ МАТРИЦ

В параграфах 1.1 — 1.3 был описан частный вариант алгоритма Хо-

лецкого для решения системы нормальных уравнений, получаемой при

использовании метода наименьших квадратов для парной регрессии.

В последующем обсуждении этот алгоритм мы будем называть

алгоритмом Холецкого полного разложения (АХПР). Поэтому алгоритму

пересчет значений каждой строки массива данных завершается полностью

до внесения каких-либо изменений в элементы последующих строк.

К интерпретации вычислений из параграфа 1.3 теперь можно

подойти следующим образом. Для матрицы

4 6 10

F) 58 29

A0) B9) 38

там фактически была найдена верхняя треугольная матрица Т, такая,

что Т'Т = S. Это разложение, однако, может быть получено с помощью

альтернативного алгоритма нахождения матрицы Т, который включает

те же арифметические действия, что и АХПР, выполняемые в другом

порядке. Этот альтернативный алгоритм в дальнейшем, когда мы

познакомимся с его основными свойствами, будет назван алгоритм

Холецкого последовательного разложения (АХСР) х.

Итак, пусть Т = [*0, tl9 t2]. На первом шаге найдем такое ^0? #э

для которого матрица S —

столбце. Имеем:

имеет нули в первой строке и первом

Г^ОО ^00 ^01 ^00 ^021

Г/1'00 и т. д.

1 Здесь мы выбрали аббревиатуру АХСР (алгоритм Холецкого

последовательного разложения), так как аббревиатура АХПР ранее использовалась для

обозначения алгоритма Холецкого полного разложения. — Примеч. ред.

17

Тогда Цо = 4 дает t00 = 2, t00t01 = 6 дает t01 = 3, t00 t02 = 10 дает

?02=5. Таким образом,

[2 3 5] =

4 6

6 9

10 15

10

15

25

Следовательно,

0 0 О"

О О О

0 0 9

[0 0 3] =

= Т Т\ где Т

что и требовалось получить.

Процедура исключения, описанная в параграфе 1.3, заключается

в приведении матрицы S = Т'Т к виду Т = (T')~1S, что эквивалентно

умножению Т'^1 на исходную матрицу. Матрица Т получена в

результате разложения S по методу Холецкого, или по методу квадратного

корня. Отметим также, что, обозначив через Sx ведущую подматрицу

размерности 2x2 матрицы S, а через Т\ — ведущую подматрицу

размерности 2x2 матрицы Т, получим г

Альтернативные алгоритмы. В только что описанном методе вторая

строка в матрице JJ (помеченная номером 1) изменяется в результате

вычитания 3*6 = *oi*6 еще до формирования t\. Эта операция

аналогична процедуре, использованной в параграфе 1.3. Что касается третьей

1 Матрица М1 меньшего размера называется ведущей подматрицей матрицы

М, если (Afi)^ = Мц. Иногда такую матрицу называют главной. — Примеч. ред.

18

строки (помеченной номером 2), то здесь имеются различия. В

параграфе 1.3 изменения в ней произошли (был вычтен вектор 5^о т 2'J)

только после того, как был сформирован вектор '[. Теперь же порядок

действий будет следующим:

1) формируется t'Q и вычитается (с соответствующим множителем)

из строк 2 и 3;

2) формируется t[ и из строки 3 вычитается 2>i.

Таким образом, последовательный характер этого алгоритма

проявляется в том, что показатели третьей строки изменяются

последовательно на двух этапах вычислений, еще до формирования г2.

Доказательство того, что такой алгоритм всегда работоспособен, отложим на

будущее.

1.6. РАСЧЕТ НА БАЗЕ МАТРИЦЫ ЦСКП

Матрица ЦСКП представляет собой матрицу сумм квадратов и

произведений, рассчитанных относительно средних. Она известна также как

матрица центрированных (или скорректированных) сумм квадратов и

произведений. Для случая, когда имеются только две переменные

х и у, она выглядит следующим образом:

р {x-xf Ъ(х-х)(у-^у) 1 1

[_2 (x-x)(y-jj) 2 (*/- yf J

Заметим, что модель линейной парной регрессии (см. параграф 1.1)

i = l, 2, ..., п

может быть эквивалентно записана как

У1~"у = а' +Ъ {Xi—~x)-\-eu * = 1, 2, ..., л,

где о! --= а — у + Ьх. Если теперь в A.1) и A.2) мы заменим xt на х* =

= Xi — х и yt на у* = yt — уу то а будет заменено на a', a b останется

неизменным. Поскольку Ел:* = 2#* = 0, первое уравнение сведется к

па' — 0, второе же будет выглядеть так:

l±{vc-x)*]b = l (x—x){y-y). F.1)

Отметим, что 2 (х — хJ и 2 (х — х) (у — у) представляют собой

элементы первой строки матрицы ЦСКП. Величины dXXJ дху и ауу

могут быть рассчитаны с помощью, обычных формул центрирования:

бхх = 1> (х—jcJ = 2jc2—nx2y F.2)

бху = 2(х—х)(у—у) = 2ху—пху. F.2')

Аналогично вычисляется и дуу. Отметим здесь, что приведенные

формулы следует применять с некоторой осторожностью; причину этого мы

объясним в параграфе 1.7.

19

Если мы применим схему Холецкого (метод квадратного корня)

к матрице ЦСКП, то получим

А хх

6ху

дху

6УУ

°ху

(дУУ дхх1

Для нашего примера

49

14

14

13

2 ]

raj

Элемент таблицы дисперсионного анализа, обусловленный

свободным членом, должен рассчитываться теперь как ш/2; другие элементы

определяются следующим образом:

Сумма квадратов

обусловленная х и свободным членом

°ху

остаточная

&хх Лх

Для регрессии более чем с одной объясняющей переменной, которые

будем обозначать как хи *2, ..., со свободным членом большинство

расчетов основаны на использовании матрицы ЦСКП, Прежде чем

приступить к рассмотрению множественной регрессии (более чем с одной

объясняющей переменной), обсудим особенности расчета значений дхх и дху.

1.7. МЕТОД, УСТОЙЧИВЫЙ К ВЛИЯНИЮ ПОГРЕШНОСТЕЙ

ВЫЧИСЛЕНИЙ ПРИ ОПРЕДЕЛЕНИИ ЦЕНТРИРОВАННЫХ СУММ

КВАДРАТОВ И ПРОИЗВЕДЕНИЙ

Неосторожное использование формул центрирования {6.2) и F.2')

может привести к значительным потерям в точности вычислений.

Рассмотрим пример. Допустим, дхх = 2 (х — хJ рассчитывается

для переменной, принимающей следующие три значения: 2001, 2002,

2003. Тогда 2х2= 12024014 и пх2 = 12024012. Для ЭВМ, в памяти

которой результаты любых арифметических операций сохраняются в виде

чисел, представленных семью значащими десятичными цифрами (или

их эквивалентом в бинарной, восьмеричной или шестнадцатеричной

системах исчисления), оба этих числа будут храниться в виде 1,202401 • 107

(возможно, некоторая неопределенность будет и в отношении последней

единицы). Результат вычисления дхх по формуле F.2) окажется

неточным тогда по всем значащим цифрам г.

1 В этом случае получится бхх — 0, тогда как в действительности бхх = 2.—

Примеч. ред.

20

Очевидно, что данная проблема возникает в случае, когда первые

цифры 2х2 и пх2 совпадают, т. е. когда эти числа почти равны. Первые

h цифр 2а:2 и пх2 будут идентичными, если их разность составляет

примерно 10-Л 2х2. Тогда дхх ~ 10-Л 2л;2 ~ 1СН* пх2, откуда 10л ~ пх2/

Таким образом, число потерянных десятичных цифр будет равно:

A~21og10 —, G.1)

где дх — \^п-1дхх. В нашем примере х = 2002, дх = 1^2/3, поэтому

Л ~ 6,8 ~ 71.

Решение сформулированной здесь проблемы заключается в подборе

подходящей системы измерения, в которой значение х превосходило бы

величину sx не более чем в 3—4 раза. Приемлемый способ такого

решения может состоять в использовании значения первого наблюдения или

первых нескольких наблюдений для определения рабочей средней d.

Рассчитанные в этом случае значения будут равны

2(x-d) и l(x—d)*.

Тогда

*„= 2 (x-df-n-1 [2 {x-d)]\ G.2)

Аналогичное выражение можно записать и для дХ1п и для любых

других сумм произведений, включающих х. Препятствие использованию

d — х состоит в том, что в этом случае потребуются два прохода по

данным, на первом из которых рассчитывалась бы лс, а на втором

оценивалась бы величина 2 (х — хJ. Однако можно предложить формулы,

требующие лишь одного прохода, при которых на каждом этапе

определяется средняя для просмотренного на нем массива наблюдений, а

также соответствующие значения сумм квадратов и произведений,

рассчитанные относительно текущих средних.

_ k _ .«•

Адаптивные формулы. Положим *<*>:=-&-1 ^ хг и^<*> = Л-12 Hi

i=-- \ i = I

в качестве средних для первых k взятых точек. Определим также

2

«= 1

?%Л G.3)

1 Таким образом, в результате ошибок округления, обусловленных формой

представления чисел в машинной памяти, погрешность в вычислениях возрастает

в данном случае примерно в 107 раз. — Примеч. пер.

2J

и аналогично для sfj. Тогда можно показать, что

G.4)

Эти формулы в такой форме приводятся в [122]. Их точность выше,

чем при применении G.2) и других аналогичных формул, за

исключением случая, когда в G.2) удается использовать рабочую среднюю d,

значение которой близко к величине истинной средней 1с. Если d близко

к jc, то формула G.2) будет давать более высокую точность вычислений,

поскольку при ее использовании совершается меньше арифметических

операций.

1.8. МНОЖЕСТВЕННАЯ РЕГРЕССИЯ — МАТРИЧНАЯ ФОРМУЛИРОВКА

Пусть у является п х 1 вектором фактических значений, а X — /гх

X (р + 1)-матрица, в строках которой представлены «наблюдения».

Обозначим через b вектор параметров (p+l)xl, т. е. коэффициентов

регресеия. Задача метода наименьших квадратов состоит в нахождении

вектора Ь, минимизирующего сумму квадратов отклонений, е = у —

— ХЬ, т. е. е'е = (у — ХЬ)'(у — ХЬ). Этот минимум достигается для

вектора b (или векторов Ь, если он определен неединственным образом),

который находится из решения системы нормальных уравнений

X' ХЬ-Х'у,

что будет доказано в параграфе 1.11.

Для случая парной линейной регрессии из параграфа 1.1

(8.1)

, У =

Ли-

, b===

Из уравнений (8.1) получаются A.1) и A.2). Если каждый элемент

%i заменить на xt — х, a yt — на yt — t/, то система Х'ХЬ = Х'у тогда

примет вид

« о ire'ir о 1

O Z(x-xf\[b J [Z(x-X)(y-y) \'

что эквивалентно записи, использованной в параграфе 1.6.

22

В более общем случае предположим, что модель регрессии имеет

вид

ei(i=l, 2, ... п), (8.2)

где xi0 тождественно равно единице. Таким образом, у нас имеются п

значений tjtwp объясняющих переменных хъ х2У ..., хр. В этой

формулировке

У =

Уг

Уп

Д =

1

хп

Xni

. . . Xj p

• • • х2р

... хпр

(8.3)

Все величины, необходимые для решения системы нормальных

уравнений, можно получить, опустив последнюю строку из матрицы сумм

квадратов и произведений (СКП):

Ly х у у j

Расчеты на базе матрицы ЦСКП. Более предпочтительна следующая

запись множественной регрессии:

(8.4)

р

где b'0 = b0—y+ 2 biXj,

1

Заменим теперь X на

и у — на у, где

¦V

— Х1

... Xip—;

Ух—У

Уг—У

-У -

Тогда система нормальных уравнений может быть записана как

О

п 0 ... (Г

О

• Х'Х

О

¦*;¦

откуда nb'0=0 и

Х'ХЬ = Х'у,

(8.5)

(8-6)

23

где

Ь =

Отметим, что коэффициенты и правую часть системы нормальных

уравнений (8.6) можно получить из матрицы ЦСКП, опустив последнюю

строку, т. е.

[X, уГ [X, у] = [Х'* Х'У1. (8.7)

Ly х у у J

Коэффициент Ьо в регрессии, записанной в виде (8.2), можно рассчиг

тать в конце по формуле

(8.8)

Матрица ЦСКП представляет собой удобную и естественную базу

для осуществления различных вычислений в рамках теории систем

многомерных нормальных уравнений 1. Такие вычисления хорошо

интерпретируются и с позиций множественной регрессии.

Модельная матрица. Было бы удобно дать матрице X какое-нибудь

название. Термин план-матрица подвергался критике [125].

Воспользовавшись предположением О. Кемпторна, назовем X модельной

матрицей.

1.9. МНОЖЕСТВЕННАЯ РЕГРЕССИЯ. ПРИМЕР

Имеются четыре набора значений для каждой из переменных хъ

х2 и у. Справа от них приводятся значения хх — хъ х2 — х2 и у — у:

х%

—2

—1

2

7

Средняя 1,5

х2

0

2

5

3

2,5

у

—3

1

2

6

1,5

Хх—хх

—3,5

—2,5

0,5

5,5

Х2~Х2

—2,5

—0,5

2,5

0,5

у —у

-4,5

—0,5

0,5

4,5

1 Как следует из предыдущего параграфа, расчеты, основанные на матрице

ЦСКП, будут действительно точнее, чем расчеты, основанные на матрице СКП.

Зато во втором случае, в отличие от первого, проще находить дисперсию

свободного члена регрессии, дисперсию прогноза и т. п. — Примеч. ред.

24

Используя обозначения из параграфа 1.8, найдем для этого примера

матрицу ЦСКП:

[X, у]' [X, у] =

-ьх ь%

49 14 42

. 13 15 Г

. . 41 J

Вместо элементов, расположенных ниже главной диагонали, значения

которых совпадают с величиной соответствующих им элементов,

стоящих выше диагонали, проставлены точки.

Воспользовавшись полной формой (см. параграф 1.5) схемы

исключения, получаем:

49 14

. 13

42

15

Разделим строку 1

на /49

7 2

. 13

15

7

0.

Вычтем 2х (строка 1) из строки 2

Разделим строку 2

на

V9"

7 2

0 3

о

1411

Вычтем F X (строка 1) -Н X (строка 2)) из строки 3

^ Разделим строку 3 7 2

1

V4

0 0 |4|

Таким образом, система нормальных уравнений

49 141IA1 Г42]

¦и 13J|aJ L is J

сводится к системе

1озШ'] = [|}

О 3

0 0 |2|

(9.1)

Отсюда получаем b.z = 1/3; 76, + 2b2 = 6 и bt — 16/21. Свободный

член находится из формулы (8.8):

bo=y—b1xl—й2х, = 3—Aб/21)х 1,5 — A/3) Х2,5=—10/21.

25

Поскольку расчеты базировались на матрице ЦСКП, элемент таблицы

дисперсионного анализа, обусловленный присутствием свободного

члена, в верхнем треугольном массиве чисел не представлен. Его величина

должна определяться так: пу2 — 4-1,52 = 9. Элементы остальной части

этой таблицы берутся из последнего столбца верхней треугольной

матрицы. Таким образом, получаем:

7 2 6^-Возвести в квадрат для получения СК, обусловленной хх при

данном свободном члене.

О 3 1-«-Возвести в квадрат для получения СК, обусловленной х2 при

данном хх и свободном члене.

О 0 2-<-Возвести в квадрат для получения остаточной СК.

(СК — сумма квадратов.)

Эти значения являются элементами таблицы дисперсионного анализа,

построенной на основе последовательной схемы (см. параграф 2.1).

Сравнение с использованием матрицы СКП. Для нашего примера"

матрица СКП [X, у]' [X, yl будет равна:

4

6

58

10

29

38

6

51

30

|50|

При использовании метода разложения Холецкого эта матрица

преобразуется следующим образом:

2 3 5

0 7 2

0 0 3

3-<-Возвести в квадрат для получения СК, обусловленной

свободным членом.

6<-Возвести в квадрат для получения СК, обусловленной

хх при данном свободном члене.

1 «-Возвести в квадрат для получения СК, обусловленной

х2 при данном свободном члене и Х\.

0 0 0 |2|-<-Возвести в квадрат для получения остаточной СК.

Система нормальных уравнений записывается теперь так:

2

0

0

.3

7

0

5"

2

3

"V

h

и

Р

Единственное отличие данной системы от (9.1), базирующейся на

матрице ЦСКП, заключается в том, что теперь у нас имеется первое

уравнение (которое будет использовано нами последним), позволяющее

Определить Ьо:

260 + 3^+5^ = 3.

26

В общем случае оно имеет вид

Vnbo+(Vn х^Ьг

Если разделить все его члены на ТЛг, то получим уравнение,

идентичное (8.8) из параграфа 1.8.

1.10. РАСЧЕТЫ НА БАЗЕ КОРРЕЛЯЦИОННОЙ МАТРИЦЫ

Регрессионная модель может быть записана также в виде

2 ]^

т.е.

(юл)

2 A0.2)

где ft* связано с определенным ранее ft; соотношением

Нетрудно видеть, что минимизация е* эквивалентна минимизации et.

Показатели Ь* известны как стандартизированные коэффициенты

регрессии, иногда их называют бета-коэффициентами.

Матрица ЦСКП для модели A0.2) как раз и представляет собой

матрицу сумм квадратов и произведений для хц и г/*, т. е.

корреляционную матрицу. Достоинство работы с корреляционной матрицей состоит

в том, что теперь оценки метода наименьших квадратов и их

характеристики не зависят от масштаба измерения исходных данных.

Различные величины, получаемые в ходе вычислений, которые мы собираемся

использовать в дальнейшем, при этом довольно просто

интерпретируются 1.

Элементы rtj корреляционной матрицы легко получаются из

элементов 6ij матрицы ЦСКП на основе формулы ro= dij/Vdadjj.

Таким образом, нет необходимости вычислять значения x*j и у*.

1 Стандартная интерпретация коэффициента bj в регрессии (8.2) такова:

bj показывает, на какую величину изменится у, если фактор Xj изменится на 1 его

измерения при условии, что остальные факторы остаются без изменения. Таким

образом, bj имеет размерность отношения: (размерность у)/ (размерность xj).

В этом смысле по bif ..., bp трудно судить о влиянии факторов хъ ..., хр на у,

поскольку они могут быть измерены в разных единицах и, в частности, могут быть

разномасштабны. Бета-коэффициенты 6/ лишены этого недостатка: с их помощью

исследование степени влияния факторов более оправдано. — Примеч. ред.

27

Для данных из параграфа 1.9 корреляционная матрица,

рассчитанная с точностью до трех значащих цифр, выглядит так:

= УЩ49~ 0,915,

~ 1,776.

Применяя к ней схему исключения, получаем:

1,0 0,555

0 0,832

0,937ч-Возвести в квадрат для получения доли в ОСК,

которая обусловлена Х\.

0,156ч-Возвести в квадрат для получения доли в ОСК,

бй

р у

обусловленной х2 при данном Х\.

В

"Возвести в квадрат для получения остаточной

О О |0, О\ 2\*4— nnnu OCR.

ОСК — общая сумма квадратов (относительно средней). Нормальные

уравнения таким образом, имеют вид

1 0,5551 Г*П Г0,

0 0,832 J I fe* J [0,

_ -937

jo 0,832.11 6* J~ [о

откуда находим

Ь\ =0,188 (раньше Ъ% ~ 0,33),

Ь* = 0,833 (раньше Ьх ~ 0,76).

Построенная по последовательной схеме дисперсионная таблица

имеет следующий вид:

Сумма квадратов

обусловленная свободным членом пу2 = 9

обусловленная *, (при данном свободном о 9372 х <*иУ = 36

члене)

обусловленная х2 при данных свободном чле- о 1562х<*ии=1

не и Х\

Остаточная сумма квадратов 0,3122 хдуу = 4

1.11*. ТЕОРИЯ: НОРМАЛЬНЫЕ УРАВНЕНИЯ

Вывод нормальных уравнений здесь будет основываться на

использовании ортогонализации Грама — Шмидта для нахождения

ортогонального базиса в евклидовом векторном пространстве г.

Ортогонализация Грама — Шмидта, ^Подпространство п-мерного

пространства Еп, натянутое на столбцы"х0, xlf ..., хр матрицы X, бу-

1 Проще получить нормальные уравнения, приравнивая частные

производные суммы квадратов е'е по bj к нулю. — Примеч. ред.

28

дем называть пространством столбцов матрицы X. Предположим

вначале, что х0, хь ..., хр линейно-независимы (это ограничение

впоследствии будет снято). Тогда найдется ортогональная последовательность

ненулевых векторов v0, vx, ..., vp, которая порождает то же

подпространство Еп, что и последовательность х0, xlt ..., хр. Векторы v0, ...,v7,

будем строить по формуле

vj = x}— 2 си^= 2 huxi9 /=0, 1, ..., р, A1.1)

где А#=1, ^и=—си для i</.

Для доказательства предположим, что ортогональные ненулевые

векторы v0, vb ..., vfc_,, вид которых определяется из A1.1), уже

построены. Следовательно, v0, vT, ..., vfe_x натянуты на то же

подпространство, что и х0, хь ..., Xfcel. Способ, который будет сейчас применен

нами для построения вектора vft, определяемого выражением A1.1), и

такого, что v/vfe = 0 для / <; k называется ортогонализацией Грама —

Шмидта. А именно положим

Таким образом, \k имеет вид, определяемый A1.1). Кроме того, \к

так как в противном случае хк представлял бы собой линейную

комбинацию v0, у1э ..., vft_x и, следовательно, х0, х1э .„, xj-.lf что противо-

речит предположению о линейной независимости х0, х1э .., хк~г.

Доказательство завершается проверкой того, что \]\к = 0 для / <. к.

Если векторы Х/,/^0,1,..., р, не являются линейно-независимыми,

произойдет лишь одно изменение, состоящее в том, что в A1.2) у/

могут принимать и нулевые значения. Такой нулевой вектор не

включается в ортогональный базис, а следующий ненулевой вектор v^

становится на его место. В результате получаем ортогональный базис v0, vlf ...,

V/, состоящий из / < р элементов.

Ортогонализация Грама — Шмидта в матричной форме. Пусть V =

^ Ivo». v*f_i#M v*l» г^е ' < Р- Выше было доказано, что столбцы

матриц X и V порождают одно и то же подпространство. Таким образом,

получаем X = VG и _V = ХИТ при соответствующем подборе матриц

G и Н. Отметим, что хк, в силу A1.2J, является линейной комбинацией

29

Vj только для / = 0, 1, ..., k. Следовательно, G представляет собой

верхнюю треугольную матрицу.

Проекция на пространство столбцов матрицы X. Пустьу — любой

вектор в Еп и пусть

У = jL I ~~ I Vj= V d, где d имеет, элементы dj =

/<k\ v; v;- /

= У'Ъ/У/Ъ, (П.З)

-XHd = Hl>, гдеТ)=НA. A1.4)

Тогда из A1.3) следует

так что у' V = y' V.

Отсюда получаем

"у'Х=у' VG = y' VG = y'X. A1.5).

Нормальные уравнения. Из A1.4) имеем у = X Ь. Поэтому, как

следует из A1.5),

X'XtT-X'"^-^'"^, A1.6)

что доказывает существование вектора Ь, удовлетворяющего системе

нормальных уравнений A1.6). Запишем теперь ~ё = у — ХЬ и найдем

IIе И = ||е||2 = У (е'е). Сейчас будет показано, что ||е||2 обраишется в

минимум, если b удовлетворяет системе нормальных уравнений X' ХЬ=

= Х'у-

Предположим, b такое, что X' X Ь= X' у, т. е. X' (у—Xb) = 0.

Запишем: ё = у—ХЬ = у—X ? + 5ГЬ~ — X Б. Тогда, поскольку

Х'(у~хБ) = 0, получаем Цё^Иу—X? ||2+Ц X?-Xb|f >

Как видим, последнее неравенство обращается в равенство тогда и толь-

ко тогда, когда ХЬ = ХЬГ Отсюда также следует, что Х'ХЬ = Х'у.

Алгоритм для определения b может основываться на уравнениях

A1.3) и A1.4). Однако на практике исследователи обычно вместо

непосредственного использования этих уравнений предпочитают применять

30

модифицированный алгоритм Грама — Шмидта (МГШ), при котором

описанные операции осуществляются в другом порядке. Этот алгоритм

будет обсуждаться в гл. 4.

Существование разложения Холецкого Х'Х. Доказательство

существования верхней треугольной матрицы Тр, такой, что ТГРТР = Х'Х,

следует из представления матрицы X в виде X = VG, где столбцы

матрицы V взаимно ортогональны, a G есть верхняя треугольная матрица.

Тогда

X'X=G'V' VG=GDG-(GD/2)'GD1/2,

где D = V'V и D1/2 — диагональные матрицы, причем диагональные

элементы D1/2 представляют собой квадратные корни из

соответствующих элементов D1.

1.12*. ТЕОРИЯ РАЗЛОЖЕНИЯ ХОЛЕЦКОГО

Существование разложения Холецкого — второе доказательство.

Пусть X — действительная матрица и8= Х'Х. Здесь и в следующей

главе обозначаем Х = [Х, у] или Х = [Х, yl (эти обозначения были

введены в параграфе 1.8). Будем считать, что столбцы матрицы X и,

следовательно, строки и столбы матрицы S, пронумерованы от 0 до q.

Алгоритм из параграфа 1.5 определяет последовательно для k ~

— 0,1, ..., матрицы S(ft) с нулями в строках и столбцах 0,1,..., k по

формуле

Таким образом, можно записать:

01 0

с S

Э(Ь — П =

, строки с 0 до k— 1

Sr7~ Sb ib \\

0

Доказательство существования разложениях Холецкого будем вести

по методу индукции. Предположим, что S<fc-j> является положительно

полуопределенной матрицей, такой, что c'S(ft>_1)C >0 для всякого

действительного вектора с. Докажем тогда, что:

1) пусть s<*-l> > 0. Если sj&-1)==0, TO

1 Нетрудно проверить, что матрица GD1/2 является верхней треугольной,

поэтому можно положить Тр = GD1/2. — Примеч. пер.

31

s^(A,_1)=0 (см. доказательство, приведенное ниже);

2) пусть s{kkk~ 1)>0. Построй^ th путем деления всех элементов

столбца k матрицы S(k- i) на ^fefe==(s(^~1)V/2. В остальных случаях

полагаем th = O- Тогда матрица S(^) =S(^_i) — ^fe ^^ имеет нули в строках

и.столбцах с номера 0 по k и c'S^c^O для каждого

действительного вектора с (доказательство также приведено ниже).

Приступая к доказательству, заметим сначала, что с' Sc

представляет собой сумму квадратов элементов с'Х' и, следовательно, никогда

не может быть меньше нуля.

Для доказательства пункта 1 положим с' = [0, ..., О, ск, с'ъ]. Тогда

очевидно, что

_i) -t-clS(*_i)C2. A2.2)

Из предположения, что с2 = 0, немедленно следует, что s^"l)^0.

Предположим теперь, что з**)=0, тогда s^(fe_.i> ^= 0 допускает

выбор с2, такого, что с'2 $k(k-\) ФО. Отсюда получаем

Ск = BC9 1k(k-\ ))~1 ( — 1 —"С2 S(a- 1) С2),

а значит, c'S<fc_1)C = — 1, что противоречит сформулированному

выше условию.

Для доказательства пункта 2 достаточно показать, что с' S(ft)C > 0

для любого действительного вектора с. Предположим противное, т. е.

что с7 S(ft)c < 0 для некоторого вектора с. Тогда из A2.1) следует

Если tkk = 0, то в соответствии с пунктом 1 th = 0 и c'S^-j) с < 0, что

снова противоречит сформулированному выше замечанию. Пусть 0

Заметим, что выбор ск не влияет на с' S(fe) с. Поэтому, выбирая

получим c'^fe —0, и следовательно,

с' X('*_i) Х(л— 1) с^с' S(jfe) c<0,

что опять противоречит сформулированному выше условию.

32

Третье доказательство можно найти в параграфе 3.3. Кроме того,

любой из рассматриваемых в гл. 4 алгоритмов ортогонального

приведения матрицы X к верхней треугольной форме может быть использован в

качестве основы для доказательства существования разложения Хо-

лецкого Х'Х.

Свойства разложения Холецкого. Пусть S = Т'Т, где Т —

верхняя треугольная матрица, и предположим, что

Ls;2 sj' L о tJ

Тогда, записав Т'Т = S в терминах подматриц, имеем

Thfu=rSu, A2.3)

Ti.f^Stt, A2.4)

ва^^Ти+ТиТя. A2.5)

Теперь рассмотрим

Г*

S

'.У'Х y'yj L0'

Тогда A2.3) означает, что "t;f р = Х'Х, а A2.4) — что f'piy = Х'~у.

Следовательно, предполагая, что Тр — невырожденная матрица с

учетом A2.3), получим

Тр)-1Ту^у'Х(Х'Х)-{Ту. A2.6)

Из A2.5) следует

т. е. с учетом A2.6)

e^-y'y-tH^yy-P'XtX'Xj-'Xy. A2.7)

Последнее значение равно остаточной сумме квадратов в методе

наименьших квадратов, т. е. (у — ХЬ)' (у — ХЬ). Если за начальную

точку отсчета принято среднее каждого столбца, т. е. вместо матрицы

[X, у] используется матрица [X, у], то уравнение A2.7) должно быть

заменено на

^=У'у-у'Х(Х'Х)-1Х'у A2.8)

(см. упражнение 6 в конце главы).

2 Зак. 1078 33

1.13. ДИСПЕРСИЯ И КОВАРИАЦИЯ ОЦЕНЕННЫХ КОЭФФИЦИЕНТОВ

РЕГРЕССИИ

Детали расчетов будут рассмотрены в гл. 2. Здесь же мы

остановимся на основных моментах и обозначениях. Прежде всего хотелось бы

подчеркнуть отличие теоретической модели

y=XJ3+e, A3.1)

где р — вектор неизвестных параметров, от подогнанной модели

y-Xb+i, A3.2)

где b — оценка р, полученная с помощью метода наименьших квадратов.

Относительно элементов elf e2, ..., гп вектора е предполагается, что они

независимы и имеют нормальное распределение со средней 0 и

дисперсией а2, т. е.

а2, если i = /,

О, если i Ф /.

Тоже справедливой для cov (yt,yj). В матрице

дисперсий-ковариаций var (у) элемент, соответствующий (*, /), равен cov (//*, у})\ таким

образом, можно записать: var (у) = o2ln. Используя соотношение

var(Ay) = Avar(y)A/ A3.3)

и положив А = (X'XJ-^X', найдем матрицу дисперсий-ковариаций

для вектора Ь, определяемого системой нормальных уравнений Х'ХЬ =

= Х'у:

var(b) = (X/X)-1a2. A3.4)

Здесь предполагается, что матрица X имеет полный ранг по столбцам,

поэтому матрица Х7Х невырождена. Таким образом, получаем

следующую таблицу дисперсий-ковариаций:

Ь9 ... b

р

Представленные

здесь значения

являются

элементами матрицы

Теперь предположим, что регрессионное уравнение включает

свободный член, поэтому первый столбец в X состоит из единиц. Тогда

нормальные уравнения могут быть альтернативным образом переписаны в

34

виде X'Xb = Х'у, где для измерения показателей каждого столбца

матрицы [X, у] используется шкала, на которой за начальную точку

отсчета принято значение средней данного столбца. Последнее матричное

уравнение может быть заменено на

Х'ХЬ-Х'у, A3.5)

где у заменен на у. Действительно, /-й элемент Х'у отличается от /-го

элемента Х'у на величину у х (сумма элементов /-го столбца матрицы

Х) = */ХО. Поэтому мы можем заменить вектор у, имеющий

коррелирующие элементы, на у, элементы которого уже не коррелируют. Из

уравнения A3.5) теперь не трудно получить матрицу

дисперсий-ковариаций для Ь:

var(b)-(X'X)-1(T2.

Таким образом, таблицу дисперсий-ковариаций можно записать в виде

>\

Представленные здесь

значения являются

элементами матрицы

(Х'Х)!2

Из сравнения этой таблицы с таблицей, полученной на базе уравнения

A3.4), становится очевидным, что матрица (Х'Х)-1 может быть найдена

вычеркиванием первой строки и столбца из (Х'Х)". Данное

утверждение можно доказать и непосредственным образом.

1.14. КОЭФФИЦИЕНТ ДЕТЕРМИНАЦИИ

Используя обозначения из предыдущих параграфов, запишем:

t\y= У' У -У' * (Х'Х)-1 Х'у, A4.1)

что представляет собой один из вариантов формулы остаточной суммы

квадратов (ОСК) для случая, когда у регрессируется на столбцы

матрицы X, в которой первый столбец состоит из единиц. Определение

матрицы X, в которой столбцов на единицу меньше, чем в X, и вектора у

приведено в параграфе 1.8; при этом значения в каждом столбце

представляют собой величины отклонений от средней. Для доказательства

A4.1) см. упражнение 6 в конце данной главы. Заметим, что

У У ~~дуу = общая сумма квадратов отклонений (ОБСК)

относительно средней;

у'Х (Х'Х)~хХ'у —сумма квадратов (СК) регрессии.

2* 35

Тогда коэффициент детерминации определяется как квадрат

коэффициента множественной корреляции и вычисляется как

R'y(\...P) = (СК регрессии)/ОСК.

Он может рассматриваться как доля общей суммы квадратов, которая

объясняется регрессией г. Тогда уравнение A4.1) может быть записано

в виде

ОСК-ОБСК—СК регрессии = ОБСК-A—/?;A...Р)).

Таким образом,

Оценку силы рассматриваемой взаимосвязи лучше, однако, определять

на основе доли объясняемой средней суммы квадратов. Основанием для

такого утверждения служит интерпретация средних сумм квадратов в

качестве оценок дисперсии. Если в матрице X имеется п строк, средняя

сумма квадратов для у равна (п — I) дууу в то время как остаточный

средний квадрат равен (п — р — I)" tyy. Таким образом, доля

объясняемой ОБСК представляет собой скорректированную статистику R2:

Ку(\ .p)=^i — =1 "(I Ку{\ ..р)),

(n~\)-1syy п—р—\

которую мы называем скорректированным коэффициентом

детерминации 2.

1.15. УПРАЖНЕНИЯ

1. Рассмотрим следующий набор значений:

*1 Х2 У

О 1 О

5 3 5

0 4 7

5 6 8

Постройте: а) матрицу СКП; б) матрицу ЦСКП; в) корреляционную матрицу.

Для каждой из этих матриц сформируйте разложение Холецкого. В каждом

случае проводите вычисления, необходимые для определения коэффициентов

регрессии у на хг и х2 (со свободным членом).

1 Критика интерпретации R2 как доли объясняемой дисперсии зависимой

переменной в регрессии изложена в работе [236]. — Примеч. ред.

2 Скорректированный R2 имеет меньшее смещение по сравнению с обычным

коэффициентом детерминации особенно в условиях малой выборки, т. е. когда

п — р — 1 мало. — Примеч. ред.

36

2. Рассмотрим следующий набор значений:

хх х2 х2 у

— 10 10

3 0 10

2 _2 —2 —2

— 2—1 1 1

-1 1 —1 —1

3 3 13

2 2 2 4

_2 —1 —1 —2

2 113

Легко подсчитать, что матрица ЦСКП [ X, уП X, у) будет равна:

Г36 12 6 18"

. 20 10 22

• • 14 20

. . . 40

Используйте схему исключения, приведенную в параграфе 1.9, для определения

верхней треугольной матрицы Т, такой, что Т'Т = S. Выпишите для каждой

переменной компоненты таблицы дисперсионного анализа. Определите коэффициенты

регрессии.

3. Расчет регрессии у на хх и х2 проведен на основе корреляционной матрицы,

определенной в параграфе 1.10. Покажите, что при использовании обозначений

из параграфа 1.10 уравнение регрессии может быть записано в виде

где

ГУ\

Запишите аналогичную формулу для Ь\.

4. (Продолжение упражнения 3). Как и в параграфе 1.10, таблица

дисперсионного анализа заполняется компонентами общей суммы квадратов относительно

средней, объясняемой введением каждой новой переменной. Покажите, что доля,

объясняемая хг равна г\у, в то время как доля, объясняемая введением *2,

составляет A —Гу\)Гд2.\. Как изменятся эти показатели, если в качестве первой

переменной взять дг2, а в качестве второй — х{? (Замечание. В гл. 3 ryl 2 будет

интерпретироваться как частный коэффициент корреляции между у и хх при постоянном

б. Пусть [X, у] и [X, у] определяются, как в^ параграфе 1.8, и пусть Т

является верхней треугольной матрицей, такой, что Т'Т = [X, у]' [X, у]. Покажите,

что верхняя треугольная матрица Т, такая, что Т'Т —[X, у]' [X, у], может быть

получена исключением первой строки и столбца из Т.

37

6. (Продолжение упражнения 5). Пусть, как и в параграфе 1.8, Ь= .°

представляет собой вектор коэффициентов регрессии, определяемых

уравнениями метода наименьших квадратов. Покажите, что

где 1 —единичный вектор размерности п х 1 (см. (8.4) и (8.8)). Выведите отсюда,

что у — ХЬ = у — ХЬ, и, используя (8.6), покажите, что остаточная сумма

квадратов может быть записана как у'у — у'X (Х'Х)—1 Х'у.

7. Пусть матрица S представлена в виде S = ТТ, где Т — верхняя

треугольная матрица. Покажите тогда (используя подстрочный индекс 0 для обозначения

первой строки и столбца), что

где для i > 0

*"""""/ = о U)

i — l \

ffj ~ I S,'j ^ tutlj] tjl1 , j > 1 .

(Предполагается, что /^ не равно нулю.) Если мы потребуем, чтобы /ц > 0, то

матрица Т единственна. Эти формулы описывают АХПР (см. параграф 1.5).

8. Запишем X — [х0, xt xg\. Пусть \k = [х0, хг, ..., xk]. Пусть ТЛ —

ведущая подматрица равномерности (k-^верхней треугольной матрицы Т, для

которой Т'Т = X' X. Пусть Р^ = Х^ (Х^Х^)—1 Х^' (предполагаем, что Х^Х^

имеет обратную матрицу). Покажите, что:

в) tlk--x'k (I — -Pfc-i) х^ и представляет собой сумму квадратов элементов

вектора (I — РЛ_,) xft;

г) tlk = 0 тогда и только тогда, когда xk = f*k-i xk- Выведите, что tkk = 0

тогдг и только тогда, когда х^ представляет собой линейную комбинацию

предыдущих столбцов матрицы X.

(Замечание. х^-^Х^_1С влечет P^-iX^ — x^, наоборот, Xh = Vh-ixh может быть

записано как х^Х^с, где с (Х^_ j Х^-!)-1 Х^_ j х^.)

9. (Продолжение упражнения 8). Пусть

38

Q i. . I Л ibk

Докажите, что, если Т*-1 = Т/г—1, то Tk — Jk *> что имеет место при следующих

условиях:

а) tkk = t^\

б) 7*=— Tk~]lhtkk.

Покажите тогда, то если в матрице Т ни один диагональный элемент не равен

нулю, то матрица Т-1 всегда существует. Приведите схему для расчета матрицы

Т-, основанную на а) и б) (см. также параграф 2.3).

10. (Продолжение упражнений 8 и 9). Покажите, что

а) tk = T&—iSk, где s/^ -= Х/г— 1 х^;

б) 'l* = sAfc~~t* *ь» ГДе Sfcfe^XfeXfe-

Упражнение 8 г) означает, что если один из столбцов матрицы Хй_х не является

линейной комбинацией предыдущих столбцов и Jh-i представляет собой верхнюю

треугольную матрицу, такую, что T^—iT^^j = X*_i Xft_x, то 1ц ф 0 (/ = 1,2,

..., k—1) и матрица Tfe_j существует. Покажите, что соотношения а) и б)

определяют матрицу Т^, такую, что T^Tft= X^X^. Предполагая, что среди столбцов

матрицы X нет линейно зависимых, докажите, что всегда возможно определить

верхнюю треугольную матрицу Т, такую, что Т'Т = Х'Х. (Следовательно, в

дополнение к АХПР и АХСР, существует третий метод построения матрицы Т).

11. Пусть S — действительная, симметричная,

положительно—определенная матрица, и

— ведущая подматрица размерности (k + l)-(&+ 1). (Это предположение

аналогично предположению S = X' X для некоторой матрицы X в упражнениях

8—10.) Модифицируя рассуждения из упражнения 9, докажите существование

матрицы Т, такой, что Т'Т = S. (Если s^k — Ш& <^ 0 с t^ = T^Zisfe, то при

соответствующем подбореЪ получим h' Sfth < 0. Возьмите h = (SiT— l sft, hk) и т. д.)

12. Докажите, что S является положительно-определенной, симметричной

матрицей тогда и только тогда, когда для некоторой матрицы X она может быть

записана в виде Х'Х.

13. Предположим, что у = ХЬ + е, где b выбрано так, чтобы минимизиро-

вать е'е. Докажите, что: а) Х'е = 0; б) у'е = 0.

14. Пусть X* —матрица размерности п х Ц, такая, что Х*'Х* = А2, где Д —

диагональная матрица. Пусть X = X* U, где U — верхняя треугольная матрица.

Покажите, что верхняя треугольная матрица, которая получается при

разложении Холецкого матрицы Х; X, представляет собой, с точностью до изменения

знака всех элементов в одной или нескольких строках, AU. Этим свойством можно

воспользоваться при генерировании матриц X, таких, что И представляет собой

разложение Холецкого Х'Х.

Глава 2

РАСЧЕТ РЕГРЕССИИ. Часть II

В этой главе обсуждаются вопросы, связанные с расчетом некоторых

характеристик, сопутствующих вычислению коэффициентов регрессии.

Здесь будут рассмотрены также следующие проблемы: выбор

объясняющих переменных в регрессии, включение в компьютерные программы

средств контроля, эффект наличия линейной или близкой к линейной

связи между объясняющими переменными, альтернативные алгоритмы

решения системы нормальных уравнений, взвешенный метод

наименьших квадратов.

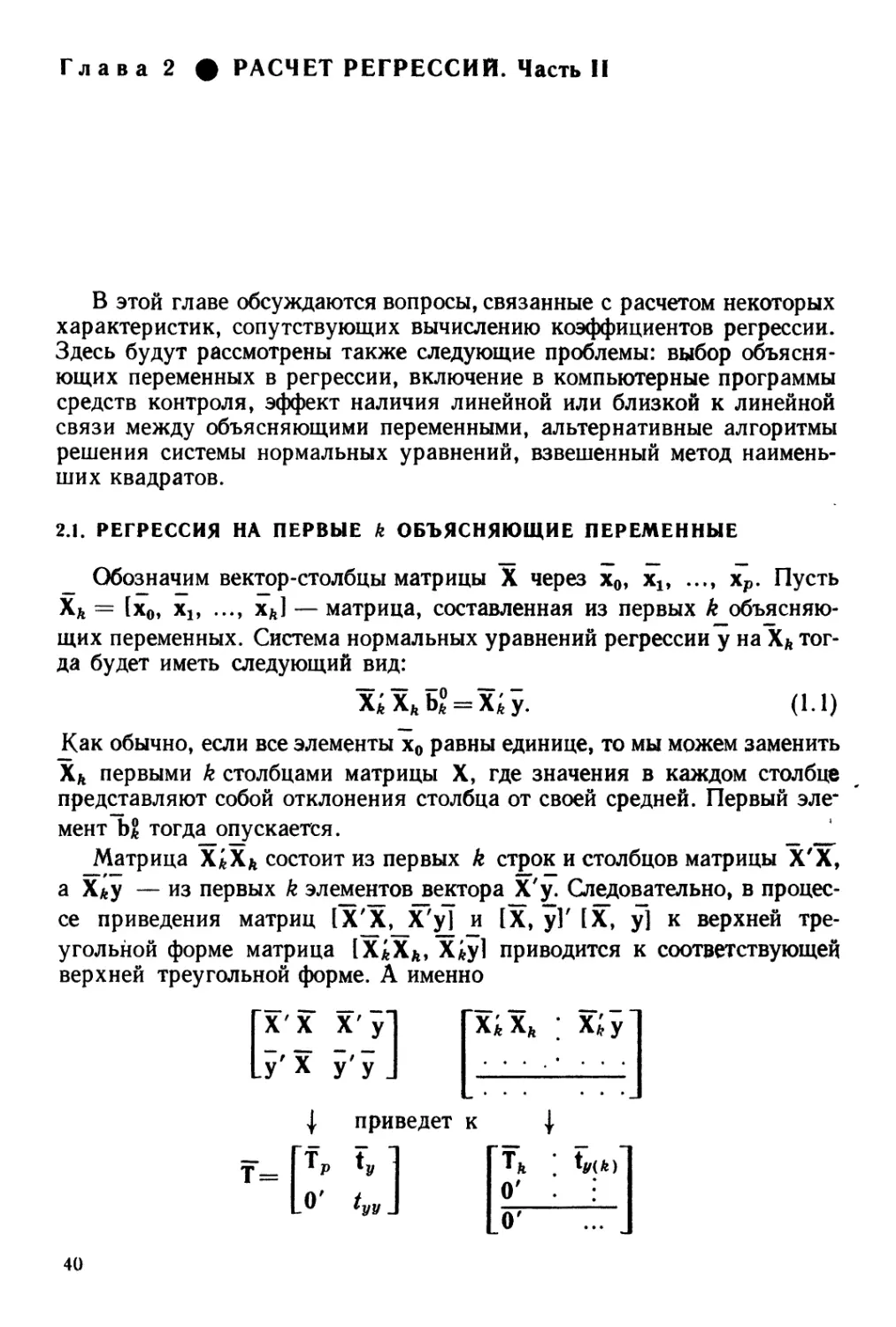

2.1. РЕГРЕССИЯ НА ПЕРВЫЕ к ОБЪЯСНЯЮЩИЕ ПЕРЕМЕННЫЕ

Обозначим вектор-столбцы матрицы X через х0, xlt ..., хр. Пусть

X* = fx0, xi> •••» х*1 — матрица, составленная из первых k

объясняющих переменных. Система нормальных уравнений регрессии у на!сЛ

тогда будет иметь следующий вид:

х;хЛБ*° = х;у. A.1)

Как обычно, если все элементы х0 равны единице, то мы можем заменить

ХЛ первыми k столбцами матрицы X, где значения в каждом столбце

представляют собой отклонения столбца от своей средней. Первый эле*

мент Ъ% тогда опускается.

Матрица Х*ХЛ состоит из первых k строк и столбцов матрицы Х'Х,

а Х*у — из первых k элементов вектора Х'у. Следовательно, в

процессе приведения матриц 1Х[Х,_Х"'у| и [X, у]'[X, у] к верхней

треугольной форме матрица lX*Xft, Х*у] приводится к соответствующей

верхней треугольной форме. А именно

[Х'Х X'yl

1УХ y'yj

л/»

приведет к

21

О'

40

Система нормальных уравнений A.1) сводится таким образом к

Т*Ь2 = Г,(Л). A.2)

Решение уравнений A.1) для любого k находится из решения

соответствующей системы уравнений с верхней треугольной матрицей Тк.

Последовательное рассмотрение элементов таблицы дисперсионного

анализа. Мы можем теперь обосновать порядок формирования клеток

таблицы дисперсионного анализа, приведенной в параграфе 1.9 и в

следующих за ним. Как и при выводе уравнения A2.7) в гл. 1, заменив

X на Xft, можно показать, что остаточная сумма квадратов в регрессии

у на столбцы матрицы Xk будет равна:

У' У— У' Xfe (Х^Х*)^* у- у' у — 1у(к) Tyik).

В регрессии на столбцы матрицы ХЛ+1 вектор ty (ft) должен быть заменен

на ty(k-j-i)- Эти Два вектора идентичны, если не учитывать того факта,

что ty (ь+1) имеет дополнительный элемент tk+lty. Таким образом,

остаточная сумма квадратов при включении в регрессию хк+1 в качестве

дополнительной объясняющей переменной уменьшается на величину

fjH-i.y. Сказанное объясняет, почему мы обозначаем /|+1> у в качестве

суммы квадратов, обусловленной введением л:Л+1 при данных лгг,

лт2, ..., хк.

Использование в качестве зависимой переменной другой

переменной. Аналогичным образом находится решение системы нормальных

уравнений

Х'кХкЪдЛк) = Х'кхя, q>k A.3)

при исследовании зависимости объясняющей переменной xq от

столбцов матрицы Хь. Для этого выберем из матрицы Т ту же, что и раньше

подматрицу ТА, а также вектор—столбец tq (ft), состоящий из элементов

с 0 по k вектор-столбца q матрицы Т. Нормальные уравнения A.3)

сводятся тогда к треугольной системе

тл bqAh) = tqik). A.4)

Особый интерес представляет для нас случай, когда q — k-\-1. Если в

уравнений A2.7) из гл. 1 заменить X на ХЛ, а у — на xft+1, то получим

Xfe (X^ Xk)~lX'kXk+l, A.5)

что представляет собой остаточную сумму квадратов в регрессии ft+,

на столбцы матрицы Хк. Предположим; что первый столбец матрицы,

X состоит из единиц. Тогда альтернативной записью A.5) будет

tl-i- \,k+1 = *k +1 xft+1 — xi+1 Xk (X'k Хь)-1 X'k xkj.v A.6)

41

Обозначения взяты в основном из параграфа 1.8. Данный результат

получен из упражнения 6 гл. 1. Далее на основе определения R2 (см.

параграф 1.14) находим:

tk

2

Отметим, что элемент dft+i, ь-н расположен в позиции (& + 1, & + 1)

матрицы Т'Т (см. упражнение 4 гл. 1), и, следовательно,

Л+1

1= 1

Таким образом,

2.2. СТАНДАРТНЫЕ ОШИБКИ КОЭФФИЦИЕНТОВ РЕГРЕССИИ

В этом параграфе будут приведены расчеты для примера из

параграфа 1.9. Оцененная матрица дисперсий-ковариаций для вектора оценки

b = A6/21, 1/3)' равна (Х'Х')**2, где а2заменена на ее оценку s2.

Диагональный элемент последней матрицы представляет собой оценку

дисперсии bt:

(b)

где SE — стандартная ошибка (Standard Error).

Оценивание а2. Несмещенная оценка а2 равна:

s2 =(п — р— I) х остаточная сумма квадратов.

Остаточную сумму квадратов наиболее просто получить как fyy>y

где tyy представляет собой последний диагональный элемент разложения

Холецкого матриц [X, уТ [X, у] или [X, у]' [X, у]. Таким образом, в

примере из параграфа 1.9 п — р — 1=4 — 3=1 и s2 = 22 = 4.

Оцененная матрица дисперсий-ковариаций.

9 ИГхЧ 52/441-56/441 I

14 13 I [- 56/441 196/441 J

Таким образом, дисперсии оценок метода наименьших квадратов

равны:

var (ft,) = 52/441, var(fc2) =¦ 196/441,

cov (bu b2) = — 56/441. Стандартная ошибка bx как было ранее

отмечено, представляет собой корень квадратный из var F5), аналогично

определяется и SE (ft2).

Значение var (b0) может быть рассчитано как

var (у — Ьх хх — Ь» х2) ---~- var (у) -i x\ var (bv) + x\ var (b2) +

4- 2хгх2 cov (bx, b2).

42

Средняя у не коррелирует с Ьл и Ь2. Значение Ьо представляет собой

ожидаемое значение у при хг -— х2 = 0, поэтому var (b0) лучше

рассчитывать с помощью формулы дисперсии теоретического значения,

приведенной в параграфе 2.4.

Обращение матрицы вида Х'Х. Общий метод. Нахождение

обратной матрицы размерности 2 х 2 не вызывает затруднений; здесь

имеется точная формула, которая использовалась нами ранее:

\с =(cd — gA) ~~ . B.1)

U d\ * 1-е с\

Однако этот простой случай может служить иллюстрацией общего

метода обращения, излагаемого в следующем параграфе. В параграфе 1.9 мы

нашли, что

2"

14 13J - [0 3_

где Т9Т2 = Х'Х. Тогда с помощью метода, описанного в следующем

параграфе, или же уравнения B.1) при g = 0 получаем:

Г1/7-1/7Х2Х1/31Г1/7 -2/211

[о 1/з J I о 1/зJ ¦ ;

Отсюда следует, что

'-^.'LI'!- B.3,

>1

j.

В частности, var (Ьг) = [A/7J + B/21J] а2 и т. д.

Преимущество такого способа обращения матрицы Х'Х состоит

в том, что при этом можно увидеть, как изменится var (fej), если

предположить, что р2 = 0, т. е. Ь2 = 0. Очевидно тогда, что var {Ьг\Ь2 =0) =

= A/7Jа2. Конечно, оценка а2 при этом также изменится.

Коэффициент возрастания дисперсии (VIF — variance inflation

factor) предоставляет информацию, которая по своему содержанию в

определенной степени аналогична информации, вытекающей из

соотношения B.3). Этот коэффициент показывает, во сколько раз увеличивается

значение var (bk) по сравнению с дисперсией var (bk), рассчитанной для

модели (имеющей то же самое значение дисперсии ошибок а2), в которой

xk является единственной объясняющей переменной.

Если обозначить через dhh k-н диагональный элемент Х'Х, а через

skk k-й диагональный элемент (Х'Х)~\ то

VIFFfc) = dfckS**. B.4)

В упражнении 7 в конце данной главы показано, что VIF может быть

рассчитан также по формуле

43

2.3. ОБРАЩЕНИЕ МАТРИЦЫ XX

Для расчетов, проводившихся в предыдущей главе, обращения

матрицы не требовалось. Использование этой процедуры приводит к

существенному возрастанию числа арифметических операций и некоторой

потере точности. Однако в расчетах, подобных тем, какие мы проводили

в параграфе 2.2, обойтись без обращения матрицы все же нельзя.

Итак, пусть матрица S^ имеет вид Х'Х; необходимо найти Sp~\

Напомним, что в процессе решения системы нормальных уравнений

Х'Х~Б ="Х' у или Х'ХЬ = Х'у

матрица

У

(или аналогичная матрица с X вместо X и у вместо у) приводится к виду

[о' tyy\

где Т — верхняя треугольная матрица с нулями ниже главной

диагонали, такая, что Т'Т = S. Легко проверяется тогда, что ТрТр = Х'Х.

Отсюда следует, что

(Х'Х) —Т^1 (Тр)~], C.1)

поэтому для получения обратной матрицы для Х'Х"необходимо

определить вначале Тр~\ а затем умножить ее на транспонированную к ней.

Предположим, что матрица TjL x сформирована, где Тк-г

представляет собой ведущую подматрицу Тр размерности (k — 1) х (k — 1).

Обозначим

Гть , к!

L 0' thh\

Тогда нетрудно проверить, что

Lo' tkkt» J

где 1А_! — единичная матрица размерности k— 1.

Полученное выражение будет представлять собой единичную матрицу

при условии

tkk = tkk\ <*=-Тл1Лл^. C.2)

Таким образом, если гккФ0, то мы можем найти Tfe = Tf1.

Вычисления начинаются с Tjj = [fib1].

Отметим, что — tk^tk является вектором коэффициентов регрессии

в регрессии xk на предыдущие столбцы матрицы X.

44

Интерпретация элементов матрицы Т. Рассмотрим регрессию хк на

первые k — 1 объясняющих переменных. Вектор коэффициентов

регрессии в соответствии с уравнением C.2) будет выглядеть тогда так:

bft.(ft-i) = T^ii Ffe = — tktkk.

Таким образом, элемент / (/ ^ k — 1) в frft.u-i) равен — t'ktkk =

= — tik/tkk. Остаточная сумма квадратов для этой регрессии равна

Пример

Г4 6

S2 =

58

10

29

38

> * 2 —

0

0

3

7

0

5"

2

3

(S2 есть СКП матрицы Х'Х для данных параграфа 1.9).

Т2 —

->

1/2

0

. 0

Г1/2

Jo

Lo

Таким

"/ 1

l~2

. „

3 5'

0 7 2

.0 0 3J

/2 3 5"

0 7 2

_ 0 0 3_

-Hi]

/2 —1/2x3x1/7 51

0 I/7 2 -_1 Г1/2 —3X1/141

0 0 3J x ""[ 0 1/7 J

—3x1/14 — 1/3[A/2)X5—3x A/14)X2] '

1/7 —1/3 A/7)X2

0 1/3

(Для

формирования элементов 1 и

2 в столбце 3

- /qt-i[51

'-""¦i [2J';

—3/14 —29/42"

1/7 —2/21

0 1/3 J

образом, окончательно

\2 / 3 \2 /29\2 3 1 29 2 29 1 -

J +\u) +[l2) ~HXT+4?x iT~l2"x7

/ 1 у /2у 2 1

\ 7 / "^Ul/ 21 3

(tI.

45

Использование этой матрицы для расчета дисперсий и ковариаций в

параграфе 2.2 позволяет нам непосредственно считывать из нее

значение коэффициента при а2 в var F0). Для первого диагонального элемента

var (bo) = [A /2J + C/14J f B9/42J] a2.

По записи Sjf1, приведенной выше, легко определить Sr1 и So. Так,

Sf1 получается из Sjf1 вычеркиванием последней строки и столбца и

исключением из каждого оставшегося элемента последнего слагаемого:

(l/2J + C/14J -3/14X1/7

В вычислении всех элементов матрицы Sjг (или Sr1) нет

необходимости. Если необходимо определить лишь диагональные элементы этой

матрицы, мы вполне можем воздержаться от расчета недиагональных

элементов.

2.4. СТАНДАРТНЫЕ ОШИБКИ ТЕОРЕТИЧЕСКИХ ЗНАЧЕНИЙ

Оцененные коэффициенты регрессии Ьи Ь2, .., Ьр (и Ьо)

определяют теоретическую регрессионную зависимость, которая может быть

записана в виде

xp D.1)

или у= у + Ь1(х1 — х1) +... +Ьр(Хр—хр). D.2)

Если [хг, #2, ..., хр] = [xtl1 xi2, ..., xip] представляет собой один из

наборов исходных данных, то, используя уравнение D.1), получаем

У. = Ьо + Ьг Хц + ...+bp xip.

Теоретическое значение следует отличать от реального уи разность et—

— Уь — Уг называем i-m отклонением.

Расчеты по формуле D.1) осуществляются достаточно просто.

Очевидно, что

y=60 + biX1-1-... -тЬрХр^Т'Ь

где 1' ~ A, хъ ..., хр). Поэтому в соответствии с формулой A3.3) из гл. 1

получаем

var (у)---И' (X/X)-1ia2 =

~(Т'р-*Т)'Тр-1То*~й'йо*9 D.3')

46

где d~ Тр^1 1. Вектор d может быть получен умножением Тр-1 на 1 или