Автор: Андронов А.М. Копытов Е.А. Гринглаз Л.Я.

Теги: теория вероятностей и математическая статистика теория вероятностей математическая статистика комбинаторный анализ теория графов математика

ISBN: 5-94723-615-Х

Год: 2004

ll—-----Г” — _

УЧЕБНИК / ДЛЯ ВУЗОВ л

А. М. Андронов

Е. А. Копытов

Л. Я. Гринглаз

ТЕОРИЯ ВЕРОЯТНОСТЕЙ

И МАТЕМАТИЧЕСКАЯ

СТАТИСТИКА

ПИТЕР

Москва Санкт-Петербург Нижний Новгород • Воронеж

Ростов-на-Дону • Екатеринбург Самара • Новосибирск

Киев • Харьков • Минск

2004

ББК 22.17я7

УДК 519.2(075)

К65

Рецензенты:

В. Б. Мелас, доктор физико-математических наук, профессор Санкт-Петербургского

государственного университета.

П. П. Бочаров, доктор технических наук, профессор, зеведующий кафедрой теории

вероятностей и математической статистики Российского университета дружбы народов.

Андронов А. М., Копытов Е. А., Гринглаз Л. Я.

К65 Теория вероятностей и математическая статистика: Учебник для вузов. — СПб.:

Питер, 2004. — 461 с.: ил. — (Серия «Учебник для вузов»),

ISBN 5-94723-615-Х

Перед вами — расширенный учебник по теории вероятностей и математической статистике. Тради-

ционный материал пополнен такими вопросами, как вероятности комбинаций случайных событий, слу-

чайные блуждания, линейные преобразования случайных векторов, численное нахождение нестационар-

ных вероятностей состояний дискретных марковских процессов, применение методов оптимизации для

решения задач математической статистики, регрессионные модели. Главное отличие предлагаемой книги

от известных учебников и монографий по теории вероятностей и математической статистике заключается

в ее ориентации на постоянное использование персонального компьютера при изучении материала. Изло-

жение сопровождается многочисленными примерами решения рассматриваемых задач в среде пакетов

Mathcad и STATISTICA. Книга написана иа основе более чем тридцатилетнего опыта авторов в препода-

вании дисциплин теории вероятностей, математической статистики и теории случайных процессов для

студентов различных специальностей высших учебных заведений.

Представляет практический интерес как для студентов и преподавателей вузов, так и для всех, кто

интересуется применением современных вероятностно-статистических методов.

ББК 22.17я7

УДК 519.2(075)

Все права защищены. Никакая часть данной книги не может быть воспроизведена е какой бы то ни было форме без письменного

разрешения владельцев авторских прав.

Информация, содержащаяся в данной книге, получена из источников, рассматриваемых издательством как надежные. Тем не

менее, имея в виду возможные человеческие или технические ошибки, издательство не может герантировать абсолютную точ-

ность и полноту приводимых сведений и не несет ответственности за возможные ошибки, связанные с использованием книги.

ISBN 5-94723-615-Х

© ЗАО Издательский дом «Питер», 2004

Краткое содержание

Введение ................................................. 8

1. Пространство элементарных событий....................11

2. Классическое определение вероятностей

и повторные испытания...................................51

3. Дискретные случайные величины........................74

4. Непрерывные случайные величины.......................92

5. Многомерные дискретные случайные величины...........129

6. Многомерные непрерывные случайные величины..........151

7. Суммирование случайных величин и предельные теоремы .... 182

8. Цепи Маркова........................................209

9. Дискретные марковские процессы......................245

10. Задачи математической статистики

и первичная обработка данных...........................278

11. Точечные оценки параметров распределений...........310

12. Оценивание с помощью доверительных интервалов......337

13. Проверка статистических гипотез....................367

14. Регрессионный и корреляционный анализ..............406

Литература.............................................454

одержание

^едение.................................................................8

Общая характеристика книги..............................................8

Структура книги.........................................................8

Стиль, нумерация и выделения в тексте...................................9

Благодарности.......................................................... 10

От издательства ........................................................10

Пространство элементарных событий.......................................11

1.1. События и операции над ними........................................11

Компьютерный практикум № 1. Операции над событиями в пакете Mathcad....16

1.2. Комбинации событий.................................................25

1.3. Структурная надежность систем......................................29

Компьютерный практикум № 2. Комбинации событий в пакете Mathcad.........31

1.4. Вероятности на дискретном пространстве элементарных событий........34

1.5. Вероятность наступления комбинации событий.........................42

Компьютерный практикум № 3. Вероятности событий в пакете Mathcad........45

Задачи..................................................................48

Классическое определение вероятностей и повторные

испытания..............................................................51

2.1. Различные определения вероятностей................................51

2.2. Элементы комбинаторики............................................52

2.3 Последовательности испытаний......................................56

2.4. Случайные блуждания* .............................................59

Компьютерный практикум № 4. Анализ повторных испытаний

и случайных блужданий в пакете Mathcad..............................66

Задачи ................................................................70

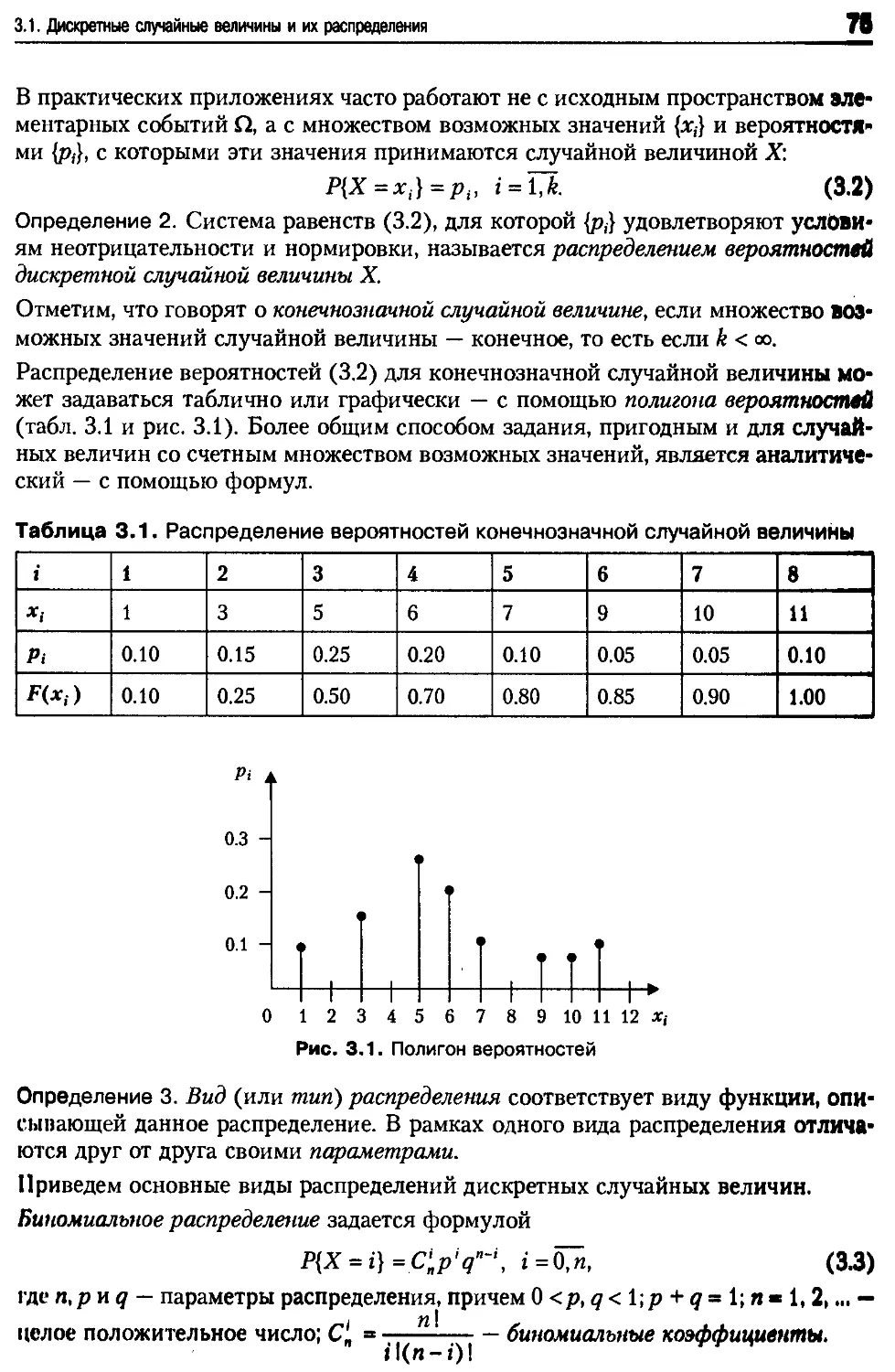

. Дискретные случайные величины.........................................74

3 1 Дискретные случайные величины и их распределения...................74

3.2 Млтематическое ожидание дискретных случайных величин...............81

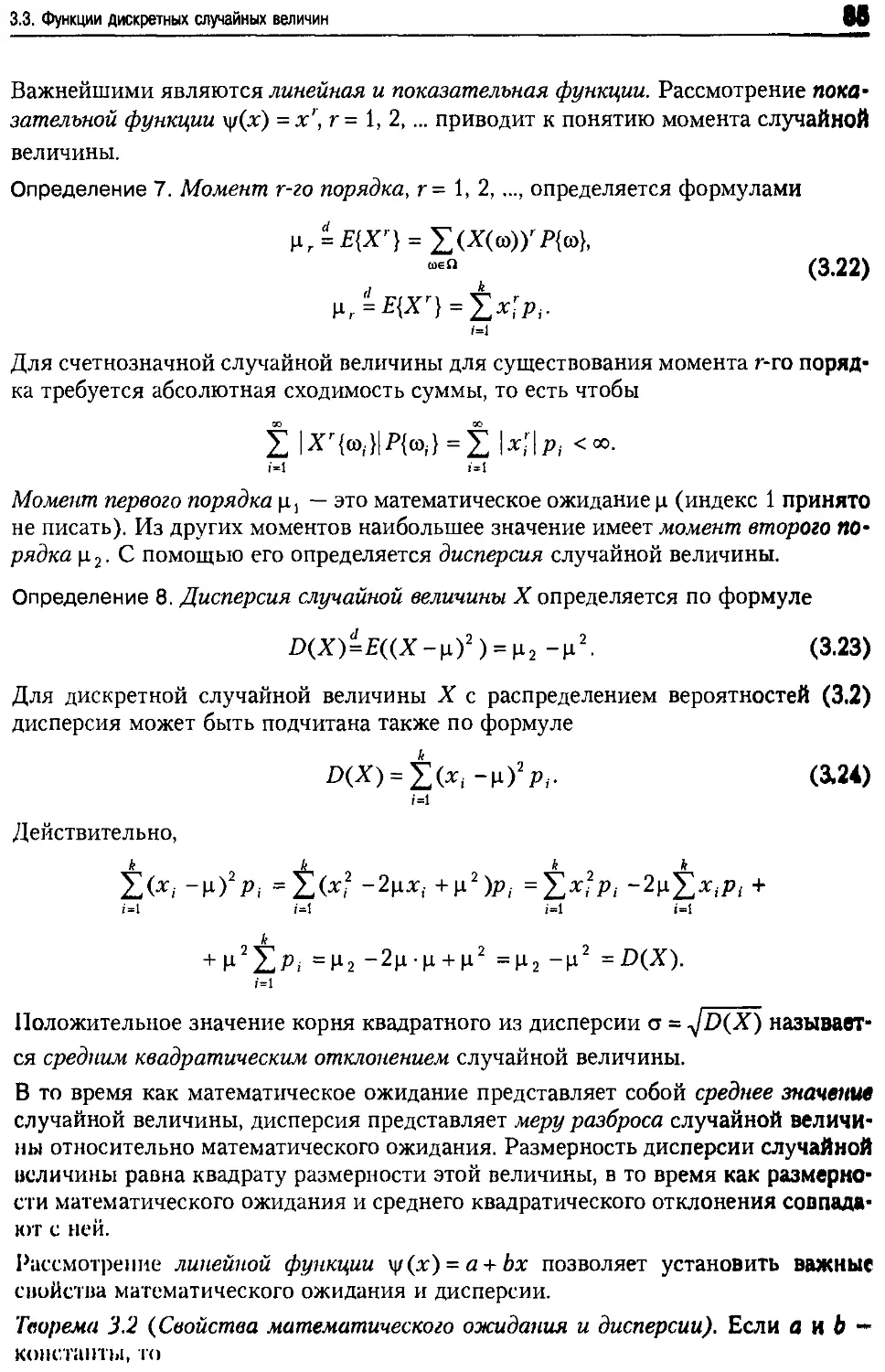

3 3 Функции дискретных случайных величин...............................83

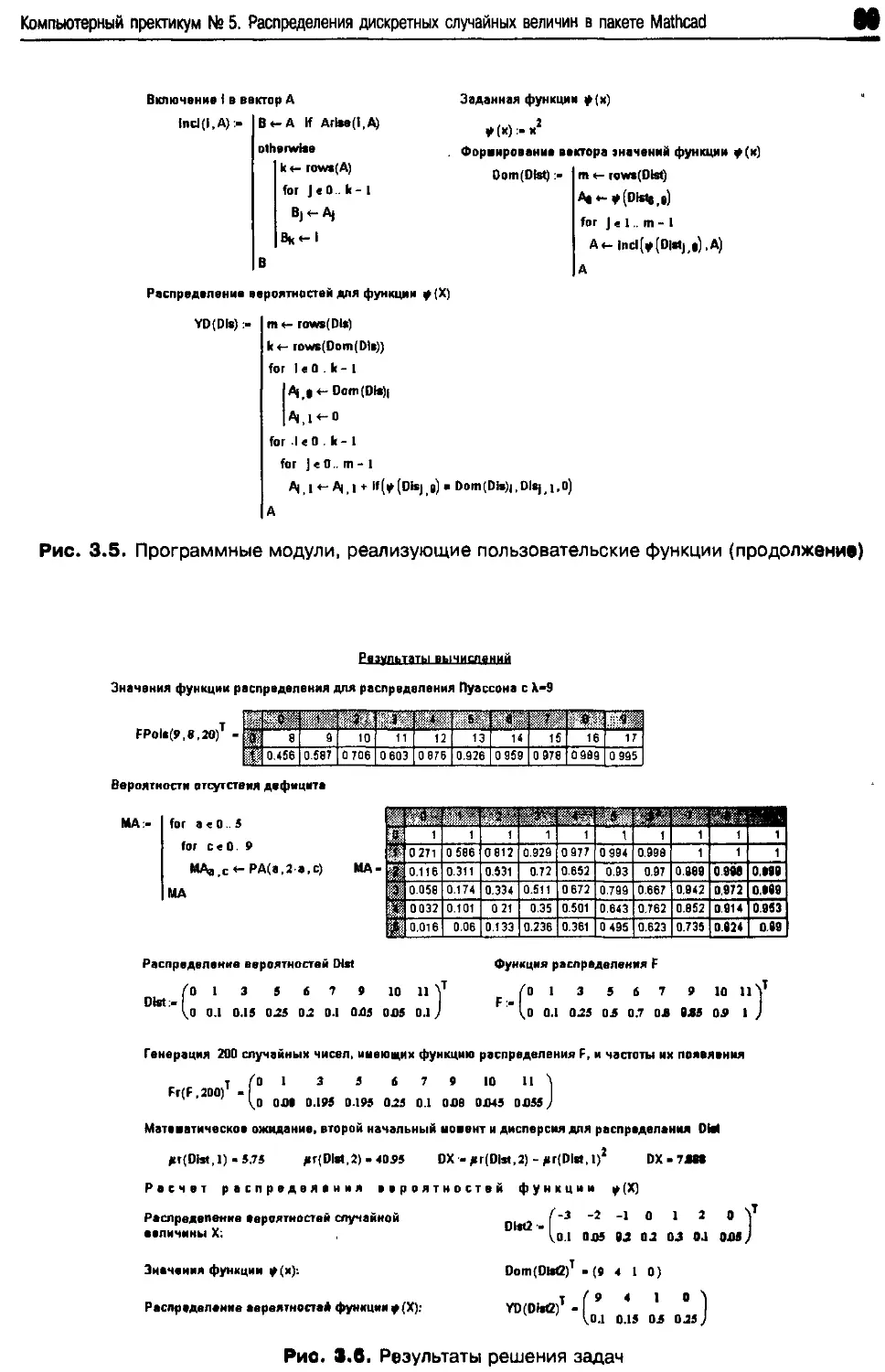

Компьютерный практикум Nv 5. Распределения дискретных случайных величин

....................86

Содержание

5

4. Непрерывные случайные величины .....................................92

4.1. Распределения непрерывных случайных величин ....................92

4.2. Математическое ожидание непрерывных случайных величин..........102

4.3. Функции и моменты непрерывных случайных величин................104

4.4. Распределения функций непрерывных случайных величин*...........109

4.5. Неравенства для моментов и вероятностей*.......................114

Компьютерный практикум № 6. Распределения непрерывных случайных величин

в пакете Mathcad..................................................118

Задачи..............................................................126

5. Многомерные дискретные случайные величины.........................129

5.1. Распределения многомерных дискретных случайных величин........129

5.2. Функции многомерных дискретных случайных величин..............135

5.3. Индикаторы событий*...........................................140

Компьютерный практикум № 7. Многомерные дискретные случайные величины

в пакете Mathcad..................................................142

Задания для самостоятельной работы..................................148

Задачи..............................................................149

6. Многомерные непрерывные случайные величины........................151

6.1. Распределения многомерных непрерывных случайных величин........151

6.2. Функции многомерных непрерывных случайных величин..............157

6.3. Линейные преобразования случайных векторов*....................159

6.4. Многомерное нормальное распределение* .........................167

Компьютерный практикум № 8. Двумерное нормальное распределение......171

Компьютерный практикум № 9. Многомерное нормальное распределение...176

Задачи..............................................................180

7. Суммирование случайных величин

и предельные теоремы ...................................................182

7.1. Суммирование дискретных случайных величин......................182

7.2. Суммирование непрерывных случайных величин.....................185

7.3. Суммирование независимых многомерных случайных величин*........187

7.4. Центральная предельная теорема.................................194

7.5. Закон больших чисел............................................196

Компьютерный практикум № 10. Суммирование дискретных случайных величин . . 197

Компьютерный практикум № 11. Суммирование непрерывных случайных величин ..201

Компьютерный практикум № 12. Предельные теоремы теории вероятностей .... 203

Задания для самостоятельной работы..................................205

Задачи..............................................................206

8. Цепи Маркова ......................................................209

8.1. Основные определения...........................................209

8.2. Классификация состояний и цепей Маркова........................215

8.3. Эргодические конечные цепи.....................................218

8.4. По, летающие цепи Маркова......................................222

Содержание

Компьютерный практикум № 13. Анализ цепей Маркова в пакете Mathcad....237

Задания для самостоятельной работы....................................242

Задачи................................................................242

Дискретные марковские процессы........................................245

9.1. Определение марковского процесса ................................245

9.2. Уравнения Колмогорова........................................... 250

9.3. Пуассоновский процесс............................................252

9.4. Численное решение уравнений Колмогорова..........................255

9.5. Стационарное распределение вероятностей состояний................259

9.6. Процессы размножения и гибели. Процессы массового обслуживания...263

Компьютерный практикум № 14. Анализ дискретных марковских процессов

в пакете Mathcad (часть 1) ..........................................268

Компьютерный практикум № 15. Анализ дискретных марковских процессов

в пакете Mathcad (часть 2) ..........................................272

Задания для самостоятельной работы....................................275

Задачи................................................................276

1 Задачи математической статистики и первичная

обработка данных......................................................278

10.1. Задачи математической статистики ...............................278

10.2. Представление статистических данных.............................281

10.3. Определения и свойства выборочных характеристик.................284

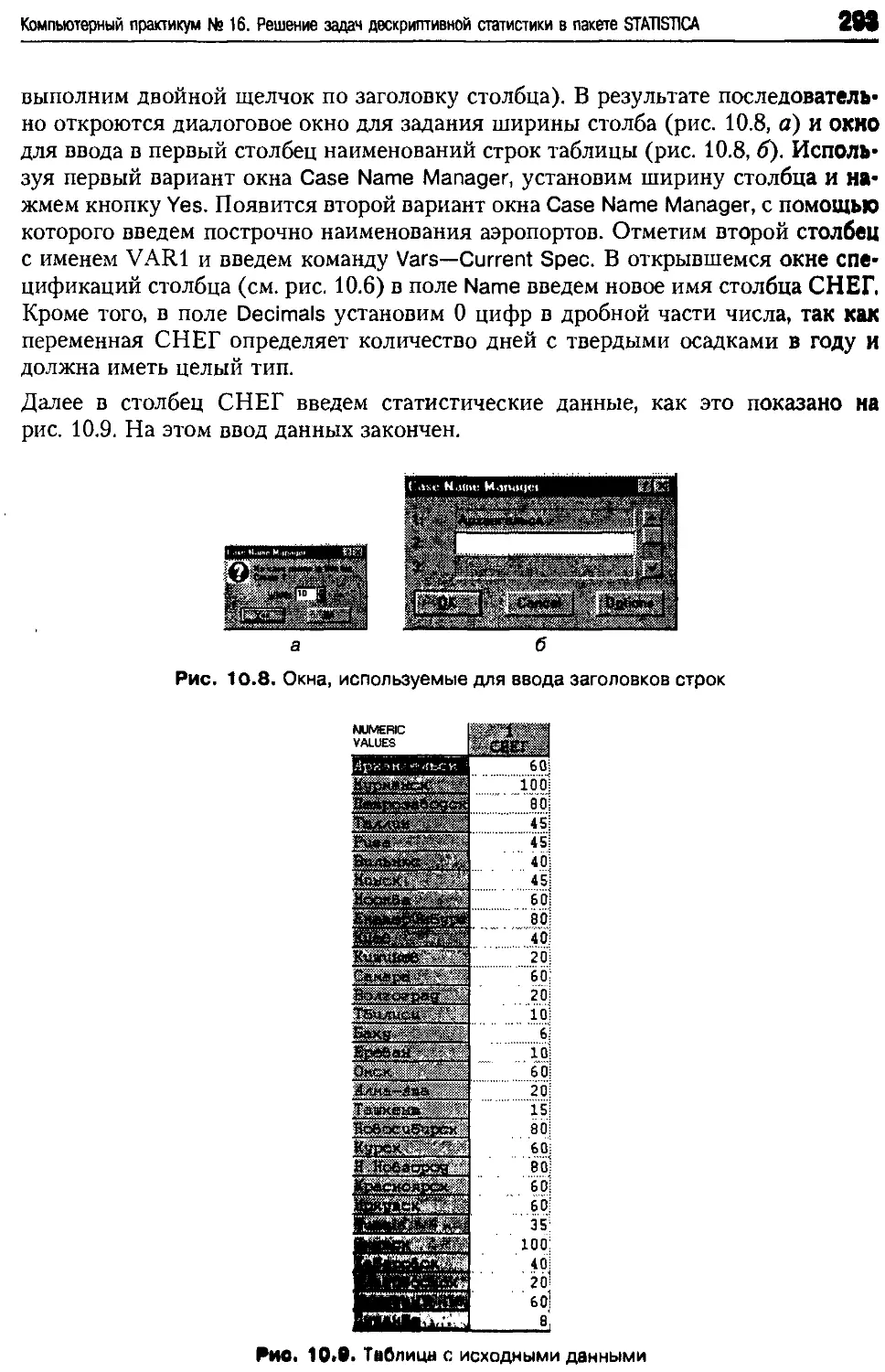

Компьютерный практикум № 16. Решение задач дескриптивной статистики

в пакете STAT1STICA..................................................287

Компьютерный практикум № 17 Работа с распределениями случайных величин

в пакете STATISTICA..................................................299

Задания для самостоятельной работы....................................308

Задачи................................................................308

1. Точечные оценки параметров распределений............................зю

111. Определение и основные свойства точечных оценок...................310

I I 2 Неравенство Рао—Крамера и эффективность*.........................316

11.3. Могод моментов для нахождения оценок параметров распределения....319

1 1.4. Метод максимального правдоподобия...............................322

11.5. Достаточные статистики*..........................................325

Компьютерный практикум № 18. Методы точечного оценивания параметров

распродслений в пакете Mathcad......................................326

Задания для самостоятельной работы.....................................334

Задачи.................................................................334

2. Оценивание с помощью доверительных интервалов . . 337

I2 I Основные определения ........................................... 337

1? 2 I locipooiinn д()1Н1|)иннн>ных интервалов в случае

цсимнмни'н’ми норм.ип.ных оценок................................... 340

12.3. Ochohiii.u р.н 11| ч д'ионии маюмагичоской шагистики............346

19 Л Ihii iihuiiihh И( ни II 111 I < itli.in.tx MIIHHIU.UHMI И (flVHHH МИЛЫХ НЫПОООК

Содержание

7

12.5 . Численный метод построения доверительных интервалов

для параметрической функции*.........................................356

Компьютерный практикум № 19. Построение доверительных интервалов

в пакете Mathcad...................................................361

Задания для самостоятельной работы...................................364

Задачи...............................................................365

13. Проверка статистических гипотез....................................367

13.1. Основные понятия ..............................................367

13.2. Проверка гипотез относительно вероятности......................373

13.3. Проверка гипотез о математическом ожидании.....................377

13.4. Проверка гипотез о дисперсии нормальной совокупности...........380

13.5. Наиболее мощные критерии*......................................382

13.6. Непараметрические критерии для проверки гипотез

о распределениях случайных величин...................................386

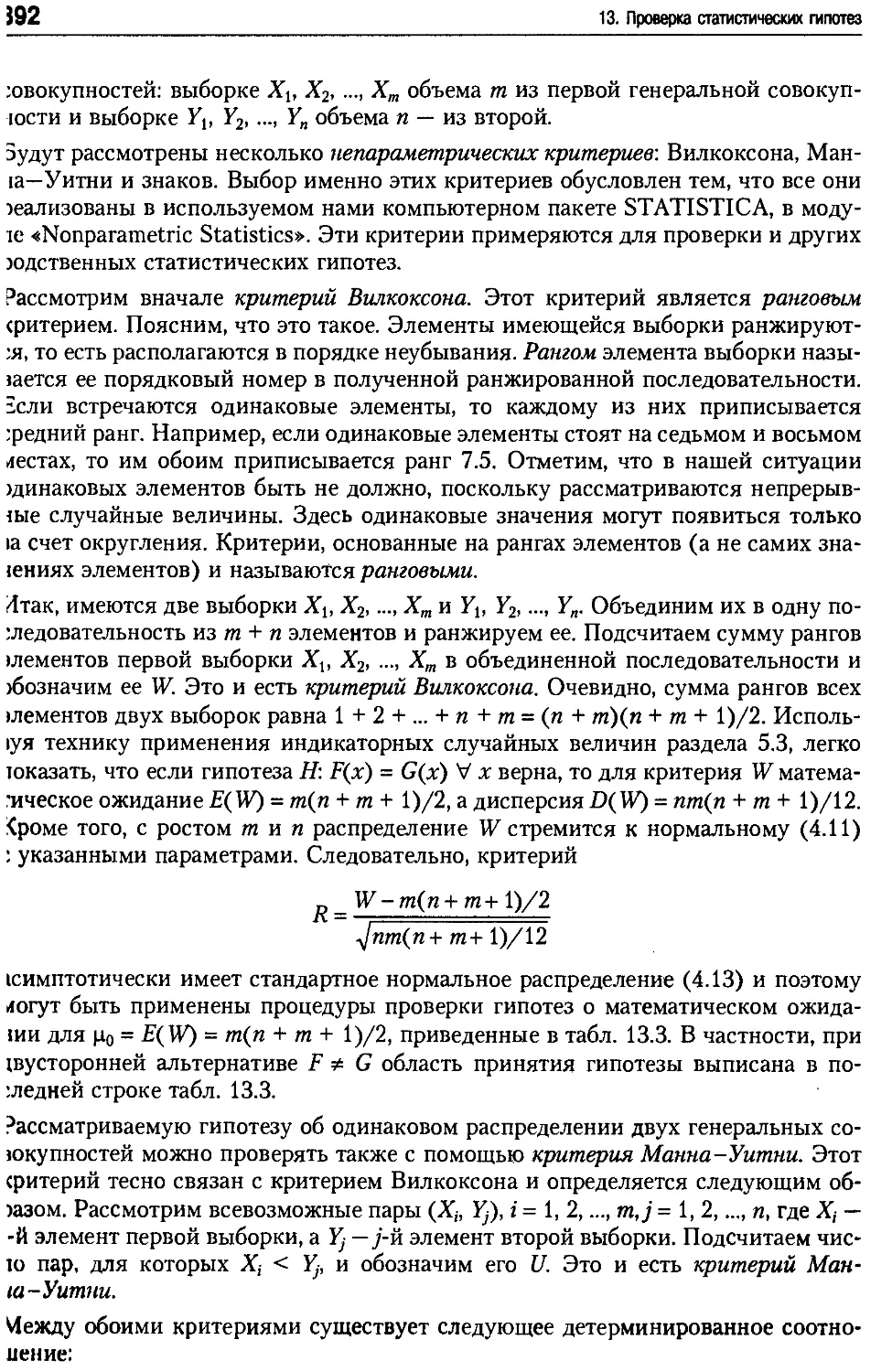

13.7. Непараметрические критерии сравнения двух совокупностей .......391

Компьютерный практикум № 20. Непараметрическая проверка гипотез

в пакете STATISTICA................................................393

Задания для самостоятельной работы...................................401

Задачи...............................................................402

14. Регрессионный и корреляционный анализ..............................406

14.1. Одномерная линейная регрессия .................................406

14.2. Проверка адекватности модели одномерной линейной регрессии ....412

14.3. Многомерная линейная регрессия.................................418

14.4. Проверка адекватности модели многомерной линейной регрессии....426

14.5. Общая модель регрессии.........................................431

14.6. Статистическое оценивание корреляционных зависимостей..........435

Компьютерный практикум № 21. Оценка параметров модели линейной регрессии

в пакете STATISTICA................................................436

Задания для самостоятельной работы...................................451

Задачи...............................................................452

Литература..............................................................454

Алфавитный указатель ...................................................455

ведение

щая характеристика книги

шая книга представляет собой расширенный учебник по теории вероятностей

ia'1'ематической статистике, ориентированный на постоянное использование

сональных компьютеров при изучении излагаемого материала. Она предна-

чена для студентов высших учебных заведений, обучающихся по различным

циалыюстям, в их числе: информатика и вычислительная техника, приклад-

। информатика, математика и компьютерные науки, математическое обеспече-

; и администрирование информационных систем и др.

1астоящее время имеется много прекрасных учебников и монографий по тео-

а вероятностей и математической статистике, написанных в классическом

)ле. Однако практически ни в одной из них нет компьютерного сопровожде-

я, когда теоретические результаты реализуются и иллюстрируются с помо-

ю компьютерных программ. На наш взгляд, последнее необходимо по двум

ичпиам. Во-первых, персональные компьютеры в огромной степени расширя-

возможиости рассмотрения численных примеров и экспериментальных рас-

к>1>. Опп позволяют отойти от рассмотрения нарочито упрощенных, учениче-

нх задач и формулировать и решать более приближенные к практике и более

персгпые задачи. Во-вторых, предоставляемая ими визуализация изучаемых

тятиii н закономерностей позволяют быстрее и лучше освоить излагаемый ма-

риал. К этому следует добавить эффект активной формы обучения, когда уча-

ийся самостоятельно выполняет на компьютере разные задания. Этим самым

I приобщается к математике посредством компьютера.

асюящая книга написана на основе более чем тридцатилетнего опыта авторов

преподавании дисциплин теории вероятностей и математической статистики

in студентов различных высших учебных заведений и специальностей. В по-

|едпис годы осуществлялся пересмотр методики преподавания на основе широ-

>к> использования персональных компьютеров.

Структура книги

'одержание мни и делшея на три части. Первая часть (сланы 1 7) содержит

радишн iitiii.ni .м.исрнал ио icopini вероятностен. Изложение не использует тео-

““ ........ ииняегся nocia io'iiio c i росим. Вторая часть (сланы 8 н 9) дает

Введение

9

ся только процессами с дискретным пространством состояний. Последняя часть

книги (главы 10-14) излагает основы математической статистики.

Главы делятся на разделы. Некоторые из них помечены звездочкой, говорящей

о том, что раздел содержит дополнительный материал и может быть при жела-

нии пропущен.

В конце глав имеются компьютерные практикумы, задания для самостоятельной

работы (на компьютере) и раздел «Задачи».

Компьютерный практикум ставит своей целью реализацию и иллюстрацию на

компьютере соответствующих теоретических положений, а также получение

практических навыков в решении задач. Можно добавить, что попутно студенты

приобретают навыки работы на компьютере, алгоритмизации и программирова-

ния задач. В практикумах используется два компьютерных пакета программ:

Mathcad и STATISTICA. Первый представляет собой язык программирования,

ориентированный на математические вычисления. Запись программы на этом

языке и принятая в математике запись формул и алгоритмов фактически совпа-

дают. Пакет STATISTICA представляет собой мощную интегрированную систе-

му статистического анализа и обработки данных. Для этих целей в состав пакета

включены разнообразные статистические модули. В процессе решения конкрет-

ной задачи в пакете STATISTICA необходимо вызвать требуемый модуль, вве-

сти исходные данные, установить необходимые параметры и выбрать выходную

форму с полученными результатами.

Практикум начинается с изложения необходимого справочного материала, далее

следует описание реализации и выполнения заданий. Основной составляющей

практикума, проводимого на базе системы Mathcad, является компьютерная

программа (или пользовательская функция). Обычно приводится ее текст, со-

держащий необходимые пояснения. Слабо подготовленный по программирова-

нию студент может просто набрать этот текст, а затем провести соответствую-

щие расчеты. Хорошо подготовленному студенту рекомендуется разобраться в

логике работы программы и постараться улучшить ее. При разработке программ

авторы в первую очередь стремились сделать их простыми для понимания, так

ч то здесь имеется большой простор для совершенствования. Авторы будут рады

получить от читателей соответствующие модификации, предложения и заме-

чания.

Задания для самостоятельной работы содержат разного рода задания (от состав-

ления новых программ до проведения расчетов по имеющимся программам), ко-

торые студенты должны выполнить на компьютере.

Предлагаемые задачи позволяют закрепить пройденный материал, а также сде-

лать на его основе дальнейшие обобщения.

Стиль, нумерация и выделения в тексте

Главы имеют сквозную нумерацию, от первой до четырнадцатой. Разделы имеют

двойную нумерацию, состоящую из номера главы и номера раздела внутри гла

вы, например, второй раздел седьмой главы имеет номер 7.2. Аналогичным обра

зом нумеруются формулы, теоремы, примеры, таблицы и рисунки. Если один

Введение

смотрении к его номеру приписывается очередная буква русского алфавита,

рпмер, пример 1.2а.

ределения имеют ординарную нумерацию внутри главы. Имеющиеся доказа-

ьства выделяются словом Доказательство. Окончание доказательства или

смотрения серии примеров указывается символом □.

ексте широко используются выделения с помощью курсива — для вводимых

«•делений, формулировки теорем, привлечения внимания к определенной

си текста.

онце книги имеется алфавитный указатель, к которому следует обращаться,

да встречается незнакомый термин.

1агодарности

.....ыражают глубокую благодарность Ирине Геннадьевне Михневич и Ната-

Львовне Савельевой за прекрасную работу по подготовке книги к изданию.

' издательства

ни замечания, предложения и вопросы отправляйте по адресу электронной

!ты comp@piter.com (издательство «Питер», компьютерная редакция).

i будем рады узнать ваше мнение!

ссты приведенных в книге заданий вы можете найти по адресу:

http://www.piter.com/download.

дробную информацию о наших книгах вы найдете на веб-сайте издательства

x//www. piter.сот.

Пространство элементарных

событий

1.1. События и операции над ними

Теория вероятностей, как и любая другая математическая дисциплина, начинает

е неопределяемых понятий. В теории вероятностей это понятия испытания

(унотребимыми синонимами также являются опыт, эксперимент, наблюдение

и пр.) и элементарного события (элементарный исход).

Под испытанием понимается реализация определенного комплекса условий, в

результате которой наступает ровно одно элементарное событие из общей их со-

вокупности, называемой пространством элементарных событий. Пространство

элементарных событий мы будем обозначать заглавной буквой греческого алфа-

вита Q. Входящие в него элементарные события обозначаются строчными буква-

ми греческого алфавита, при необходимости — с индексами: со, со(, со2, со;),... Про-

странство элементарных событий описывается, как и любое множество —

фигурными скобками, в которых перечисляются входящие в него элементарные

события, например, Q = {со 1( со2, со3, ...}.

В зависимости от числа элементарных событий в пространстве, мы будем разли-

чать конечное, счетное и несчетное пространство элементарных событий. Конеч-

ное пространство содержит конечное число элементарных событий, счетное -

бесконечное число, однако такое, которое можно перенумеровать (говорят так-

же — пересчитать). Наконец, несчетное пространство содержит бесконечное чис-

ло элементарных событий, не поддающихся нумерации (пересчету).

Па базе введенных понятий даются другие определения теории вероятностей.

При их формулировке мы будем давать два определения: теоретико-множест-

вен ное, использующее язык теории множеств, и вероятностное, основанное па

содержательном смысле вводимого определения.

Определение 1. Событием (иначе составным событием) называется некоторое

подмножество пространства элементарных событий. Говорят, что событие на-

ступило в результате испытания, если наступило одно из элементарных собы-

тий, входящих в данное событие.

События мы будем обозначать заглавными буквами латинского алфавита Л, /J,

(', ... Как и ранее для пространства Q, событие А описывается с помо1цыо <|>нгур

пых скобок, внутри которых указываются элементарные события, составляющие

эго событие, например, Л <о4, <o(i, <он}.

2

1. Пространство элементарных событий

л приведенного определения естественно вытекает следующее определение,

цюделение 2. События называются эквивалентными (символ эквивалентности =),

ли они состоят из одних и тех же элементарных событий. Эквивалентные со-

ития наступают или не наступают одновременно.

з всевозможных событий два события занимают особое положение — это не-

ыможиое и достоверное события.

пределение 3. Событие называется невозможным, если оно не содержит ни

(пою элементарного события, иначе — это пустое подмножество Q. Невозмож-

>с событие никогда не происходит, оно обозначается 0. Событие называется

хтоверным, если оно содержит все элементарные события пространства Q,

паче — если оно совпадает с самим пространством. Достоверное событие про-

ходит при каждом испытании, оно обозначается V (или просто Q, хотя это

формально некорректно: U — это подмножество Q).

римеры

ример 1.1. Однократное бросание игральной кости. Игральная кость представ-

ив г собой правильной формы кубик, на шести гранях которого точками изобра-

зим числа 1, 2, 3, 4, 5, 6, на каждой грани по одному числу. После бросания кос-

। фиксируют число, записанное на верхней грани кубика. О нем говорят как о

ыпаншем числе очков.

данном случае элементарным событием является число выпавших очков. Если

ыпало г очков, i = 1, ..., 6, то будем говорить, что произошло событие со,. Следова-

'льно, Q = {соь со2, со3, со4, со5, со6}> пространство содержит шесть элементарных со-

итий и является конечным. Событие «число выпавших очков равно 9» является

(•возможным, а событие «число выпавших очков не более 7» является достоверным,

ели А,,,,, обозначает событие «выпало четное число очков», то Ачет = {со 2, ®4> ®е}-

<3 = {(о |, со2, со3, со4} представляет собой событие «число выпавших очков менее пяти»,

ример 1.2. Двукратное бросание игральной кости. Пусть игральная кость броса-

гся дважды. Эти два бросания образуют одно испытание. Если при первом бро-

ни нн выпало г очков, а при второму очков, то будем этот результат записывать в

идс у и считать это элементарным событием. Следовательно, пространство эле-

1сн гарных событий Q = {11, 12, 13, 14, 15, 16, 21, 22, 23, 24, 25, 26, 31, 32, 33, 34,

5, 36, 41, 42, 43, 44, 45, 46, 51, 52, 53, 54, 55, 56, 61, 62, 63, 64, 65, 66}. Более ком-

актпая запись следующая: Q = {ij: i,j е{1, 2, 3, 4, 5, 6}}. Она означает, что рас-

магриваются все пары ij, где i nj пробегают всевозможные значения от 1 до 6.

дли Л_ - событие «при обоих бросаниях выпало одинаковое число очков», то

L {11, 22, 33, 44, 55, 66}. Событие А^=10 «сумма выпавших очков равна 10», за-

ш ынаетея гак: А£=10 = {46, 55, 64}.

1римор 1.3. Бросание монеты. В соответствии со старинной русской традицией,

удем одну сторону монеты (вне зависимости от ее достоинства и страны) назы-

агь «гербом», а вторую — «решеткой». Пусть монета подбрасывается до первого

ыпадения герба. Вся последовательность таких подбрасываний составляет одно

и ныганпе. Если результат выпадения герба при одном подбрасывании обозпа-

агь Г, а решетки Р, то пространство элементарных событий записывается в виде

1.1. События и операции над ними

13

11 = {Г, РГ, РРГ, РРРГ, РРРРГ, ...}. Мы видим, что число элементарных событий

пространства бесконечно. Это — пример «счетного» пространства элемен тарных

собы тин.

Событие Л5 — «первый герб выпал при пятом бросании» есть Л5 = {РРРРГ}. ()но

состоит только из одного элементарного события РРРРГ. Событие «потре-

бовалось пе более четырех бросаний» записывается так: As4 = {Г, РГ, РРГ,

РРРГ}. Событие В «герб выпал до седьмого подбрасывания, но при подбрасыва-

нии с четным номером» может быть представлено так: В = {РГ, РРРГ, РРРРРГ).

Чтобы записать событие Ачст «герб выпал при подбрасывании с четным номе-

ром», мы введем следующее обозначение, принятое в формальных языках и

грамматиках: i-я степень символа означает, что этот символ в записи повторяет-

ся г раз. Например, Г5 означает ГГГГГ. Теперь можно записать АЧС| = {Р2' 1 /’,:

1=1,2,...}.

Пример 1.4. Задача о встрече. Два приятеля договорились встретиться между

двенадцатью и часом дня в условленном месте. Сконструируем пространство

элементарных событий, соответствующее данной ситуации. Будем рассматри-

ваемый интервал времени обозначать (0, 1), момент прихода первого приятеля х,

а второго приятеля у. Фиксация этих моментов времени будет соответствовать

элементарному событию (х, у). На числовой плоскости оно обозначается точкой.

Все пространство элементарных событий геометрически представляет собой

квадрат с единичной длиной сторон, расположенный в начале положительного

квадранта плоскости. Аналитически это можно записать в виде Q = (0, 1 )х((), 1)

= {(х, у): х, у е(0, 1)}. Отметим, что это — несчетное пространство элементарных

событий: число его элементарных событий нельзя пересчитать или перенумеро-

вать.

Событие А «оба приятеля пришли до половины первого» записывается в виде

А = {(х, у): х, у е(0, 0.5)}. Предположим, что пришедший первым ждет приятеля

четверть часа и уходит, если тот не придет до этого. Тогда событие В «прия тели

встретятся» есть В = {(х, у): х, у е (0, 1), | х - у | < 0.25}.

Пример 1.5. Случайное блуждание на плоскости. Представим себе шахматную доску

и некоторую гипотетическую фигуру на ней, которая может ходить только на

одну клетку или направо по горизонтали, или вверх по вертикали. Вначале фп

гура стоит в нижнем левом углу доски. Это соответствует клетке (полю, па шах-

матном языке) al, если вертикальные ряды клеток обозначать a, b, с, d, е, f, ц, h,

а горизонтальные ряды 1, 2, 3, 4, 5, 6, 7, 8. Опишем перемещение фигуры за пя ть

ходов.

В данном случае будем понимать под одним испытанием все пять ходов фигуры.

Элементарным событием является отдельная траектория, описывающая дниже

нис фигуры в течение этих пяти ходов. Удобно его записывать в виде пятнмер-

ного булевого вектора, компоненты которого принимают значения 0 и 1. i-я ком

попепта вектора соответствует i-му ходу фигуры, 0 — перемещению фигуры

направо, а 1 — перемещению вверх. Так, элементарное событие 00000 означает,

что фигура все время двигалась направо по горизонтали, 11111 — ч то двигалась

вверх но вертикали, 11100 — что первые три шага сделала вверх, а два послед

них направо. Бели обозначить В {(), 1} множество из двух булевых значении

14

1. Пространство элементарных событий

) и 1, а В5 множество всевозможных булевых векторов с пятью компонентами, то

||>остранство элементарных событий Q = В5.

Событие Л,;4 «после пятого шага фигура находится на клетке с4» записывается

срез элементарные события так: Лс4 = {00111, 01011,01101, OHIO, 10011, 10101,

10110, 11001, 11010, 11100}. Этот пример интересен тем, что элементарному со-

>ытию здесь соответствует некоторая траектория движения фигуры. Данная си-

уация характерна для теории случайных процессов, которая будет рассматри-

>аться далее. □

Геперь мы рассмотрим операции над событиями, важнейшими из которых явля-

о гся сумма, произведение и разность.

Определение 4. Сумма событий А, ,Д2,...,Д4 — это событие

k г ___ 1

U At = Д + А2 + ... + Д = <! со:Э i = l,k шеД. >, (1.1)

i=t I J

:остоящее из элементарных событий, входящих в события-слагаемые. Оно на-

гупает тогда, когда наступает хотя бы одно из событий-слагаемых: или Д или

12 и т. д. — принцип «или»-«или».

Определение 5. Произведение событий A1,A2,...,Ai — это событие

k f ___ 1

ПА = Д A2-...-Ak со: V i = 1, Jfe соеДД (1.2)

I J

^стоящее из элементарных событий, входящих во все события-сомножители.

Оно наступает, когда наступают все события-слагаемые: и At, и Д, и т. д. —

рипцип «и»-«и».

Рис. 1.1. Диаграммы Венна

Определение 6. Разность событий А и И — это собы тие

А - в - < cd : <о с А, со </ И},

(13)

1.1. События и операции над ними

16

состоящее из элементарных событий, входящих в А, но не входящих в В. Оно на-

ступает, когда событие А наступает, а событие В не наступает.

Введенные выше понятия могут быть проиллюстрированы геометрически с по-

мощью диаграмм Венна (рис. 1.1). На этом рисунке поясняемые понятия выне-

сены на полочку. Соответствующие им события заштрихованы.

Примеры

Пример 1.1а. Однократное бросание игральной кости. Как и раньше, пусть А,,,., —

событие «число выпавших очков четное», а Л<5 — событие «выпало менее пяти

очков». Тогда сумма этих событий происходит, когда выпало или четное число

очков, или когда это число менее пяти: Ачет + Л<5 ={<»,, со2, со3, со4, со6}. Иными

словами, она происходит всегда, когда число выпавших очков не равно пяти.

Произведение этих событий наступает при двух элементарных исходах: число

выпавших очков должно равняться двум или четырем: АчетА<5 = {со2, со4}. Раз-

ность Л<5 - Ачет означает событие «число выпавших очков меньше пяти и нечет-

ное» : Л<5 -Ачет ={®i, ®3}.

Пример 1.2а. Двукратное бросание игральной кости. Произведение двух событий

А. «число выпавших очков на обоих гранях совпадает» и Az=10 «сумма выпавших

очков равна десяти» есть событие, состоящее из одного элементарного собы тия.

Их разность А. - Az=10 = {И, 22, 33, 44, 66}.

Пример 1.3а. Бросание монеты. Событие «герб выпал до пятого бросания, при-

чем это было бросание с четным номером» можно представить в виде произведе-

ния A4„As4 событий А,1ет и As4. Разность As4 -Ачет ={Г, РРГ} означает событие

«герб выпал до пятого бросания, причем это было событие с нечетным номером».

Пример 1.4а. Задача о встрече. Произведение АВ означает событие «оба прияте-

ля пришли до половины первого и встретились», в то время как разность А В,

что «они пришли до половины первого, но не встретились». □

Между событиями существуют различные отношения. С одним из них мы уже

познакомились, это отношение эквивалентности событий =. Рассмотрим другие

важные отношения.

Определение 7. События называются противоположными, если каждое из них

содержит те элементарные события, которые не содержит другое событие. Если

А — некоторое событие, то противоположное ему событие обозначается А, при

чем это противоположное для А событие единственно. Если некоторое событие

произошло, то противоположное ему событие не произошло, и наоборот.

Противоположное для А событие можно формально определить так:

А = {со е Q: со g А}. Поскольку одновременное наступление события А и противо-

положного ему события А невозможно, то А-А =0. Из определения следует

также, что одно из этих событий происходит обязательно, поэтому А + A =U.

Понятие противоположного события позволяет выразить разность событий и

виде произведения: А -В = АВ.

Определение 8. События А и В называются несовместными, если они не содер-

жа! общих элементарных событий, то есть одновременно наступить не могут,

I fl______________________________

I. I ipiA«!|JCinVI<KS да1 VN*Vn Ш|Л1ИЛ vw«t>r«r<

Следовательно, их пр<>и hkiu une <<и. невозможное событие; AB = 0. О событиях

At, A.,,... loiiop,n, hi.и nonti/mo несовместны, если никакие два из них не со-

IIMCI TIII.I

Онридвпини» u 11 ни i| »i ।, что событие А влечет событие В, и записывают это как

I /<. ci мн luirtoior ,iнемец гарное событие из А входит в событие В. Наступление

Пып1>| Л iiiii'Mei наступление события В. Очевидно, А В = А, А + В = В.

'нрндинокпо К) События А,, А2,..„ Ak образуют полную группу событий (ина-

i< pa.ifHieiiiie пространства Q), если они; попарно несовместны; не невозмож-

ны, и < умме дают все пространство элементарных событий, то есть достоверное

событие 12. События полной группы называют гипотезами.

Рисунок 1.2 дает графическое представление полной группы событий.

Рис. 1.2. Полная группа событий

Примеры

Пример 1.1b. Однократное бросание игральной кости. Противоположным собы-

тию Ачст является событие Ачет ={«>t, о>3, о>5} — «число выпавших £чков нечет-

но». Если В = {ш2, со 4} — событие «выпало два или четыре очка», то Ачет и В — не-

совместные события. Ясно также, что событие В влечет событие Ачст. События В,

Л и (oG образуют полную группу событий.

Пример 1.2b. Двукратное бросание игральной кости. События At_5: «сумма вы-

павших очков не больше пяти», А6_9: «сумма выпавших очков составляет от шес-

ти до девяти» и А10_12: «сумма выпавших очков больше девяти» образуют пол-

ную группу событий. □

Компьютерный практикум № 1.

Операции над событиями в пакете Mathcad

Общие положения

I [астоящий практикум открывает цикл работ, выполняемых на персональном

компьютере (ПК). В первой части книги при решении задач теории вероятно-

стей будем использовать пакет Mathcad, во второй части при решении задач ма-

тематической статистики — пакет STATISTICA. Выбор данного программного

обеспечения не случаен. Оба пакета представляют собой интегрированные мно-

гофункциональные системы, предназначенные для проведения разнообразных

вычислений. Они получили широкое распространение и достаточно хорошо

описаны и отечественной Jinrcpaiуре (см. список литературы н конце киши)

При наложении материала практикумов авторы не ставили своей целью полное

научение данных пакетов, а стремились показать, каким образом задачи теории

вероятностей и математической статистики могут быть решены па ПК. Для ус

пепиюго прохождения компьютерных практикумов не требуется предвари гель

пая подготовка по пакетам программ или программированию для ,')ВМ. 11собхо

дпмые для работы сведения будут излагаться по мере изучения практикумов

Дополнительный справочный материал по пакетам Mathcad и STAT1STICA

можно найти в литературе [1, 6]. Читатель, прошедший все практикумы, не голь

ко закрепит теоретический материал курса и решит разнообразные практические

примеры, но и приобретет умение работать с пакетами Mathcad и STATISTIC’Л,

а говоря более обобщенно — умение программировать. Отметим также, что мало

подготовленный читатель может пользоваться представленными программами,

не особенно разбираясь в логике их работы. Для более подготовленного читате-

ля представляются широкие возможности усовершенствования и развития этих

программ.

Цель и задачи практикума

Целью практикума является компьютерная реализация основных операций над

событиями в среде Mathcad.

Задачами данного практикума являются:

□ задание пространства элементарных событий и отдельных событий;

□ проверка принадлежности данного элементарного события составному собы

тию;

□ выполнение операций суммы, произведения и разности событий.

Необходимый справочный материал

В процессе работы в пакете Mathcad создаются документы, которые могут содер-

жать формулы, программы, комментарии, результаты вычислений и графики.

11ростые вычисления реализуются посредством ввода соответствующих формул,

для организации сложных вычислительных процессов составляются программы.

Формулы могут иметь вид арифметического выражения, которое необходимо

вычислить, или вид определяемой функции. Достоинством пакета является про

с гота представления формул, которые имеют естественную запись. Программы

на Mathcad оформляются в виде программных блоков (см. ниже). При вводе

конструкций Mathcad рекомендуется использовать вызываемые на экран палит

ры инструментов, содержащие множество математических символов, ключевые

слова и др. Рядом с выражениями рекомендуется вводить комментарии, которые

поясняют их назначения. Результаты расчетов также необходимо сопровождав ь

комментариями. Ввод формул, программ и текста производится в любом меги-

рабочего окна. При этом для каждого выражения и фрагмента текста создается

своя рабочая область, ограниченная обычно невидимым прямоугольником (этот

прямоугольник становится видимым при вводе в него курсора и нажатии па ле-

вую кнопку мыши).

Документ в Mathcad образуется из совокупности всех рабочих областей, создан

пых пользователем, при сохранении он получает расширение .med.

IO

1. Пространство элементарных событий

В системе Mathcad использую гея три средства для ввода и редактирования эле-

ментов документа, одно из которых обязательно присутствует на экране. Рас-

смотрим подробнее эти средства.

Крестообразный курсор или визир (красный плюс) используется для размеще-

ния новых выражений, графиков и текстовых областей. Отмечает место в рабо-

чем документе, где должна появиться новая область.

Маркер ввода (вертикальная черта) подобен аналогичному средству в текстовом

редакторе. Он используется для удаления и вставки отдельных символов и эле-

ментов.

выделяющая рамка, по сути, является двумерным маркером ввода (имеет синий

цвет) и предназначена для работы в математической и графической областях.

Выделяющая рамка широко используется при вводе и редактировании матема-

। ических выражений. При этом действует следующее важное правило: то, что за-

ключено в выделяющую рамку, становится операндом следующего вводимого

оператора. Правильное использование выделяющей рамки позволяет избежать

многих ошибок, связанных с неправильным порядком выполнения математиче-

ских операций. Имеется несколько способов заключить часть выражения в выде-

ляющую рамку. Один из них — поставить маркер ввода на требуемое место и на-

жать клавишу «пробел» нужное число раз. Другой способ — отметить мышью

нужное выражение, и используя клавиши, обозначенные стрелками, перемещать

курсор ввода в нужном направлении.

Вид окна Mathcad 2001, содержащего примеры различных объектов языка и ре-

зультаты вычислений, показан на рис. 1.3. Все примеры снабжены текстовыми

комментариями. Окно имеет стандартную для окна приложения MS Windows

cipyicrypy. Верхняя строка окна содержит имя приложения Mathcad Professional

(альтернативным является использование Mathcad 6+, Mathcad 7 и др.), имя

файла, в котором сохраняются результаты работы, (в нашем случае это имя

examples) и справа — размерные кнопки для работы с окном. Вторая строка окна

содержит команды прикладного меню. Это меню имеет набор стандартных для

приложений MS Windows групп команд: File, Edit, View, Format, Windows, Help,

а также две специфичные группы Math (Математика — операции управления

вычислениями) и Symbolics (Символьные вычисления — операции символьной

математики). Следующие три строки содержат панели инструментов. Многие

инструменты должны быть известны читателю, так как они имеются в болыпин-

сгне приложений MS Windows. Среди инструментов, специфичных для Mathcad,

следует указать кнопку f(x), которая открывает список встроенных функций,

а также инструменты панели математических операций, которая в нашем случае

расположена в пятой строке окна. Эта панель содержит кнопки запуска девяти

палитр инструментов, предоставляющих пользователю множество математи-

ческих символов, ключевые слова, шаблоны и многие другие символы, которые

облегчают набор базовых конструкций Mathcad. Для того чтобы узнать название

отдельных палитр, достаточно навести на соответствующую кнопку (иконку)

курсор мыши. Следуя слева направо по группе кнопок, поясним назначение каж-

дой из палитр:

U Calculator Toolbar — панель калькулятора, содержит общие арифметические

операторы; л

V 1\

Комньюшрный прак1икум № I. Операции над (лИплинми и намни Mathcad

19

□ Graph Toolbar — панель графиков, содержит набор двух- и трехмерных графиков;

□ Vector and Matrix Toolbar — панель матричных и векторных операции;

□ Evaluation Toolbar — панель вычислений, содержит набор знаков, iiciio.in..iye

мых в математических выражениях (равенство, тождество и др.);

□ Calculus Toolbar — панель операций математического анализа (нронзиодныс,

интегралы, пределы, произведение и др.);

□ Boolean Toolbar — панель отношений, содержит знаки операций сравнения;

□ Programming Toolbar — панель программирования, содержит набор базовых

операторов языка Mathcad;

□ Greek Symbol Toolbar — панель греческих букв;

□ Symbolic Keyword Toolbar — панель ключевых слов языка Mathcad.

Отметим, что в отдельных версиях пакета Mathcad часть из перечисленных на

литр вызывается с использованием команды прикладного меню View-Toolbars.

Mathcad Professional г (examples)

Г"‘ ,-| »।Л.

'Й-Н

Примеры использования различных конструкций языка MATHCAD

Пример 4. Программа вычисления факториала числа п

Fact(n) :• f <- 1

Пример 1. Вычисление арифметического выражения

и Р. . /е _ 1 то

Пример 2. Вычисление алгебраического выражения

i2 + b2 - 5

а 3 b := 4

Пример 3. Вычисление таблицы значений функции

2

х-1,2.8 у(х) - а х +Ьх+1

У(х)-

_____8_

21

~~4o'

65

96

133

176

225

for I« In

Пример 5. Построение графика функции у(х)

Факториал числа 6 равен: Fact(6) - 720

Рис. 1.3. Окно Mathcad с примерами вычислений

L*J J

Ргги Fl fa

Под строками инструментов находится окно рабочего документа, в котором рас

полагаются все введенные выражения, операторы и результаты расчетов. Содер

жимое окна документа можно редактировать, форматировать, сохранять и выно

лить на печать. Под текстом «пример 4» можно увидеть крестообразный курсор,

который отмечает место в рабочем документе для ввода нового объекта.

1(цжпяя строка окна приложения называется строкой состояния. Она содержи i

рекомендацию пользователю (Press F1 for help — для получения справки важаи

1. Пространство элементарных событий

клавишу F1); информацию о режиме работы (и пашем случае Auto соответствует

режиму автоматических вычислений); помер текущей страницы рабочего доку-

мента (в пашем случае Раде 1 - первая страница).

/1./1Я выполнения операций над событиями в пакете Mathcad читатель должен

умен, работать со скалярами, векторами и матрицами, которые могут быть по-

стоянными или переменными; использовать функции от одной или нескольких

переменных; составлять программы, реализующие в среде Mathcad типовые вы-

числительные процедуры.

Задание скаляров, векторов и матриц в пакете Mathcad осуществляется с помо-

щью оператора «присвоить», обозначаемого :=. Слева от этого оператора стоит

идентификатор (имя, обозначение) объекта, а справа — определяющее его выра-

жение. Например, п: = 5 означает, что п является постоянной величиной, равной

пяти.

Н программах на Mathcad довольно часто используется оператор внутреннего

локального присваивания, действующий внутри программы и обозначаемый сим-

волом . В этом случае присвоенное значение сохраняется только в теле про-

|раммы. Например, выражение х <— 15 присваивает переменной х значение 15

внутри программы; за пределами тела программы значение переменной х либо

является неопределенным, либо равно значению, которое задано вне программ-

ного блока.

Часто необходимо указать множество значений, которые может принимать ска-

лярная переменная. Если речь идет о переменной г, которая пробегает целые зна-

чения от 0 до п, то это записывается в виде 1 := 0 .. п. Как правило, такое выра-

жение используется для описания области действия целочисленных аргументов

функции, а также индексов векторов, матриц и циклов.

Рассмотренные выше символы := и .. набираются путем нажатия на клавишу

«Ж» и «ж», соответственно. При этом заглавные буквы, как обычно, получаются

пажа гнем па клавишу «Shift». Альтернативным способом является использова-

ние «кал ькулятора».

Для задания вектора или матрицы следует выполнить команду прикладного меню

Insert Matrix... или активизировать соответствующую кнопку (иконку) на палит-

ре инструментов Vector and Matrix Palette. В результате этих действий появляется

окошко Insert Matrix, в котором пользователь должен задать требуемое число

строк и столбцов матрицы. Для вектора-строки указывается одна строка, а для

вектора-столбца — один столбец. После ввода размеров матрицы следует нажать

на кнопку Insert, и в окне редактирования на экране появится шаблон вектора

пли матрицы заказанных размеров с пустыми клеточками.

Следует обратить внимание на то, что нумерация строк и столбцов начинается

< пулевого элемента, так что при размерности вектора, равной п, его последняя

компонента имеет номер п-1. Важно также помнить, что Mathcad оперирует

<• векторами-столбцами. Он выдаст ошибку, если мы попытаемся обратиться к

конкретному элементу вектора-строки. Поэтому перед началом работы с век-

тор-строкой ее следует транспонировать в вектор-столбец. Эта операция осуще-

ствляется или вручную (приписыванием буквы Т сверху справа над вектором

Компьююрный практикум Nt 1. Операции н.щ иЛшинми и h.imhu m.iIIk .kI

или матрицей) или автоматически (вызовом этой буквы с напели нп< грумепгоп

Vector and Matrix Palette).

В пакете Mathcad используется сотни встроенных функций, причем их количсс!

во в новых версиях пакета становится все больше. Функция имеет аргументы.

записываемые в круглых скобках после имени функции. Они могут бы ть число

выми константами, переменными с буквенными обозначениями или математи

ческими выражениями, вычисляющими численные значения. Вызов наиболее

известных элементарных функций может осуществляться непосредственно пу-

тем ввода соответствующих обозначений, например, sm(0.4), co.v(.r), е\р(а),

1п(2.3) и т. д. Для облегчения процедуры ввода встроенных функций рскоменду

ется использовать кнопку/(х) палитры инструментов или команду прикладного

меню Insert—Function... После ввода данной команды открывается окно, содер

жащее список имеющихся функций, из которого необходимо выбрать нужную.

В последних версиях пакета эти функции разбиты на тематические разделы.

Выбор отмеченной курсором функции фиксируется щелчком на кнопке lnsoil

диалогового окна, после этого функция переносится в окно текущею докумен ia.

В настоящем практикуме используются встроенные функции if, rows и cols.

Функция if имеет следующий формат: if(condition, а, Ь). Здесь condition - логи-

ческое условие. Это условие может представлять собой булево выражение пли

записываться с помощью символов «меньше» <, «меньше или равно» <., «боль

ше» >, «больше или равно» >, «равно» =, «не равно» * (все эти символы берутся с

панели инструментов Evaluation and boolean Palette). Слева и справа от символов

записываются сравниваемые скаляры (в виде постоянных или уже определен

пых к этому моменту значений переменных или функций). Далее, а — вы раже

ние, определяющее значение функции в случае, если условие condition выполне-

но; b — выражение, определяющее значение функции в случае, если условие

condition не выполнено.

При работе с векторами разной длины используются функции cols(M) и rows(M),

значения которых равны соответственно числу столбцов и строк матрицы М.

Например, если cols(M) = 6, то это значит, что матрица М имеет шесть столбцов.

В настоящем практикуме используется несколько функций пользователя для ра

боты с событиями, с этой целью были разработаны соответствующие програм

мы. Следует отметить, что Mathcad является постоянно развивающимся пакетом

программ. Каждая новая версия пакета предоставляет пользователю все новые

возможности. Так, в последних версиях (например, Mathcad 2002) имеются

встроенные функции для работы с множествами, а, следовательно, и с собы гни

ми, поскольку последние являются множествами. Ввиду учебного характера дан

ной книги мы рассмотрим ситуацию, когда такая возможность отсутствует и

пользователю необходимо самому создать соответствующие функции н опера ги

ры; при этом для реализации большинства рассматриваемых в книге примерив

достаточно иметь версию пакета не ниже Mathcad 6+.

Программирование в пакете Mathcad заключается в создании программных ми

дулей — блоков, выделенных слева отрезками жирных вертикальных прямых

Доступные элементы языка программирования (операторы) содержатся в напели

Programming, которая открывается при нажатии кнопки (иконки) ProQiamnuiHi

,, • Ifrwifzunwiuv «З/IQNRiniapnDIA UUVDIIMM

toolbar (см. рис. 1.4). /(ля набора в окне редактирования любого из данных опе-

ра горов необходимо щелкнута левой кнопкой мыши по соответствующей кнопке

на панели Programming. В результате откроется окошко, содержащее ключевое

слово и шаблон для ввода требуемых параметров (операнд).

Mathcad Professional - [Untitled:!]

Edit View Insert Formal Math Symbol

| Programming T oolbar]

if otherwise

for while

break continue

return on error

Рис. 1.4. Панель программирования Programming в окне Mathcad

Создание программных модулей предполагает знакомство читателя с основами

программирования, так как любой программный блок сначала необходимо за-

программировать. Создаваемый блок может иметь имя или не иметь такового.

В первом случае нужно набрать имя и в круглых скобках — формальные пара-

метры, если таковые есть. После этого необходимо записать символ присваи-

вания :=. Дальнейшие действия совпадают с действиями для случая, когда имя

программы не задается. Для ввода программного блока необходимо щелкнуть

левой кнопкой мыши по кнопке Add Line на панели Programming. В результате

этого действия в окне редактирования появляется вертикальная черта, справа от

нее высвечивается окошечко, в котором надо начать записывать текст програм-

мы. Повторное нажатие на клавишу Add Line создает дополнительные окошечки.

За первой вертикальной чертой могут следовать другие вертикальные черты,

в этом случае говорят о ступенчатой записи программы. Такая запись делает

прозрачной структуру вычислений.

Отметим, что набор базовых операторов пакета Mathcad ограничен и включает

всего восемь операторов (см. рис. 1.4), из которых мы будем использовать сле-

дующие:

□ <---оператор локального присваивания;

□ while — оператор цикла типа «пока»;

□ for — оператор цикла с фиксированным числом повторений;

□ if — условный оператор;

□ otherwise — оператор альтернативного продолжения (работает с оператором if).

Компышорный пракшкум № 1. ОГКЦМЩИИ ИИД (КОШИИМИ II II.IHIIII M.ltllUM av

В рассматриваемых в данном практикуме примерах программ кроме oia paiop.i

локального присваивания широко используется оператор цикла for. Для зада

ппя цикла for необходимо указа ть индекс цикла, диапазон изменения его значе

пип, а также описать выражение, многократно вычисляемое в цикле для разных

значений индекса цикла. Если индексом цикла является i, а диапазон изменения

сто значений 0, 1, 2,..., п, то цикл начинается с выражения for i е ()..//, за которым

следует вычисляемое в цикле выражение.

Для повышения наглядности вводимых выражений и программ в пакте

Mathcad мы будем использовать соответствующие комментарии. Наличие ком

ментариев существенно упрощает работу пользователя с ранее набранными и к

стами, а также помогает при работе с полученными результатами.

Реализация задания

Наша задача заключается в формировании нескольких составных событий и вы

полпенни над ними типовых операций. Будем представлять элементарные co6i.it пя

веп1ественными числами, а состоящие из них множества (в том числе прострзп

ство элементарных событий и составные события) — в виде векторов-с трок. Раз

мерность вектора совпадает с числом элементов множества, а значение компо

цент вектора — суть элементы множества, то есть вещественные числа. В пашем

примере рассматривается три составных события С, G и D, записанных в виде:

С = {1, 2, 3, 4, 5, 6, 7}, D = {4, 5, 6, 7, 8, 9, 10, 11} и G = {1, 8, 11, 9}. 11ад этими с<>

бытиями необходимо выполнит), основные операции.

Для реализации типовых операций над составными событиями используюк я

программные модули, тексты которых представлены на рис. 1.5. Каждый модуль

определяет пользовательскую функцию, имя которой вместе со списком фор

мальных аргументов указано в заголовке программы. Если мы хотим невольно

вать данные функции для проведения операций над событиями, то вместо фор

мальных аргументов следует подставить конкретные события, над коюрыми

проводятся операции. Функции пользователя имеют следующее назначение:

□ ProdNum(A, В) вычисляет число элементарных событий, общих для собьпий

А и В, то есть число |А В| элементарных событий произведения А В;

□ SumNum(A, В) вычисляет общее число различных элементарных ...... в

составных событиях Л и В, то есть число элементарных событий суммы A । II,

□ DifNum(A, В) вычисляет число элементарных событий, которые входят и со

бытие Л и не входят в событие В, то есть число элементарных событий разно

сти А - В;

□ Sum(A, В) определяет сумму событий А и В;

□ Prod(A, В) определяет произведение событий А и В;

□ Dif(A, В) определяет разность событий Л и В;

□ Arise(i, А) указывает, произойдет (возвращает значение 1) или нет (возврата

ет значение 0) событие А, если произошло элементарное событие i.

Напомним, что по умолчанию в Mathcad вектор понимается как столбец. Дли

перехода от строки к столбцу нужно транспонировать вектор-строку. (’ друпш

стороны, при выводе результатов мы также пользуемся операцией трат нонн

24

1. ПрОС1|> янтарных событий

ровапия, поскольку ваши функции дают результаты в виде векторов-столбцов,

которые занимают много места.

При разработке модулей были использованы встроенные функции if, rows и cols,

операторы присваивания := и а также оператор цикла for, рассмотренные

выше. В программах используются вложенные циклы, организуемые по двум

индексам i nj. Наличие в текстах программ соответствующих отступов и верти-

кальных линий позволяет определить тело каждого цикла.

Результаты вычислений

Полученные результаты представлены на рис. 1.6. Вычисления проведены для

трех событий С = (1 23456 7)т, D = (4 5 6 7 8 9 10 11)т и G = (1 8 11 9)т. Все ре-

зультаты снабжены комментариями и не требуют дополнительных пояснений.

Заметим, что наряду с разработанными пользовательскими функциями в вычис-

лениях используется встроенная функция rows, определяющая число элементар-

ных событий соответствующего составного события.

Практикуй Nt 1. Операции над событиями

Пользовательские функции

Число элементарных событий произведения Произведение событий А и В

событий А и В

ProdNum(A.B) := st~ 0 Prod(A.B).« for IeO. ProdNum(A.B) -

for leO.. rows(A) - 1 qe-0

fe-0 ne-0

for JeO.. rows(B) - 1 for ieO.. rows(A) - 1

f*-.f+If(Ai»Bj,1,0) f«-0

s <-s + if(f > 0.1,0) for j < 0. rows(B) - 1

s f<-f+if(Aj = Bj.1,0)

if f>0

Число элементарных событий суммы событий А и В

SumNum(A,B) rows(A) + rows(B) - ProdNum(A.B) | П П + 1

C

Число элементарных событий разности событий А и В

DifNum(A,B) := rows (А) - ProdNum(A,B)

Сумма событий А и В

Разность событий А и В

Sum(A,B) ••

for ieO.. row$(A) - 1

Q<-A|

n <- rows(A)

for leO.. rows(B) - 1

fe-0

for Je 0.. rows(A) - 1

f f- f+ if(A] « Bj.1.0)

If f.O

П П + 1

Dif(A.B) - fo i e 0 . DifNum(A.B) - 1

c^o

n <- -0

fo C led rows(A) - 1 f«-0 for JeO.. rows(B) - 1 Г«-1+И(Д| = В|.1.0) if fcO |C,.^Ai I n ♦— n + 1

Проверка наступления события A

Arise (i. A) -

f«-0

for j e 0 .. rows (A) - 1

f <-f + lf[i = (A),.1.0]

g lf(f > 0.1.0)

g

Рис. 1.5. Реализация типовых операций над событиями

17. КОМОИН.ЩИИ (.()1)Ы1ИИ

I’VUJlblVUI 1Ы‘1И1Ли11ИИ

Исходные собьния: С-(1 2 3 4 Л И // 0 - (4 5 6 7 в 9 1U 11 )l G -(1 II 11 II)’

1. Число элементарных событий а) е составных событиях: rows(C) - 7 rows(D) - В rows(G) - 4 cols((1 2 4 9 0))-5

б) в произведении деух событий: ProdNum'C, D) > 4 ProdNom(G,C) - 1

в) в сумме деух событий: SumNum(C.D) - 11 SurnNum(C,G) - 10

г) в разности двух событий DifNum(D.C) - 4 DlfNum(D.G) - 5

2. Проверка принадлежности элементарного события Arlse(4.C)-1 Arise(11 ,С) - 0 Ar Ise(21,(1 34 07 21 22)’) . 1

3. Операции над событиями а) произведение: Prod(C,G)T -(1) Prod(c,(1 б) сукна: Sum(c,(1 7 11)’) .(1234567 в) разность; 011(0, С)’ -(В 9 10 11) 5 7 И)’ / - (1 5 7) И)

4, Комбинация событий

F - Dlf(D,Sum(C,G)) f’-(W)

Arlse(I.F) - 0 Arise(1, Dif (D ,Sum(C. G))) - 0 Arise(10,F) - 1 1 Arlee(10,Dlf(0,Sum(C.G))) -

Рис. 1.6. Результаты выполнения операций над событиями

Задания для самостоятельной работы

I. Апробировать приведенные на рис. 1.5 программы для различных (читанных

события А, В, ...

2. Описать логику работы программных модулей ProdNum(A, В) и Prod(A, /<)

3. Составить программу, вычисляющую симметрическую разность событий .1 и И,

определяемую как (А - В) + (В - А).

1.2. Комбинации событий

Введенные выше операции отрицания, суммы, произведения и разности собы i nii

позволяют образовывать новые события из уже имеющихся, то есть осунцчтп

лить комбинации событий. Комбинации событий записываются в виде формул,

содержащих исходные события, а также символы — операций отри

цаиия, суммы, произведения и разности. Последовательность выполнения one

раций в формулах обычно определяется скобками. Количество скобок можно

сократить, если договориться о приоритете (порядке выполнения) операций

Общепринятой договоренностью является приоритет произведения над суммой,

аналогичный приоритету умножения над сложением в арифметике и алгебре.

'Гак, А + В • С является сокращенной записью А + (В • С). Оно представляет собой

событие, которое наступает только тогда, когда наступает или событие А или оба

события В и С. Далее, F = В • (А + С) представляет собой событие, которое пасту

идет, когда не наступает событие В и наступает или А или С.

Формулы, описывающие комбинации событий, можно преобразовывать, ш ноль

зуя следующие свойства операций суммы и произведения событий:

□ коммутативность-.

А + В = В + А, АВ = В-А;

□ at < оциашнаиш mi>;

(A + B) +С = A+(B + С) = Л + В + C,

(А -В) С = A (B С) = A -В C;

□ дистрибутивность-.

A(B + C) = AB + AC,

(AB)+C = (A +C)(B + C);

□ идемпотентность-.

A + A = A,

AA = A;

□ поглощение-.

если А с В, то A + В = В, А - В = A.

Справедливость этих свойств следует непосредственно из определений суммы

и произведения событий.

()i мстим, что отрицание А также можно рассматривать как унарную операцию,

применяемому к одному событию А. Для него справедливы следующие свойства:

Х=А, А = В=>А=В, А = В=>А=В.

С от рицанием также связаны свойства, называемые законами де Моргана'.

А + В = АВ, А^В = А+В. (1.4)

11а эт их формулах мы сейчас проиллюстрируем общий метод доказательства эк-

вивалентности двух событий G и Н, то есть того, что G = Н. Доказательство со-

стоит из двух этапов. Вначале доказывается, что из того, что со е G, следует, что

<о с II. Следовательно, G с Н, то есть событие G влечет событие Н. Потом рас-

сматривается обратное утверждение: из условия со е Н следует, что со е G.

Следовательно, Н с G, то есть в действительности G = Н.

Итак, докажем первое равенство (1.4). Для этого необходимо убедиться в том,

что А + В с: А В, и наоборот, АВ с А + В. Пусть со е А + В. Тогда со g А + В. Но это

значит, что одновременно со g А и со g В. Отсюда следует, что одновременно со е А

и со е В, то есть со е А В. Итак, доказано, что из соеЛ + В следует со е А В, иначе

А + ВсАВ.

/(ля доказательства того, что АВ с А + В, достаточно посмотреть предыдущую

цепочку формул в обратном порядке. Следовательно, первое из равенств (1.4)

доказано.

Для доказательства второго равенства (1.4) подставим в первое равенство А вме-

сто А и В вместо В. Тогда

А+В = АЁ = АВ, А+В = АВ.

Доказательство формул (1.4) закончено. □

Итак, комбинация событий также является событием. Как и любое событие, это

событие наступает, если наступает некоторое элементарное событие, входящее

в него. Например, если А = {©р со3, со4, со7}, В = {сор со2, со4}, Н = {со3, со5, со6, со7},

то комбинация событии (/ All i li (<°i. <'»2, (0.i> (l,o ">/} наступает, если na< ly

uric г любое из элементарных событий <о,, <о2, (»>:,, <ол, <о7.

Однако в формулах, описывающих комбинации событий, элементарные события

обычно явно пс фигурируют. В этом случае наступила или нет комбинация со

бытии определяется тем, наступили или нет входящие в комбинацию cociэнные

события. Как определить факт наступления комбинации событий на основе ни

формации о том, какие из входящих в него событий наступили, а какие не нэп у

пили? Для этого следует использовать понятия теории булевых функций (иначе

функций алгебры логики или логических функций). Это осуществляется следую

щим образом.

Пусть комбинация включает события Ль Л2, ..., А„. Событию Л,- поставим в кин

ветствие булеву переменную х,, принимающую только два значения: х, = 1, е< ли

событие Л,- наступило, и х,- = 0, если событие Л,- не наступило, то есть наступ и во

событие Лг. Комбинации событий G поставим в соответствие булеву перемен

пую у, равную 1, если комбинация наступила, и равную 0 в противоположном

случае. Переменная у выражается через переменные х, с помощью операций

конъюнкции, дизъюнкции и отрицания. Конъюнкция соответствует пронэнеде

нию событий и описывает логическую связку «и-и». Дизъюнкция соответствуй!

сумме событий и описывает логическую связку «или-или». Отрицание cootuci

ствует противоположному событию и описывает логическое «не». Разность со

бытий Л - В может быть вычислена как ЛД. Обычно операция конъюнкции изо

бражается символом &, операция дизъюнкции v, отрицания —. Таблица I 1

содержит значения этих операций. Мы видим, что значения конъюнкции равны

минимуму из аргументов (может быть, нескольких), а значения дизъюнкции

максимуму. Принято, что конъюнкция имеем приоритет в очередности вы полис

ния перед дизъюнкцией.

Таблица 1.1. Операции конъюнкции, дизъюнкции и отрицания

*1 х2 хх& х2 Хг V х2 *1

0 0 0 0 1

0 1 0 1 1

1 0 0 1 0

1 1 1 1 0

Теперь значение у можно вычислить как значение булевой функции g(xt,x2,.г„),

которая получается, если в выражении для комбинации G заменить Л, па х„ спм

вол произведения_на конъюнкцию, символ суммы на дизъюнкцию. Например,

если G = Л| • Л2 + А, (Л3 + Л4 X то g(xt ,х2,х3,х4 ) = х, &х2 v х{ &(х3 v х4). Так.

если события Л! и Л3 не наступили, а остальные наступили, то xt = 0, х2 = 1, хл О,

х4 = 1 и мы имеем g(0, 1, 0, 1) = 0 & 1 v 0 & (0 v 1) = 1, что соответствует действн

тельности.

Поскольку мы работаем только со значениями 0 и 1, то операции конъюнкции

и произведения тождественны, в связи с чем можно вместо символа конъюнкции

28

1. Пространство элементарных событий

& использовать символ умножения • или вообще опускать его. В этом смысле

дизъюнкцию v с суммированием отождествлять нельзя, однако все-таки можно

использовать суммирование, но результат заменять на единицу, если он больше

нуля. Отрицание х вычисляется как х = 1 - х. В результате вместо булевой функ-

ции g(x\, х2.хп) мы получаем арифметизированную функцию gA(xr х2......х„).

Если последняя больше нуля, то булева функция Дх^х^, •> хп) равна единице:

g(x„x2, ..., хя) = if (gA(xbx2, ..., хя) > О, 1,0).

В частности,

xt v х2 v ... v хп = if (х( + х2 + ... + х„ > 0,1, 0).

Здесь используется оператор Mathcad if, в записи которого первой фигурирует

логическое условие, за которым после запятой следует значение, выдаваемое,

если условие выполняется, далее — значение, выдаваемое, если условие не вы-

полняется.

В случае когда элементарные события явно не фигурируют в комбинации собы-

тий, можно поступать и другим способом. Сейчас мы покажем, как можно по-

строить искусственное пространство элементарных событий на базе событий,

фигурирующих в комбинации. Это позволит нам в дальнейшем рассчитывать ве-

роятности наступления комбинации событий.

Снова рассмотрим комбинацию G, включающую п событий А1; А2, ..., Ап. Как

и ранее, пусть 1 означает наступление события, а 0 — ненаступление события.

Тогда конкретная реализация событий в данном испытании описывается «-мер-

ным булевым вектором (а1; а2, ..., а„). i-я компонента этого вектора я,- относится

к событию А). Иными словами, вектор (яь а2, ..., а„) описывает наступление или

ненаступление всех событий в рассматриваемом испытании. Подчеркнем, что в

отличие от переменной xjt которая может принимать оба значения 0 и 1, значе-

ние я, фиксировано. Мы будем рассматривать вектор (яь а2, ..., а„) как элемен-

тарное событие со, то есть <о= (ait а2, ..., я„): в рассматриваемом «испытании» мы

имеем такие исходы для событий.

С помощью булевого вектора (яь а2,..., а„), или просто а^ а2... ап, можно описать

элементарное событие и другим способом, а именно, как А”1 А“2 ... А“", где

А(, если я, =0,

А,, если ai =1. |

Например, 0101 означает реализацию события Д А2 А3 А4, в которой события

А2 и А4 наступили, а события Д и А3 — нет.

Очевидно, элементарных событий столько, сколько различных «-мерных буле-

вых векторов. Обычно множество таких векторов обозначается В", где В = {0, 1}:

В” = {(яь а2,..., я„): V я, е{0, 1}}. Следовательно, наше пространство элементарных

событий Q =В". Легко видеть, что число различных «-мерных булевых векторов

равно 2", следовательно, число элементарных событий |Q| = 2".

Теперь можно выразить исходные события Аь А2, ..., А„ через эти элементарные со-

бытия: а именно, событие А, состоит из тех элементарных событий <о= (яь а2,..., я„),

в записи которых на месте буквы я, стоит 1:

А, = {со = («], а2.ап) еQ: я, = 1}.

А“< =

। । i вычурная надежность систем

29

Н । .iK, каждое элементарное событие описывается и-мерным булевым вектором

<п - а2, а,,). Оперировать с такими векторами неудобно. Лучше все их перс

нумеровать и присвоить им имена, совпадающие с соответствующими номерами

ho (>удет в точности совпадать с обозначениями элементарных событий, кото

рым и мы пользовались в программах, разработанных ранее для Mathcad.

/1чч десятеричной нумерации булевых (иначе — двоичных) векторов исполину

ин III)(' код (Binary Decimal Code). Этот код хорошо знаком из начальных кур

ши информатики. Булев вектор 010 означает число 2, 0101 — число 5, 1110

чи< ч<> 14 и т. д. Справа располагаются младшие разряды, а слева — старшие,

II < амом младшем (самом правом) разряде указывается число единиц. Во втором

I и।Ына разряде — число двоек, потом число четверок, восьмерок и последующих

• о цепей числа 2. г-й справа разряд (z = 1, 2, ..., п) содержит количество чисел,

равных двум в степени г-1. Следовательно, для булева вектора а = (аь а2, ..., ап)

III )С код есть

BDC(a) = £а;2"-‘. (15)

м

Примнр 1.6. Пусть имеются три исходных события А(, А2, А3 и две комбинации

нм / Л, • А2 + А:1 и G = А2 •'А3. Итак, событие Fпроисходит, если наступает или

11ifii.i। не А, или событие Аь но не А2. Событие G наступает, если наступают и А2,

н I, Н данном случае п = 3, а пространство элементарных событий выглядит

mi' О {ООО, 001, 010, 011, 100, 101, 110, 111}. В частности, элементарное

' на । ис 011 означает, что событие Aj не наступило (а( = 0), событие А2 наступи

in {а, равно I), событие А3 также наступило (а3 = 1). Десятичный код этого эле

мен ирного события равен 3.

1Ь читные события теперь представляются так:

.1, {001, 011, 101, 111}, Л2 = {010, 011, ПО, 111}, Л, = {100, 101, ПО 111}.

I'iii । m.iiрпнаемые комбинации выражаются через элементарные события сле-

дующим образом: G = {011, 111}, F= {001, 011, 100, 101, 111}. □

Мы Путем использовать эту систему представления событий и их комбинации в

। и i\ iniiii'M разделе при описании структур логических систем, а также при со

Цйптснии компьютерных программ.

1.3. Структурная надежность систем

II iii'puu надежности рассматриваются системы, состоящие из элементов. Каж

и.hi i h’Mcht может находиться в одном из двух возможных состояний: рабою

< । в и । ю । в >м (исправном) и неработоспособном (состоянии отказа). Система так

«в iimci'i loni.KO дна состояния: работоспособное и состояние отказа. Состояние

linn мы выражается в виде некоторой комбинации состояний составляющих

и mi в и in (обозначим п число элементов системы. Пусть А,- означае т собы тис

ii’mi и । находится в работоспособном состоянии», А, означает пеработоспо

iiitiiiiie ini 1ОЯНИС этого элемента. Для системы аналогичными событиями буду

II раТииогиогобпое состояние, Л неработоспособное состояние.

11рн не,тем ( hi в > 1111 ы с сипы споем, рассматриваемые в теории падежное i н.

30

1. Пространство элементарных событий

Последовательной называется система, в которой отказ любого элемента при-

водит к отказу системы (см. рис. 1.7, а). Иначе говоря, система будет работо-

способна, если работоспособны и первый, и второй, и все другие элементы. Это

соответствует операции умножения событий. Следовательно, условие работо-

способности последовательной системы записывается в виде

в = А-а2....-а„. (1.6)

Соответствующая булева функция имеет вид:

gs(Xj ,х2,...,х„) = х,&х2&...&х„. (1.7)

Параллельной называется система, которая остается работоспособной, пока рабо-

тоспособен хотя бы один ее элемент (см. рис. 1.7, б). Иначе говоря, система будет

работоспособна, если работоспособен или первый, или второй, или какой либо

пл последующих ее элементов. Это соответствует операции сложения событий.

Следовательно, условие работоспособности параллельной системы записывается

в виде

B = At +А2 +... + А„. (1.8)

Соответствующая булева функция имеет вид:

g/,(x1,x2,...,x„) = x1 v х2 v...v х„. (1.9)

а б

Рис. 1.7. а — последовательная и б — параллельная системы

В общем случае говорят о последовательно-параллельной системе, если ее можно

разбит ь па последовательные или параллельные подсистемы, которые соедине-

ны между собой также последовательно или параллельно. Условие работоспо-

собности таких систем представляет собой комбинацию вышеприведенных усло-

вий для последовательных и параллельных систем.

Принятая графическая схема последовательно-параллельной системы приведена

па рис. 1.8. Элементы системы изображаются на схеме прямоугольничками. Сис-

тема считается работоспособной, если существует хотя бы один путь, ведущий

от левого конца схемы к правому ее концу и проходящий только через исправ-

ные элементы. Для последовательно-параллельной системы, изображенной на

pin 1.8, событие «система работоспособна» записывается так:

В = (Л, +Л2) А, (Л4 • Л5 +Л,;).

Соогвек твующая булева функция записывается в виде:

g (•' I , Л'2 , х2, Л 4 , Л 5, Хв ) = (Х| V х2 ) & Л ч & ((Х4 & Xj ) V Л о ).

Компьютерный практикум № 2. Комбинации событий в пакете Mathcad

31

Рис. 1.8. Последовательно-параллельная система

Пример 1.7. Система «два-из-трех». Так называется система из трех элементов,

которая является работоспособной, когда работоспособны хотя бы два элемеша

Следовательно, условие работоспособности системы имеет вид:

В =А,А2 + А,А3 +Л2Л3. (1.10)

Соответствующая булева функция

g(Xj, х2, х3) = (Xj &х2 )v (xt &х3 )v (х2&х3).

Применим технику, изложенную в конце предыдущего раздела, для этого при

мера. В данном случае число исходных событий равно 3. Следовательно, имеем

23 = 8 элементарных событий и следующее пространство элементарных событий:

Q = {ООО, 001, 010, 011, 1007 Ю1, 110, 111}. Исходные события представляю гея

теперь так: Л3 = {001,011,101,111}, Л2 = {010,011,110,111}, Л, = {100,101, 110, 111}

Следовательно, В = {111, 110, 101, 011}. □

Компьютерный практикум № 2.

Комбинации событий в пакете Mathcad

Цель и задачи практикума

Целью практикума является приобретение практических навыков в описании

различных комбинаций событий и определении факта их наступления или пена

ступления в зависимости от наступления других составных и элементарных со

бытий.

Основной задачей данного практикума является построение искусственного

пространства элементарных событий на базе событий, фигурирующих в комби

нации. В качестве иллюстрации рассматривается исправность системы «два-из

трех».

Необходимый справочный материал

В настоящем практикуме кроме конструкций пакета Mathcad, описанных выше,