Текст

МЕТОДЫ ОПТИМИЗАЦИИ

В СТАТИСТИЧЕСКИХ

ЗАДАЧАХ УПРАВЛЕНИЯ

Москва «МАШИНОСТРОЕНИЕ» 197 4

M4i

УДК 62.505

W**

I Щ

Методы оптимизации в статистических задачах управления.

Батков А. М. и др. М., «Машиностроение», 1974, 240 с.

Книга посвящена вопросам проектирования систем

автоматического управления в условиях случайных воздействий. Изложены

методы расчета показателей точности нелинейных стохастических

систем управления. Рассмотрены также задачи анализа

специального класса автоматических систем, описываемых линейными

дифференциальными уравнениями со случайными коэффициентами.

В книге представлены современные методы параметрической

оптимизации, позволяющие выбрать оптимальные значения

параметров системы управления при заданной структуре. Приведены

основные методы расчета оптимального управления стохастическим

объектом: динамическое программирование и стохастический

принцип максимума.

Книга рассчитана на инженеров, работающих в области

проектирования систем автоматического управления, научных

работников, преподавателей и аспирантов.

Табл. 2. Ил. 49. Список лит. 157 назв.

Автор,ы книги:

А. М. Батков, д-р техн. наук (п. 1—5 гл. V); В. М. Александров, канд. техн.

наук (п. 5 гл. I, гл. III, приложение); А. О. Мишулина, канд. техн. наук

(п. 4 гл. I, гл. II, п. 1—-6 гл. IV, п. 6 гл. V); А. Н. Староверов, канд. техн. наук

(п. 1—3 гл. 1); Б, Л. Щукин, канд. техн. наук (п. 7, 8 гл. IV).

Рецензент д-р техн. наук проф. Н*-#.Андреев -~™~?гГ

30501 74 ^- *

М 038(01)-74 270-74 ^ Ц £^ -$/) ~"V4

© Издательство «Машиностроение», 1974

, ПРЕДИСЛОВИЕ

Проблема проектирования системы управления в значительной степени

сводится к проблеме оптимизации. Эта проблема охватывает широкий круг задач,

некоторые из которых, как, например, принципы формирования критерия

оптимальности системы или выбора совокупности параметров, подлежащих настройке,

решаются в настоящее время на неформальном уровне. Проблема оптимизации

включает в себя также^расчет заданных показателей функционирования системы

в условиях случайных возмущений, выбор оптимальных значений параметров

системы, определение оптимального управления динамическими объектами, для

которых разработаны аналитические методы.

Современный этап развития теории оптимизации систем, автоматического

управления характеризуется совершенствованием и широким внедрением

аналитических й численных методов расчета систем. Дальнейшее развитие получили

теория аналитического конструирования регуляторов, динамическое

программирование, стохастический принцип максимума. Все более широкое применение

находят методы оптимизации, основанные на использовании возможностей

цифровых вычислительных машин.

Предлагаемая читателю работа содержит описание ряда методов решения

статистических задач оптимизации, развитых в последние годы и нашедших

применение в инженерной практике. Авторы не ставили перед собой задачи

обобщения и описания всех методов оптимизации в статистических задачах и

основное внимание обргатили на наименее освещенные в монографиях приемы и

методы расчета оптимальных систем управления.

В теории оптимизации могут быть выделены два класса задач:

задачи параметрической оптимизации, в которых производится выбор

конечного числа параметров в системе управления при заданной ее структуре;

задачи вариационного исчисления, в которых производится выбор конечного

числа операторов или функций.

Оба класса задач характеризуются определенным видом функции или

функционала, подлежащего оптимизации. Для вычисления функционала необходимо

решить задачу анализа системы управления. Щйрокий класс систем управления

описывается системой обыкновенных дифференциальных уравнений конечного

порядка. Этот класс систем управления и является предметом исследования в

настоящей книге. Решение задачи анализа детерминированных сиетем управления

не вызывает принципиальных затруднений и может быть сведено к численному

решению системы обыкновенных диф<ференциальных уравнений на

вычислительной машине. Проведение анализа стохастических систем управления представляет

сложную задачу. Строгое решение этой задачи получено только для линейных

систем при гауссовых воздействиях. Если система содержит нелинейные

безынерционные преобразования, то в общем случае возможен лишь приближенный

расчет статистических характеристик фазовых координат этой системы.

Изложенный в работе приближенный метод, эквивалентный методу статистической

линеаризации, позволяет составить конечную систему обыкновенных

дифференциальных уравнений относительно моментных функций выходных координат

"анализируемой системы. Кроме того, эффективным является подход, основанный

1* 3

на теории процессов Маркова и приближенном решении уравнения А. Н.

Колмогорова.

Из класса нелинейных систем управления можно выделить класс систем,

которые содержат мультипликативные помехи. К этому классу относятся, 'в

частности, системы, описываемые линейными дифференциальными уравнениями

со случайными коэффициентами. Для систем управления данного класса

разработаны специальные методы анализа, позволяющие рассчитать статистические

характеристики выходных координат при различных статистических свойствах

случайных коэффициентов.

Указанные методы анализа стохастических систем управления позволяют

рассчитать статистические характеристики выходных координат путем

однократного решения на вычислительной машине конечной системы обыкновенных

дифференциальных уравнений и тем самым существенно сократить время

анализа.

В инженерной практике широко применяется также метод статистических

испытаний (метод Монте-Карло), требующий проведения многократного

моделирования исследуемой системы управления на вычислительной машине. Ряд

приемов, изложенных в работе, позволяет более эффективно организовать процедуру

статистических испытаний на вычислительной машине.

Изложенные методы анализа систем управления используются в задачах

параметрической оптимизации. Методы параметрической оптимизации систем

управления могут быть разделены на три группы:

методы безусловной минимизации;

методы оптимизации при наличии ограничений на переменные (задачи

нелинейного программирования);

методы оптимизации в статистическом случае (стохастическая

аппроксимация).

Если структура стохастической системы управления объектном не задана,

то оптимизация системы производится методами, основанными на достижениях

современного вариационного исчисления. Широкое применение нашли метод

динамического программирования и стохастический принцип максимума.

В работе рассматриваются не только теоретические положения, но и вопросы

практического применения методов.

Авторы надеются, что книга окажет помощь инженерам в деле внедрения

в практику современных методов оптимизации систем управления.

ГЛАВА I

МЕТОДЫ ВЫЧИСЛЕНИЯ ХАРАКТЕРИСТИК

ТОЧНОСТИ НЕЛИНЕЙНЫХ ДИНАМИЧЕСКИХ СИСТЕМ

1. Применение метода статистической линеаризации

в нелинейных статистических задачах

Современные автоматические системы, как правило, работают

в условиях помех. Поэтому для анализа точности работы таких

систем широко используются теоретико-вероятностные и

статистические методы исследования. Задача анализа точности работы

динамической системы состоит в определении статистических

характеристик выходных координат системы по известным

характеристикам входного сигнала. При анализе точности сложных

динамических систем иногда достаточно определить первые два

момента выходных координат системы.

Практически все современные системы управления являются

нелинейными, поэтому наибольший интерес представляют методы

исследования именно таких систем. Существуют точные и

приближенные методы исследования нелинейных систем. Однако задача

точного исследования нелинейной системы чрезвычайно сложна,

и применение точных методов ограничено простейшими системами.

Поэтому для исследования точности нелинейных систем широкое

применение в инженерной практике находят приближенные

методы, из которых наибольшее распространение получил метод

статистической линеаризации [39].

Сущность метода статистической линеаризации заключается

в том, что нелинейная зависимость между случайными функциями

*Ю = ф {*(<)} (1)

приближенно заменяется линейной

**(0«Фо + *1*Ю. (2)

где ф0—математическое ожидание нелинейной функции (1);

ki — эквивалентный коэффициент усиления нелинейного эле-

о

мента по случайной составляющей процесса на входе; х (t) —

случайная составляющая процесса на входе нелинейного элемента.

Существуют различные способы.определения, ф0 и &х. Первый

способ основан на том, что эти величины определяются из условия

равенства математических ожиданий и дисперсий нелинейной

5

функции и приближенной линейной [40]. При таком подходе

имеем:

Фв = ль ==М №(*)]; .ЛР>=:±*

где (т2 и ох — среднеквадратические отклонения случайных

функций z (t) и х (t) соответственно.

Второй способ определения <р0 и kt основан на том, что

приближенная зависимость между случайными функциями

определяется из условия минимума среднего кавдрата отклонения

нелинейной функции и приближенной линейной [40], т. е.

M[{<p(x) — q>0-ki2)Ox(t)}2]==min. (3)

Выражение (3) достигает минимума, если

А|2) = К (4)

"дне J

где dzx — корреляционный момент случайных функций z (f) и

* (f)\ dxx — дисперсия случайной функции х (/).

Числовые значения ф0 и kx для определенного вида нелинейной

функции (1) можно вычислить, если известен закон

распределения х (/). При анализе точности сложных нелинейных систем

с использованием метода статистически линеаризации

предполагают нормальным закон распределения процесса на входе

нелинейного элемента. Методы анализа стационарных нелинейных

систем хорошо разработаны и описаны в литературе [39, 74, 82].

Рассмотрим применение метода статистической линеаризации

к анализу точности нестационарных систем.

Пусть нестационарная система содержит в своей структуре

безынерционный нелинейный элемент. Широкий класс таких

нелинейных систем с использованием метода формирующих фильтров

[10, 62] можно описать дифференциальным управлением в

векторной форме:

§- = A(t) х (t) + //V<P (**, t) + Bx (t) r(t) + B (t) I (/);

*(0) = *o, (5)

где r (t) — неслучайное воздействие! I (t) — распределенный

нормально белый шум с интесивностью Q; x (t) — вектор фазовых

координат системы; х0—нормально распределенный вектор

начальных условий, некоррелированный с возмущающим

воздействием g (t); A (t) — квадратная матрица переменных

коэффициентов размерности In, п]; В (t) и Вг (t) — прямоугольные

матрицы переменных коэффициентов системы размерности [п> 1 ];

Ф (xv, t) — характеристика безынерционного нелинейного

элемента; liv — вектор-столбец размерности п с компонентами

(1. *' = v,

//v — 10, i + v.

Определим приближенно математическое ожидание и

дисперсионную матрицу вектора х (t) нелинейной системы:

Dx(t) = M[x(t)°x*(t)]9 (6)

о о

где х (t) — центрированный вектор-столбец; я* (/) —

транспонированный вектор или вектор-строка.

Усредняя уравнение (5), получим дифференциальное уравнение

относительно математического ожидания вектора х (/):

^ = A (t) тх (/) + l£vM [<p (*v, /)] + В± (t) r (0;

тх(0) = тХо, (7)

где тх = М [х (/)] — математическбе ожидание вектора х (f).

Вычитая почленно из уравнения (5) 'уравнение (7), получим

дифференциальное уравнение относительно центрированной

составляющей вектору выходных координат:

о

^^A(t)x(t) + lJ(xVft) + B(tn(ty,

°х(0) = °Хо. Ч (8)

Дифференцируя левую и правую части равенства (6) по / и

используя уравнение (8), получим дифференциальное уравнение

относительно дисперсионной матрицы вектора фазовых кординат

исследуемой системы:

*g- = A(f)Dx{f) + Dx(f)A*(f) +

+ М [ltJp (ху, t)x (*)] +М[х(t) ф (xv, t) Q +

+ В (t) M Ц (t) > (О] + M [x it) | (t)]B* (t); -

Dx(0) = M.lxo0xo]. (9)

Для вычисления математических ожиданий двух последних

слагаемых выражения (9) проинтегрируем уравнение (8):

о о ' ' ' ' ' '

*(0 = *о + lA(n)x(t)dx + llv J »р(*„, t)dx+ \B(x)t(x)dx. (10)

Тогда, принимая во внимание некоррелированность вектора

начальных условий с возмущающим воздействием и используя

выражение (10), получим

t

M[x(t)l(t)]= JA(x)M[x(T)l(t)]dx +

t t

+ //v J M[y(xV9 %)l{t)\dx+ JB(x)M[l(x)l(t)]dx. (11)

о о

Выполняя интегрирование выражения (11) с использованием

свойств «белого» шума и умножая обе части этого равенства справа

на В* (/), имеем

М [х(t) I (/)] В* (t) = -i~ В (t) QS* (0. (12)

Транспортированием равенства (12) получим

В (t) М Ц (0 > (0] = ±В (t) Q5* (0. (13)

В процессе решения уравнений (7) и (9) необходимо вычислять

средние значения

Ml<p(xv, 01 = Фо; (14)

//v М [ф (*v, t) > (0J; М [х (t) i (xv, t)] 1%. (15)

Среднее значение (14) можно вычислить, если известен

одномерный закон распределения xv (t). Для вычисления средних

значений (15) необходимо располагать совместным законам

распределения каждой выходной координаты х{ (t) с _xv (t).

Если предположить нормальными совместные распределения

xv (t) и xt (t) (i =1, 2, . . ., ri), то можно считать, что совместные

плотности распределения р2 (t, xv, xt) (i = 1, 2, . . ., n)

известны для каждого момента времени tf так как в процессе

решения уравнений (7) и (9) определяются все необходимые параметры,

от которых зависят плотности распределения.

Вычислим средние значения (15), предполагая нормальными

совместные распределения xv (t) со всеми xt (t) и используя

выражение совместной плотности распределения через ортогональные

полиномы Чебышева-Эрмита [50, 741:

*<«.«. ч -кд «р {--J- K^f)'+('^ Л} х

х|]тгАя«(5Ч;ь)й-(й^)- (16>

/=1, 2,.,.,я

8

где р^ — коэффициент корреляции случайных процессов xt (t)

их {t)\ Hs (A,) — ортогональные полиномы Че^бышева—Эрмита,

определяемые соотношением

Введя новые переменные

*/ —mi \ ХУ — ^У \

и используя формулу (16), получим

00

М [xi (t) ф (xVi t)] = S bisa8p*V9

s=0

i = 1, 2, . . ., n,

где as и 6/s — коэффициенты, которые определяются

выражениями [83, 74]

(17)

]/"2яЛ

(Vv + ™v)#s(4)e 2A,;

oo

CO

f --i

■„ = -* J Х,Я.(Я,)е 2 dX„

V2ns\ _

i = 1, 2,

., n.

(18)

Для вычисления коэффициентов bis воспользуемся свойством

я*

ортогональности полиномов #s (X) с весом е 2 на прямой

—оо <^Х <2оо:

J Я.(*)Я.

.-■т-л-//2"*'. * = s;

*(А,)е 2 <ft =

0.

&=f s.

(19)

Принимая во внимание, что %t = Ht (%t), и используя

свойство (19), получим

\at, s = 1, i = 1, 2, . . ., п.

b's=W s+l.

(20)

С учетом формул (18) и (20) выражение (17) принимает вид

М Ixi (t) ф (jcv, 01 = or/aip/v = k[2)dtv, (21)

где div — корреляционный момент связи xi (t) и xv (t)\ fe[2) — эк-

вийалентный коэффициент усиления нелинейного элемента по

случайной составляющей процесса на входе, вычисленный вторым

способом по формуле (4).

Принимая во внимание выражения (12) и (13) и используя

формулу (21) при совместном нормальном распределении xt (t) и

xv (t), получим линеаризованное дифференциальное уравнение

относительно дисперсионной матрицы вектора

. " " ^ = А (0 Dx(t) + Dx (t) Л* (*) +

+ k[2)llvt%Dx (t) + k[2)Dx (t) Wjv + В (t) QBl (t),

Dx (0) = M [xoxl], (22)

так как

hvM [ф (xv, t) x (t)] = k[2)liv M lxv (t) x (t)] =

M [x (t) ф (*v, t)] 1% = k[2) M [x (t) xv (t) ] 1% =

= k[2)Dj£vi;v.

Дифференциальное уравнение (22) имеет порядок п2, но только

2 уравнений являются линейно независимыми, так как

При нормальном или близком к нормальному совместном

законе распределения xv (t) со всеми xt \t) математическое

ожидание фо и коэффициент статистической линеаризации k{2),

входящие в уравнения (7) и (22), являются функциями

математического ожидания и дисперсии процесса на входе нелинейного

элемента

Фо = Фо (wv dvv); |

*P-tfW«w,i (23)

которые для различных типов нелинейных функций можно

определить заранее [39].

Уравнения (7) и (22) необходимо решать совместно, так как

для определения выражений (23) в каждый момент времени

необходимо иметь соответствующие значения тх и dvv. Таким

образом, задача сводится к решению уравнений (7) и (22), связанных

зависимостями (23), которые можно проинтегрировать только

с помощью вычислительных машин. При этом однократным

решением этих уравнений определяются математическое ожидание и

дисперсионная матрица вектора фазовых координат.

В общем случае решение уравнений (7) и (22) может быть

выполнено только на цифровых вычислительных машинах (ЦВМ),

что обусловлено трудностями реализации на аналоговых вычисли-

10

тельйых машийах нелинейных зависимостей (23), (так как при этом

требуются нелинейные блоки двух переменных) и высоким

порядком решаемой системы уравнений. В частном случае, когда

порядок исходной системы невысок и математическое ожидание

процесса на входе нелинейного элемента равно нулю, эти

уравнения можно решить на аналоговых вычислительных машинах, так

как реализация зависимостей (23) в этом случае осуществляется

на обычных нелинейных блоках.

При численном интегрировании уравнений (7), (22) на ЦВМ

значения фо и k[2) вычисляются по определяемым на каждом шаге

интегрирования значениям тх и dvv.

Заметим, что векторная форма не только позволяет сделать

запись уравнений более компактной, но и упрощает алгоритм

решения задачи на ЦВМ, так как правая часть уравнения (22) в

процессе его решения определяется ца каждом шаге интегрирования

с использованием стандартных программ сложения и умножения

матриц.

Изложенный выше метод можно применять для анализа

точности систем с постоянными параметрами. При исследовании

точности установившихся режимов стационарных систем

дифференциальные уравнения (7) и (22) сводятся к алгебраическим. Если

в системе (5) матрицы Л, fi, Bx и неслучайное воздействие

постоянны, а система устойчива, то. в установившемся режиме тх и

Dx — постоянны и дифференциальные уравнения (7) и (22)

превращаются в алгебраические:' —

Атх + liv(p0 (тх , dvv) + Вгг = 0;

"V'

ADX + DXA* + M2) (mv <*w) /jv&D* +

+ M2) («. , dvv)DJ(vl% + QBB\

(24)

Система уравнений (24) может быть решена методом

последовательных приближений на ЦВМ.

Рассмотрим примеры составления уравнений, определяющих

математические ожидания и элементы дисперсионной матрицы

выходных координат систем управления.

Пример 1. Нелинейная система, изображенная на-рис. 1,а, в момент

времени t — 0 возмущается распределенным нормально [стационарным случайным

процессом z (t) и неслучайным воздействием г (t). Предполагается, что среднее

значение z (t) равно нулю, а спектральная плотность мощности имеет вид

* . s*(№>=^' (25>

где dz — дисперсия процесса г (t).

Построим систему дифференциальных уравнений для приближенного

определения математического ожидания и дисперсии процесса на выходе системы

в переходном режиме.

Используя метод формирующих фильтров, сведем исследуемую систему к

эквивалентной, которая в момент времени t = 0 возмущается стационарным белым

11

шумом £ (/) с интенсивностью Q = dz. Передаточная функция формирующего

фильтра W2 (p) при этих условиях на основании формулы (25) имеет вид

Г,(р).

'Ttf+l'

(26)

где

'.Ч. •>-(-§■)'"

С учетом принятых на рис. 1 б, обозначений и передаточной функции (26)

эквивалентную систему можно описать следующими уравнениями:

Лу 1 О

•^-2 = ^ [-*2 (о + *а| (01; ч (0) = х02,

(27)

где ф (xt) — характеристика безынерционного нелинейного элемента; х02 —

центрированная случайная величина с дисперсией, равной d2.

z(t)

ф-

r(t)

k<-)

JP + 1

x(t) B(t)

<P(x)

Tzp+I

r(t)

*г($Тх-)

T,p+i

9CX,)

a) 6)

Рис. 1. Структурные схемы нелинейной системы:

а — исходная; б — эквивалентная

Jf/ft)

Предполагая совместный закон распределения хг (t) и хг (t) близким к

нормальному и используя формулу (27), получим уравнения для определения

математического ожидания и дисперсии процесса на выходе исследуемой системы

в переходном режиме:

1

mi = j~ [—Щ (t) — ф0 (ml9 dn) + r(t)];

in = Y[ {- il +k™ (ть *n)] dn (0 + ^12 (0};

hu = ~ {к + ТГ t1 + ^2) К *n)]) rfi2 (0 + ^ 4и (0;

Qk\ 2

d22 = -Zv—-T~ d™ Wt ^22 (0) = dz.

I ~ * 9.

(28)

12

" Последнее уравнение системы (28) решается независимо от других и при

заданных начальных условиях имеет постоянное решение d22 = d2> что позволяет

упростить систему • уравнений (28), которая в окончательной форме имеет вид:

"*i = уг [—т1 (0 — ф0 (mb dn) + г (/)];

5ц = -^ {— [1 + М2) (^ь ^ii)] ^1 (0 + rfi2 (0};

Пример 2. Нелинейная стационарная система, приведенная на рис. 2,

возмущается стационарным белым шумом £ (t) с интенсивностью Q. Предполагается,

' что нелинейный элемент имеет нечетную характеристику.

Определим приближенно дисперсию

процесса на выходе системы в установившемся £/$ ^„ч^ Г

состоянии. l_iy+y_J

Исследуемая нелинейная система описы- ^ч-< I

вается дифференциальным уравнением

x(t) = -r-lUt)-x(t)-iMx)]. (29)

!(->

Тр+1

xft)

ЧМ

Так как среднее значение процесса на

входе равно нулю, а нелинейный элемент Рис. 2. Структурная схема ста-

имеет нечетную характеристику, то среднее ционарной нелинейной системы

значение процесса на выходе также равно '

нулю. Предполагая закон распределения х (t) близким к нормальному и

используя формулу (24), получим уравнение для приближенного определения

дисперсии процесса на выходе системы в установившемся состоянии:

Пусть характеристика нелинейного элемента

ф (я) = ах3 (t)

при нормальном распределении х (t) и среднем его значении, равном нулю, имеет

коэффициент &{2), выражаемый через дисперсию

k^ = Шх.

(31)

Подставляя выражение (31) в формулу (30), получим квадратное уравнение

относительно dx:

решая которое, определим значение дисперсии процесса на выходе в

установившемся состоянии:

-1 + |Л

6aQ

6a

13

2. Метод определения характеристик

многомерных нелинейных систем

Рассмотрим многомерную нелинейную систему, которая в

векторной форме описывается уравнением

§• = Ф (*, t) + В, (t) r(t)+B (t) I (0, x (0) = xo, (32)

где x (t) — вектор фазовых координат системы размерности п\

Ф (ху t) — векторная нелинейная функция размерности п\ \ (tY—

распределенный нормально векторный белый шум размерности т;

г (f) — векторное неслучайное воздействие размерности /; х0 —

распределенный нормально вектор начальных условий,

некоррелированный с возмущающим воздействием; Вг (t) —

прямоугольная матрица переменных коэффициентов размерности [я, /];

В (t) — прямоугольная матрица переменных коэффициентов

размерности [п, т].

Используя метод статистической линеаризации, определим

приближенно математическое ожидание вектора

mx(t) == М lx(t)] {33)

и матрицу корреляционных функций этого вектора

Кх (*ь *,) = М [*(*!> ** (*,)]. (34)

Рассмотрим статистическую линеаризацию векторных

нелинейных функций, которую будем использовать пры определении

характеристик нелинейной системы (32). Нелинейное

преобразование между векторными случайными функциями z (t) и х (t)

задано в форме

z (t) = Ф (х, 0, (35)

где z (t) — векторная случайная функция размерности п\ х (t) —

вектор случайных аргументов размерности п\ ф (х, t) — вектор

нелинейных функций. ] »

Аппроксимируем векторное нелинейное преобразование (35)

приближенной линейной зависимостью между случайными

векторами z (t) и х (t), которую представим в форме

*л W = Фо + Кг х (0, (36)

где ф0 — математическое ожидание нелинейной функции (35);

Кг — прямоугольная матрица эквивалентных коэффициентов

усиления нелинейного элемента по случайной составляющей вектора

х (t) размерности [п, п].

При аппроксимации нелинейной функции (35) линейной

функцией (36) будем исходить из минимума среднего квадрата откло-

. нения векторов z (t) и гл ^)» т- е- потребуем минимума выражения

Е = М 1\г (0 — Фо — КгХ (01* {* (0 — Фо~

— КгхЩ] = min. (37)

14

ж = — 2 [M[z (t)x* (t)] — KtMlx (t) x* (*)]} = 0

Значение (37) будет минимальным, если выполняются условия:

-i£ = o ™_ = о

где оператор -g— представляет вектор-столбец размерности п,

компонентами которого являются _-§г—» / = 1, 2, . . ., /г,

оператор -jH7- является прямоугольной матрицей размерности [л, п\

с элементами д^—, /, ] = 1, 2, . . ., п.

Дифференцируя выражение (37)-по <р0 и приравнивая

производную нулю, получим

Ц.=-2М[2(*)Г-ср0] = 0,

откуда имеем

фо = М [г (01 = М [<р (*, t)]. (38)

Выполняя дифференцирование выражения (37) по Кг и

приравнивая производную нулю, получим <

<г

или

KiDx = M [Ф(х, f)x* (01 (39)

где D*— дисперсионная матрица вектора х (f)> кот9рая

определяется выражением

Dx = M [x(t)x* (t)].

Из равенства (39) получаем выражение для матрицы

эквивалентных коэффициентов усиления нелинейной функции (35) по

случайной составляющей вектора х (t):

Ki = М [Ф (*, 0 > (t)]DJl. (40)

Выражения (38) и (40) для определенного вида нелинейной

функции можно вычислить, если известен закон распределения

вектора х (/). Особый практический интерес представляет

статистическая линеаризация нелинейной функции (35) при

нормальном распределении вектора х (0, плотность распределения

которого выражется формулой [59]

p{tt x)= (2</w/8 exp [--т^-т^в^^-тА • <41>

где | Dx | — определитель дисперсионной матрицы вектора х (t)\

тх—математическое ожидание вектора х (/); (х—тх) —

центрированный вектор х (/).

15

Используя выражение (41), математическое ожидание

векторной нелинейной функции можно определить по формуле

00

Фо = J ф (*> t) P {U x) dx, (42)

i —ОЭ

где интегрирование осуществляется по всем составляющим

вектора л:.

Матрицы эквивалентных коэффициентов усиления (40) можно

вычислить, используя плотность распределения (41), но если

математическое ожидание (38) уже определено, то его можно

использовать для вычисления матрицы эквивалентных

коэффициентов усиления. Дифференцируя равенство (42) по тх и используя

формальное тождество

о

dtp (x -f mx, t) __ ду(х, t)

дтх ~~ дх '

получим

£_*р£а]-/Й£Я„<Ь,)А. (43)

— 00

Интегрируя правую часть равенства по частям и используя

выражение плотности распределения (41), запишем

— 00

со

= j Ф (*» О (х — *Пх)* D~XP (К x)dx =

— 00

= M[^{Xit)°x{t)]D7\ (44)

Сравнивая выражения (40) с (43) и (44), получим формулы для

определения матрицы Кг-

«> = %;'. <45>

. К1 = М[ЩЬЛ]. (46)

Формула (45) оказывается очень удобной, так как элементы

матрицы /Ci определяются достаточно просто [4, 41]:

**/«тЭ^.и-1.2,...,я. (47)

Выражение (46) целесообразно использовать для вычисления

элементов матрицы К\ в случае, когда нелинейная функция (35)

является полиномом,

1§

Пусть, например, двумерная нелинейная функция имеет вид

z (t) = х\ (О Х2 (О, (48)

линейное приближение которой имеет форму

2Л (t) = Фо + &i*i (0 + k2x2 (t).

Предполагая нормальным совместное распределение хх {t)

и х2 (t)> математическое ожидание нелинейной функции (48)

получаем в форме

фо = М [г (/)] = тХхтХг + mXidXl + 2mXldXiX2, (49)

где mXl и тХг — математические ожидания хг (t) и х2 (/)

соответственно; dXl — дисперсия хг (/); dXtXz — корреляционный

момент хг (0 и х2 (/).

У Используя формулу (47) и выражение (49), имеем:

дтХг

Аналогичные выражения для kx и k2 получим, используя

формулу (46):

kl==M [&&] = 2тХ1тХг + 2dXlXl;

*-*W]-< + '*■

Определим теперь характеристики (33) и (34) нелинейной

системы (32). Усредняя уравнение (32) по совокупности, получим

дифференциальное уравнение относительно математического

ожидания вектора х (t):

^ = Фо (t) + Вг (t) г (0, тх (0) = /по, (50)

где т0 — математическое ожидание вектора начальных условий*

Вычитая почленно из уравнения (32) уравнение (50), получим.

4■ = ф (*, t) + B (t) I (0, х (0) = °х0. (51)

at

Дифференцируя левую и правую части равенства (34) по tx

и принимая во внимание формулу (51), получим дифференциальное

уравнение относительно матрицы корреляционных функций

вектора х (t):

дКх(£ h) = М [ф(х9 tx)>(t2)] + B(t)M [Ift)>(t2)]. (52)

A. M. Батков jrr— - — __ , 17

2::.:. Гор.л(сгэ

Так как автокорреляционные функции составляющих вектора

х (t) симметричны относительно плоскости, проходящей через

биссектрису координатного угла и ось ординат, а их взаимные

корреляционные функции обладают свойством

kxtxf (tb U) == kXjXi (t2, tx)t

то для определения матрицы корреляционных функций Кх (tlf t2)

достаточно решить уравнение (52) в области, где t^ t2. Но при

tx 5> t2 второе слагаемое в правой части уравнения (52) равно

нулю на основании свойств белого шума. Следовательно, при

^i 5> t2 имеет уравнение

дКх(£ h) = М [{(*, tx) > &)], (53)

tx>t2.

Для решения уравнения (53) необходимо вычислить среднее

значение правой части уравнения и задать значения

корреляционной матрицы вектора х (t) на границе области

интегрирования при tx =

Заграничные условия уравнения (53) определяются

дисперсионной матрицей вектора х (t):

Dx (t) = М lx (t) x*(t) ], Dx (0) = M [xjfo. (54)

Дифференцируя левую и правую части равенства (54) по t и

используя уравнение (51) и выражения (12) и (13), получим

дифференциальное уравнение:

//D о о о о

^■ = ЛПф(*, f)**(t>] + Mlx(f)<p*(x, t)] + B(t)QB*(t),

Dx(0) = Mlxjft9 (55)

где Q — квадратная матрица интенсивностей векторного балого

шума размерности [m, ml.

Для определения математических ожиданий в уравнениях (53)

и (55) предположим нормальным двумерный закон распределения

вектора х (t). Тогда, используя выражение (39), уравнение (55)

запишем в следующей форме:

-4g*. = Kl (щху Dx)Dx + DxK\ (щХ9 Dx) + B(t)QB*(t)y

Dx(0) = M[x0x;i (56)

где Кг — матрица эквивалентных коэффициентов усиления

векторного нелинейного элемента (35) по случайной составляющей

вектора на входе, которая при нормальном распределении

вектора х (t) зависит от вектора тх и дисперсионной матрицы Dx.

18

dt

г

Нетрудно показать, что при двумерном нормальном

распределении вектора х (t) матрицы-взаимных корреляционных функций

векторов на входе и выходе нелинейного элемента (35)

определяются равенствами:

Kzx(tu h) = М [ф(*, tx)j<* (t2)] =

K„(tl9 t2) = M [*(<!> ф*(*. *,)] -

= Kx(tl, fe)tfl(fc).

(57)

Для доказательства справедливости равенств (57) рассмотрим

векторную нелинейную функцию размерности п, которая имеет вид

Ф1 (") = Ф (X, h) + <р (х, t2),

(58)

где ф (х, tx) и ф (х, t2) — одинаковые векторные нелинейные

функции типа выражения (35); и — вектор размерности 2я,

компонентами которого являются векторы х $г) и х (t2):

1 vi;" (59)

и = \

x(t2)\\

При совместном нормальном распределении векторов х (/i)

и х (f£) плотность распределения вектора и имеет вид

Р^^И) = (2я)В[1/Сц|,/,ехрх

X [ 5~ (и — тиУ Кй1 (и — т„)] ,

(60)

где \Ки\ — определитель корреляционной матрицы вектора и;

IQ — обратная корреляционная матрица того же

вектора.,Заметим, что корреляционная матрица вектора и на оснований

формулы (59) выражается через матрицу корреляционных моментов

и корреляционных функций вектора х (t). В самом деле,

так как

к _ м г°°*, _ I вЛк) KxVi, Щ

Ки = М[ии ] = . I,

Ц Ajc (?1, 12) L>x\tl) I

Kx{t2,h) = Kx{h, t2).

(61)

Дифференцируя по ти математическое ожидание нелинейной

функции (58), выраженное через плотность распределения (60),

по аналогии с формулой (44) получим матрицу эквивалентных

2* 19

статистических коэффициентов усиления этой нелинейной

функции по случайной составляющей вектора и:

Кх = М[^{и)и]Ки\ (62)

которая на основании формулы (58) имеет вид

Кг^ХКЛЫКгШ (63)

где Кг (tt) и /Ci (t2) — матрицы эквивалентных статистических

коэффициентов усиления нелинейного элемента (35) по

случайным составляющим векторов х (tx) и х (t2) соответственно.

Запишем матричное равнество (62) в следующей форме:

КгКи = М [Ф (и) и*]. (64)

Предположим теперь, что нелинейная функция (58) зависит

только от вектора х (ti), тогда Ki (t2) в равенстве (63) равна нулю.

Принимая во внимание формулу (61) и используя выражение (64),

получим

l*i(*i)Ar('i) КгМКхУг, Ш =

= \\М[Ф (х9 h) > (tx)] M [Ф (*, tx)> (t2)]\\. (65)

Но при нормальном распределении вектора х (/х)

следовательно, матричное равенство (65) выполняется, если

* 1 (h) Kx (tu t2) = М [Ф (х, h) х* (*,)],

что доказывает справедливость первого равенства формулы (57).

Транспонируя равенство (64) и предполагая, что нелинейная

функция (58) зависит только от вектора х (t2), получим

lKx(tu fe)tfl(fe)

I Dx{t2)Kl(t2)

На основании транспонированного равенства (39) матричное

равенство (66) выполняется, если

Кх (tu *2) К\ (t2) = М [х (tt) Ф* (х, *,)],

что доказывает справедливость второго равенства формулы (57).

Принимая во внимание выражение (57), уравнение (53)

запишем в виде

дКх1£ h) = KAQКх(/lf h), ь>и. (61)

' В отличие от линейных систем, для которых математическое

ожидание и дисперсионная матрица вектора фазовых координат

определяются из независимых уравнений, уравнения (50) и (56)

20

M[x(ti)(p (x, fe)

M[x(t2) <р*(х, t2)

(66)

при нормальном распределении вектора х (t) оказываются

связанными функциональными зависимостями

Фо = Фо (тХ9 Dx)y Кх = /Ci (mx, Dx), (68)

вместе с которыми образуют единую систему уравнений порядка

п + п(п+ 1)/2.

Совместное интегрирование уравнений (50) и (56) с

использованием зависимостей (68) может быть выполнено только с помощью

ЦВМ. Причем, однократным решением этой системы определяются

математическое ожидание и дисперсионная матрица вектора

фазовых координат систем (32). Помимо этого, в процессе

решения этих уравнений определяется матрица эквивалентных

коэффициентов усиления векторного нелинейного элемента /Ci, которая

вместе с матрицей Dx может быть исползована для решения

дифференциального уравнения (67): При этом однократным решением

дифференциального уравнения (67) определяется сечение

корреляционной матрицы вектора х (t) как функция tx при

фиксированном значении t2. Общее число решений уравнения (67) для

определения всей поверхности корреляционной матрицы зависит

от того, насколько быстро она изменяется с ростом аргумента t2.

Если же исследуемая система стационарна и устойчива, то

для установившегося состояния уравнение (67) превращается

в обыкновенное дифференциальное уравнение относительно

корреляционной матрицы вектора фазовых координат

-^- = /Ci/Ut), t>0, (69)

которое решается при начальных условиях, определяемых

системой алгебраических уравнений:

Фо (тх> £>х) + Вхг = 0;

Кг {тХу Dx) Dx + DXK\ (mXf Dx) + BQS*=0;

Фо (mX9 Dx) = M [<p (*)];

Ki fax, Dx) = -g£ Фо fax, Dx).

(70)

Решение системы уравнений (70) может быть выполнено на ЦВМ

методом последовательных приближений. В процессе решения

этой системы уравнений определяются Кг и Dx, которые

используются для решения уравнения (69). г „__

Рассмотрим пример составления дифференциальных уравнений

для определения элементов матрицы корреляционных функций

выходных координат системы.

Пример. Нелинейная система, изображенная на рис. 3, возмущается в

момент времени t = 0 стационарным белым шумом |(/) с интенсивностью Q,

21

,равной единице, и неслучайным воздействием г (t). Нелинейная система

описывается дифференциальными уравнениями

■^—i-fe(i)-*,(0].

(71)

где ф (*1э д:2) — двумерная нелинейная функция выходных координат системы,

имеющая вид:

<Р (х19 х2) = хх (t) х2 (t) + kx2 (t). (72)

Предполагая совместный двумерный закон распределения хг (t) и х2 (t)

близким к нормальному, построим систему уравнений для определения элементов

матрицы корреляционных функций выходных координат системы (71) в

переходном режиме.

Принимая во внимание формулу (67) и используя выражения (71) и (72)

прихдвумерном нормальном векторе х (/), получим уравнения относительно эле-

щ)

1

r(ty

1

1 >

г

1

Т,р+1

1 *i(*l\

'

(D(Xt X~\

У\л1

/

Т2р + 1

h(t)

Рис. 3. Структурная схема

нелинейной системы,

содержащей двумерный

нелинейный элемент

ментов матрицы корреляционных функций выходных координат системы в об-^

ласти, где ^> t2:

— y~ [£+"*! ('i)J "22 ('i> t2);

^ — у «11 \ll> l2) ^T-«21 1*1» Г2;»

d&22^1> *2) __ 1 fc // /\ _!_/% // /V

g/ ~y"«12lrl» l2) — ^r-K22{rlf I2),

kij(t, t) = di;(t), /,/=1, 2,

где mx (J) n m2 (0 — математические ожидания выходных координат системы,

которые определяются решением системы дифференциальных уравнений

dmt

dt

= 4r-lr it) -щ О) - km2 {f) - щ (t) m%{t) - dl2 (*)];

dm2

dt

71,

т?-^ I'M')-*•(')]

22

совместно с системой уравнений, определяющих значения корреляционных

функций на границе области при tx = <2 = t,

4i (0 = js - Yi I1 + m* Wl rfn - y-% t* + щ (t)} d12 (0; -

i12 (0 = y: du (0 ~ Ьт[1 + m2 (/)1 + т~}dli {t) ~ J~{k+щ {t)] dii (0*

2 2

^2 (0 = y~ rf12 (0 - у <*22 (О-

3. Интегральный метод анализа точности

нелинейных систем

В предыдущем параграфе рассмотрен метод анализа

нелинейных многомерных систем, основанный на предположении, что

закон распределения вектора фазовых координат известен с

точностью до двух параметров. В настоящем параграфе проводится

анализ многомерных нелинейных систем при известном законе

распределения вектора на входе нелинейного элемента.

Рассмотрим многомерную нелинейную систему порядка п

(рис. 4). Обозначим через х (t)

вектор фазовых координат

системы размерности т на входе

нелинейного элемента ф (х, t)

той же размерности. Введем

матрицу размерности [т, т]

импульсных переходных функций

W (t, т) линейной, части

системы. Тогда вектор х (t)

выразится следующим образом:

mt

1 Л ^1

г J *1

w(t,%)

•

J <r(*,t)

x(t)

■С ■■■

Рис. 4. Структурная схема

многомерной нелинейной системы

x(t) = \W (U т) [В (т) z (т) — ф (х, t)]Jt,

(73)

где В (т) — матрица переменных коэффициентов размерности

Г/я, /]; z (т) — нормально распределенный вектор случайных

воздействий размерности / с известными статистическими

характеристиками. Начальные условия вектора х (t) предполагаются

нулевыми.

Принимая нормальным двумерный "закон распределения

вектора х (t), определим приближенно математическое ожидание и

матрицу корреляционных функций этого вектора. '

Используя формулу (73), определим математическое ожида-

о

ние тх (t) и центрированный вектор х (t) через матрицу

импульсных переходных функций линейных звеньев:

23

mx (t) = JW (t, т) [В (т) тг (т) - Ф„ (т)] dx;. (74)

x (t) = j W (t, x) [B (t) z (t) — ф (л;, т)] dx. (75)

Используя равенство (34) и выражение (75), получим

уравнение относительно матрицы корреляционных функций вектора

x(t) [2]:

Кх (tlt t%) + \ J W(tlt x) M [ф (*, т) ф* (х, Я)] W* (t2, К) dxd% +

+ \W (tlt x) M [Ф (xt x) x* (t2)] dx +

0

U

+ j M [x (tx) ф* (x, Я)] Г* (t2,\) dX =

о

и и

= 11 W Vi* *) 5 (t) /C2 (t, Я) Я* (Л) Г* (*2, Я) dr Л, (76)

где Кг (t, Я) — матрица корреляционных функций входного

вектора z (t).

Используя выражение (57), представим уравнение (76) в форме

и и

Кх (tl9 t2) =JJW (tiS) IB (т) Kz (г, Я) Я* (Я) -

и

— /Сф (т, Я)] Г* (*„ Я) Л Л — \ W (tl9 т) /Ci (т) Кх (т, /,) -

и

-\кх Ни X) К\ (Я) V (fe, Я) Л, (77)

о

где

/Сф (т, X) = М [ф (л:, т) }* (*, Я)]. (78)

Корреляционную функцию (78) векторного нелинейного

элемента ф (л:, f) при двумерном нормальном законе распределения

вектора х (t) можно представить в виде суммы двух составляющих:

#Ф (т, Я) = Кг (т) Кх (т, %)'К\ (Я) + V (т, Я), (79)

где УР (т, Я) — известная функция,^ которая для определенного

вида нелинейного элемента при двумерном нормальном

распределении вектора на входе выражается через математическое

ожидание и элементы матрицы корреляционных функций этого вектора.

24

Первое слагаемое равенства (79) представляет собой

корреляционную функцию векторного нелинейного преобразования,

пропорциональную корреляционной функции вектора х (f), которая

получена с помощью статистической линеаризации нелинейного

элемента.

Второе слагаемое этого равенства выражает нелинейные

искажения вида корреляционной функции вектора х (/). Это слагаемое

представляется разложением в ряд по степеням элементов матрицы

корреляционной функции вектора х (0, начиная со вторых

степеней. При этом используется разложение 2я-мерного

нормального закона распределения по ортогональным полиномам Чебы-

шева—Эрмита. В частном случае, когда нелинейный элемент

имеет полиноминальные характеристики, функция УР может быть

определена непосредственно.

В интегральное уравнение (77) входят матрицы коэффициентов"

статистической линеаризации /Ci (т) и /Ci (Я) векторного

нелинейного элемента по случайной составляющей, а также функция

^(т, Я), которые при двумерном нормальном законе

распределения вектора х (t) являются функциями математического ожидания

и матрицы корреляционных функций этого вектора, т. е.

Кг(г) = Кг{тХ1 Кх (х, *)}; 1

*(т, X)=W{mXiKx(t, *)}. f (Щ

В силу этого интегральное уравнение (77) и уравнение (74)

необходимо решать совместно с зависимостями (80).

Систему уравнений (74) и (77) можно решить методом

последовательных приближений или проинтегрировать методом

квадратурных формул на цифровых вычислительных машинах.

Используя метод прямоугольников, представим систему уравнений (74) и

(77) в следующем виде [2]:

mx(i + 1) = Д 2 W (/А + Д, vА) [В (vA) m2 (vA) - Фо (vА)];

Kx(i+U /+1) = A2S £г(*Д + Д, vA)x

v=0 /=0

X IB (vA) K2 (vA, IA) В* (1&) —

—/Cv(vA, /A)] W* (/A + А; Щ — \ (81)

i

— Д 2 W (/A + A, vA) /Ci (vA) Kx (vA, /A + A) —

v=0

/

- A 2 Kx (/A + A, /A) Ki (/А) Г* (/А + А, /Д),

/, / = —1, 0, 1, 2, . . .,

где A — шаг интегрирования по переменным т и X.

25

В системе уравнений (81) vA соответствует t; /А — Я; /А +

+ А — tt на / + 1-м шаге интегрирования; /А + А — t2 на

/ + 1-м шаге интегрирования.

При составлении системы уравнений (81) предполагается

выполнение следующих условий:

-1 , —i

Ъ * - 0; 2 */ = о.

s=0

/=0

Если предположить, что математическое ожидание т* (/)

известно на интервале /А = яД, а [корреляционная функция

Кх (ti, t2) определены в квадрате 0 ^ tx ^ «А, 0 ^ £2 ^ пА

(п = 0, 1, 2, . . .), то, используя систему (81), можно найти

значение тх (t) на п + 1-м шаге интегрирования и /С* (*ь *2)

для значений переменных tx = 0, /2 = (я + 1) Д (см- Рис- 5).

Аналогично определяются значения корреляционной матрицы

в точках:

(*х = A, t2 = пАЛ А), (^ - 2Д, /а = яД + Д), . . .,

(/х = пА + А, *2 = /|Д + Д).

Воспользовавшись известным свойством матрицы

корреляционных функций

Kx(tu fe) = /£(fc, tl), ,

всегда можно найти значение матрицы Кх (tu t2) вйутри всего

квадрата {(п + I) А, (п + 1) А}.

Совершенно аналогично определяется /С* ('ь Л) в квадрате

{(п + 2) А, (я + 2) Д}. Продолжая этот процесс, можно

вычислить искомую матрицу Кх (tu t2) в произвольной точке /А, /А.

Чтобы начать вычислительный процесс, достаточно знать

значение матрицы Кх (tlt t2) в точке (0, 0). Поскольку в уравнении

(73) начальные условия равны нулю, то Кх (0,. 0) = 0. Наличие

случайных начальных условий в системе (73) не приведет к

возникновению дополнительных трудностей

при определении матрицы,

корреляционных функций предлагаемым

методом.

В рассмотренном' методе

определения математического ожидания и

матрицы корреляционных функций

число решаемых уравнений зависит

не от порядка дифференциальных

уравнений исходной системы, а от

числа переменных, входящих в не-

Рис. 5. Последовательность вы- линейные элементы. Кроме того,

числения значений корреля- предлагаемый метод не требует, чтобы

ционной функции распределение всего вектора фазовых-

26

координат системы было нормальным; он основан на

предположении о совместном нормальном распределении только тех

координат, которые поступают на входы нелинейных элементов.

В случае, когда исследуемая система (73) стационарна и

устойчива, для установившегося режима работы системы уравнения (74)

и (77) принимают вид: \.

тх= W (0) {Втг — Фо [тХУ Кх-(0)]}\ (82)

00 СО

Кх(т) = J J W (I) [ВКг (т + £ - к) В* -

- KiKx (т + 6 -Я) К\ -Т(т+ t-Щ W* (К) d\dk-

оо со

— \w(l)KiKx(x+l)db—\kxb-b)*№(b)i&\

о о

Кг = К1[т„ Кхф)];

У(г + 1-Х)=у [тх, кх (т + £ - Щ,

где W (0) — значение матрицы передаточных функций линейных

звеньев системы в нуле. , / -

Взяв преобразование Фурье от левой и правой частей

уравнения (83), получим:

(83)

Sx (со) = W (- /со) [BSZ (со) В* - KiSx (со) К\ — ■

- V (о))] W* (/со) - W (- MKiSx (со) - S, (о)) К\ W* (/со);

*i = Кг [тх, Кх (0)], ¥ (со) = W [mx, Sx (со)],

:(84)

где Sx (со) и Sz (со) — матрицы спектральных плотностей

мощности векторов х (t) и z (t) соответственно; W (/со) — матрица

частотных характеристик линейных звеньев системы.

После несложных преобразований формулы (84) получим

уравнение: ..

Sx (со) = [Е+ W (-/со) /CJ-1 W (-/со) [BS2(<*) В* —

где

/Ci = /Сх lm„-/C»(0)]; . -,

У(<й)=У1тх, Sx(©)];

£ — единичная матрица.

Обозначив

[£ + Г (—/со) /Сх] -1 W (—/со) = Ф (—/со);

Г (/со) [J5 + К\ W (/со)]-1 = ф* (/со),

27

получим уравнение для определения'матрицы спектральных

плотностей мощности вектора х (t) в компактной форме:

Sx (со) = Ф (—/со) [BS2 (со) Я* — ¥ (со)] Ф* (/со), (85)

где

*i = *i 1тХ9 Кх (0)]; V (со) = У [mXi Sx (со)].

Для определения матрицы корреляционных моментов, от

которой зависят ф0, Кг и ¥, можно воспользоваться формулой

00

K*(0) = Dx=± J Sx(*>)d<*. (86)

—00

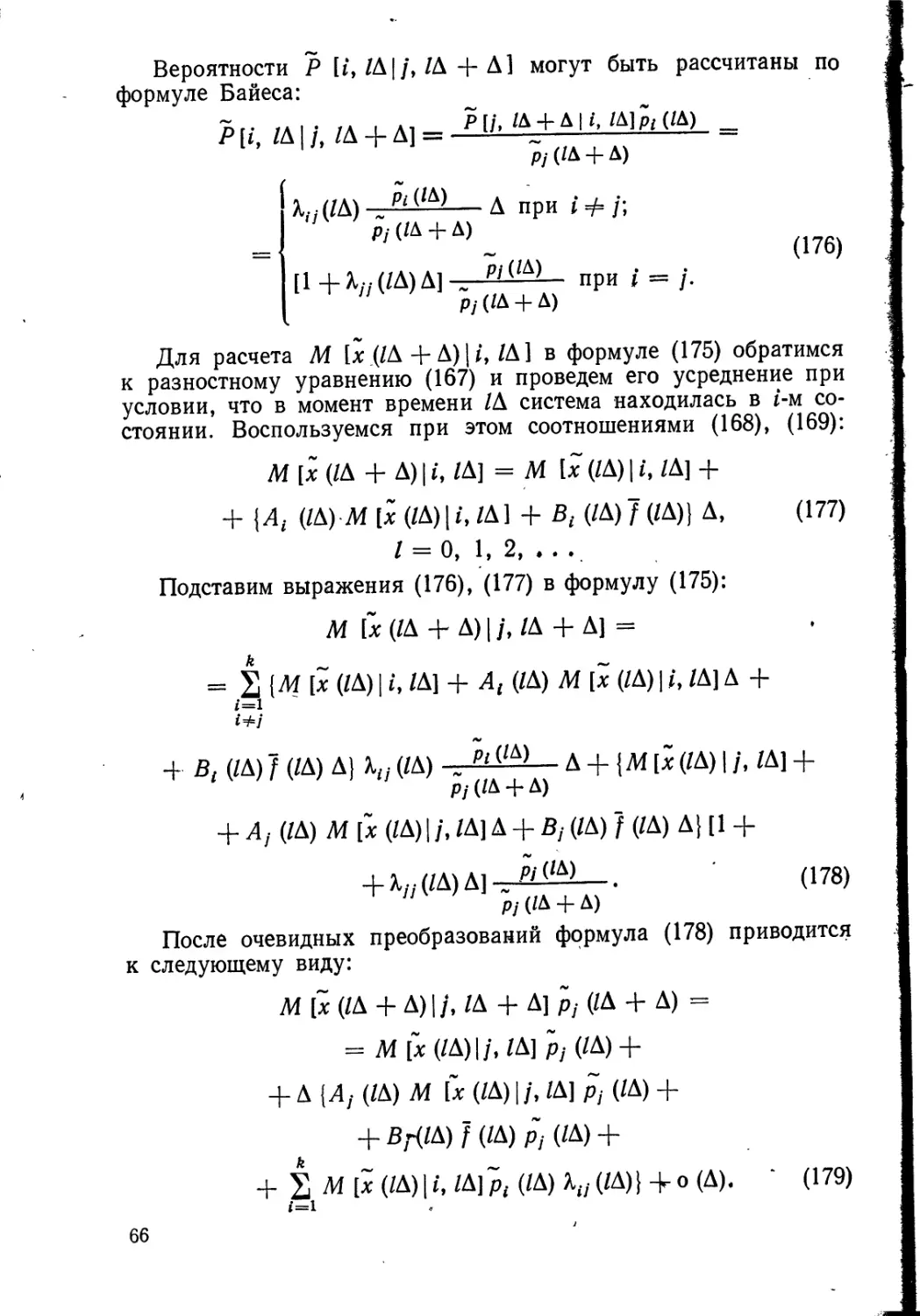

Уравнения (82) и (85) вместе с формулой (86) можно решать

на ЭВМ методом последовательных приближений, определяя

в качестве нулевого приближения математическое ожидание

тх0) спектральную плотность Sx0) (со) и мощности вектора х (t)

системы, в которой нелинейные элементы заменены линейными.

После этого вычисляются первые приближения фо1*, Кг1) и Ч?{1) (со),

а затем первые приближения тх1) и Sxl) (со). Процесс вычислений

продолжается до тех пор, пока ф0 и /Ci нового приближения будут

отличаться от значений предыдущего вычисления на величины,

меньше заданных.

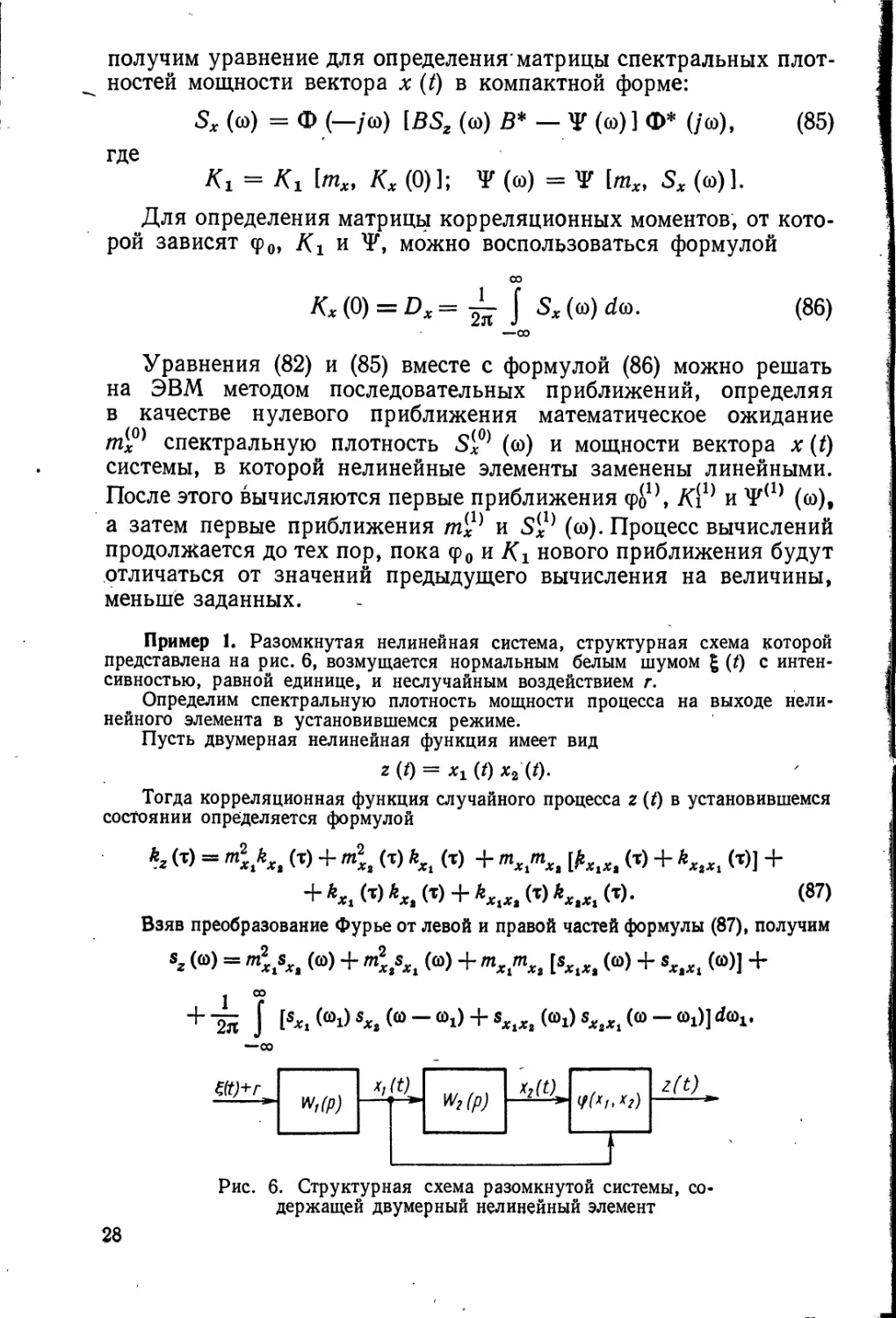

Пример 1. Разомкнутая нелинейная система, структурная схема которой

представлена на рис. 6, возмущается нормальным белым шумом £ (t) с

интенсивностью, равной единице, и неслучайным воздействием г.

Определим спектральную плотность мощности процесса на выходе

нелинейного элемента в установившемся режиме.

Пусть двумерная нелинейная функция имеет вид

г (0 - хг (0 x2(t).

Тогда корреляционная функция случайного процесса г (t) в установившемся

состоянии определяется формулой

kz (т) = m2xkXt (т) + т\г (т) kXi (т) + msmSt [^^ (т) + **,„ (t)J +

+ **, W *„. (т) + kXtXt (т) kXtXi (т). (87)

Взяв преобразование Фурье от левой и правой частей формулы (87), получим

sz (<d) = ml sXt (<o) + m2XtsXi (<o) + mxmXt [sXiX> (©) + sx>Xt (<*)] +

—00

ед+л

■ЗД

*/

w

ад

**w„

V(*i,"/)

i

z(t)

Рис. 6. Структурная схема разомкнутой системы,

содержащей двумерный нелинейный элемент

2Ь

Выразим спектральные

плотности мощности процессов на входе

блока произведения через

частотные характеристики линейных

звеньев:

' 5г(С0)= |^(/С0)|2К2 +

+ m2Xi\w2(M\2 +

+ mxtmx2 [w2 (/*>) + w2 (- /©)]} +

GO

—oo

-<^>]1М1<М/(©--©1>]|*+'

+ W2 (MW2 [—/ (0 — (Oi)]} d©i.

Рис. 7. Спектральная плотность

мощности процесса на выходе двумерного

нелинейного элемента

Предположим, что передаточные функции линейных звеньев имеют вид

1

Щ (Р) = Щ (р) =

Тр+1

Тогда спектральная плотность мощности процесса на выходе нелинейного

элемента будет определяться выражением

Мю)

_г2(4 + Т2со2) , 20 + Т*а>*

(88)

Т2ш2+1 г47(72со2 + 4)'

На рис. 7 приведены графики спектральных плотностей процесса на выходе

нелинейного элемента, полученные с помощью формулы (88) (кривые 1, 3) и

метода статистической линеаризации (кривые 2, 4) для различных значений

дисперсий сомножителей при фиксированных средних значениях.

Пример 2. Определим математическое ожидание и корреляционную

функцию процесса хг (t) системы, которая рассмотрена в примере предыдущего

параграфа (рис. 3).

Принимая во внимание формулы (74) и (76), запишем уравнения относительно

математических ожиданий и корреляционных функций выходных координат

исследуемой системы:

t

Щ (0 = J wx (т) [г — ф0 (t — х) — km2 (t — т)] dx\

t

mz (t) = J w2 (к) mx (t — к) dK\

*u Vi> U) + \wx (т) {kk21 ft - т, t2) + M [ф (tx - x) °Xl (t2)]} dx +

и

+ J щ(к) {kk12(tv *,_-Л) + Л1& ft) $(*,-«]} Л +

0

и и

(89)

+ ^W^W^tiift-t, t2-X) +

(90)

29

+ kM [<p (tx _ т) x2 (t2 - I)] + kM [x2 ft _ т) q> (t2 - X)] +

+ M [Ф ft - т) ф ft - Я)] dx<a =

- и и

= J J щ (т) Ш1 (Я) *& ('«— '1 — * +*) <*тЛ,;

«22 (']

• и и

*ъ)=\ J Щ (т) ay (W «ц ft — т, *2 — Я) <*т dX\

00 ^

- *i2-&. *2) = J «Ъ (т) «и ft, Л - Я) Л;

^21 ('ъ 'а) = ^2 W *п d — *> h) Л.

7

(90)

Математические ожидания, входящие в уравнения (89) и (90), при

совместном нормальном распределении выхадных координат для нелинейной функции

(72) имеют вид:

* Фо (0 = тг (t) т2 (0 + d12 (0;

(91)

1

(92)

М\хг ft) ф ft)] = т2 (t2) ktl ft, t2) + тг (t2) k1% ft, t2)\

M [ф ft) xx(t2)] = тг ft) k2l ft, t2) + m2 ft) ku ft, t2);

о о

M [x2 ft) ф ft)] = mx (t2) «22 ft, t2) + m2 ft) k21 ft, t2);

M [ф ft) x2 (t2)] = тг ft) «22 (tv t2) + m2 ft) k12 ft, t2)\

M [ф ft) ф (t2) ] = mx ft) mt (t2) k22 ft, t2) +

+ m2 ft) m2 ft) kxl ft, t2) +

+ m2 ft) m± (t2) k12 ft, t2) + mx ft) m2 ft) k21 ft, t2) +

+ ^11 (*i> *г) k22 (h> h) + Кг (h> h) b2\ (h> **).

Уравнения (89), (90) с учетом выражений (91) и (92) были проинтегрированы

методом квадратурных формул на ЦВМ с шагом А = 0,1 для следующих

параметров системы: Тг = 0,5, Т2 = 1,

k = 2, г = 1, Q = 0,58. Результаты

решения для kn ft, t2), mXi и D.Xt

приводятся на рис. 8, 9, 10. На

рис. 9 и 10 для сравнения показаны

математическое ожидание и

дисперсия выходной координаты хг (/)»

определенные методом

статистических испытаний по тысяче

реализаций (кривые 2).

Рис. 8. Поверхность

корреляционной функции процесса *! (0

нелинейной системы, содержащей

двумерный нелинейный элемент

Рис. 9. Математическое ожидание про- Рис. 10. Дисперсия процесса хг (t)

цесса хх (t) нелинейной системы: нелинейной системы:

1 - метод квадратных формул; 2 — метод / — метод квадратурных формул; 2 —

статистических испытаний метод статистических испытаний

4. Применение теории процессов Маркова

к анализу непрерывных систем управления

Широкий класс систем управления описывается

дифференциальным уравнением

i =*/('. *) + Gfc-*J6W, (93)

где вектор-столбец фазовых координат системы х имеет

размерность п\ f (t9 х) — вектор-функция п измерений; G (t, x) —

матрица размерности [/г, т]. Случайные возмущения, действующие

на систему, представлены в формуле (94) в виде вектора-столбца

I (t) m измерений. Случайный векторный процесс g (t) является

нормально распределенным белым шумом со следующими

статистическими характеристиками:

А* [6 (01=0;

A*[6(<i)6*(<i)] = Q(<i)e(/1-/JI). (94)"

Анализ системы, отписываемый уравнением (93), предполагает

вычисление некоторых показателей точности. Достаточно общей

формой такого псказателя является

т

I = М\<р [*(*), t] dU

где Ф [х (t)y /] —скалярная функция фазовых координат

системы. ^ Обозначим через р (t, x) плотность распределения

вероятностей случайного процесса х (/). Тогда

т

1 = J dt I dx Ф (x, f) p (/, x)9 (95)

31-

где j dx означает n-кратный интеграл по всем компонентам

вектора х в пределах от —оо до +оо, т. е.

.00 00 00

J ^л: = J dxx J dx2. , . J dxn.

— 00 —00 —00

В частном случае

Ф [*(/), t] = х* (t) V(t)x(t) +

+ x* (t)Ax(t)8(T — t),

где V (t) и Л — положительно определенные матрицы

размерности [/г, п], а б (Г— /) — дельта-функция Дирака.

Тогда показатель точности системы / равен

/ = М И х* (t) V (t) x (t)dt +

И;

+ x* (T) Ax (T)\ = J tr [Г (t) V (t)] dt + tr [Г (Т) A]. (96)

В формуле (96) матрица Г (f) размерности In, n ] определяется

выражением

Г(/) = М [x(t)x* (t)],

а

п

trc = 2 °и

является следом матрицы С размерности [я, п] с элементами сГп

i, j = 1, 2, . . ., /г.

-^ Показатель точности, определяемый выражением (96), зависит

только от второй начальной моментной функции Г (t) случайного

процесса в то время, как в общем случае [см. формулу (95)]

показатель / зависит от закона распределения случайного

процесса. Расчет плотности распределения вероятностей р (t, х)

случайного процесса х (t) может быть проведен с применением

теории процессов Маркова.

Случайный процесс х (t) называется процессом без

последействия, или процессом Маркова, если для любых tx <* t2 <!

• • '• <C.tk при произвольном k -

F (*л» xk\ ^i> *i» *2> ^2» • ♦ • » h-i* ^A-i) ==

= F(tk, Xk\tk-b *a-i)> (97)

где

P (hi Xk\ *1* #1» ^2*2» • • •» *k-ii Xk-l) ==

= pi* (tk)'<*k\x (ti) = xi% i = 1, 2, .« M k— 1].

32

Условная плотность распределения вероятностей марковского

процесса х (f) обладает свойством, аналогичным выраженному

формулой (97):

Р (4> xk\ ti> xi\ ^2» хъ "• • •'» 4-i) =

= Р(4, xk\tk-i, *h-i)- (98)

Приведенное определение марковского векторного процесса

х (t) означает, что если производится предсказание поведения х (t)

в момент 4 на основании известных значений х (^), i = 1,

2 ., k— 1, то точность предсказания будет такой же, как

в* случае известного измерения только в последний момент

времени 4-1- Иначе говоря, вся информация о марковском процессе

сосредоточена в последнем' его измерении. Можно сказать и так:

будущее марковского процесса независит от его прошлого при

известном настоящем значении.

Для марковских процессов

Р (t, xt | х (т), т < s < t) = р (tf xt | s, xs)f

где под р (/, xt\x (т), т <: s < f) понимается плотность

распределения вероятностей в момент t при известной реализации

процесса х (т), т < s < *.

Согласно известным свойствам многомерного

дифференциального закона распределения х (t) [82]

Р \ti> xi\ ^2» *2> • • Л 4> #&) ^

— Р (4» ^| *1> Х\\ *2> Х2.\ • * •"* 4-1>

*A-i) Р (4-i> xk-i I 'i'i *i'> *2>

*2; . •.; 4-2» **-i)-- • • p (<2. ^2 Mi. *i) p, (*i, *i).- (99)

Применяя к выражению (99) свойство (98) марковского

процесса, получим при tx << t2 < ... <: tk

Р (^1> -^1» ^2» ^2» • • -i 4> #&) =

= Р (4> *л| 4-1, **-i) р (4-х, ^-i|;

4-2» Xk^) • • • Р (^2» ХА ^1» *l) Р Ul> *l)-

Таким образом, многомерный дифференциальный закон

распределения вероятностей произвольного порядка k полностью

определяется одномерными условными законами распределения

Р (/, х) и р (/, л: | т, у), которые содержат, следовательно, полное

статистическое описание марковского процесса.

Важное значение в теории марковских процессов имеет

обобщенное уравнение Маркова [8, 23]

Р (U х\%, у) =

= J dzp (f, x\s, z) p (s, z|t, #), t<s< t.

3 A. M. Батков 33

Случайный процесс х (t) является непрерывным, если за малые

интервалы времени он с малой вероятностью получает заметные

по-величине приращения. Дадим, следующее определение

непрерывности случайного процесса: случайный процесс является

непрерывным, если для любого n-мерного вектора 8, все компоненты

которого положительны,

lim ±rP[\-x(t + At) — x(t)\>e\x(t) = х] -О,

что означает

lim -J- f dyp(t + At, y\t, x) = 0.

Другое, более жесткое, определение непрерывности случайного

процесса состоит в следующем: случайный процесс непрерывен,

если для любого я-мерного вектора е, все компоненты которого

положительны,

lim ^т J (у' — х)2 p(t + M, y\ t, x) dy = 0.

Непрерывные марковские случайные векторные процессы х (t),

или процессы диффузионного типа, характеризуются д-мерным

вектором коэффициентов сноса с (tf x) и матрицей коэффициентов

диффузии 8 (t, x) размерности [п> п]9 которые определяются

выражениями:

c(t,x)^\\m ^-M[x(t-\-At)--x{t)\x (t) = x] =

Af->0 Af "

\

= \\m±:\{y-x)p(t+M, y\t, x)dy; (100)

9 (t, x) = lim-Jr M [(x (t + At)—x (/)) (x) (t + At)—

- x (t))* \ x(t) = x} = lim± I (y~x)(y-x)*p(t +At, y\t, x) dy.

(101)

Таким образом, математическое ожидание и дисперсия

приращения процесса х (t) за время At при условии х (t) = x являются

бесконечно малыми величинами порядка АЛ В дальнейшем будут

рассматриваться такие процессы, для которых моменты

приращения- порядка выше второго являются бесконечно малыми более

высокого порядка малости, чем At.

Процесс х (t), описываемый дифференциальным уравнением

(93), обладает марковским свойством и является непрерывным [8,

34 ^

74 88]. Рассчитаем коэффициенты сноса и диффузии этого

процесса в следующем частном случае:

f{t, х) = А (t)x + r(t), (102)

G (*, х) = В (*),

где A (t) — матрица переменных коэффициентов размерности

[л, п\\ г (t) — известная вектор-функция времени размерности п\

В \t) — матрица переменных коэффициентов размерности [я, ml.

В рассматриваемом случае исследуемая система '

управления (93) является линейной.

Для расчета с (t, x) и 0 (t, x) представим приращение

процесса за время А^ согласно формулам (93) и (102) в виде

t+At

x(t+At) — x (t) = J (A (x) x (т) +

t

+ r(x) + В (t) I (t)) dx. (103)

Тогда согласно определению вектора коэффициентов сноса

выражение (100) примет вид

t+At

\ (А(х)х(х) +

c(t, x) = Нт-дтМ

Д*-*0

Д*

+ r(x)+B(x)t(x))dx\x(t) = x

= A(t)x + r(t).

(104)

Матрица коэффициентов диффузии 0 (t, x) рассчитывается по

формуле (101) с использованием выражения (103) и

характеристиками (94) процесса g (t):

П+At

Q(t, *) = lim -JtM

At+0

J (A(x)x(x)+r(x) +

L t

t+At

+ B(x)l(x))dx J (A(l)x(X) + r(l) + B(k)t(X))*dk\x(t) = x\ =

rt+At t+At

' 1

t

+ o(M)\x(t) = x\

t

= lim -L M

At+0 &

j-At t-\-At

J dx J <&В (T)g(T)|* (Л) В* (*,)+•

It+At t+At

\ dx \ dkx

t t

o(A0J =

х.В№(х)¥(ЦВ*(%) + <

t+At t-\-At

= limi J dx J dXiS(T)Q(t)B*^)6(T — Я),

д*-»о

3*

35

где о (А/) является величиной более высокого порядка малости,

чем А*.

Выполняя операции интегрирования и перехода к пределу

при А*—> 0, получим

9 (*, х) = В (О Q (t) В* (/). . (105)

В выводе формул (104), (105) было использовано свойство

независимости значений нормально распределенного «белого» шума

I (/). Из этого свойства вытекает отсутствие статистической связи

I (т), t < т < t + А* и условия х (t) = х. Поэтому

j В(т) | (т) dx|^ (0 = x = M\ \ В(т)6(т)Л

J dr J' dX В (т) £(т)£* (Л) Я* (Я)|х (*) = * =

= JH )Л) ЛВ(т)| (т) £* (Я) S* (Я) =

= В (t)Q (t) B* (t) At + o (АО-

Расчетами, аналогичными приведенным в формулах (104), (105),

можно показать, что для нелинейной системы, описываемой

уравнением (93) при G (/, х) = В (/) коэффициенты сноса и диффузии

определяются соответственно выражениями

c(t, х) = /(*, x)\ \

0 (*, х) = В (t) Q (t) В* (0. J ( '

Случай, когда матрица G зависит не только от времени t> но

и фазовых координат объекта х, будет рассмотрен в п. 3 гл. II.

Пусть диффузионный процесс х (t) удовлетворяет следующим

условиям:

1) существует р (t, х|т, и), и непрерывные по переменным

х, у, / ит</ частные прсшзводные

dp (i,x |т, у) д2р (t, x\ т, у) .

. ■» ду ' дуду* '

2) существуют коэффициенты сноса с (/, *) и диффузии 0(tf, л:);

3) существуют непрерывные по переменным х, у, t и т < t

частные производные

-^p[Q(t,x)p(t,x\r, у)];

36

4)~моменты приращения процесса выше второго порядка

являются бескончено малыми более высокого порядка малости, чем Д£.

Здесь оператор -д- является вектором-столбцом размерности п

д

с элементами

dyi

, i = 1, 2,

д*

вектора у\ оператор щ^* -

а2 . . * о

ментами jurats Ь / = I, ^

. ., п, где уь — одна из координат

матрица размерности [п, п] с эле-

. ., п.

дшду> а а*

Аналогичное содержание имеют операторы -^ и gjcg »

В частности,

д2р д2р

d2p(t, x\%ty)

дуду*

д2р

духдУх духду2

д2р д*р

дУхдуп

д*р

духдУх ду2ду2

д*р д2р

ду2дуп

д*р

дУпдУх дупду2

дупдуп

При выполнении, указанных условий диффузионный процесс

удовлетворяет первому (обратному) и второму (прямому)

уравнениям А. Н. Колмогорова [23]:

др (*, х\т, у) __

at ~"

-с*(т, у)

др V, х\т,у)

ду

а'<'■„','*■»> = - (А)',, ((, х) „(,,,, г, й| + -

* +-г^[зг&-[в('.*)Р('»*1т»й1]; (107)

Из второго уравнения А. Н. Колмогорова можно получить

уравнение, определяющее одномерный дифференциальный закон

распределения непрерывного марковского процесса. Для этого

следует воспользоваться известным свойством плотности

распределения вероятностей

р (t, х) = f р (*, х\%, у) р (т, t/) dj/.

Умножим обе части уравнения (107) на р (т, у) и

проинтегрируем по переменной у. В результате получим следующее

уравнение относительно р {t, x):

9ESLA^^y[e{t,X)pittx)] +

dt

+ x4a^ie(<'*)^*)1]

(108)

37

Как правило, при исследовании системы управления (93)

бывает известен закон распределения начального значения

процесса х (0) = х0 :

ГР (0, х) = р0 (х). (109)

Тогда уравнение (108) должно решаться при начальном

условии (109). Исходя из свойства плотности распределения, решение

уравнения (108) должно быть нормировано:

J p (t, x) dx = 1.

Рассмотрим частный случай линейной системы, когда

коэффициенты сноса и диффузии определяются выражениями (104),

(105). Уравнение А. Н. Колмогорова (108) в этом случае

принимает вид

др (Л х) __ ( д

dt

(i;)*W{t)x + r{t))p(t,x)] +

+ irtr [шг*в О « W 5* W р (<• *)] ■

Учитывая, что

(~y[(A(t)x + r(t))p(t,x)] =

= 2 ^ и« w*/+г*>+2л"w р (^ *>=

= [тг] * IA W л: + г] + Кг Л (01 р (/, *),

получим

^И = -I'M (*)1/>(*,*)-

_[Щ*у1Ау)х + г{т +

Характеристическая функция g (/, Я), где А.— n-мерный вектор-

столбец, связана с плотностью распределения соотношением

g (/, 'Я,) = М №** «>J = J е/*'* /> (*, х) dx.

за

Для получения уравнения относительно характеристической

функции следует левую и правую части уравнения (ПО) умножить

на е'^** и проинтегрировать по х. Тогда, применяя правило

интегрирования по частям, получим

EiStJL = х*А {t) Ei^L + Av {t) g {tf k) -

-±WB(t)Q(t)B*(t)Xg(t9K)- (HI)

Пусть начальное распределение р0 (х) (109) нормально, так что

g (0, X) = exp [jmll- -±-k'Dok] , (112)

где

m0 = M [x(0)]\

D0 = M [{x (0) — m0) (x (0) —m0) * ].

Тогда решением уравнения (111) является

g (U Я) ^exp [jm(t) X- i- X*D (*) Jt] . (113)

Таким образом, закон распределения случайного процесса х (t)

нормальный с математическим ожиданием т (f) = М [х (f)] и

дисперсионной матрицей D (/) = М [{х {t) — т (t) (x (t) — m (/))].

Для определения т (t) и D (t) выражение (113) подставим в

формулу (111) и из условия тождественного выполнения уравнения

получим:

т (t) = A (t) m{t) + г (0; |

D(f) = A (0 D{t) +D (t) A* (t) + J (114)

+ В (t) Q (t) В* (i). , )

Согласно выражению (112) находятся начальные значения

т (t) и D (t):

т (0) = т0;

D(0) =D0.

Обыкновенные дифференциальные уравнения (114)

определяют поведение вектора математического ожидания и

дисперсионной матрицы фазовых координат системы в произвольный момент

времени. Эти уравнения впервые получены Дунканом [1261.

Для произвольной нелинейной системы (93) найти

аналитическое решение уравнения А. Н. Колмогорова (108) не удается.

Однако можно использовать выражения (108) для вычисления

некоторых частных характеристик случайного процесса,

например его математического ожидания и дисперсионной матрицы.

Для нахождения уравнений, которым удовлетворяют момент-

ые функции, удобно воспользоваться описанным выше методом

39

характеристической функции. Аналогично тому, как было

получено уравнение (111) для характеристической функции линейного

марковского процесса, можно получить уравнение относительно

g (/, Я) для марковского процесса с произвольными известными

характеристиками с (t, х) и 0 (t, х) [27, 29]:

Щ^ = М ЦК*с (/, х) ехр (/Л**)] +

• + 4-А* [(/Я*) 0 (*, х) (А) ехр (А**)].

Используя известное свойство характеристической функции

[82], состоящее в том, что

' 1 А П

Ч"*1—-^w-°

»«)ri+r'+",+r"'AfK^«-..*a,

можно получить уравнение относительно любой моментной

функции исследуемого процесса. Для этого в уравнении в частных

производных относительно g (t, Я) необходимо представить g (/, Я)

рядом Маклорена:

х=о^"

= 1 + /Vm + -^ (А*) (Я + ™"*) (А) + о

где || Я || — норма вектора Я.

Приравнивая коэффициенты полиномов по переменной Я в

левой и правой частях уравнения, получим обыкновенные

дифференциальные уравнения, которым удовлетворяют моментные функции.

В частности, рассмотрение линейных членов дает уравнение

относительно математического ожидания

, т = М \c(U х)]9 (115)

а квадратичных членов— уравнение относительно дисперсионной

матрицы

Ь = М Ixc* (*, х) + с (/, х) х* + 9 (*, х)1 (116)

о

где х = х — т является центрированным вектором фазовых коо р-

динат.

40

Для линейной системы управления система уравнений для

т (t), D {t) не содержит других моментных функций случайного

процесса. При исследовании нелинейной системы правые части

уравнений (115), (116) не являются функциями только т {t) и

р (t)j поэтому из этой системы т (t) и D (/) не могут быть

однозначно определены. Действительно, пусть исследуются

статистические характеристики процесса х (/) на выходе нелинейной

системы (93) при G (t, х) = В (t)r

x = f(t,x) + B (t) I (0.

Непрерывный марковский процесс х (t) характеризуется

значениями с (t, x) и 0 (/, х), определяемыми формулой (106).

Используя выражение (106), запишем на основании формул (115), (116)

систему уравнений для математического ожидания и

дисперсионной матрицы рассматриваемого процесса:

m(t) = M [/(*, x(t))]\ (117)

D (t) = М ix (t) f* (t9 x (0) +

+ f(t,x (0) > (t)] + B (t) Q (t) B* (/)• (П8)

В силу нелинейного характера зависимости f (t, x (/)) от

фазовых координат х (t) правые части уравнений (И1-?) зависят не

только от т (0 и D (/), но и от старших моментных функций.

Поэтому система уравнений (117), (118) должна быть дополнена

уравнениями относительно моментных функций выше второго

порядка. Эти уравнения могут быть получены из уравнения

А. Н. Колмогорова с помощью того же приема [29], который был

использован при выводе формул (115)г (116). При решении

практических задач необходимо в бесконечной системе уравнений

относительно моментных функций ограничиться конечным числом

уравнений. При этом относительно старших моментов, для

которых уравнения отбрасываются, делаются некоторые

предположения, позволяющие замкнуть систему уравнений для моментов.

Отметим, что при возрастании порядка моментные функции могут

существенно возрастать и потому предположение о равенстве

нулю моментных функций выше некоторого порядка является

грубым. Практически следует связать старшие моментные

функции с младшими в соответствии с некоторым законом'распределения

фазовых координат. Такой подход означает аппроксимацию

истинного закона распределения фазовых координат некоторым

заданным законом. Усечение бесконечной системы уравнений для.

моментных функций дает один из возможных способов такой

аппроксимации.

Векторное уравнение (117) содержит п скалярных уравнений,

матричное уравнение^ (118) содержит п2 скалярных уравнений,

из которых • ^ ' линейно независимы. Число уравнений,

41

определяющих старшие моментные функции, быстро нарастает.

Так, для моментных функций третьего порядка следует решать

систему из п ^п > (п~т~ ) линейно независимых уравнений.

В связи со столь быстрым нарастанием объема вычислений при

увеличении точности результата в ряде случаев можно считать

обоснованным ограничение рассмотрения уравнений для первых

двух моментных функций (117) и (118). Как указывалось выше,

для замыкания этой системы уравнений. необходимо сделать

предположение о поведении старших моментных функций.

Если есть основание считать одномерный закон распределения

случайного процесса х (t) близким к нормальному, то старшие

моментные функции легко могут быть выражены через т (t) и

D (t). Предположение о нормальности закона распределения поз^

воляет рассчитать выражения [3, 4]

Vilt,m(t),D(t)]=Mlf(t,x(f))] =

= [ \ dxf (t, х) ехр Г-4- (x-m(t))*D-i(t)(x-m(t))] .

. V(2n)n\D(t)\ J L z J

(П9)

^2 It, m (*), D (/)] = M [x (t) /* (*, x (t))] =

= l \dx(x- m(t)) f (t, x) x

X exp ]—±.(x-m (t)f D-1 (t) (x-m (/))] ,

где W2 связано с у¥1 соотношением

Ъ'«.т.В> = в[п*<'£-°>]\ (120)

*

Теперь использование формул (119), (120) в выражениях (117),

(118) позволяет записать замкнутую систему .уравнений

относительно т (t), D (t):

m — W^t, т, D)\ )

D=^^D)p + D[^^Z))]*+ (121)

+ B(t)Q(t)B*(t). )

Система обыкновенных дифференциальных уравнений (121)

должна решаться при начальных условиях

т (0) = т0;

0.(0) = D0,

связанных с известным начальным распределением вероятностей

фазовых координат.

Решение системы (121) дает приближенные значения

математического ожидания и дисперсионной матрицы процесса х (t).

42

Точность результата зависит от возможности аппроксимации

истинного закона распределения р (t, х) нормальным.

Выше указывалось, что одним из наиболее сложных вопросов

в процедуре замыкания конечной системы уравнений для момент-

ных функций является предположение о характере поведения

старших моментных функций. Эта трудность практически не

возникает, если в качестве характеристик закона распределения

выбрать не моментные функции, а семиинварианты [27]. Известно,

что первые два семиинварианта совпадают с математическим

ожиданием и дисперсионной матрицей процесса х (t). Семиинварианты

более высокого порядка имеют тенденцию стремиться к нулю при

увеличении порядка, а для нормального закона распределения

семиинварианты, начиная с третьего, тождественно равны нулю.

Поэтому для замыкания бесконечной системы уравнений

относительно семиинвариантов естественно положить равными нулю

семиинварианты выше &-го порядка. Если k = 2, то система

уравнений относительно первых двух семиинвариантов совпадает

с системой (121). Увеличение точности,, связанное с рассмотрением

семиинвариантов выше второго порядка, как и при рассмотрении

моментных функций, требует существенного увеличения объема

вычислений.

5. Основы метода статистических испытаний

В предыдущих параграфах были рассмотрены методы анализа

стохастических систем автоматического управления, основанные

на сведении исходной статистической задачи к задаче решения

некоторой детерминированной системы уравнений. Эти методы

обычно оказываются эффективными только для определенных

классов систем, где требуется или линейность системы, или

ограниченное число нелинейностей, или ограниченность порядка

дифференциальных уравнений системы. Подобные методы полезно

применять на предварительном этапе проектирования, когда

можно ограничиться относительно простой моделью системы.

Наиболее- общим методом анализа систем управления и

поэтому обычно наиболее дорогим в смысле использования

машинного времени является метод статистического

моделирования.

Метод Монте-Карло состоит в последовательном многократном

решении уравнений, описывающих работу системы при

различных реализациях случайных входных сигналов. Для каждого

решения вычисляется значение критерия качества системы.

Окончательное среднее значение показателя качества работы системы

обычно определяется как среднее арифметическое значений

критерия для всех проведенных решений.

оПри практической реализации метода статистических

испытании на ЦВМ необходимо построить дискретную модель системы,

ТоРУю было бы удобно реализовать на вычислительной

43

машине. Чаще всего эта модель строится в виде дискретных

уравнений вида

х (*Д + А) = / (х ((/А), 0 + Б (/А); (122)

х (0) = х°

или в более общем случае

х (/А + А) = / (х (/А), /, £ (/А));

* (0) = *°,

где х = (хг, x2i . . ., хп) — вектор фазовых координат системы;

хР — в общем случае случайный вектор начального состояния

системы; g (£Д) — случайное возмущение на /-шаге.

Обычно исходная анализируемая система управления задается

системой дифференциальных уравнений. В этом случае переход

к дискретной модели осуществляется на основании

использования численных методов решения систем дифференциальных

уравнений. Теория точности численного интегрирования заданной

системы дифференциальных уравнений довольно Хорошо

разработана [14, 68, 114].

"Следующим этапом применения метода Монте-Карло является

задача генерации случайных параметров хР и возмущений \ (/А)

(i = 1, 2, 3, . . .) в полученной дискретной модели (122).

Совместней закон распределения *° й £ (/А) обычно нетрудно получить

на основании анализа статистических характеристик случайных